2025年12月3日,第49期AIR学术沙龙如期举行。本期活动邀请了美国加州大学尔湾分校(UC Irvine)解剖学与神经生物学 / 生物医学工程 / 认知科学讲席教授、听觉研究中心主任、美国工程院外籍院士曾凡钢教授,为清华师生作题为《当互联网数据走到尽头,神经数据登场:脑机接口与下一代 AI 前沿》的深度分享。

曾凡钢教授是加州大学尔湾分校解剖学和神经生物学、生物医学工程、认知科学和耳鼻喉头颈外科的校长特聘教授,领导听力研究中心。作为神经技术领域的领先创新者,他的工作涵盖人工耳蜗、基因治疗和新兴的人工智能神经接口。他撰写了 323 篇出版物,被引用次数超过 20,000 次,h-Index为 69。曾担任《The Hearing Journal》杂志编辑委员会主席,并为 NIH、NSF、DOD、美国耳鸣协会、北京听力协会、巴黎听力研究所、Hyperacusis Research 以及多家人工智能和医疗设备公司提供咨询服务。他领导了 Nurotron 26 电极人工耳蜗和 SoundCure 耳鸣抑制器的开发。他是 AIMBE、ASA 和 IEEE Fellow,美国国家工程院外籍院士。

曾教授从互联网数据即将“耗尽”的 AI 瓶颈谈起,引出“神经数据”这一全新数据范式可以作为应对互联网数据危机的解决方式,并系统阐述了脑机接口(Brain-Computer Interface, BCI)在推动通用人工智能(AGI)、重塑人机交互和再定义生物医学中的关键作用,同时也对中美在 AI+BCI 领域的差距发出了紧迫的“行动号召”。

一、互联网数据的天花板:AI 的燃料危机

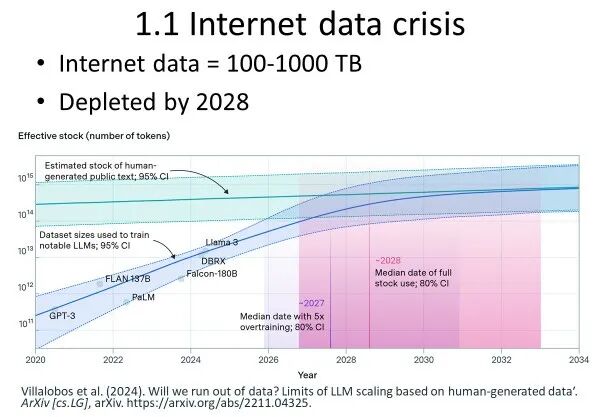

当前 AI 发展如日中天,但有一个常被忽视、却极为关键的问题:高质量训练数据正在变成稀缺资源。研究团队测算,目前人类在公开互联网中可用于训练大模型的高质量、有标注的文本、图像、语音等数据总量,大约只有 200–1000 TB 量级。在 GPT-3 时代,十几个 TB 的高质量数据就足以训练一个“不错”的模型;而如今的大模型随便就是 50–100 TB 的训练规模。以当前的发展趋势推算,乐观估计到 2028 年左右,互联网可用的高质量数据将基本被“吃干榨尽”——而数据一旦用于训练,就很难“当成新数据再用一次”。换句话说,算力可以不断扩展,模型可以不断加大,但高质量人类行为数据这个“燃料”却接近见底。这使得经典意义上依赖“Internet Data + Scaling Law”的 AI 路线,正面临一个不可回避的天花板。

曾教授专门提到了自己最近接触到的一项美国政府最新计划—— “Genesis Mission”,也被形容为一项新的“曼哈顿计划”。该计划的核心思路是:将联邦政府数十年来积累的高质量科学与政策数据(科研项目报告、评估数据、智库研究、政策评估等)通过一个统一的 AI 平台进行整合,用于训练所谓的“Scientific Foundation Models”(科学基础模型),以此来自动生成科学假说、加速科研流程、推动重大科学突破。这意味着:在互联网公共数据即将见底的情况下,美国率先将“封闭的高质量数据”作为新一轮 AI 竞争的战略资源,并以国家工程的方式推进。然而,这些数据对中国及其他国家的研究者未必开放。即使这些数据能够在未来数年里缓解一部分“数据燃料短缺”问题,其本质仍是「人类行为的“外在记录”数据」,且总量有限。曾教授抛出核心问题:即便加上联邦科学数据,AI 的数据瓶颈也只是被往后推了几年——那么,真正意义上的“下一个数据前沿”,在哪里?

二、当互联网数据终结,神经数据登场

曾凡钢教授认为下一代 AI 的数据前沿,是人脑本身——即“神经数据(Neural Data)”。传统神经科学大量依赖于动物模型(例如在小鼠听觉中枢植入电极,记录它对声音、触觉、视觉刺激的反应,再用这些数据训练 AI 模型)。曾教授团队也曾用小鼠听觉中枢的数据,训练超高维神经网络模型进行语音识别,效果不错。但传统神经科学这条路有一个根本问题:因为小鼠的大脑结构、功能与人脑差异巨大,所以依赖动物数据训练出来的AI,很可能在高级认知层面仍然“像只老鼠”,与人类智能相去甚远。因此,为了获得逼近人类级别的 General Intelligence(通用智能),那么数据来源不可避免地要从动物转向人类自身的大脑活动。这就引出了 Brain-Computer Interface(脑机接口,BCI)。

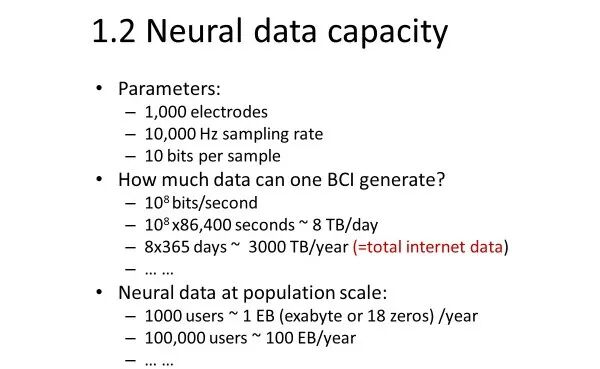

针对人类的神经数据容量,曾教授进行过估算:一个人 + 一套高通量 BCI,一年产出的神经数据量,已经与整个互联网的高质量数据同一量级。具体来说:当前一代高通量 BCI约 1024 个电极;采样率约 10 kHz;动态范围约 10 bits。粗略估算:每秒记录的数据量:约 (10^8) bits;一天可产生约 8 TB 数据;一年就是约 3000 TB(3 PB)数据。这还只是来自一个人的一套 BCI 设备。如果未来有成千上万名病人或志愿者长期植入 BCI,并持续记录数据,那么神经数据的总量将轻松达到 Exabyte(EB)级,远超现有任何公开数据源,相比之下,人类可用的高质量互联网数据也不过几百 TB 级别。

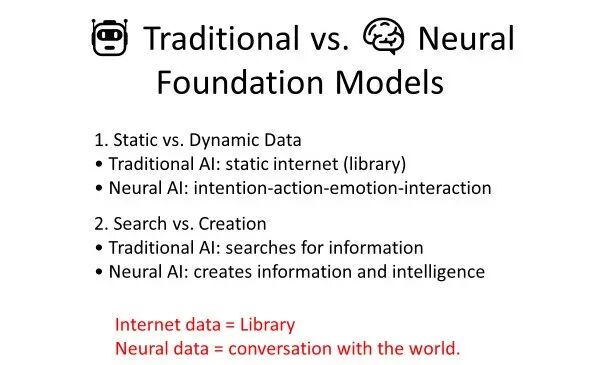

更关键的是,基于神经数据训练的“神经基础模型”与传统基础模型在本质上截然不同。传统 AI 所依赖的是静态的互联网数据,更像一座“静态图书馆”,只是人类行为事后留下的文字、图像和语音记录;而神经 AI 所依赖的是实时、连续的“与世界对话”(Conversation with the World)的过程本身。传统 AI 更擅长检索既有信息,而神经 AI 则面向生成新的信息与智能。例如,当一个人举起水杯、缓解口渴并产生愉悦感时,这些“意图”“情绪”“决策”“感受”都会同步编码在大脑活动之中,神经信号与行为结果、主观体验之间天然存在因果联系,而不仅仅是离线的文本记录。此外,神经数据还具有高度个体化和非同质化的特征。传统大模型训练往往面向“平均用户”,输出趋向“共识化”;而神经数据天生携带个体差异与个性化意图,正是未来打造真正意义上的“个人 AI(Personal AI)”的关键资源。因此,如果说迈向 AGI 必须完成一次“数据范式”的跃迁,那么从互联网数据走向神经数据,很可能就是这条道路上无法回避的必经之路。

三、脑机接口:既是数据接口,也是下一代“人机入口”

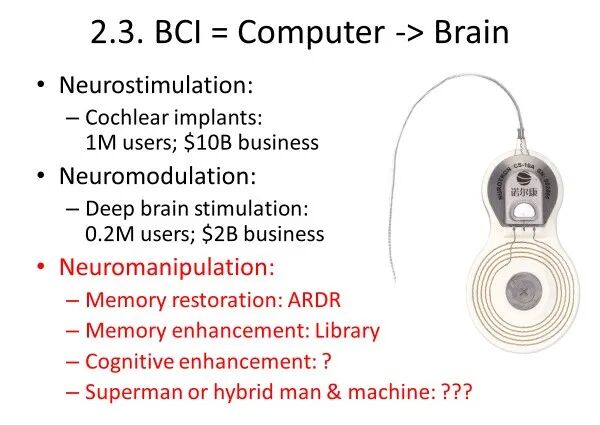

脑机接口(Brain-Computer Interface, BCI)即是神经数据的“采集与写入接口”,也是未来人机交互的“通用入口(Universal Interface)”。作为全球最早、也是最成功的神经电子产品之一,人工耳蜗(Cochlear Implant)是理解 BCI 应用路径的经典范例。曾教授研制的人工耳蜗,目前在全球已有超过 100 万用户,约一半是儿童,它通过一串电极直接刺激听神经,让“打枪都听不见”的全聋患者恢复听力,可以与人自然对话、进入普通学校学习。在人工耳蜗技术路线的演化过程中,最初的直觉是尽可能完整地模拟正常耳蜗的编码方式,但实践表明几乎不可能做到——人耳拥有上万条听神经纤维,而植入电极最多只有二十几根,试图以“少”逼真还原“多”的复杂生理信号几乎不可行。真正的突破来自范式的改变:不再追求恢复全部细节,而是将信号大幅简化,提取最核心的语音信息,并依托大脑的神经可塑性,让大脑自身去学习、补全和重构,与人工设备形成协同翻译机制。这样范式转变的效果是显著的——患者最初只能听懂 10–20% 的语音,但经过十余年的算法和编码策略迭代,如今多数人已能听懂 70–80% 以上的日常语言,而其中大脑自身的学习与重组能力发挥了越来越关键的作用。BCI 不需要一开始就追求“完美还原生理系统”,而是要找到“足够有用”的编码方式,让大脑与算法共同完成剩下的工作。同样的范式也可以推广到人工视觉、运动功能重建等领域:

BCI 也是新一代 “人机交互入口”:如今,人机交互的入口还是键盘、鼠标、触摸屏、语音助手、手机 App。当 BCI 技术足够成熟时,某种 BCI 装置成为人与世界交互的标准入口,人机交互可能变成“一想即得,比打字、说话都快”。在这个意义上,脑机接口不再只是一个医疗器械,而是人与人、人与机器、人与世界之间的下一代“基础设施”,有潜力成长为足以和新能源、量子计算、6G 通讯等并列的 “新质生产力支柱产业”。

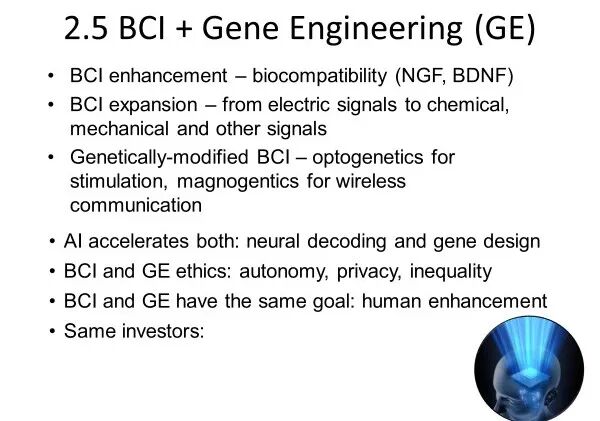

基因工程与脑机接口,就像“分子层面的碳基改造”与“系统层面的功能整合”,二者与 AI 结合,将在未来几十年深刻塑造人类自身。BCI 的发展将不仅限于提升生物相容性(如利用 NGF、BDNF 等促进神经生长),还将从单一的电信号扩展到化学、机械等多模态神经信息的读取与调控;与此同时,基因工程将催生“基因增强型 BCI”,例如通过光遗传学实现更精确的神经刺激,通过磁遗传学实现真正的无线脑-机通信。AI 则在这一进程中双向加速:既推动神经解码能力不断提升,也加速基因电路和分子工具的设计迭代。然而,两者也共同带来对自主性、隐私和社会不平等的新伦理挑战。BCI 与 GE 在本质上都指向同一个目标——人类能力的增强(human enhancement),而推动这些技术的投资者群体高度重叠,预示着这场深刻的技术合流正成为塑造未来人类形态的关键力量。

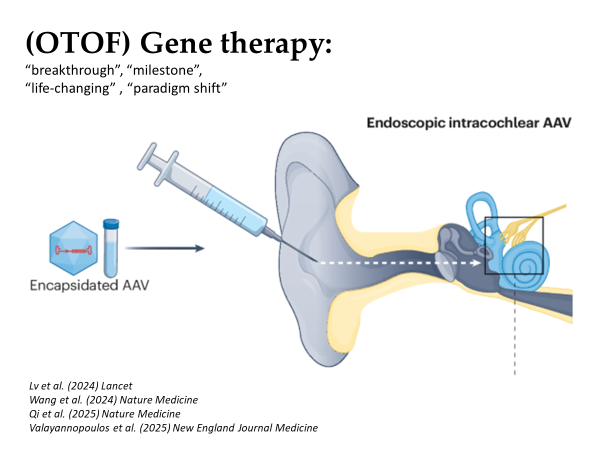

为了说明BCI+GE的发展前景,曾教授分享了一个极具震撼力的基因治疗耳聋的临床案例:某些先天性耳聋患儿携带 OTOF 基因突变,导致耳蜗内关键蛋白缺失,听神经不能正常传递信号。过去,这类病人只能依赖人工耳蜗来“绕过”损坏的生物环节;而在 2024–2025 年间,国内团队(东南大学、复旦大学等)率先在人体上开展了基因治疗临床试验:通过 AAV(腺相关病毒)载体,将健康版本的 OTOF 基因“一针打入内耳”。病人原本需要依赖人工耳蜗的一侧,在打针数月后,自然听力部分恢复。

四、呼吁行动,正视中美在 AI+BCI 的差距

梳理公开信息可以发现,美国的AI巨头押注 BCI 与基因工程,Neuralink融资约 13 亿美元,估值在数十亿美元量级,主要出资人就是 Elon Musk;Synchron的早期投资者包括 Jeff Bezos、Bill Gates;Blackrock Neurotech的早期天使投资人包括 Peter Thiel;Sam Altman 也以个人身份投入了新的 BCI 创业公司(如 Merge Labs 等)。他们背后的共同逻辑是:想让人类活得更长、活得更好、活得更舒服;同时,在下一场技术革命中抢占平台级入口与数据源的制高点。

中国在这场全球性竞争中既具备显著优势,也存在突出短板。一方面,中国拥有全球最丰富、最可及的临床与患者资源,这是发展高通量 BCI、积累神经数据和推进临床转化的天然宝库;但另一方面,中国在 BCI 领域的投入与战略认知却明显不足。与美国数十亿美元级的民间资本持续涌入相比,中国当前以国资为主的投资规模仅为其十分之一左右,缺乏面向未来的人机智能基础设施视角。更深层的问题在于,国内许多企业仍将 BCI 限定为“医疗器械”赛道,忽视了其在 AI 数据获取、具身智能控制、人机交互入口等方面的战略潜力;在技术路线与工程 know-how 上,不少产品停留在“照着国外外形做”的层面,不敢或不会挑战底层原理创新,呈现出典型的“知其然不知其所以然”。

曾教授还系统比较了中国“十五五规划”与美国“Genesis Mission”的技术布局,并明确指出:脑机接口已不再是单纯的医疗器械,而是驱动下一代人工智能的核心引擎、拓展人类能力的战略平台,甚至关乎国家安全与经济竞争力的“新质生产力”。因此,中国必须尽快在战略高度上重视脑机接口,将其视为与芯片、操作系统同等重要的数字时代底座技术,否则将在“人机智能深度融合”的新纪元中陷入被动。曾教授同时呼吁 AI 领域的领军人物与企业家主动拥抱并布局 AI + BCI + 基因工程 的交叉赛道,把握未来产业范式跃迁的历史性机遇。

最后,曾教授概括了他对 AI 与 BCI 结合的宏大愿景:互联网数据是一座图书馆,神经数据则是一场与世界的持续对话,只有真正接入这场对话,AGI 才有可能迈出下一步。要想在这一波浪潮中做出世界一流的产品和突破,他认为至少需要三件事同时做到“世界一流”:

1.世界一流的科学研究(Research)

2.世界一流的工程能力(Engineering)

3.世界一流的基础设施(Infrastructure)

对于中国而言,既有庞大的临床与人口优势,也有在工程落地方面的强执行力;但在战略投入、跨界整合与长期愿景方面,仍需更大胆、更系统的布局。当互联网数据走到尽头,也许,下一场关于智能、生命与人类未来的“数据革命”,已经在我们的脑中悄然开始。