11月28日晚,由DISCOVER实验室主办的第三十七期AIR青年科学家论坛如期举行。本次活动有幸邀请到南京大学智能科学与技术学院的姚遥副教授,为AIR的老师和同学们做了题为Creating a Realistic 3D World的精彩报告。

姚遥副教授是2022年国家级人才计划青年项目(海外)入选者。曾任苹果公司高级研究员,Altizure创始团队核心成员(被苹果收购)。2015年于南京大学获学士学位,2019年于香港科技大学获博士学位。主要研究方向为三维计算机视觉,包括三维重建、可微渲染及三维内容生成。代表工作包括MVSNet系列工作、BlendedMVS数据集及NeILF系列工作,文章总引用数逾四千,曾获2020年国际模式识别大会最佳学生论文奖。

姚遥博士提出,当前元宇宙面临的主要问题有两点:“设备”和“三维内容”本身。

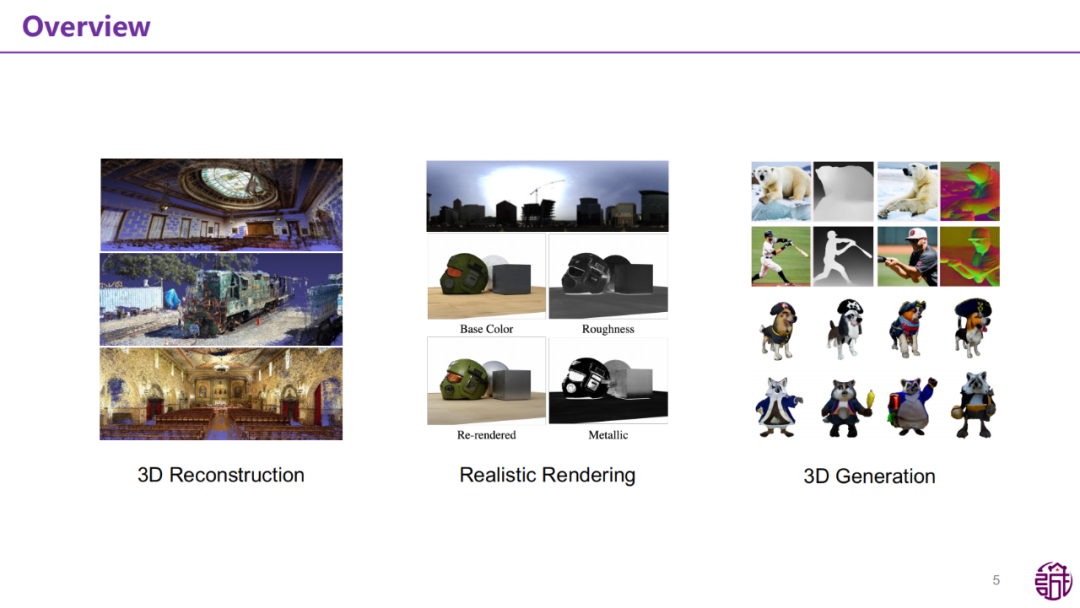

面对这些挑战,姚博士提出了三个方向的探索:三维重建(3D Reconstruction)、真实感渲染(Realistc Rendering)、三维生成(3D Generation)。

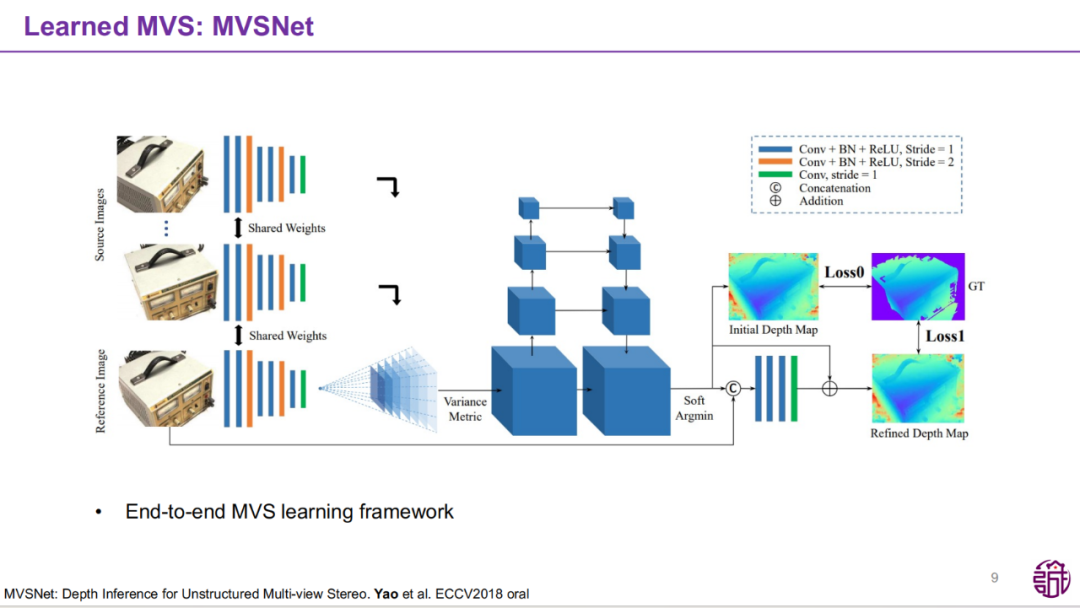

在报告的第一部分,姚遥博士探讨了基于图像的三维重建技术。这一技术通过多视图图像输入,逐步生成稠密点云、网格表面及其纹理化效果,最终实现逼真的三维数字化场景建模。传统的三维重建方法依赖于精确的几何信息,而姚博士的团队通过深度学习的引入,有效提升了泛化性和多项重要指标,在Multi-view Stereo(MVS)的研究中,姚遥博士及团队提出的MVSNet框架成为领域内重要的基准。

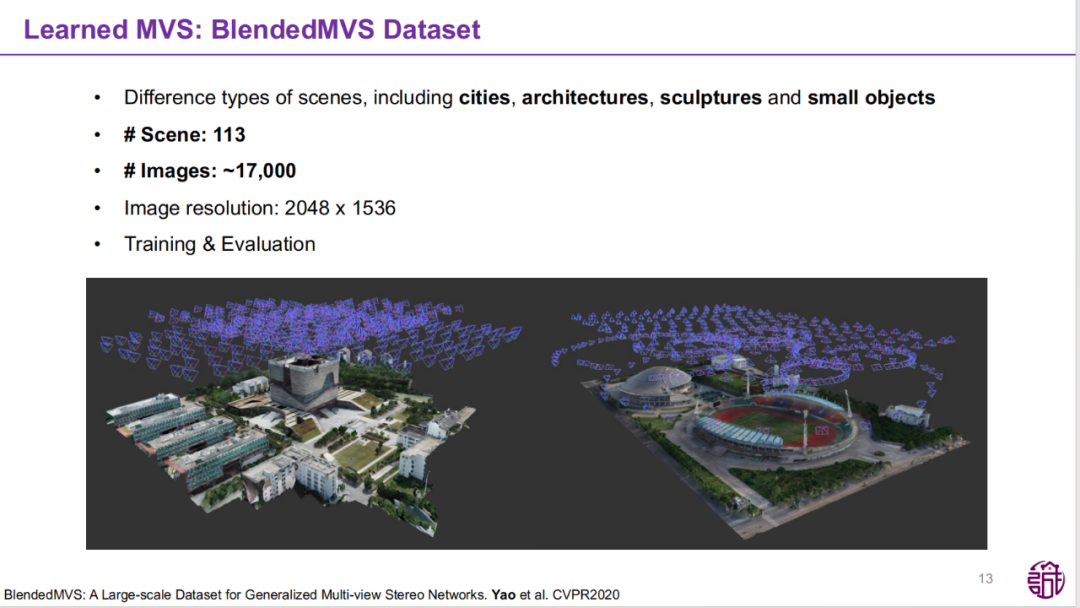

此外,团队还开发了BlendedMVS Dataset,一个涵盖城市、建筑、雕塑和小物件等多类型场景的数据集。

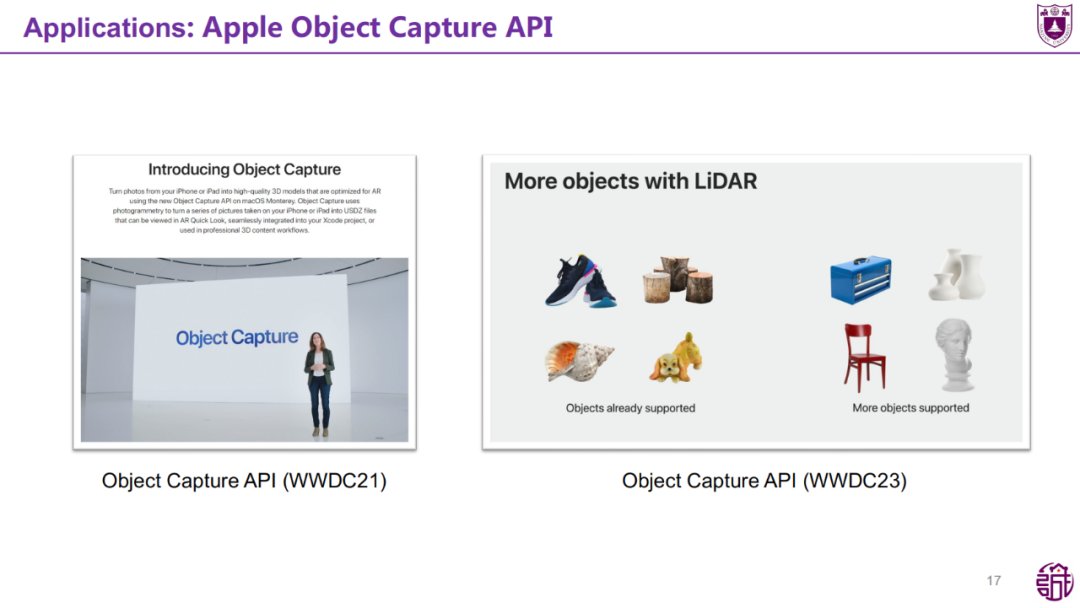

相较传统方法,MVSNet通过端到端学习框架,不仅在重建精度上实现突破,还展现了更优越的泛化能力。相关研究成果已于2020年被苹果公司收购,并应用于Apple

Object Capture API等。

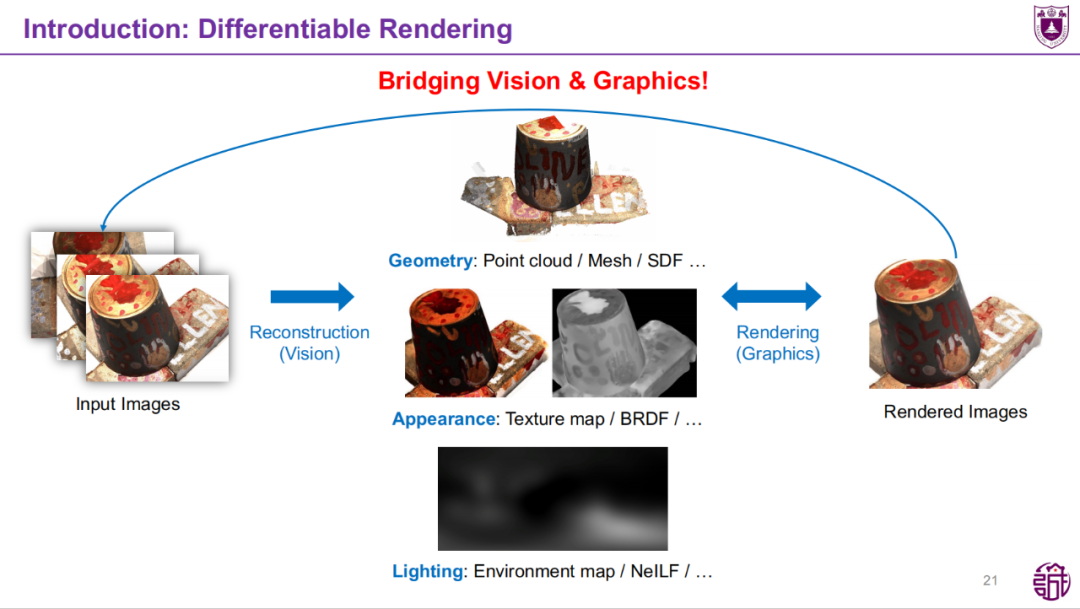

报告的第二部分聚焦于真实感渲染(Realistic Rendering)的前沿研究。通过结合计算机视觉和图形学,姚博士团队提出了基于可微分渲染(Differentiable Rendering)的框架,从图像观测中反推场景的几何、外观与光照信息,为高度真实的三维场景再现奠定了理论基础。这一研究的关键意义在于打通了传统图形学研究的逆向推理领域。

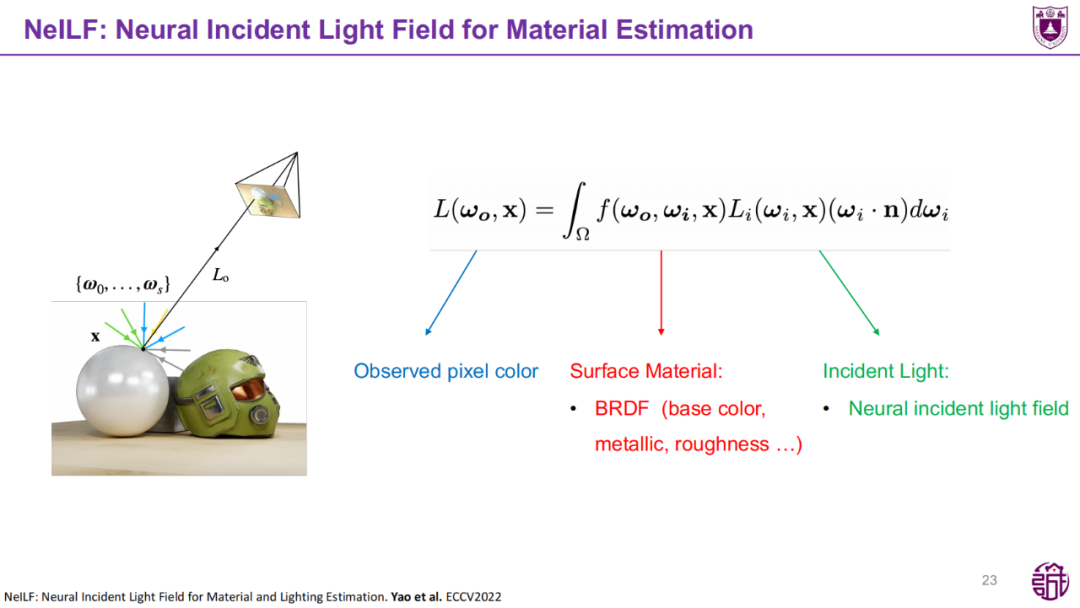

对于Surface Rendering问题,姚博士及团队提出的Neural Incident Light Field (NeILF) 是一种用于表面材质与光照估计的神经网络模型。

NeILF结合了材质的双向反射分布函数(BRDF)以及环境光照的神经估计,并用光场表示入射光,以任意表示静态场景的光照情况,从而能够对复杂场景中的材质属性(如金属度、粗糙度)进行精准的反演。

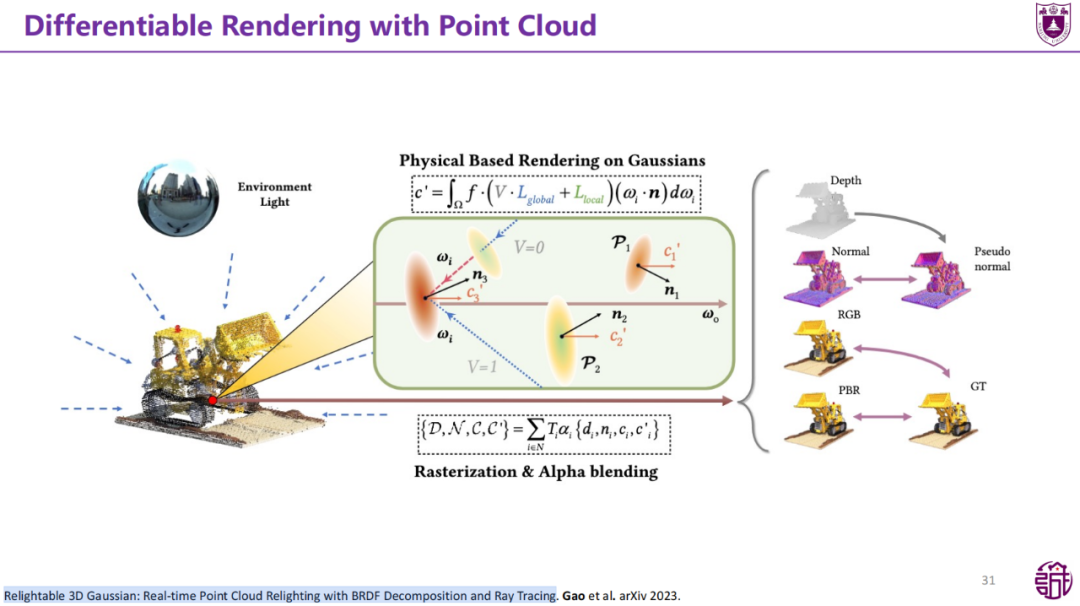

此外,姚博士展示了他们在点云渲染领域的探索——Point-based Differentiable Rendering,提出了基于高斯分布的点云光照与渲染框架(Relightable 3D Gaussians)。这一方法能够实时生成具有高度真实感的点云渲染图像,并被应用于动态场景的重建与渲染中。它的核心竞争力在于,采用了离散的点云形式表达,对于每个点模拟参数变化曲线,对于三维高斯点新增了一系列动态参数,结合傅里叶变换和多项式逼近实现动态参数建模,且避免了引入MLP网络,从而大幅提升训练效率。

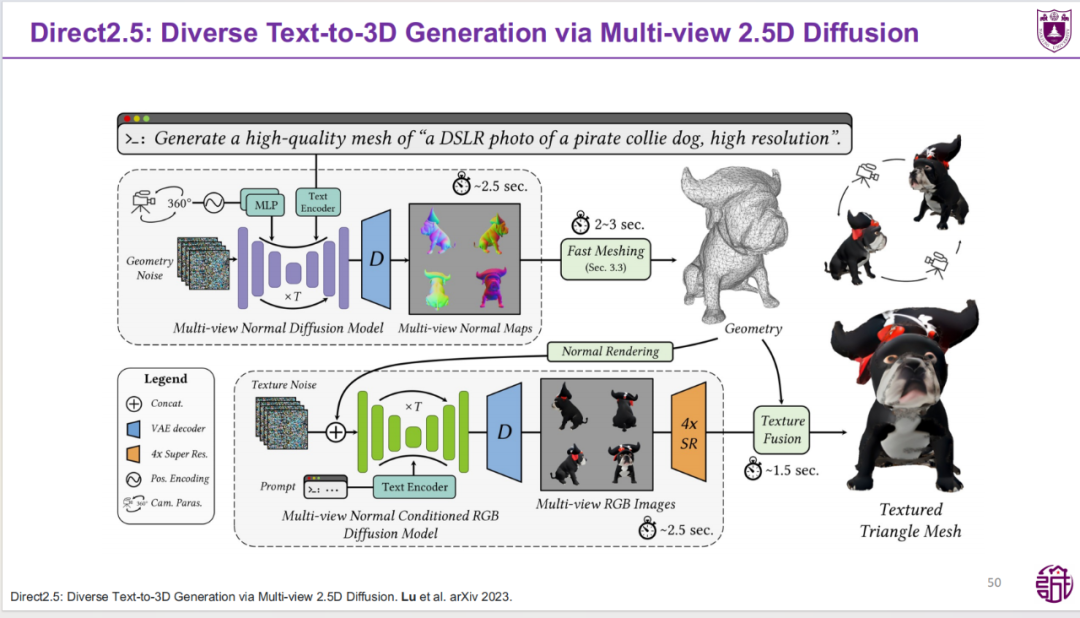

在本报告的第三部分,姚遥博士探讨了3D生成技术的最新进展,聚焦从2D、3D到2.5D路径的多样化探索,以及如何实现动态与高效的3D内容生成。对于Direct 3D Diffusion,数据问题一直困扰这项实践,包括繁杂的数据清洗等。而Direct2.5模型是一种折中的策略,生成速度显著提升,为高效3D生成树立了新标杆。

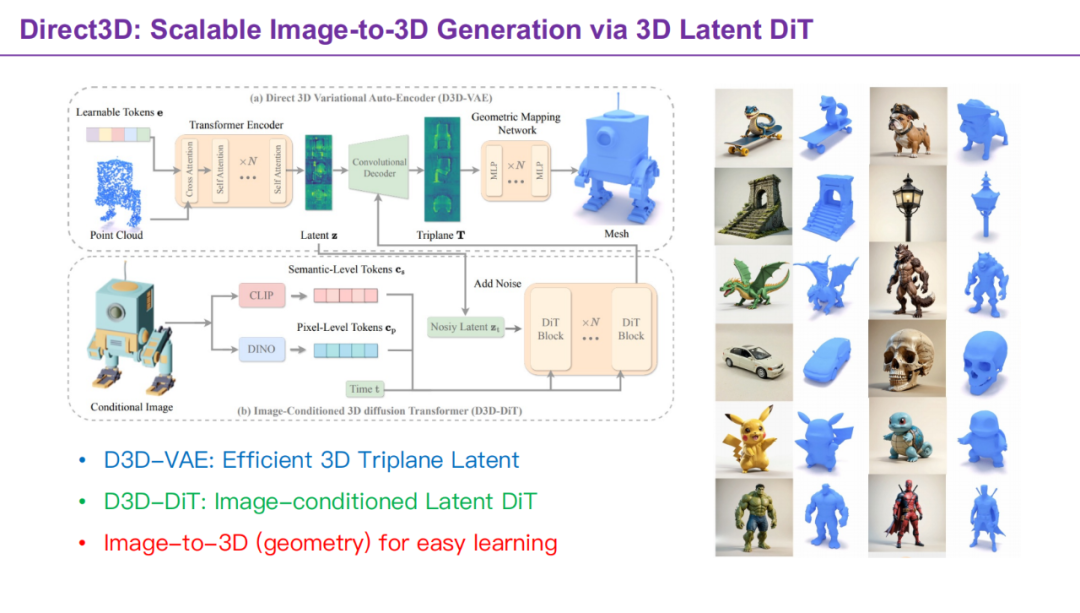

姚博士进一步展示了Direct3D方法,该方法通过 Latent DiT 实现了从图像到3D的几何生成。该方法采用半显式表达:保留一定结构信息的 triplane,只需要相对较少的数据就可以实现优秀模型的训练,在几何准确性、细节精度及保真度上,Direct3D均展现出明显优势。

本次报告全面而深入地展示了三维计算机视觉领域的前沿进展与应用前景,从三维重建、真实感渲染再到三维生成,不仅呈现了学术研究的广度与深度,也彰显了这一领域在元宇宙与数字化场景建模中的核心价值。姚遥博士的这场报告为AIR师生提供了宝贵的学术启发,也为未来三维计算机视觉领域的发展指明了重要方向。