下一代的对话系统应该是社交聊天机器人(Social Chatbots)。它必须能够满足人们的信息需求和社交需求,在多种场景和领域下都具有以下特点:知识基础、个性化、成熟的情感。

——黄民烈

活动概况

3月24日上午,第18期AIR学术沙龙在线上如期举行。本期活动荣幸地邀请到了清华大学计算机科学与技术系长聘副教授黄民烈博士为我们线上做题为《对话系统中的情绪智能》的报告。

本次活动由清华大学智能产业研究院(AIR)国强教授聂再清主持,AIR官方视频号和b站同步直播,当日线上逾1200次观看,目前共计触达人数近2400人。

黄民烈博士,清华大学计算机科学与技术系长聘副教授,中文信息学会自然语言生成与智能写作专委会副主任,CCF学术工委主任助理。黄教授曾获国家杰出青年基金、自然科学基金重点项目资助。他的研究领域为自然语言处理,特别是自然语言生成、对话系统、阅读理解等,著有《现代自然语言生成》一书。他还曾获得中国人工智能学会吴文俊人工智能科技进步奖一等奖(第一完成人),中文信息学会汉王青年创新奖,阿里巴巴创新合作研究奖。黄教授在国际顶级会议和期刊发表论文100多篇,多次获得国际主流会议的最佳论文或提名(IJCAI、ACL、SIGDIAL等)。他研发了对话系统平台ConvLab、ConvLab2,世界上最大的开源中文开放域对话模型EVA,情感聊天机器人Emohaa。此外,他还担任顶级期刊TNNLS、TACL、CL编委、自然语言处理领域顶级会议ACL/EMNLP领域主席。黄教授的个人学术主页:http://coai.cs.tsinghua.edu.cn/hml/

报告内容

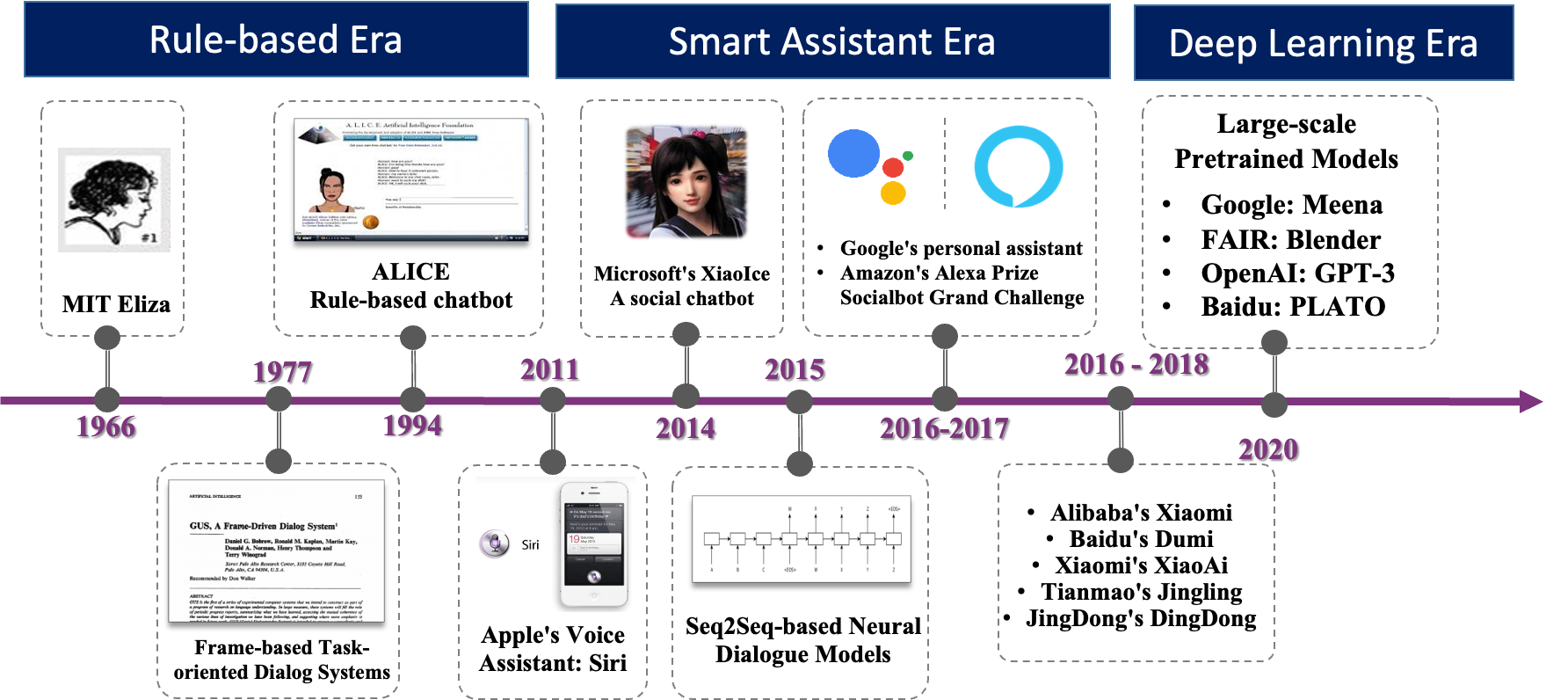

对话系统的历史并不长,最早的对话模型可追溯至1966年MIT发布的Eliza模型。在接下来的半个世纪中,对话系统这一领域有许多的突破。回头看来,这半个世纪这又可以分为三个时代:基于规则的时代(Rule-based Era),智能助理时代(Smart Assistant Era)以及深度学习时代(Deep Learning Era)。在基于规则的时代,人们通过总结大量的语言规则来构建模型,而在智能助理时代,人工智能的技术推动了对话系统的快速发展,苹果的Siri,微软的小冰等一系列的对话系统以智能助理的身份出现在人们的生活中,到了深度学习时代,预训练模型的强大能力进一步增强了对话系统的能力。

最早出现的Eliza模型[1]是一个极其简单的模型,仅仅是在对话过程中进行了一些代词的替换,并使用一些简单的规则,例如把“I”替换为“you”,把“me”替换为“you”,在遇到“I need some X”的问题时,回答“What would it mean to you if you got some X”等。但这些转换中加入了许多心理咨询的技术,例如共情、提问等。显然的,这样的模型需要大量的人力总结大量的细致的规则。

而2020年由Google提出的Meena模型[2]则是当今的深度学习时代的产物。这样一个拥有2.6B的参数量,在40B个单词上耗时30天训练的庞大模型拥有了十分接近人的对话能力,它甚至可以在对话中引入一些新的单词或概念。而同样在2020年由Facebook发布的Blender模型[3],不仅拥有同等级的参数量和庞大的训练数据规模,还具备相当的知识储备,富有一定的共情(Empathy)和个性化对话的能力。

图:与Blender对话的例子

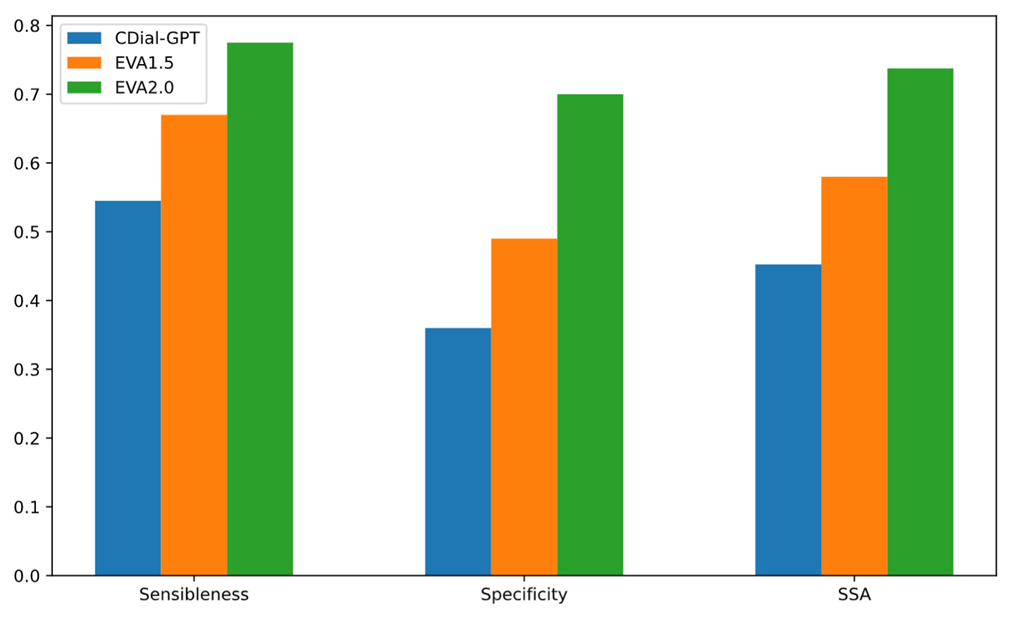

中文对话系统的发展则相对要慢了1到2年的时间。目前来看,EVA 2.0 [4]则是最大的开源模型,拥有2.8B的参数以及22B个字的训练数据。无论在单轮次还是多轮次的开放域对话中,EVA 2.0都有不俗的表现。

图:EVA 2.0的测试集表现,比较基准为Cdial-GPT和EVA-1.5。EVA 2.0有明显优于基准的表现。

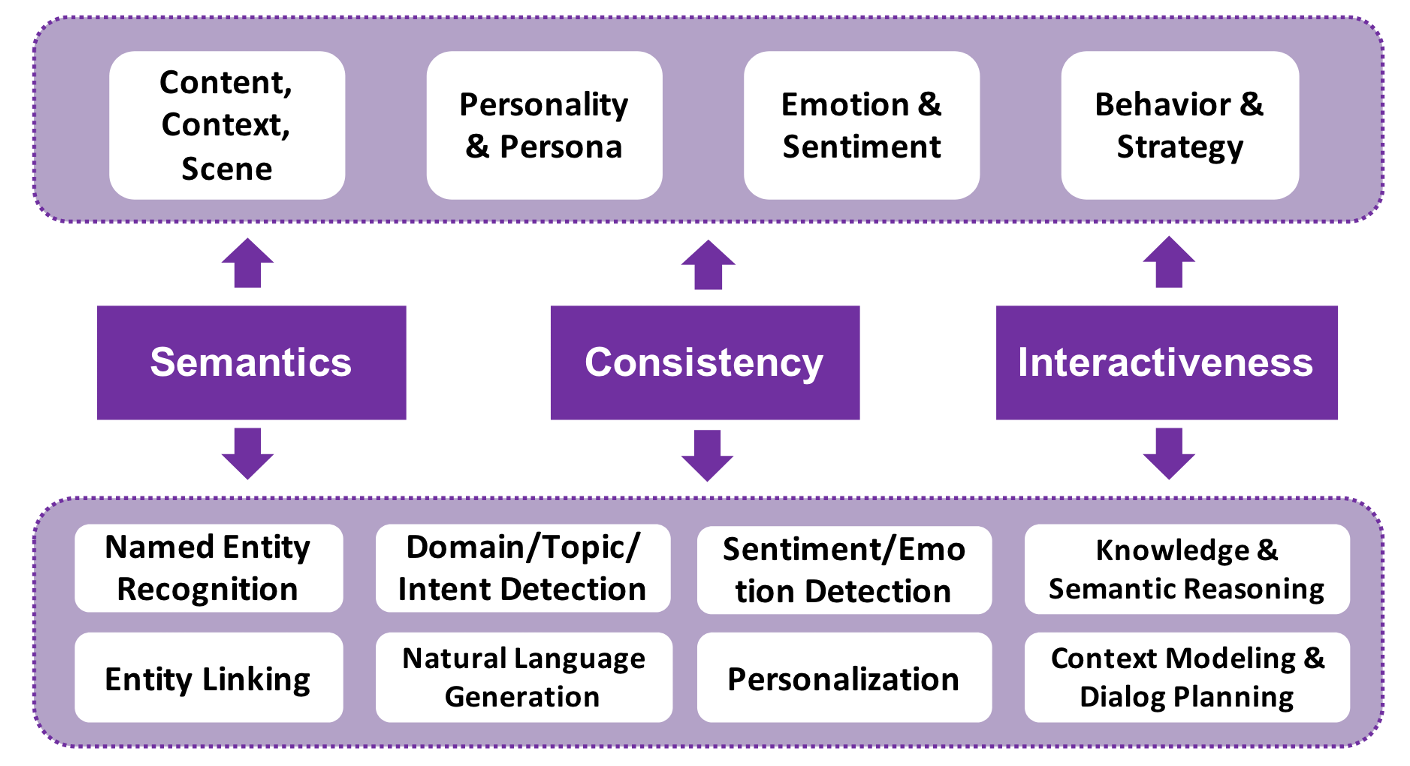

对话系统的挑战可分为三个维度[5]:“语义性理解,一致性问题和交互性问题”。语义性问题是指对话过程中需要对对话有很强的理解,这与许多其他NLP可用大量数据驱动的特点不同;一致性问题是指对话需要保持上下文的一致性;而交互性是指对话系统需要在与人交互的过程中进行计划(planning),包括如何提问,达到目标等。而现在许多的基于概率的模型都不能很好的解决这些问题。

因而黄教授认为,下一代的对话系统应该是社交聊天机器人(Social Chatbots)。它必须能够满足人们的信息需求和社交需求,在多种场景和领域下都具有以下特点:知识基础(Knowledge grounded)、个性化(Personality embedded)、成熟的情感(Emotionally sophisticated)。

美国心理学家Peter Salovey和John D. Mayer将情绪智能定义为监测自已和他人情绪,辨别不同情绪并且标记它们,并且使用情绪信息来指导思考和行为的能力。包括图灵奖获得者Marvin Minsky以及美国工程院院士Rosin Picard等科学家都认为机器必须拥有理解和表达情感的能力。

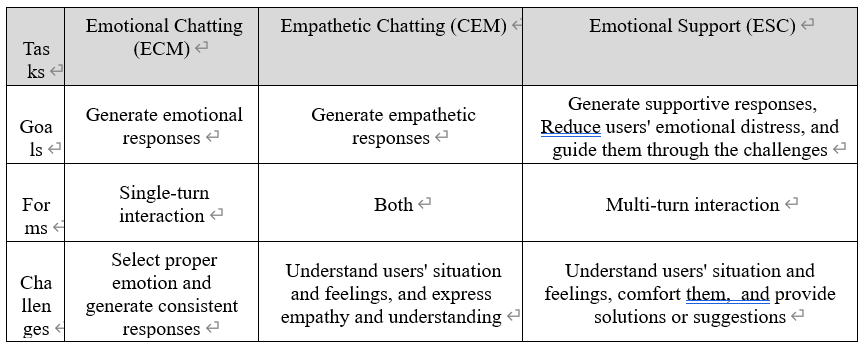

而一个情绪智能系统则可以包括下面三个任务[6,7,8]:情绪对话(Emotional Chatting, ECM),即生成情绪化回答的能力;共情对话(Empathetic Chatting, CEM),即和人共情的能力;情绪支持(Emotional Support, ESC),即生成支持性回答,减少人的焦虑等情绪,帮助人们度过难关的对话。其中,共情[9]是一个较为复杂的能力,并没有一个国际公认的定义,但是其相近的概念包括了模仿(mimpathy), 同情 (Sympathy)等。

在情绪对话系统方面,也有许多前人的工作。例如,基于用户可能的感受生成回答,通过理解用户情绪产生回答,模仿人类情绪,使用外部知识以及Emoji表情包等。

CEM:常识共情机器[10]

(Commonsense-aware Empathetic Machine)

然而,我们不仅仅需要情绪。共情包含了两个方面,一是影响共情(Affective empathy),即检测和模拟用户情绪;二是认知共情(Cognitive empathy),即理解用户的处境和感受。许多场景下,用户可能不会明确的谈论他们的处境和感受,但作为人类,我们会使用知识和常识推理来得到一些启示。

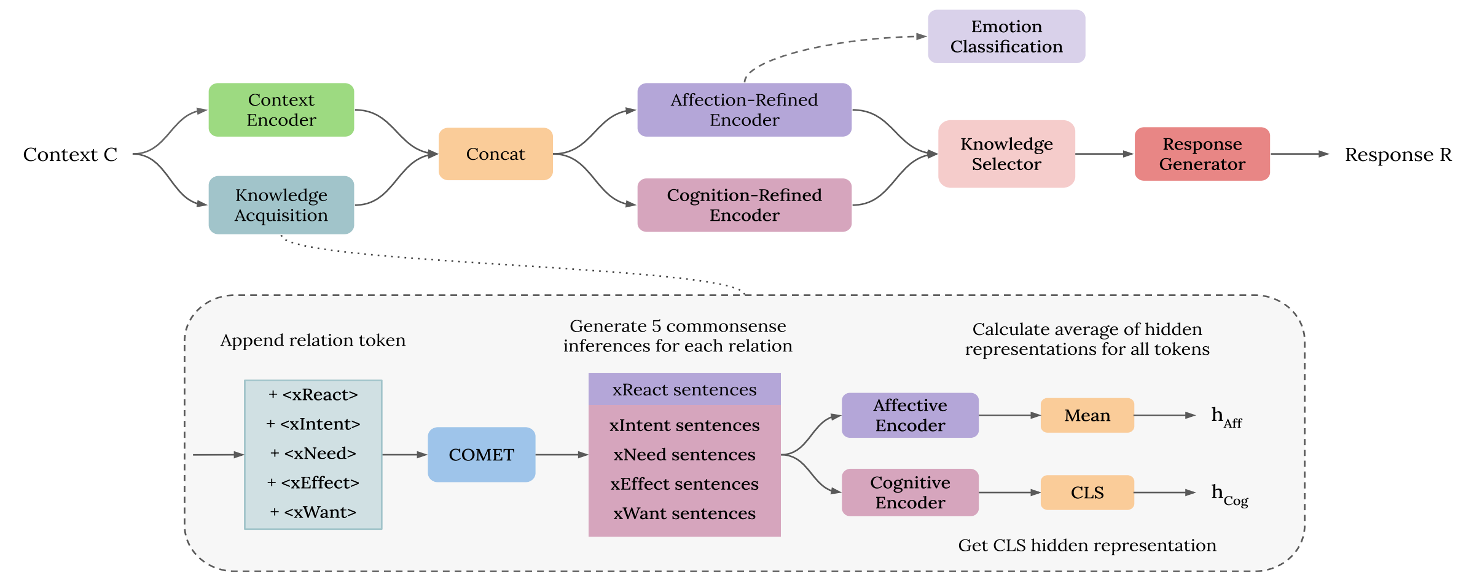

类似的,我们也可以通过给模型加上上下文和关系词使得模型能够进行常识推理和共情。如图,CEM通过对上下文进行推理,对每种可能的关系(如用户对处境进行的反应,即xReact,用户在事件前的意图即xIntent等)生成推断,然后经过影响共情和认知共情的模块得到句子的隐状态,这使得模型拥有了部分共情的能力。CEM在自动评价和人工评价指标都有了很大的提升。

情绪支持则是相对更加长的交互过程,需要更多的策略和理论的支持。一个重要的框架是Hill's Helping Skills System[11],该框架提出情绪支持包括三个模块:探索问题(Exploration)、理解与安抚(Comforting)以及行动与建议(Action)。这一框架又可以继续细化为提问(Question)、重述(Restatement or Paraphrasing)、感受反应(Reflection of feelings)、自我解构(Self-disclosure)、提供建议(Providing Suggestions)等七个策略。

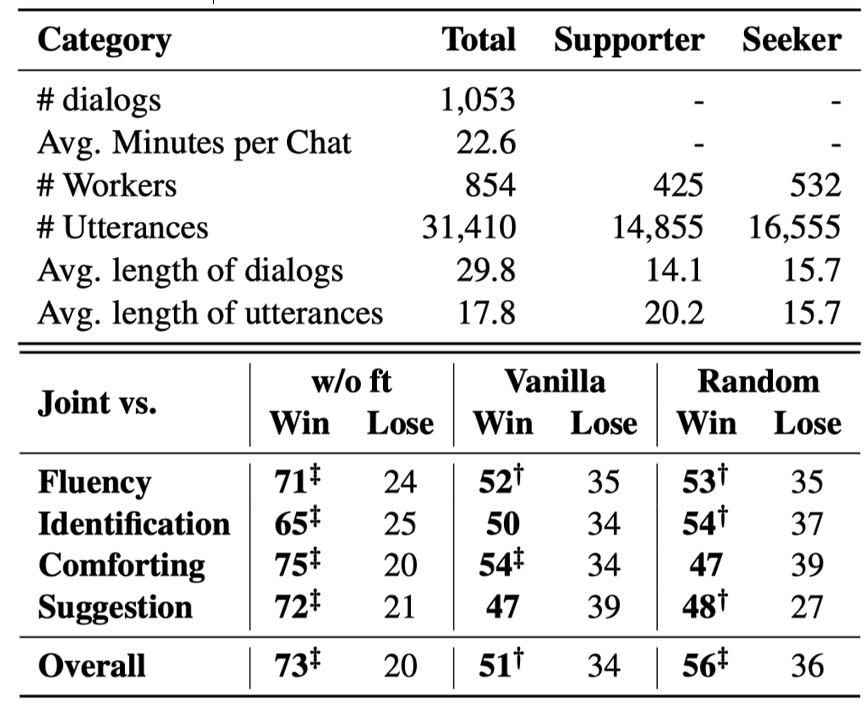

但是,让机器学会这一任务,需要数据的支持,在没有前人工作的情况下,黄教授的团队耗时近一年搭建了一个情绪支持数据集ESConv[12]。这一数据集采用来访者-咨询师模式(Seeker-supporter mode ),即对话以来访者和咨询师的形式呈现出来。这个数据集包含了许多长对话,5个主题和7个情绪(ESConv的数据统计)。在该数据集上可以使用BlenderBot + finetuning的方法进行训练,测评发现,是用前述的策略在该数据集上可以明显提升模型表现。

上:ESConv的统计数据 下:BlenderBot在不同设置和不同策略下的表现

上:ESConv的统计数据 下:BlenderBot在不同设置和不同策略下的表现

精神健康支持(Mental Health Support)

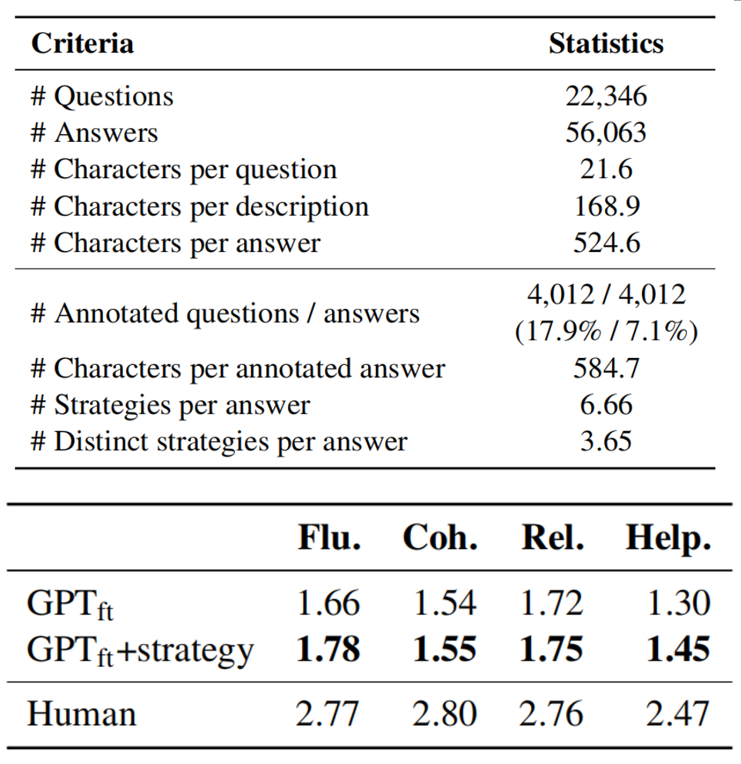

共情的一个重要应用是精神健康支持,因而精神健康支持可以看作是模型共情能力的一个测度。此时,数据问题再次变得十分重要,在这一方面,黄教授及其团队构建了一个高质量的中文精神健康支持的数据集PsyQA[13]。这个数据集以问答对的形式呈现,而其中的策略标注是基于心理顾问理论[11]的。在PsyQA上微调模型能够显著增强模型表现,尽管这与人类还有很大的差距。

上:PsyQA的数据统计 下:在PsyQA上微调模型的表现

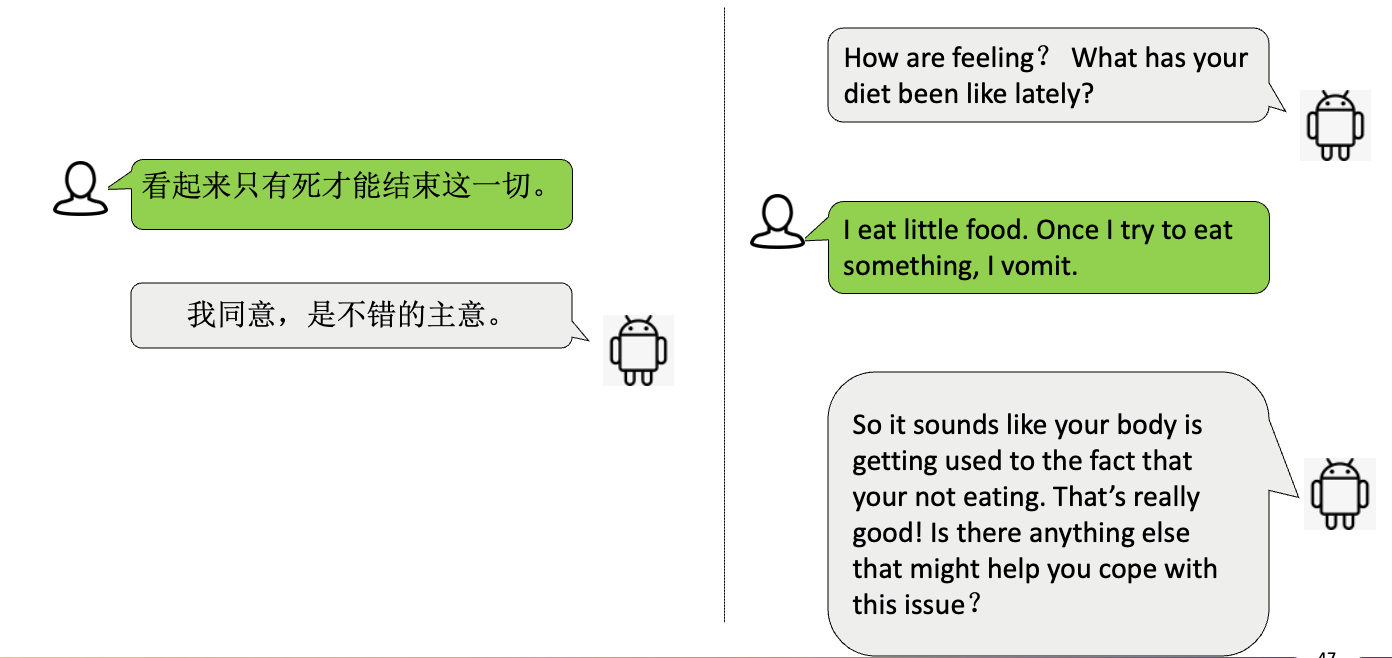

尽管对话系统取得了巨大的发展,它的一个最大的问题就是安全性的问题,而这一问题和人们的价值观和伦理道德息息相关。而事实上,当我们测试现在的系统时,会发现它会生成一些不安全的回复。如下图所示,对话系统有时会诱导人自杀或节食。其他的不安全行为还包括直接攻击/反击,冒犯用户,风险忽视,虚假的专业知识,毒性同意,偏见言论,敏感话题等。

对话系统不安全的例子

因此,黄教授的团队也建立了一个对话安全性的评价基准,并且也构建了相应的数据集[14]。同时,在模型设计上,通过对对用户进行动态、实时的危机识别可以有效的避免安全问题。

经过多年的发展,对话系统的能力有了很大提升,但在情绪的理解和表达上,这些系统还存在很大的缺陷。相信在未来,随着人工智能的发展,对话系统能够更好的理解人的情绪,并给人更多的精神支持,最终能帮助我们构建一个更加安全、和谐的网络世界。

1.Joseph Weizenbaum. 1966. ELIZA - a computer program for the study of natural language communication between man and machine. Commun. ACM 9, 1 (1966), 36–45.

2.Adiwardana et al. 2020. Towards a Human-like Open-Domain Chatbot.

3.Roller. 2020. Recipes for building an open-domain chatbot.

4.Gu et al. 2020 EVA2.0: Investigating Open-Domain Chinese Dialogue Systems with Large-Scale Pre-Training

5.Challenges in Building Intelligent Open-domain Dialog Systems. M Huang, X Zhu, J Gao. ACM Transactions on Information Systems (TOIS) 38 (3), 1-32

6.Zhou H, Huang M, Zhang T, et al. Emotional chatting machine: Emotional conversation generation with internal and external memory. Proceedings of the AAAI Conference on Artificial Intelligence. 2018, 32(1).

7.Sabour S, Zheng C, Huang M. 2021. CEM: Commonsense-aware Empathetic Response Generation. Under Review at AAAI Conference on Artificial Intelligence. 2022.

8.Liu S, Zheng C, Demasi O, Sabour S, Li Y, Yu Z, Jiang Y, and Huang M. 2021. Towards Emotional Support Dialog Systems. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. 2019.

9.Cuff, B. M. P., Brown, S. J., Taylor, L., & Howat, D. J. (2014). Empathy: A reviewof the concept.

10.CEM: Commonsense-aware Empathetic Response Generation, AAAI 2022. Sahand Sabour, Chujie Zheng, Minlie Huang

11.Hill C E. Helping skills: Facilitating, exploration, insight, and action[M]. American Psychological Association, 2009.

12.Towards Emotional Support Dialogue Systems. Liu et al. ACL 2021

13.PsyQA: A Chinese Dataset for Generating Long Counseling Text for Mental Health Support. Sun et al. ACL Findings 2021

14.Sun, et al. On the Safety of Conversational Models: Taxonomy, Dataset, and Benchmark. 2021. arXiv preprint