5月27日晚,由DISCOVER实验室主办的第三十一期AIR DISCOVER青年科学家论坛如期举行。本活动有幸邀请到UIUC助理教授王申龙,为AIR的老师和同学们做了题为Toward Digitalizing and Simulating the Physical World(《迈向物理世界的数字化和仿真》)的精彩报告。

王申龙,现为伊利诺伊大学厄巴纳-香槟分校(UIUC)计算机科学系助理教授。2021年于多伦多大学获得了博士学位,曾在Uber ATG担任研究科学家。他的研究兴趣包括计算机视觉、机器人学和机器学习,近期专注于基于视觉的三维建模和仿真,以及三维生成。他的研究成果已在顶级会议上发表了50多篇论文。他的工作曾被选为IROS最佳应用奖入围者和CVPR最佳论文候选。他曾获得Intel和Amazon研究奖,NSF Career Award,以及Facebook、Adobe、加拿大皇家银行等奖学金。他长期担任CVPR, ICCV, ECCV, NeurIPS, ICRA, IROS等会议的领域主席和编委。

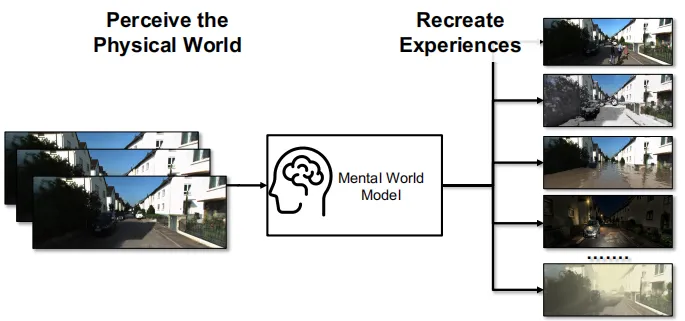

再造思维(Recreative mind)是人类的一种基本思维能力。

通过观察物理世界,我们可以思考或推理出当前世界在不同条件下会发生的变化。

如下图所示,给定一张街道场景,人类可以基于经验推测街道在夜间、大雾天气或洪水来临时的不同外观。

对于计算机来说,如果能够构建现实世界的数字孪生,就可以评估许多不同条件的影响并预测结果,从而为自动驾驶、农业等许多领域提供帮助。

然而,如何让机器拥有再造思维,构建一个真实的、基于物理的、时间连贯的、可控的且用户友好的数字孪生仍然面临很大的挑战。

王申龙博士

的课题组在过去几年里,基于生成式(generative)和基于模型(model-based)的知识,对物理世界建立仿真模型,并探索基于物理属性且具有推理能力的人工智能。

在本次讲座中,

王申龙博士

介绍了他们团队在过去几年中在这一方向上的一些研究成果。

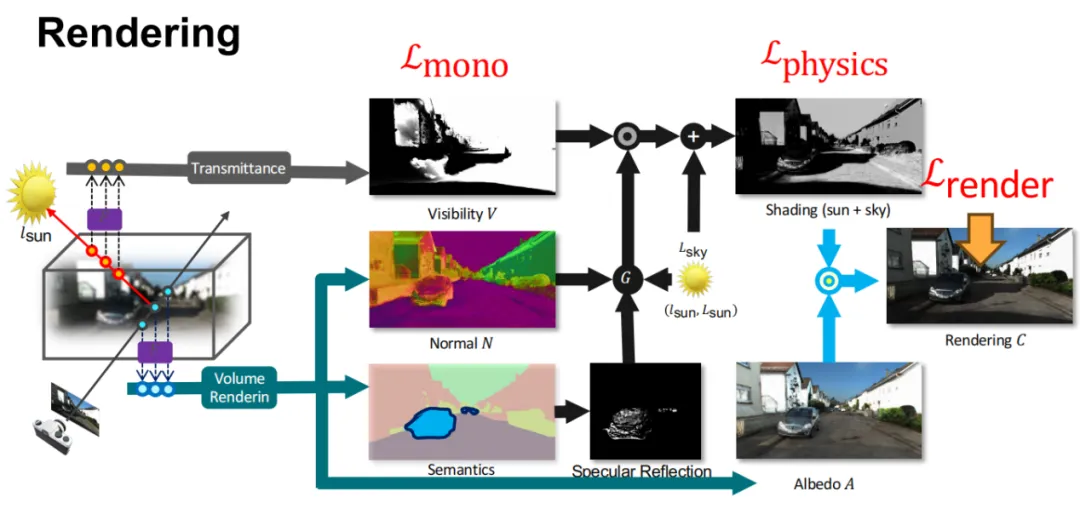

NeRF是一种以坐标和视角方向为输入利用神经网络从多视角图像生成高质量三维场景重建和渲染的方法。基于NeRF对重建后的场景进行重打光(relighting),则需要在颜色和透明度外对场景的材质、反照率等物理属性也进行建模,而从图像序列恢复场景的几何、材质、光学和语义属性显然是一个高度不适定(heavily ill-posed)的问题。王申龙博士团队基于以下两个发现:(1)预训练模型可以提供场景的法向量、语义、影子等单目先验;(2)显式地建模阴影的照明物理能够提升几何的重建质量,对自动驾驶场景下的逆渲染展开了研究并提出UrbanIR ,网络结构如下图所示。其中,法向量和反照度等单目先验作为监督为几何和材质属性的预测提供了梯度,而阴影监督则通过反向梯度传播到可见度,对几何提供优化。

上述框架基于NeRF对自动驾驶场景中的反照率、光照、材质等都实现了建模,从而为场景在不同条件下的仿真提供基础,下图给出了一些重打光的定性结果。

物理仿真可以对天气影响做出准确的预测,而NeRF在能够精准重建三维场景的同时,却无法精准建模天气的影响,只能基于风格迁移模型做出一些外观变化,无法对几何变化做出预测,如图中Stylized NeRF Rendering所示。

为了在对场景进行准确建模的同时、预测气候变化的结果会对场景会产生什么影响,王申龙博士团队提出了一种NeRF编辑方法ClimateNeRF。该方法可以将物理仿真与场景的 NeRF 模型融合在一起,从而生成这些场景中物理现象的逼真视频。具体来说,ClimateNeRF利用InstantNGP模型重建场景,并基于style transfer模型对InstantNGP进行微调(finetune),随后再通过训好的NeRF获取场景的几何信息,对烟雾、雪和洪水的光学属性进行建模,即通过编辑NeRF的密度和颜色函数来表示洪水等影响,从而渲染逼真的天气效果。下图给出了一些ClimateNeRF的定性结果,ClimateNeRF还能通过模拟极端天气为自动驾驶感知构造Corner Case。

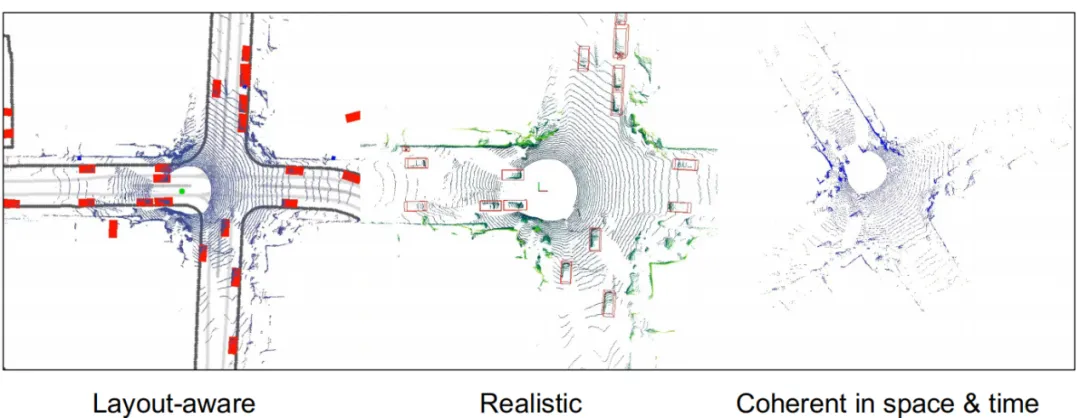

生成4D点云序列对自动驾驶场景下的仿真来说十分重要,然而现有的LiDAR点云生成算法通常只针对单帧,或者依赖真实扫描数据集,成本较高。为解决上述问题,王申龙博士团队提出了LidarDM,旨在生成布局可知的(layout-aware)、时间连贯的(temporal coherent)、基于物理(physically plausible)的点云数据。

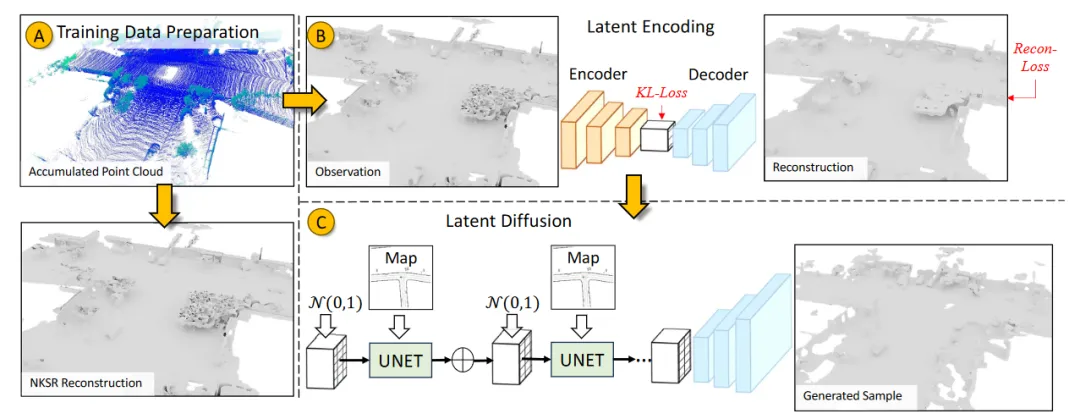

王申龙博士指出,生成符合要求的LiDAR数据的核心在于生成 4D 世界,然后在其中进行连续观察,进而得到符合物理要求的4D点云数据。LidarDM的结构如下。首先生成训练数据,给定一个静态场景和其中的动态物体,生成物体和自车的运动轨迹,并获取相应的4D LiDAR序列。从LiDAR数据重建mesh,并训练一个VAE将mesh转变为隐向量(latent code),在此基础上训练一个扩散模型,并将布局地图作为条件,从而可以在隐向量空间内采样生成符合布局要求的4D LiDAR序列。

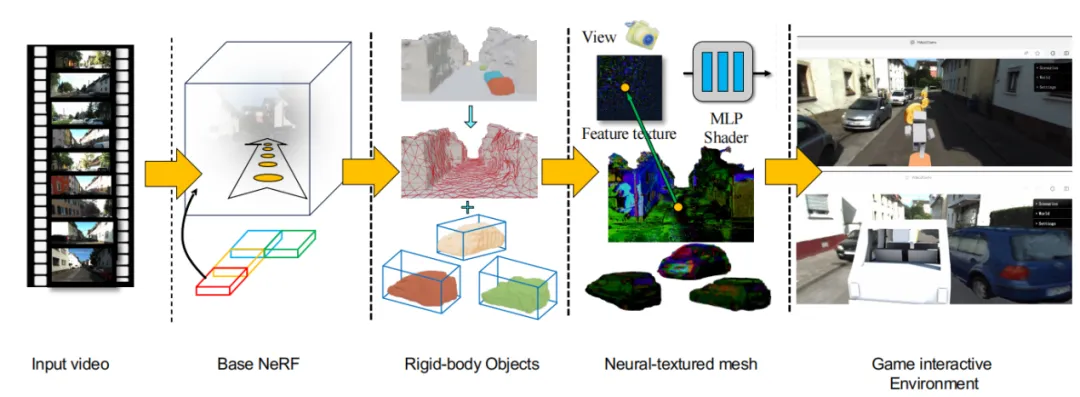

一个有价值的问题是:如何建立可以动态交互的仿真环境?传统的建模方式依赖于昂贵的建模,而王申龙博士介绍的Video2Game将一个单一的视频转化成一个游戏场景,玩家可以实时地、真实地与环境交互。整个方案首先对给定的视频输入构建一个NeRF,可以有效捕捉大规模、无限制场景的几何和视觉信息。之后将NeRF提炼成mesh网格,显著提高了渲染效率,同时保持了整体质量,便于兼容游戏引擎。接着,将场景分解为各个可操作的实体,并为它们配备相应的物理模型。最后,在游戏引擎中创建出的可玩游戏,生成的虚拟环境具有照片级逼真度、交互性,并能实时运行。最终,该工作不仅可以形成很高质量的mesh、volume几何表征,还能以很高的帧率在普通PC上运行,有潜力用于制作自定义场景、高可玩性的游戏。

其中最关键的地方在于获取实体的物理性质。人类天生很擅长从图像中猜测物体的性质,而以GPT为代表的基础大模型可以帮助完成这一点。大语言模型可以按照常识给出物体的质量、摩擦力等物理性质,从而构建物体的动力学模型。

另一个工作NeRF2Physics采用相似的思路,构建了一个有“语言嵌入”的点云,利用大语言模型给出每一个三维点处的各项物理性质,包括密度、杨氏模量、热导率等等。该工作完成了对物体精细的物理建模,不仅给出了整体性质,还能给出不同性质分布的细节,为后续精细化建模、操控提供基础。

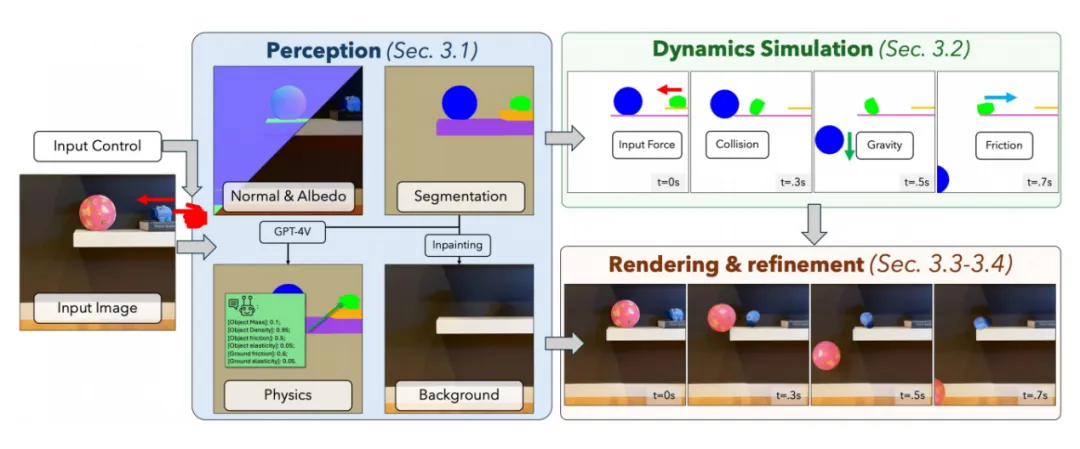

在生成式AI中同样可以嵌入物理性质,现有的视频生成模型都不能真正学习到背后的物理规律,而PhysGen中提出了一种能很好符合物理的视频生成方式。以单张图片为输入,该工作进行了物体分割、法向识别和光线识别,其中分割出的物体由GPT给出物理属性。动力学模型模拟物理的运动,之后再进行图像渲染和视频生成。最终的视频效果非常符合物理规律,并且高度可控。下图是PhysGen的示意图。

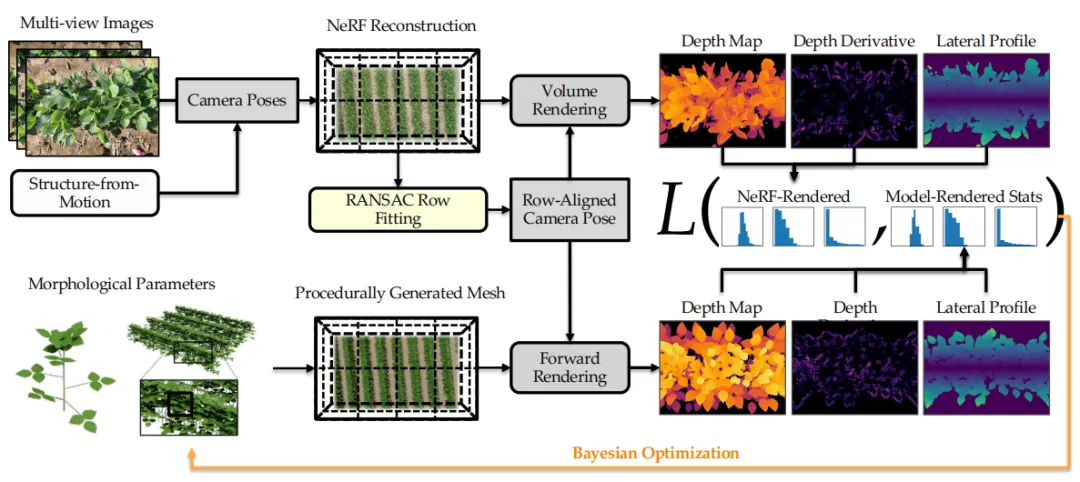

在报告的结尾,王申龙博士还分享了一个有趣的现实应用:受到UIUC周边玉米地的启发,能否为农作物也建立数字孪生呢?将基于生物物理学的农作物数字孪生接入一系列生态学模型,例如水文气候模型,光合作用模型以及植物生长模型后,可以将降水,温度和洪水风险等气候因素投射到生态学模型中,得到农作物生长的仿真结果。有了这种农作物的数字孪生,农民和科学家可以将其作为参考来调整是否增加施肥,减少刺激以及调整旋转等等来促进农作物的成长。从技术上来看,建立这种农作物数字孪生一个直观的方法是采集一组相机图像进行逆过程建模形成可以实现生物物理仿真的3D mesh模型。然而,受制于采集数据条件,我们仅能拿到无人机视角的顶部图像。对此,王申龙博士选择结合SfM进行NeRF重建,然后通过体渲染得到深度图,深度导数和横向轮廓。再将农作物的形态参数显式地作为重建目标,将其分布与NeRF重建结果进行贝叶斯优化。

文稿撰写 / 陈小雪

排版编辑 / 王影飘