11月25日下午,AIR DISCOVER青年科学家论坛第二期在清华大学智能产业研究院(AIR)如期举行。本期活动邀请到了毫末智行联合创始人兼CEO顾维灏做题为《数据智能的深思考与慢功夫》的报告。

报告中,顾维灏先生介绍了毫末智行近两年的发展情况,并围绕在自动驾驶落定过程中遇到的数据采集与治理、模型研发、芯片应用、安全解决方案等数据智能应用中的核心问题,给出了思考与探索。

报告内容

无人驾驶这条路看起来非常漫长,对于纯粹的无人驾驶来说,它在不同的场景下落地所需要的时间也不太一样。究竟什么样的场景,什么样的无人驾驶会更早得到来?

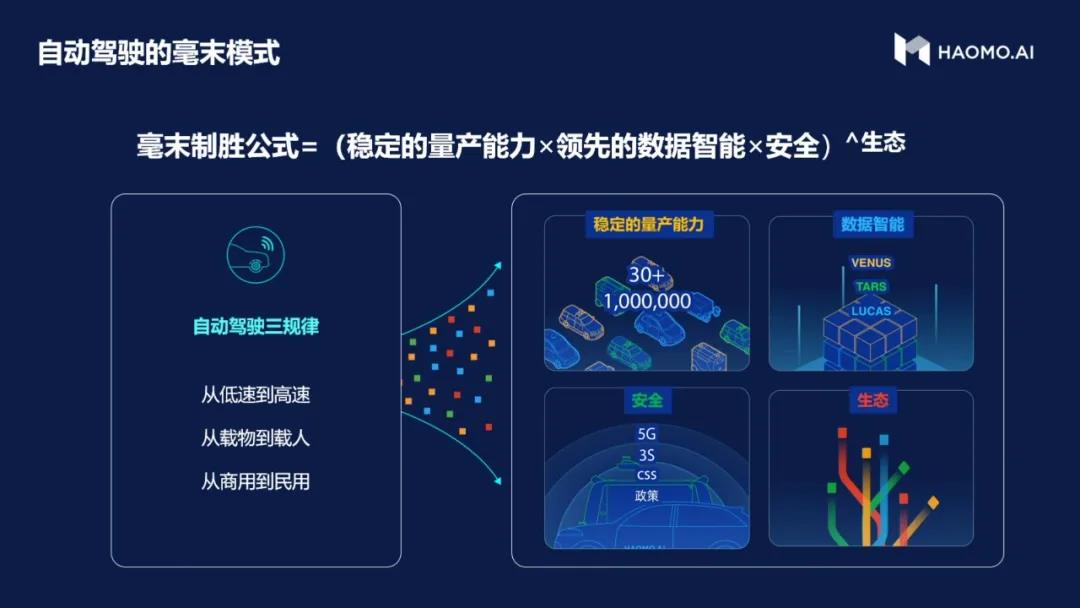

我们总结出了“自动驾驶三定律”的基础逻辑。我们认为,纯粹的无人驾驶出现的过程基本上是建立在这三定律的基础上,也就是“从低速到高速、从载物到载人、从商用到民用”。其中“商用到民用”,其核心想表达的是先做To B的业务,后做To C的业务;也可以表达为先做生产资料,然后再做生活资料。如果把低速、载物、商用这三个事情结合起来看,举个例子就会很快的明白。比如说仓储机器人,就是一个低速、载物、商用最典型的例子。仓储机器人现在已经在很多大型仓库里面得到广泛的使用了,它的速度不断提升。当下很多酒店、饭馆都出现了一些看似端盘子的载物小机器人,它们的速度在不断的提升,但是依然还是载物、商用的角色。在其他场景下,像走在校园里面给大家送餐、送外卖机器人的出现速度也越来越快。此外也会有很多人研究干线交通物流或者城市内的交通物流载具,总之低速、载物、商用的商业化周期最短。

基于这样的思考,我们布局了 “风车战略”这一公司发展战略,并总结出了:

成功模式 =(稳定的量产能力*数据智能*安全)^生态。

我们认为,量产之后,有了数据,通过实现数据的智能,保证产品的安全性。在这个基础上利用生态的能力,可以实现最终的成功。

以数据为基础,我们如何来实现智能化水平的迭代?

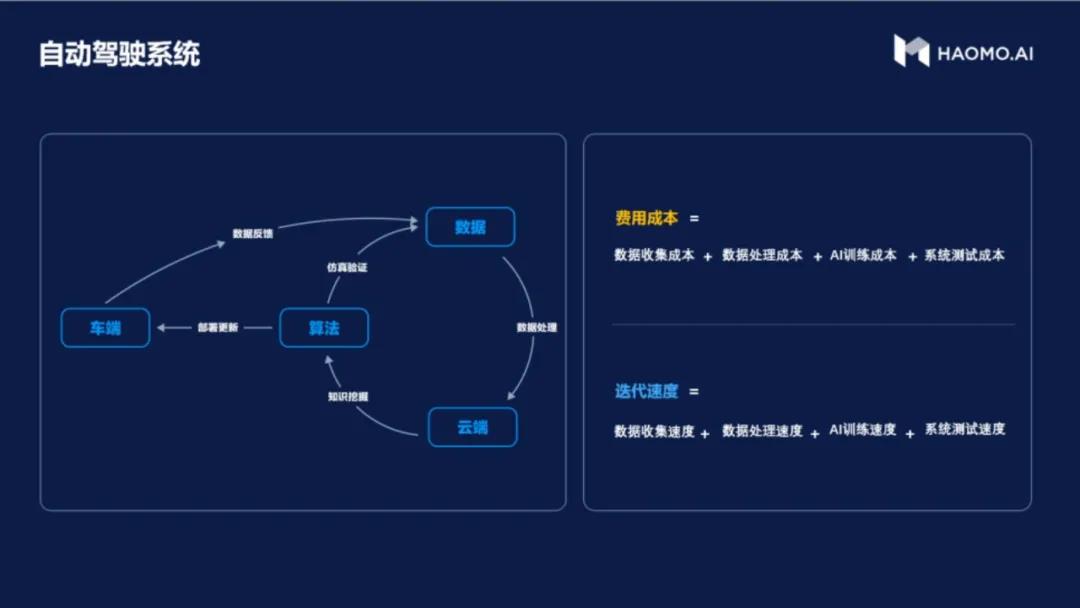

我们认为一般AI型的产品,不论是自动驾驶,还是语音识别、搜索等,其实都是通过算法、数据、云端做一个基础应用,用户在使用这个基础应用的过程中会给出来一些反馈,开发方再把这些反馈再收集回来,继续去优化,训练整个产品的效果,这也是一般AI型产品闭环的思路。

在这个闭环当中,有很重要的两个公式:一个是成本,另一个是迭代效率。首先成本包括收集数据的成本、存储数据的成本、训练数据的成本。需要寻找一种模式能够极大程度降低这个成本不断发展?另外是在互联网行业和移动互联网行业所积累的迭代速度。

2,000,000公里,我们发现了什么?

在用户行驶里程突破200万公里的过程中,我们发现真正的驾驶环境其实远远比坐在办公室里想像的要复杂的多得多。最早原型产品的形成,是我们坐在办公室里设想了一些场景,形成解决方案。但是这阶段的产品距离成为一个Killer APP,或者是特别完整的一种状态其实有非常大的差距。当越来越多用户在使用的时候,系统会检测到驾驶者开始介入接管了,或者说产品使用效果不好。那个时候究竟发生了什么?此时就需要把它拿回来研究。

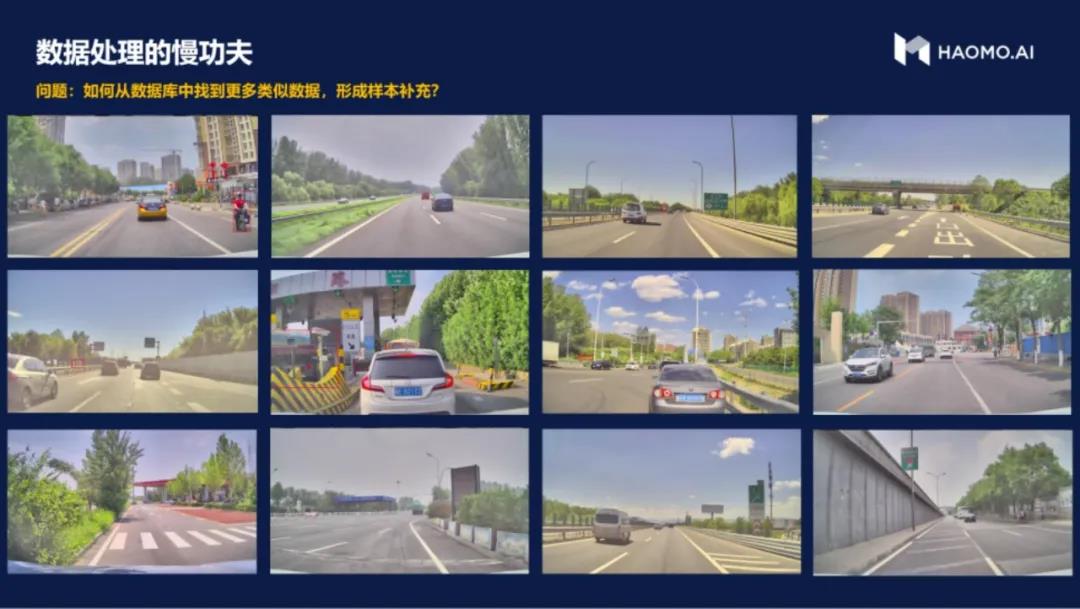

1、数据浩如烟海,如何找到对当前能力最优价值的数据?

我们发现数据非常多,到底该怎么样不断地优化我们初始设想的那个场景?我们的做法是把所有用户的反馈,使用好的和使用不好的,特别是使用不好的拿回来,再来修正模型。

2、车端能力有限,如何充分利用数据及算力资源?

由于芯片能力、功耗能力受限,我们利用云端的能力做一个更大的模型,用更多的数据,把它当成一个“老师”,而把端上的算法、端上的模型当做“学生”,大家去识别同样一批数据,因为“老师”的资源比较多,能力比较大,他一定会发现很多学生们发现不了的东西。把这些东西指出来,标识出来,“学生”再有针对性的优化,从而提高车端的能力。

如果把这种模型放在实际的驾驶场景里面,简单地筛选一些实际遇到的情况,就会发现在应对一些小目标或异型车时候,“学生”一开始识别不出来,而用大模型其实可以识别。例如,最初做训练的时候,大家标注的样本都是有限视角的,但是当走到路口的时候会有很多车辆的遮挡和截断,通过大模型,我们可以实现不同天气、光线条件下的泛化。通过这种方式发现,提升“学生”的能力。

如何解决数据偏见?

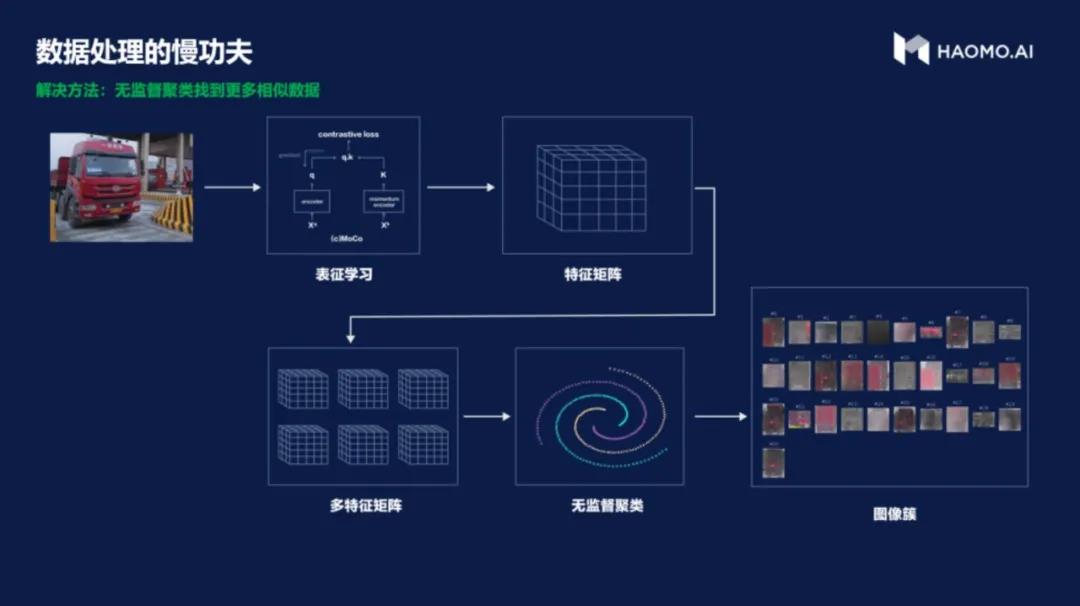

发现了这个问题,下一步会怎么样?我认为一方面要去完善算法自身的网络结构,但是更重要的是要找到更多相关数据。因为在处理样本的时候,会发现样本调和以及训练数据的调和是一个大问题。比如说黑夜这种情况,所有的样本里面只出现了这一张,其他的都是白天的,此时对算法的要求就会很高。我们更希望用数据的方式来解决,通过调和找到更多问题数据的样本。

问题:如何去找到这些问题数据的样本?

比如这张照片是“老师”告诉“学生”这些检测不出来,包括自行车、遮挡、截断和一些特殊情况,此时就要到非常大的数据库、数据集里面寻找相关数据。

我们采用无监督学习的方式,首先是把图片转化成一些特征,后采用无监督聚类的方法在一个数据集里找到更多和这张图片特征相似的数据。把这些数据加入到整体的样本集里面调和,从而提高数据质量。后通过人工的抽查和复检,去除错误数据,以此来保证数据质量的纯粹性。我们通过一些特定环境的实验,包括有树丛的遮挡,和障碍物遮挡截断,最终成功利用上述方法找出了更多的样本数据。当然这个结果也不是百分之百正确的。因此算法后面还需要人工的抽查和复检,比如说要去检自行车,如果把轮椅检出来,后台检测人员觉得它不是这种类型的话,人工就会将其标记并从数据集里去掉,保证数据集的准确性。

更多数据,如何训练的更快?

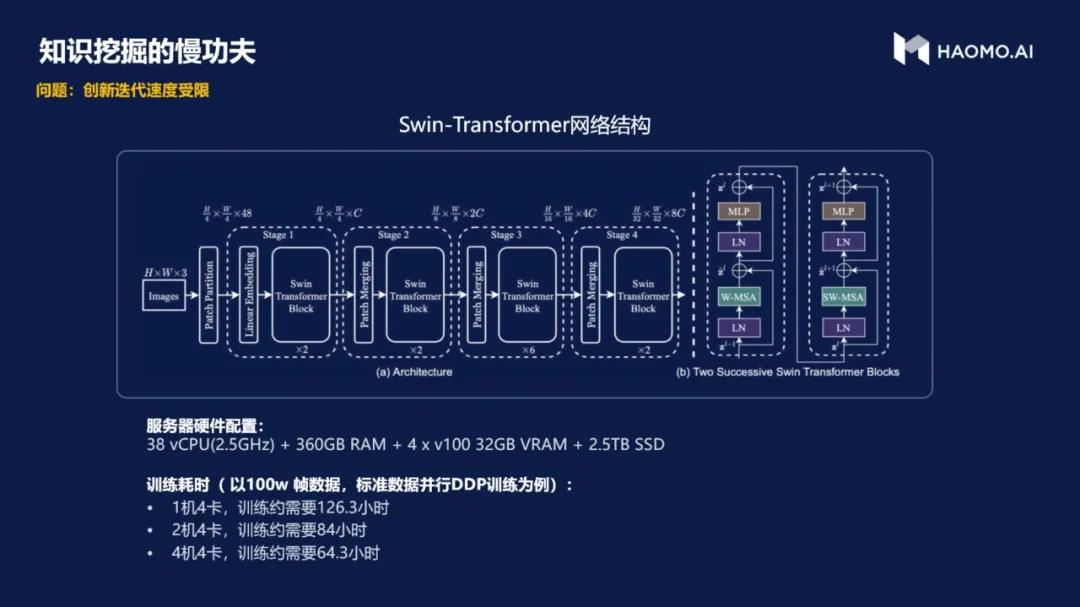

在解决了模型的识别与补充后,我们发现收集到的数据越来越多,因为用户使用的规模越来越大,基础数据和样本数据规模快速增长。在这种情况下如何能够加速训练?我们在云端采用了Transformer等模型。通过简单比较,发现如果用1机4卡的硬件配置,用100万帧的数据规模训练一个数据,差不多要100多个小时才能够训练完成一遍。但AI训练可能会遇到过很多突发情况,例如模型需要调整或者各种问题引起的训练终止,所以真正完成训练的时间只会更长,这成为了阻碍迭代产品和创新的一个重要问题。

此时的问题变成了当有了更多的数据之后,怎么样能够训练得更快?业界通常会单独或同时使用一些典型的并行训练方法,包括数据流并行、任务并行、工作流并行。我们也是如此,把Transformer上面的不同层次做适当的并行,来加速整个训练过程,最后整体的时间确实大大缩短了。

更多模型,如何更快的测试验证?

当已经可以更快地训练一个模型,并且更快地产出结果之后,面临的下一个问题是如何能够更快的去验证模型的可行性。

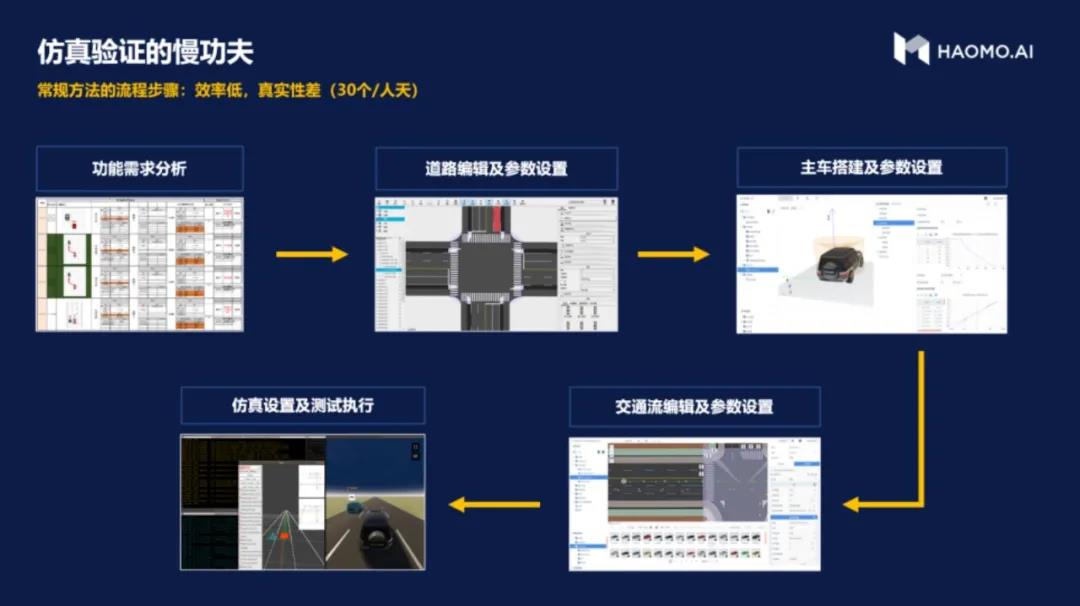

我们在这个验证的过程中使用了仿真实验,和一般的仿真不太一样的是,在传统的仿真场景设定上需要有交通流,有产品自身的情况,也有道路的情况。如果人工一个个去设置在路口下产品自身按照什么速度、什么方向行驶,周围的交通流是按照什么标准行驶,把这些交通参与者、道路模型和产品本身的模型建设进来,会让这个交通场景爆炸得非常厉害。差不多一人一天只能完成二三十个仿真实验的方案,进展会非常缓慢。因此我们在尝试了很多方式后,最终采用了语义化的仿真场景描绘方法,通过语义去描绘一个自动驾驶的场景,从而约束场景爆炸的情况,使之处于一个更加稳定、可维护的状态。

但是如果把这种状态又落回到真正验证的时候,又需要让它产生更多的爆炸,这种爆炸就也需要通过语义化仿真的工具,把用语义化描述的场景再做更加量化的场景扩充,然后再用仿真更多的来验证。这样的话,仿真实验也可以在云端进行,整体仿真和验证的效率就得到了极大的提升,也可以加快技术整体的迭代速度。

车端选择什么样的芯片?如何部署?

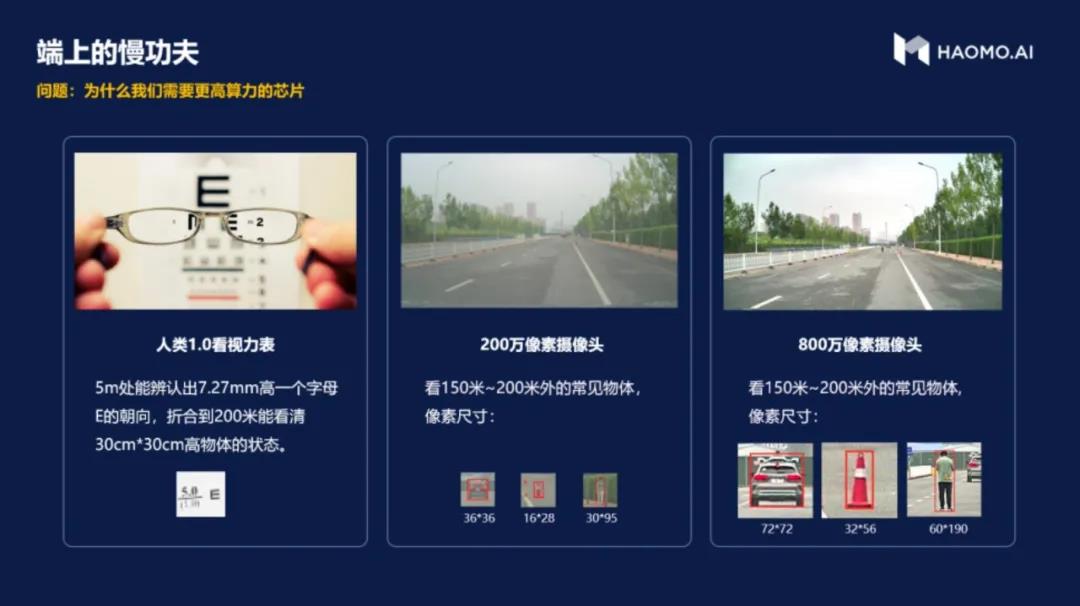

虽然刚才讲解了大量关于云端的技术,但是在可预计的一段时间内,自动驾驶核心的计算能力主要还是在车端。车、云之间的通信网络现在还不是那么稳定,通信的频度和承载的数据量都不会有那么大。如果系统性地考虑这个问题,就会发现传感器,车端的芯片或者车端的计算能力从过去几年的发展趋势来看在快速增加。三四年前量产车的车端计算能力只有2T,去年的时候,量产车的计算能力就达到了20T,到明年车端产品的算力就会达到300多T,预计未来两年还会再出现两三百T的计算芯片。所以在过去一段时间,端上的计算能力在以10倍的速度增长。

为什么会有这种增长?其实核心还是由传感器信息量的变化所带来的端上计算能力的增强。很明显的是像素的变化,现在主流的汽车基本上都是100万像素的摄像头。但是今年已经开始出现,并预计来会变成标配的是800万像素。从100万到800万像素,单张照片的信息量就会扩充很多。另外每个车所搭载的摄像头也会越来越多,现在主流的车只有几个。到更长一段时间之后,当大家逐渐把整车都武装起来,每个车差不多会配备有12个或者14个摄像头。单个摄像头像素的增加和整车摄像头个数的增加,导致了在车内需要一个更强算力的计算器,这也是大家不断的在比拼车端的算力原因。

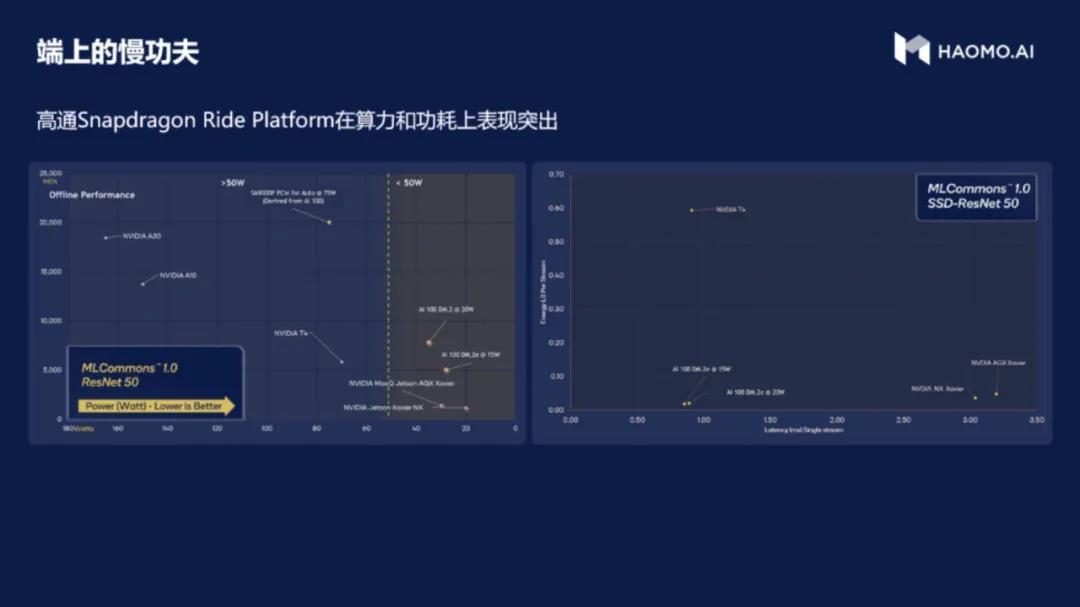

我们在选择车端芯片的时候考虑到了功耗、成本和整体的计算能力等问题。在英伟达、高通,以及诸多国内品牌间做了很长时间的对比,最后选择了高通芯片。高通的芯片除了算力优势外,已经在很多量产车上实现了落地应用。根据我们对于算力的评估,毫末智行硬件算力的有效率目前能达到50%,整体硬件的算力差不多是360T。在360T的计算硬件里面搭载100多M的高速缓存,这两个特点至关重要。利用这样的硬件特点,我们用一些标准化深度学习的模型,例如ResNet50限制一个图片大小,这种情况基本上可以达到每秒钟2万帧的状态,每一帧的识别效率可以达到30毫秒以内。

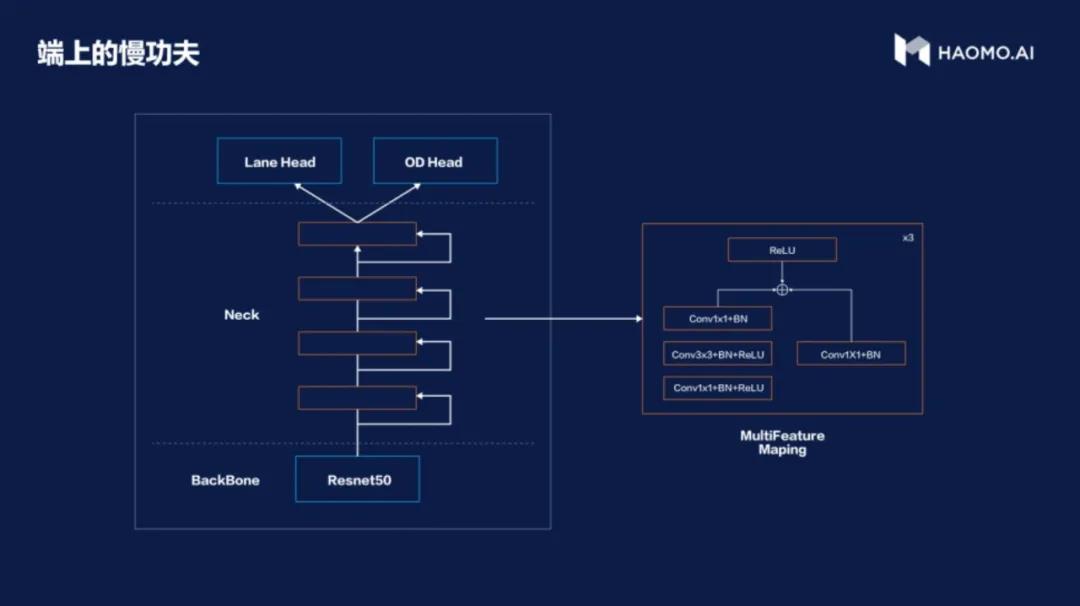

除了选择这样一个硬件之外,我们对于端上的学习模型也有自己的考虑。整体来说业界在这方面使用的方式结构是比较类似的,主要使用一个主干网。其中毫末智行使用的主干网是ResNet50。不同的是,我们向其中加入了一个多特征的聚合层,当特征经过了主干网以后,所有的特征都会通过中间的聚合层再做一层处理。这之后众多特征会被分成不同的维度。有的识别障碍物,有的识别车道线、有的识别行人,和每一类模型独立识别的方法相比这种方式的效率会更高。

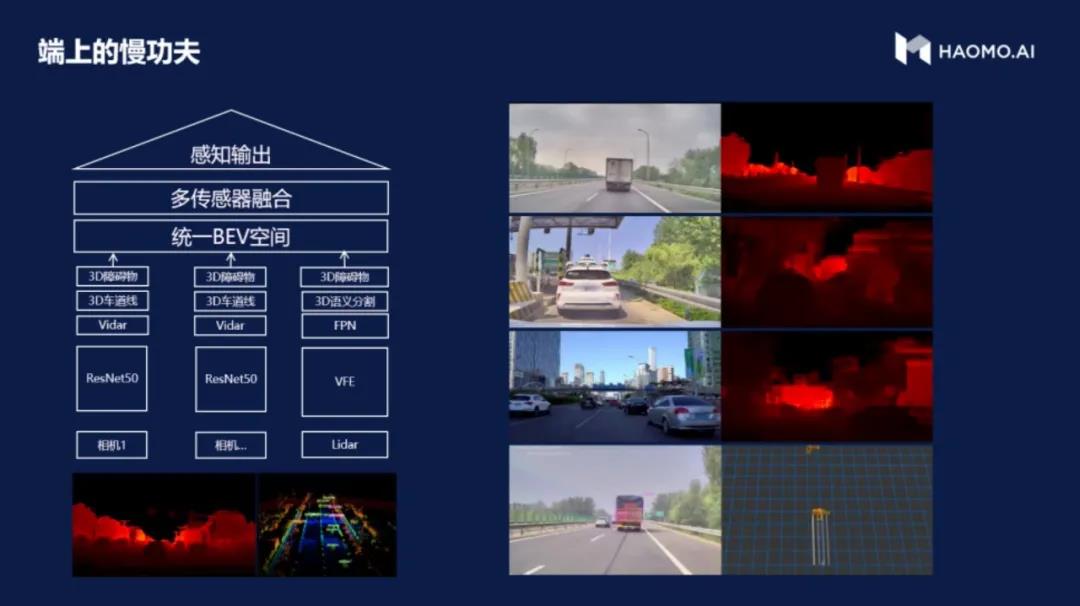

目前来看,我们取得的整体效果还不错,毫末在明年量产的车型里面,就会用刚才我说的360T的计算硬件,预计会有14个摄像头,和3颗激光雷达。对于相机来讲,每一个相机都会通过上述网络结构,识别出来之后,再把所有的识别结果统一到一个鸟瞰图融合后的障碍物空间。然后再做一层不同传感器的融合,最后完成感知的输出。对于我们来讲,现阶段研究重点还是对于图像深度的识别。希望可以和以清华AIR为代表的学术界一起合作,解决图像深度信息挖掘的问题。

如何考虑自动驾驶安全?

除了人工智能端上感知能力的实现,自动驾驶安全也是一个重要课题。车辆是高速行驶在开放的社会环境里,涉及到个体的驾驶安全和周围环境交通流的安全,所以自动驾驶的安全其实是逃避不了的话题。我们认为,安全是整体效果的第一个1,其他的实现出来都是1后面的0。

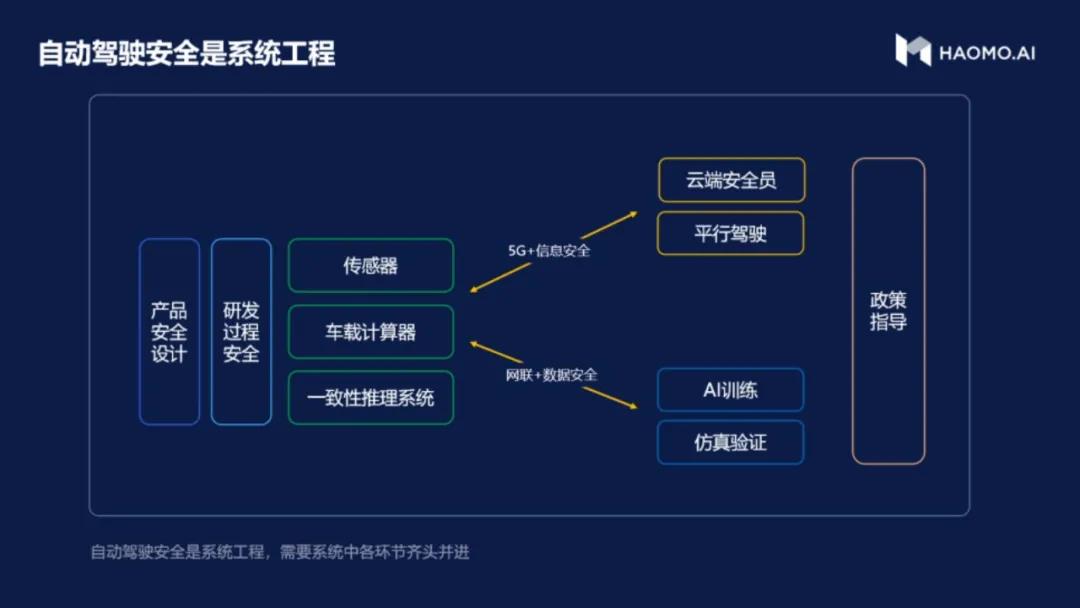

安全是一项系统性工作,首先要保证设计的安全,其次是研发过程的安全。此外还需要保证传输网络和数据安全、以及平行驾驶和远程控制过程中的5G和信息安全。

通过保障设计安全和研发过程安全,整个硬件和软件的配置,包括传感器、车载计算器以及一致性的推理系统的安全性能够得到保证,从而确保产品在运行过程中是安全的。此外产品在运行的过程中,还会通过回传一些数据,包括接管情况和一些关键的事故数据,用于我们整体的仿真。在这个传输过程中,需要保证网络安全和数据安全。因为现在对整个汽车界自动驾驶和辅助驾驶来讲,数据安全都也提升到了一个相当重要的程度。

除此之外是平行驾驶和远程控制过程中,要保证5G和信息安全,能够确保控制指令准确的被传输和执行。我们有一套对应的设计理念叫“协同场景安全”,在研发过程中结合整个汽车的研发流程,划分成段与检查点,来保证研发落地的执行。这需要传感器的冗余,我们认为目前解决周身传感的安全冗余问题,还是需要通过摄像头、激光雷达等多种传感器的组合。此外各种安全岛与车规级的安全芯片,包括一致性推理系统,也是保证控制流能够安全稳定的传输到车端的重要环节。

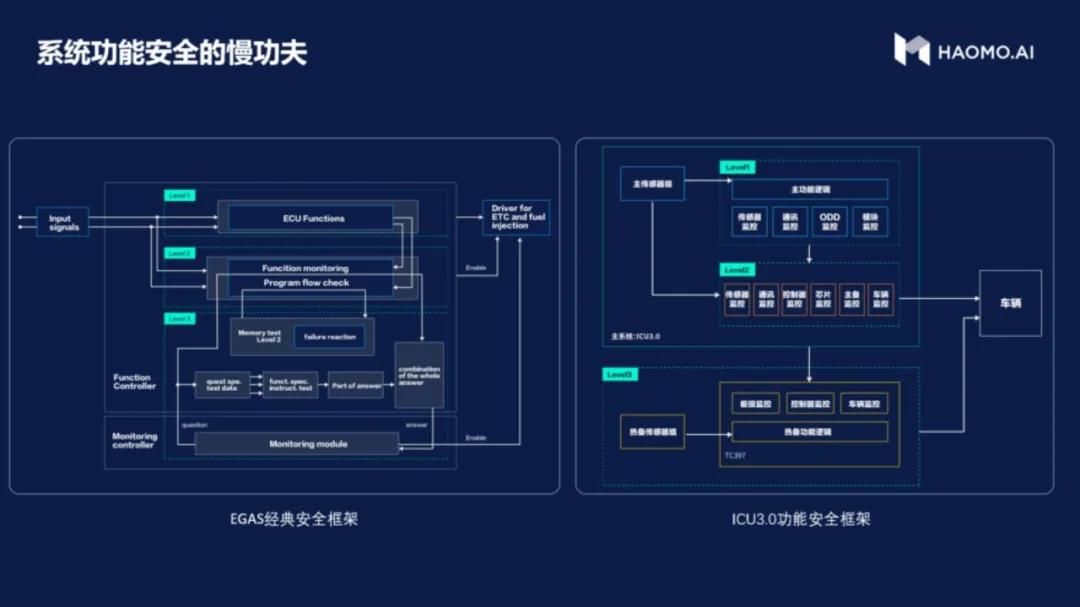

在车辆安全方面最基础的是功能安全。功能安全框架在很久前被称为EGAS,其要求在汽车内要遵循三层监控,达到L1、L2、L3的三层冗余安全。我们把这个思路借鉴到预控制器里面,第一层是监管保证应用的正常运行,这是L1的一种监控;第二层监控保障执行应用的芯片运行安全;第三层监控监控整个L1、L2硬件的运行安全。L1和L2的这两个芯片是在一个控制硬件里,L3这个硬件是在另一个控制硬件里,所以最后的这层监控就会监控整个L1、L2所在的硬件是不是在安全的运行。通过这三层监控,保证这个车在真正的辅助驾驶接管的时间内,它的应用是正常的状态。

通过我们的不断努力,将以上的各类硬件、算法基本上都集成在了毫末智行的产品里,做成一个满足车规级要求的产品,包括温度、震动、热度、寿命,基本上都能够满足车规级设计的要求。

最后,介绍一下毫末智行的情况。

毫末智行成立于2019年,是一家致力于自动驾驶的人工智能技术公司。“毫末“二字摘自《老子·道德经·第六十四章》“合抱之木,生于毫末;九层之台,起于累土;千里之行,始于足下。”喻为无论做什么事情,都必须具有坚强的毅力,从小事做起,才可能成就大事业。毫末智行品牌口号据此衍生为:千里智行,始于毫末。毫末智行的公司愿景,是以零事故、零拥堵、自由出行和高效物流为目标,助力合作伙伴重塑和全面升级整个社会的出行及物流方式。

精彩视频回顾及完整版PPT下载,请点击:

AIR DISCOVER | 顾维灏:数据智能的深思考与慢功夫