多模态超大规模的预训练模型无论是在研究还是在应用领域都有着巨大的前景,WenLan2.0的成功也印证了这一点。

——文继荣

活动概况

12月2日下午,第13期AIR学术沙龙在线上如期举行。本期活动荣幸地邀请到了中国人民大学信息学院院长、高瓴人工智能学院执行院长文继荣教授为我们做题为《超大规模多模态预训练带来了什么》的报告。

本次讲座由清华大学智能产业研究院(AIR)副院长刘洋教授主持,活动线上线下共计约1000人次观看。

讲者介绍

文继荣,教授,现任中国人民大学信息学院院长、高瓴人工智能学院执行院长。长期从事大数据和人工智能领域的研究工作,曾任微软亚洲研究院高级研究员和互联网搜索与挖掘组主任。到中国人民大学工作后,参与创立了高瓴人工智能学院,积极致力于推动人民大学人工智能和大数据的研究和教学,特别是新技术与人文社会科学的交叉。

2013年入选国家“海外高层次人才计划”特聘专家,2018年入选首批“北京市卓越青年科学家”,2019年担任北京智源人工智能研究院首席科学家。

报告内容

人类儿童是如何理解世界的?

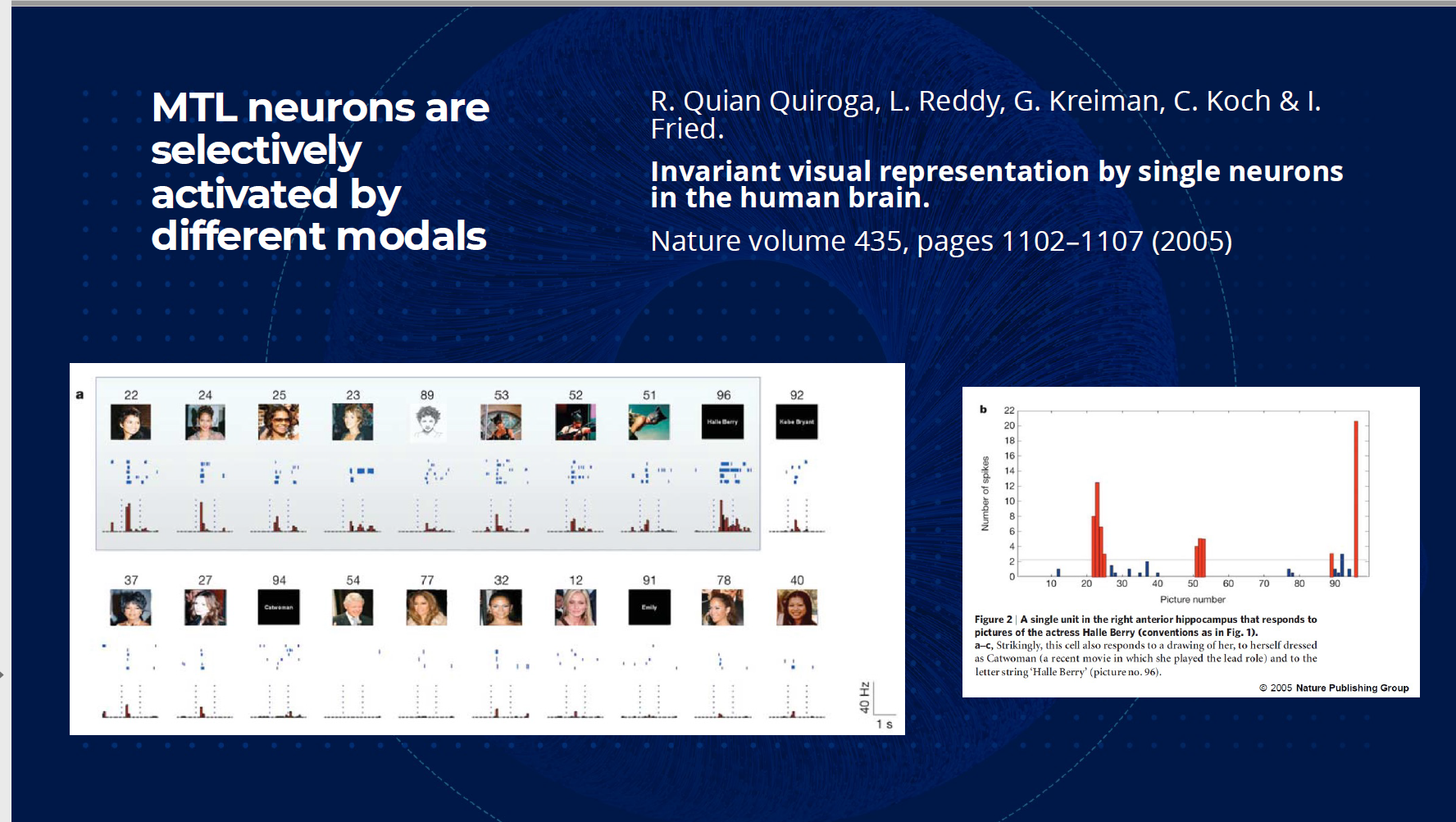

早在2005年,MIT和UCLA研究者【1】就发现人类在理解世界的过程中,多种模态的数据会激活相同的神经元。例如,人类在理解文本"克林顿"以及美国前总统克林顿的照片时,大脑中相同的神经元会被激活,这意味着人类大脑能够融合不同模态的多种信息。同时,我们成长的过程中的经验告诉我们,我们常常利用不同模态的信息学习知识,理解世界。例如,我们常常通过现实世界中的物体对应的不同语言来学习外语。那么,遵循这条路径,多模态的信息也应当能够帮助模型的学习和训练。

【1】Quiroga, R., Reddy, L., Kreiman, G. et al. Invariant visual representation by single neurons in the human brain. Nature 435, 1102–1107 (2005). https://doi.org/10.1038/nature03687

文澜——一个多模态预训练模型

文澜(WenLan)模型是北京智源人工智能研究院、中国人民大学和中科院计算所的研究团队在中国人民大学高瓴人工智能学院执行院长、智源首席科学家文继荣教授的带领下合作开展的大规模中文多模态预训练模型。目前文澜模型已经发布了WenLan2.0,并且在多项多模态与训练任务上取得了SOTA的成绩。

WenLan 1.0

WenLan 1.0是第一代文澜模型。具有以下三个特点:

在任务上,WenLan 1.0采用了图像-文本抽取作为预训练任务,这使得模型能够轻易得在下游任务上进行迁移;

在数据上,文教授的团队从互联网上挖掘了55M个的图像-文本对。这些数据涵盖了众多主题,能够有效的反应真实世界的场景。

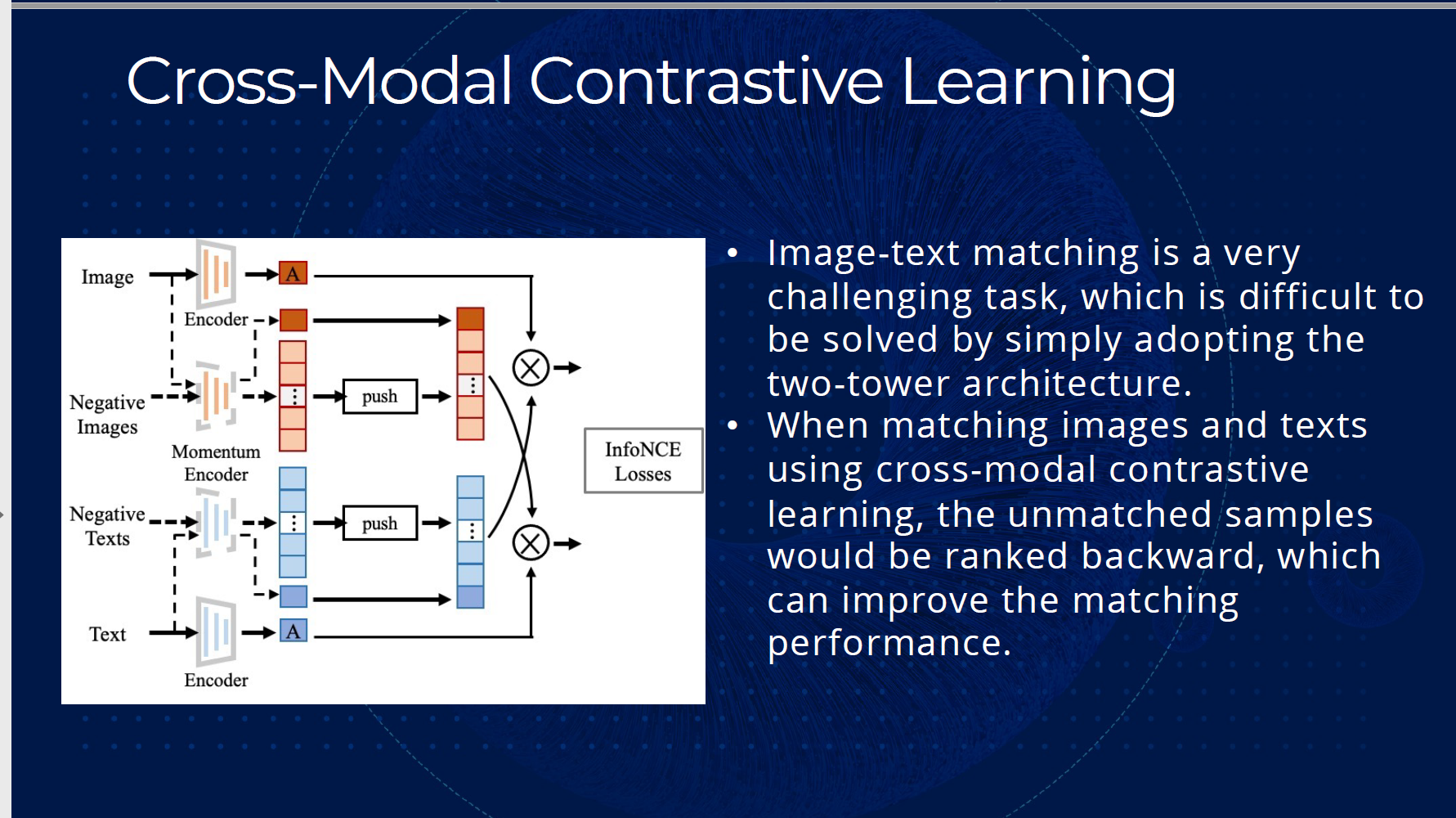

模型上,模型采用了基于弱相关的双塔的架构(Two-tower architecture based on weak correlation),这种架构在大规模的模型上效果尤其显著。其中,弱相关是指文本不再要求是图像的细节描述,图像也不再要求是文本的具体反应,与之相反的则是强相关。如下图所示,如果对这应一图像的文本是There are several burning candles on a fruit cake (水果蛋糕上有许多燃烧着的蜡烛),那么这就是符合强相关假设的数据;相反,如果文本是Happy birthday! Make a wish! (生日快乐,许个愿望吧!),那么这组数据则是基于弱相关假设的。显然的,弱相关的数据更广泛的分布在现实生活中,因此基于弱相关假设的模型能够更好的处理这些数据。

相比基于强相关假设的单塔模型(Single-tower assumption),采用了对比学习(Contrastive learning)的双塔架构能够更好的反应这种假设,从而极大的提升了模型的表现。

WenLan 2.0

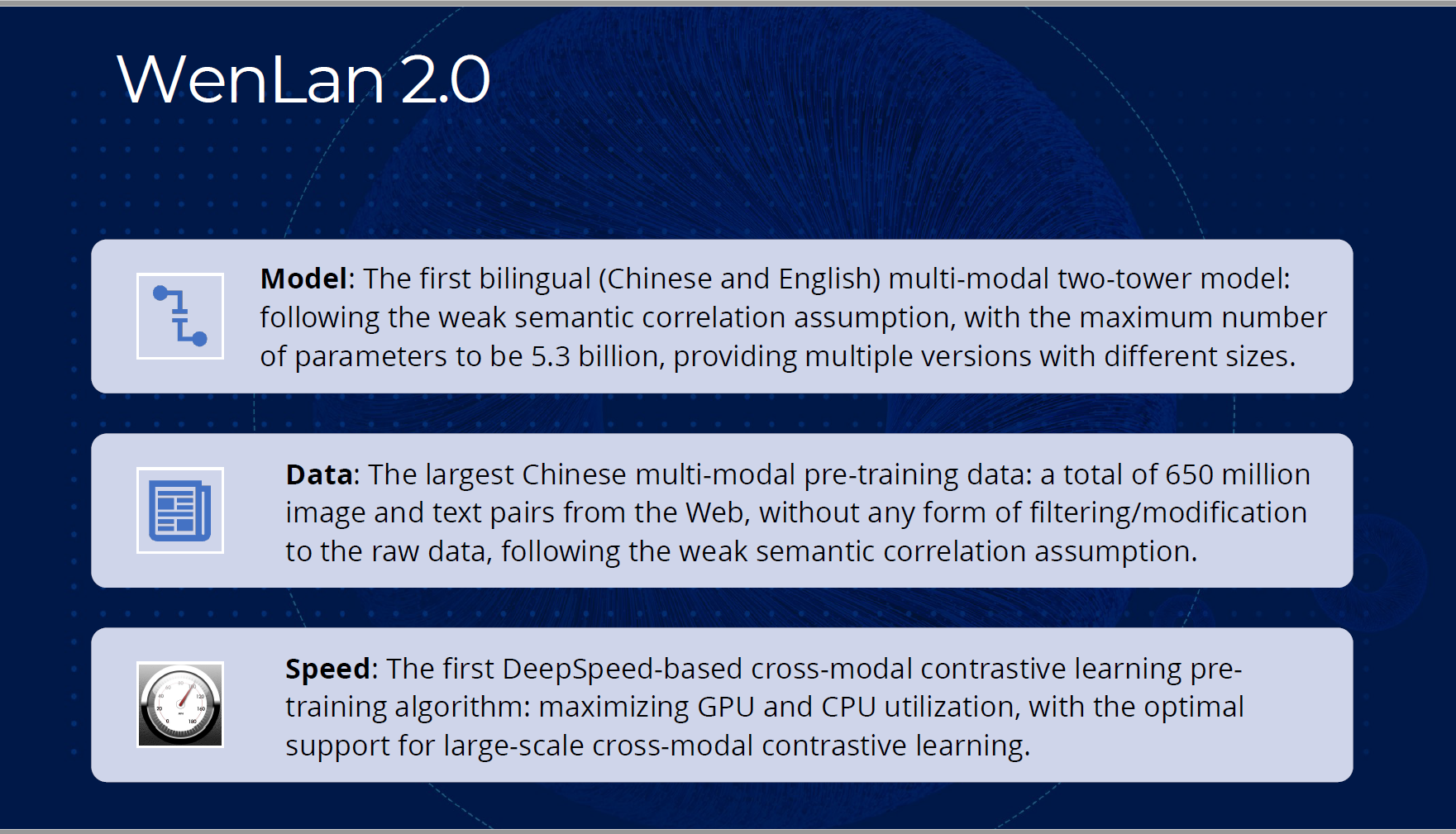

WenLan 2.0是第二代文澜模型。在 WenLan 1.0的基础上,WenLan 2.0做出了以下改进:

模型上,同样基于弱相关假设,WenLan 2.0加入了中文和英文的双语多模态架构,提供了多种不同大小的模型版本,最大参数量扩大至53亿;

数据上,WenLan 2.0采用了迄今为止最大中文多模态与训练数据:包含了从互联网上抓取的6.5亿个图像-文本对,这些数据没有经过任何的清洗和修改,并且是基于弱相关假设的;

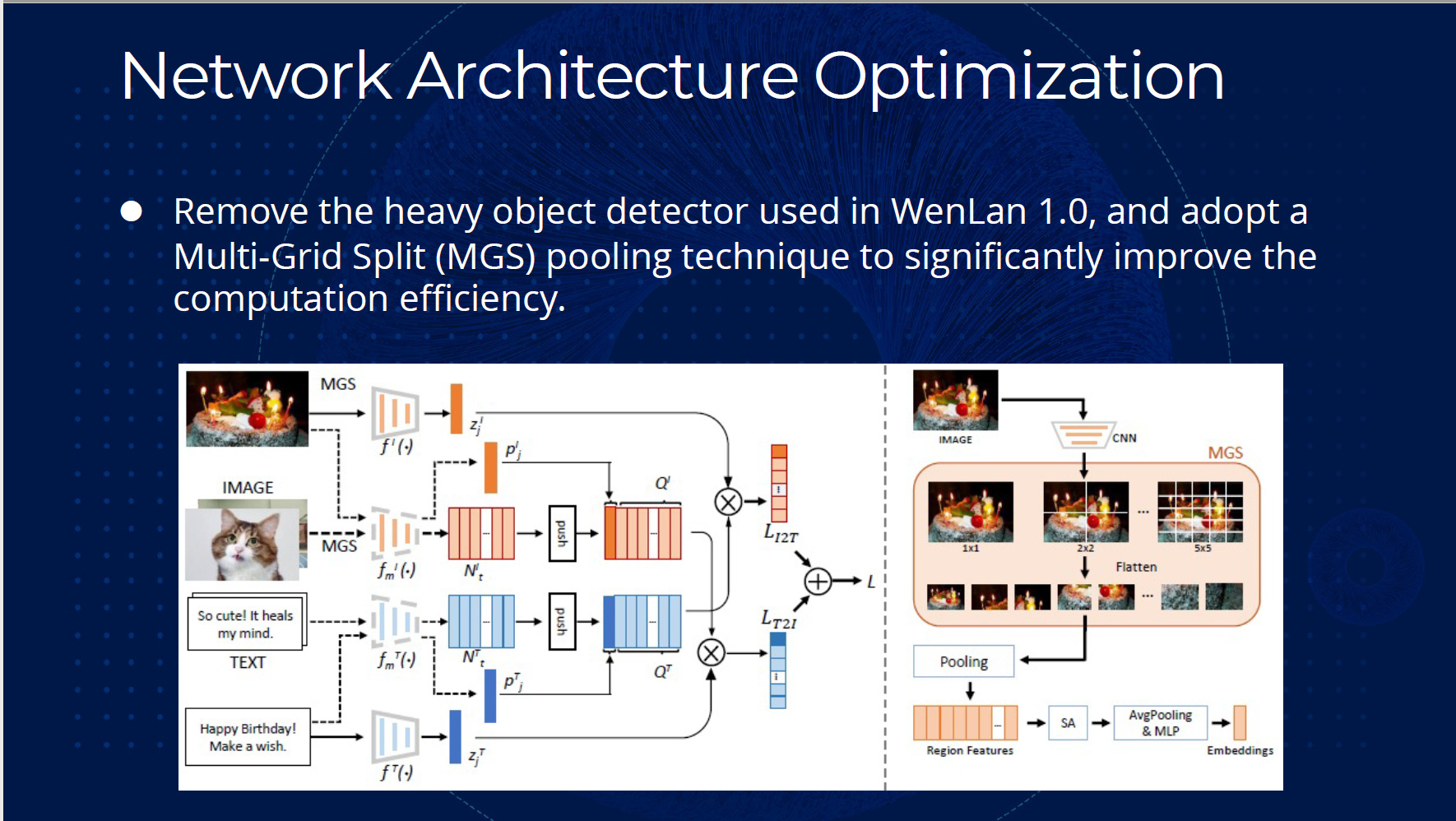

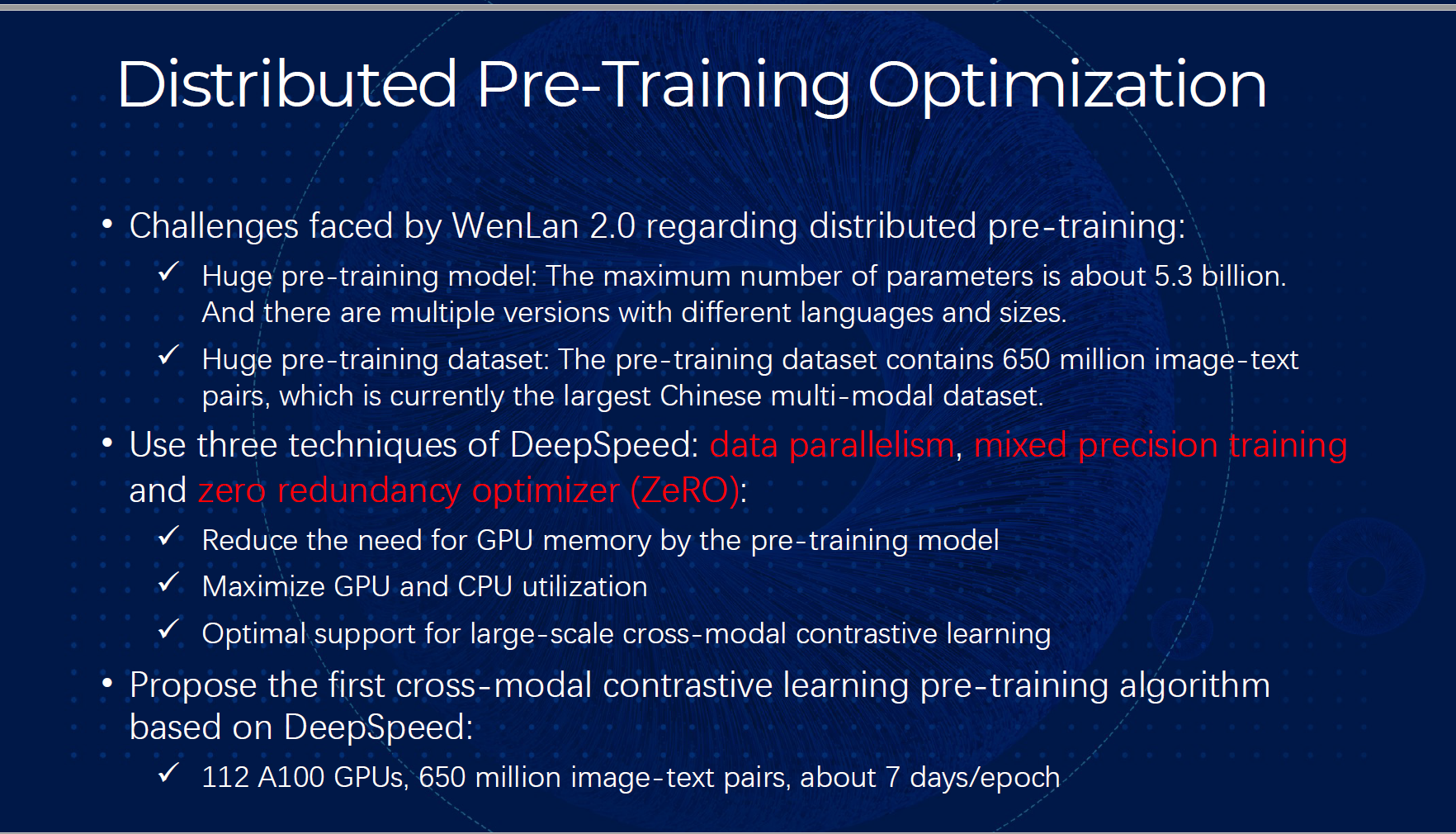

速度上,WenLan 2.0是第一个基于DeepSpeed的跨模态对比学习的训练算法。值得一提的是,WenLan 2.0移除了上个版本中笨重的目标识别器,采用了MGS池化技术来加速模型训练。同时,WenLan 2.0还采用了数据并行(data parallelism)、混合精度训练(mixed precision training)和零冗余优化(zero redundancy optimizer, ZeRO)等分布式训练技术。这使得训练过程最大化的利用了CPU和GPU,对大规模跨模态对比学习提供了很好的支持。

模型表现

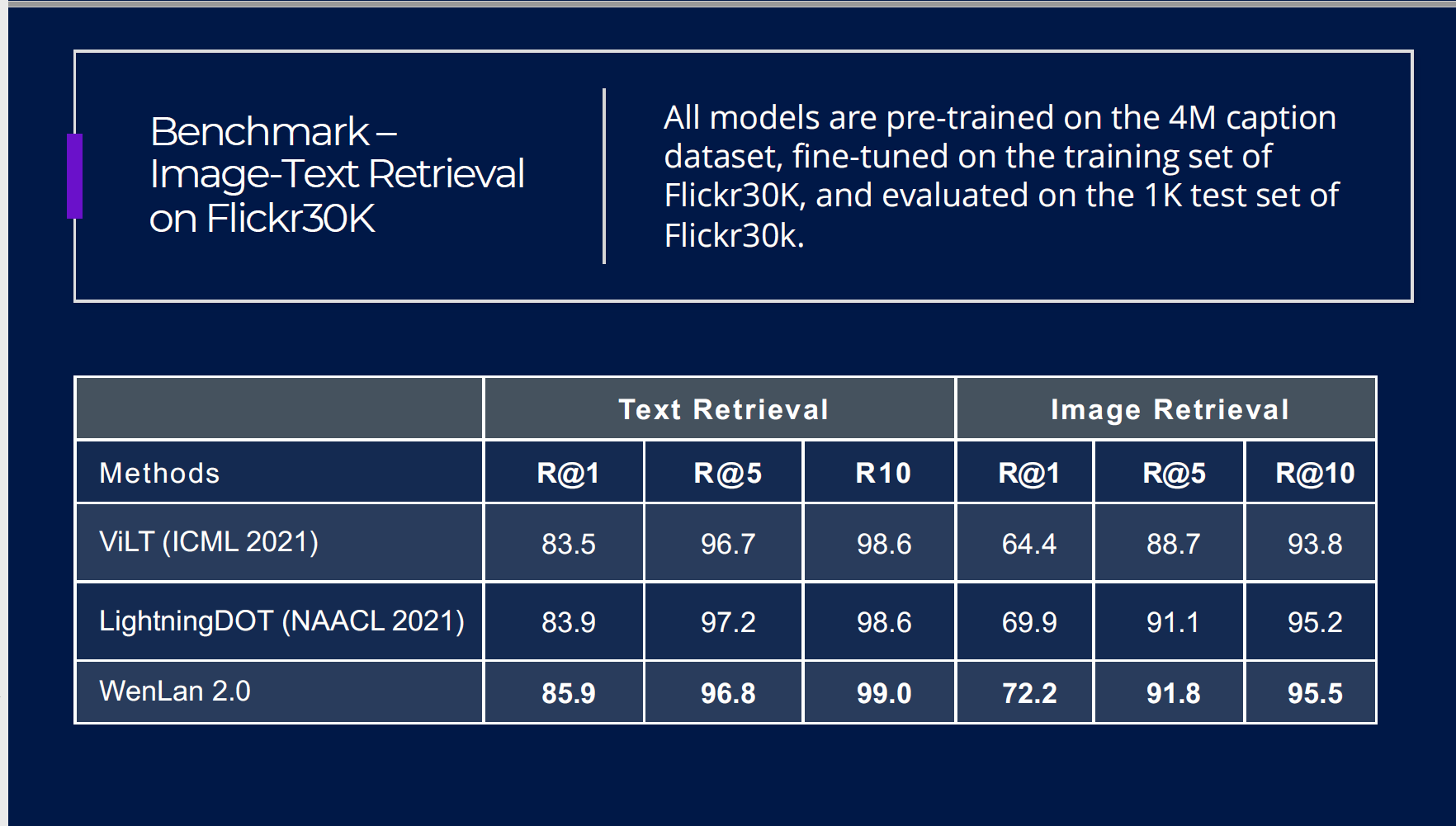

WenLan 2.0在多项多模态任务上取得了SOTA(State of the art)的表现。首先,在图像-文本检索任务上,无论是图检索文还是文检索图都超越了前人的工作。

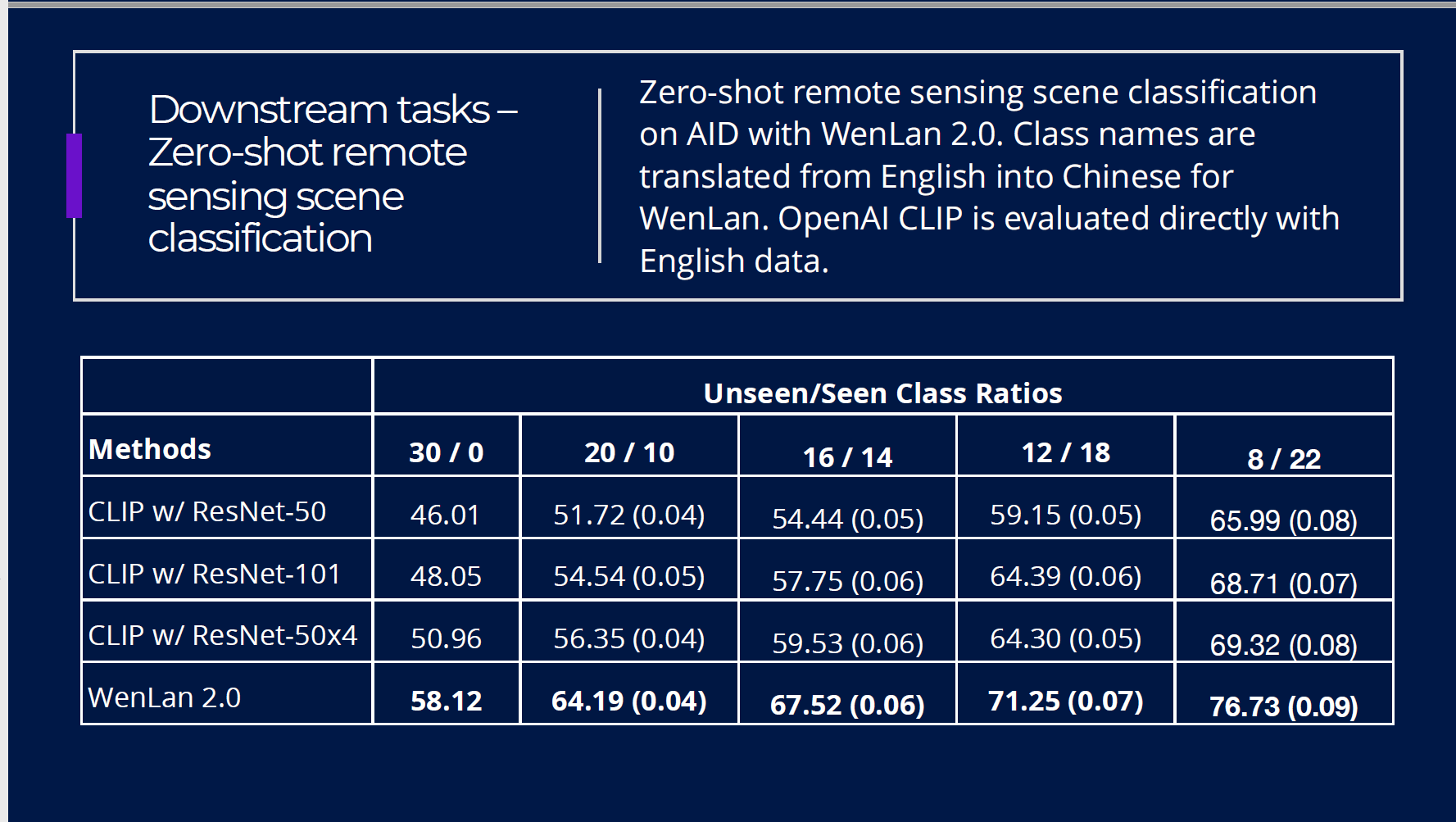

而在下游任务上,模型在Zero-shot遥感场景分类上也全面超越了前人的模型。

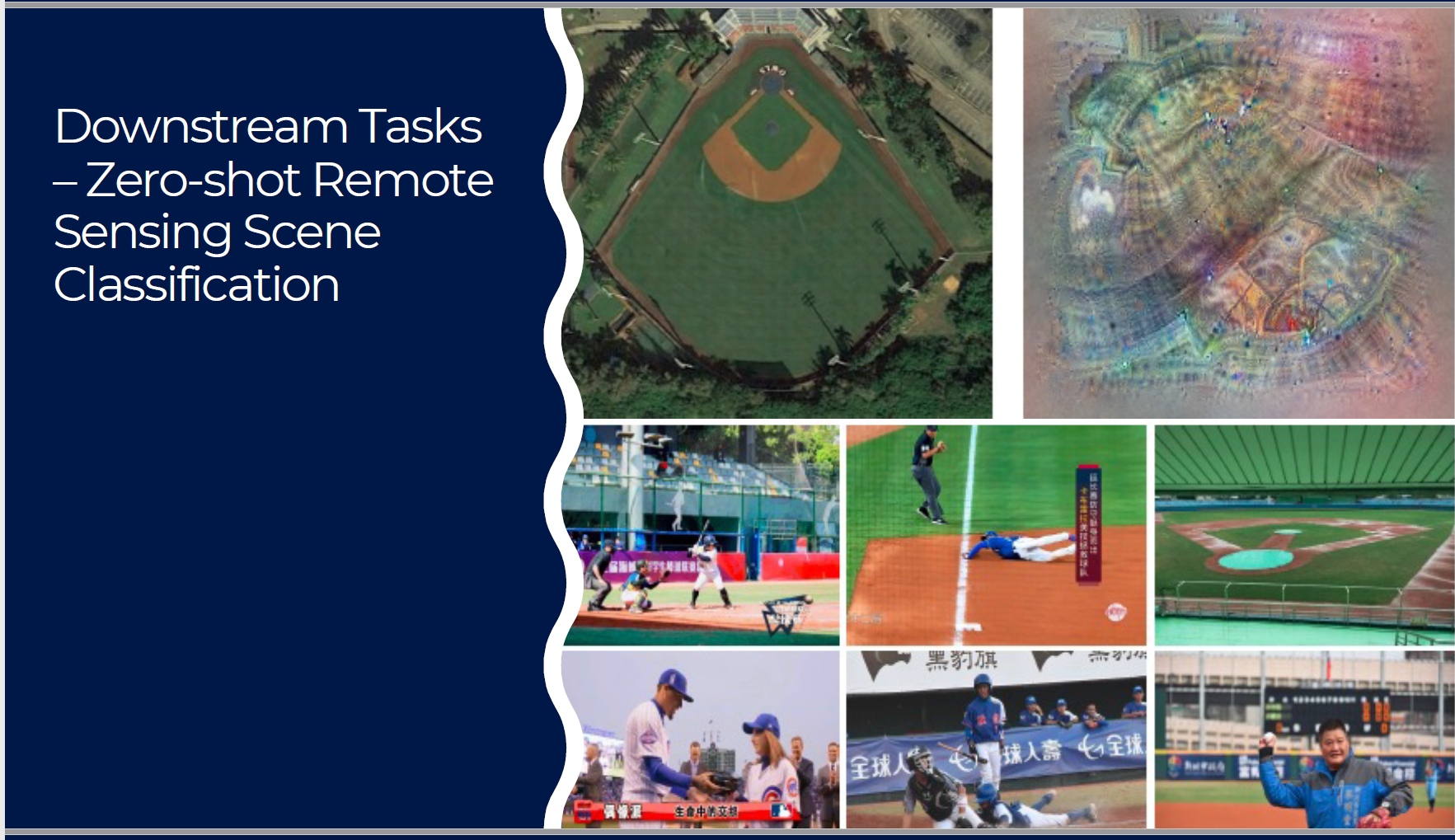

在这一任务中,尤其值得一提的是,WenLan2.0能够对训练数据中极少的遥感数据图像做出精准分类。例如,训练数据中常见的是图中右下角显示的平视的棒球场,但模型依然能够对俯视的棒球场做出很好的表示(如右上角的模型可视化结果)。

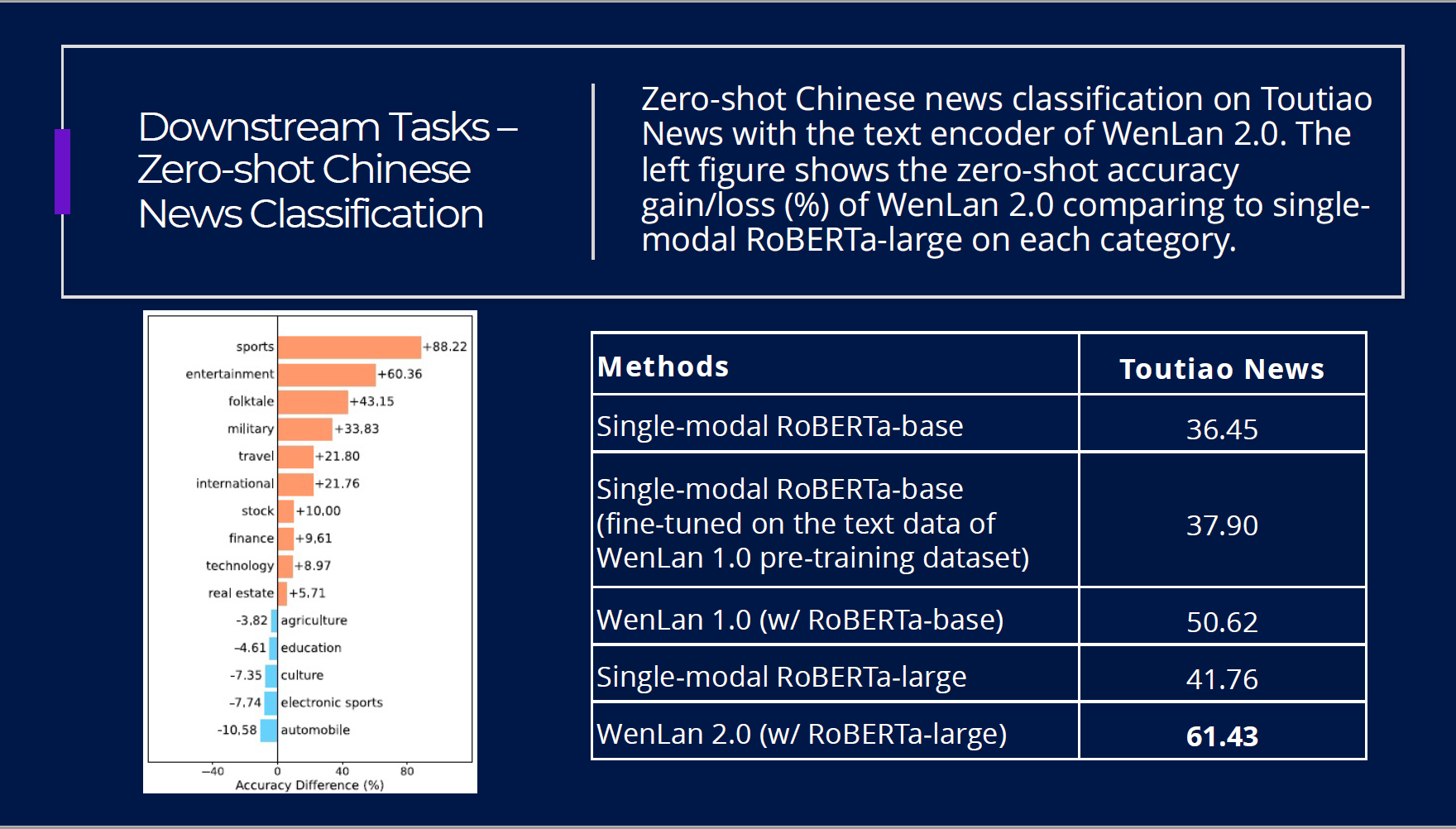

同时,模型在单模态任务上也取得了很好的效果,这一点超出了团队的预期。在Zero-shot中文新闻分类上,模型取得了SOTA的表现,超出了此前的单模态模型。

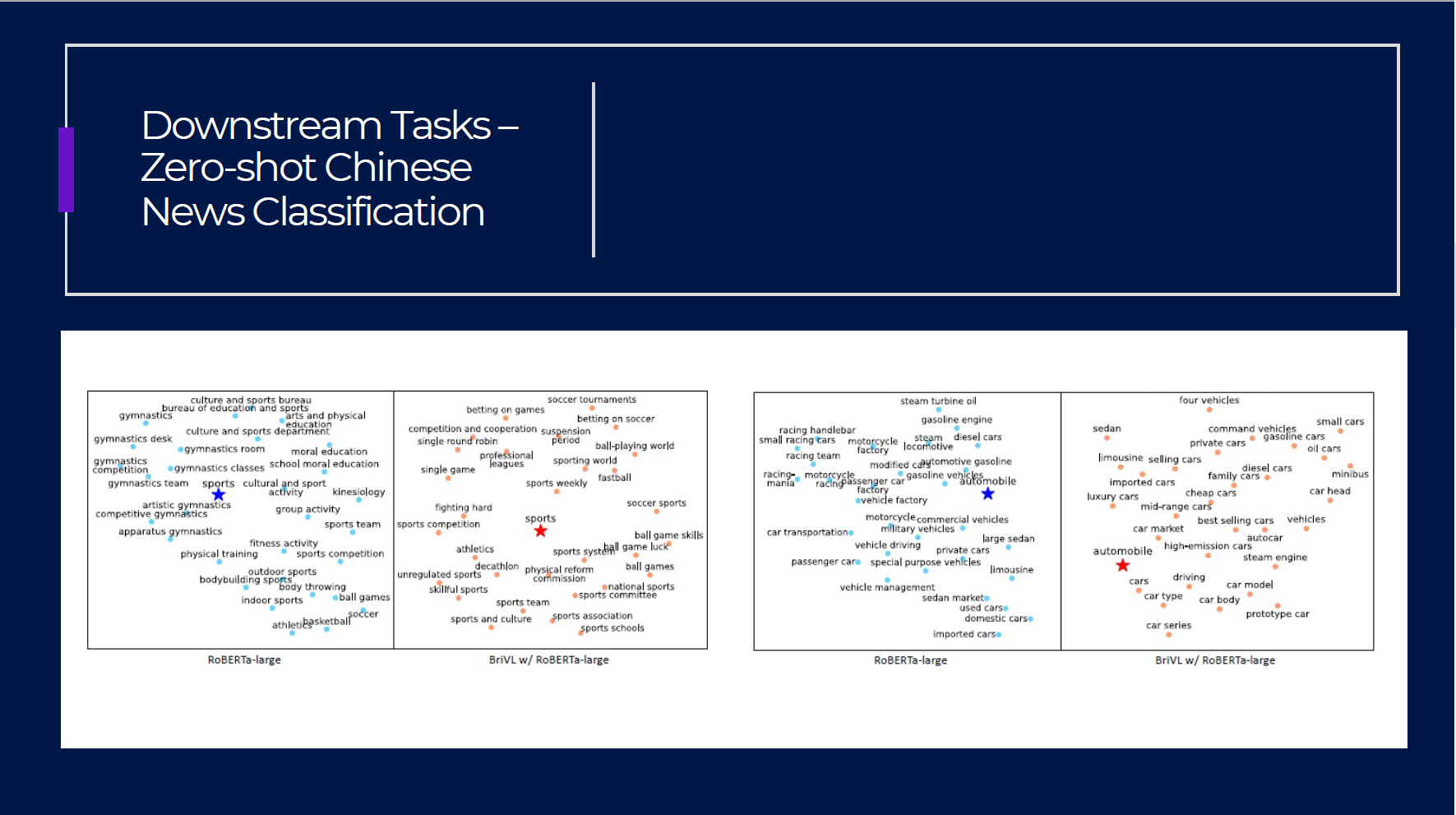

同时,WenLan 2.0在新闻分类上习得的词表示与此前的单模态模型(RoBERTa)有很大不同,这一点也充分反映了多模态模型的不同之处。例如,在下图的词的表示的可视化结果中可以看出,“Sport”一词在单模态和多模态的模型中的周围的词很不一样。尽管这一点不能完全解释WenLan 2.0优异的表现,但这依然使得人们对预训练模型的前景有了更多期待。

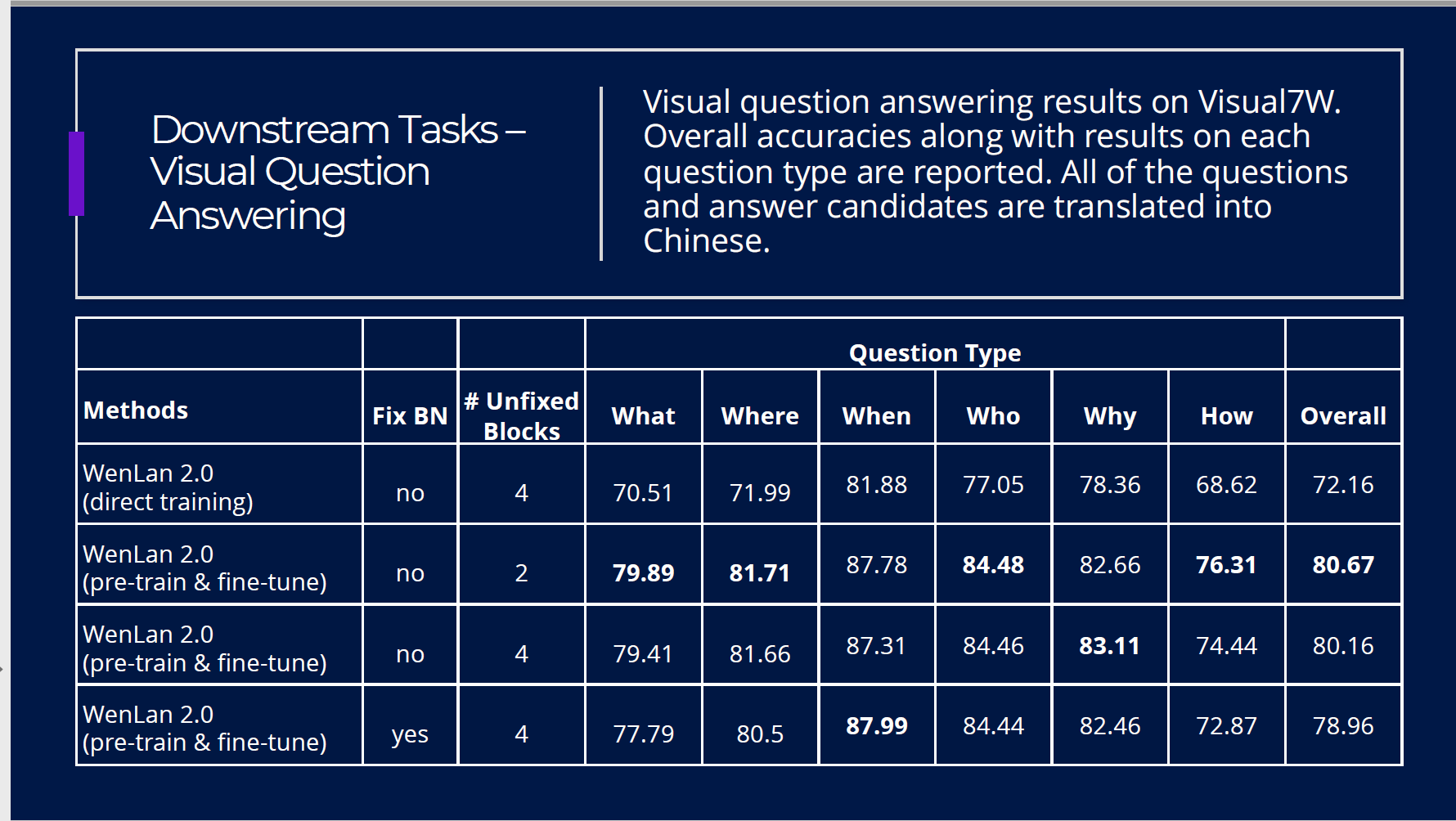

另外,模型在VQA(Visual Question Answering)任务上也取得了十分亮眼的表现。

表示、知识和常识

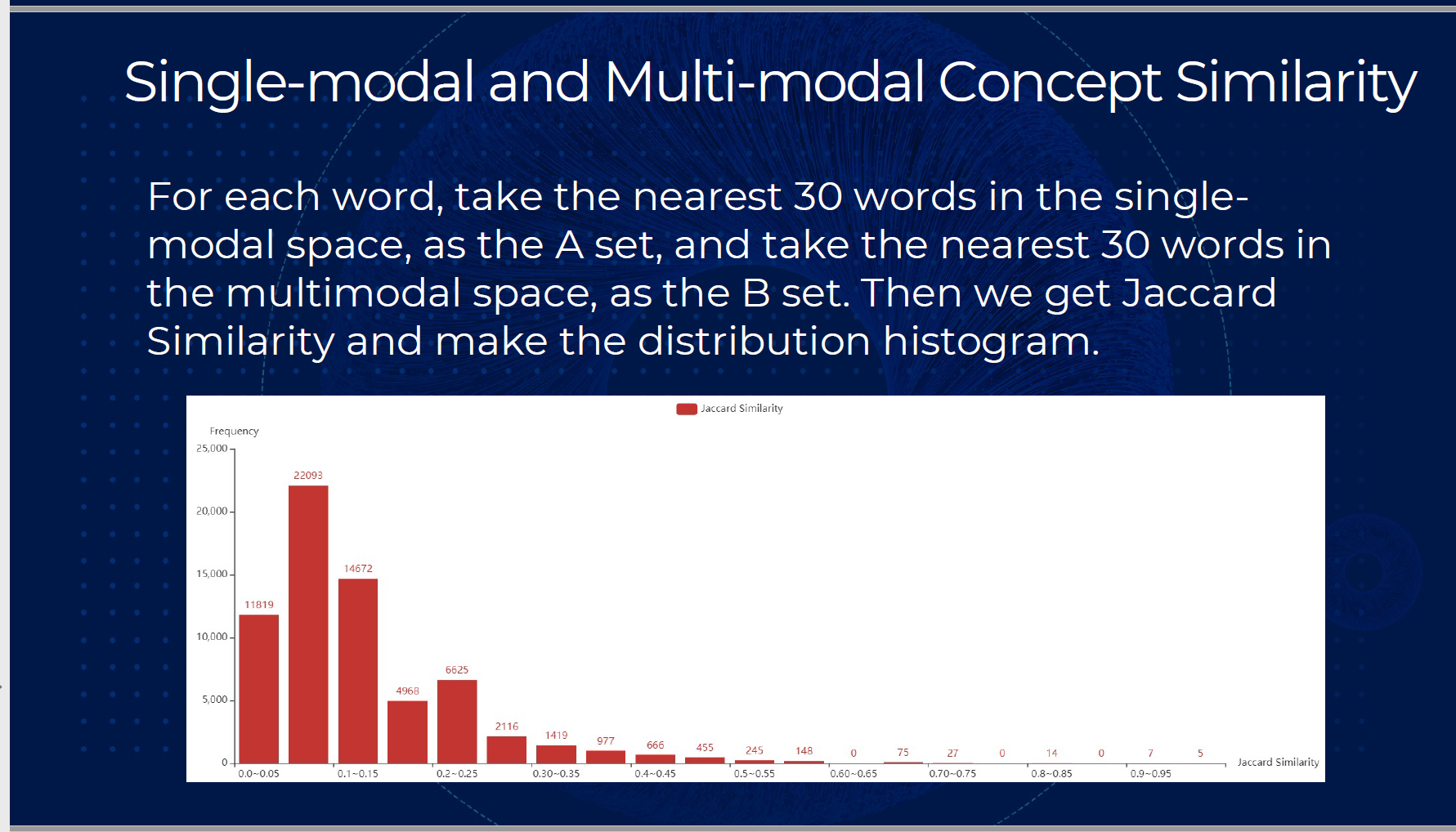

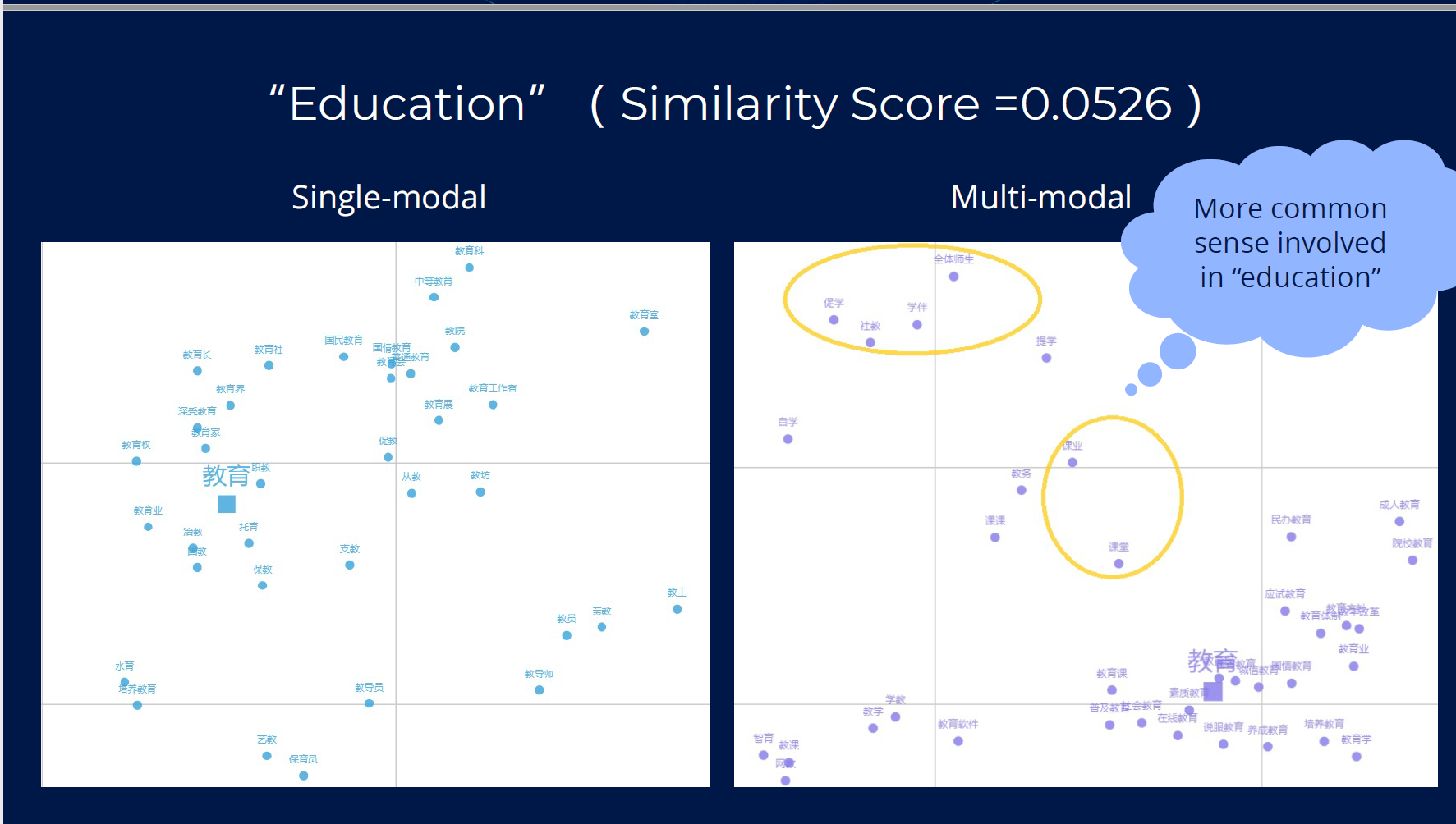

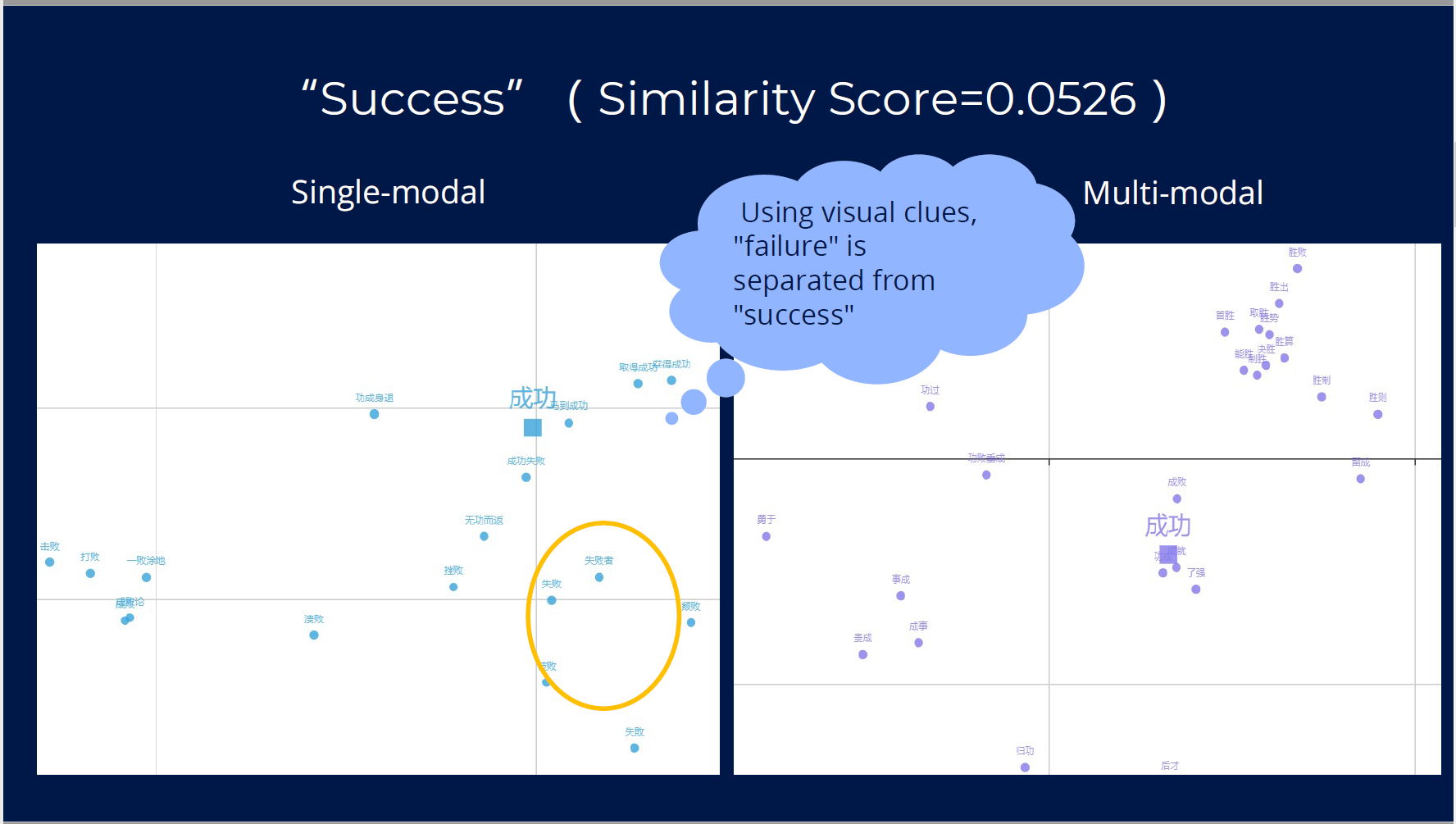

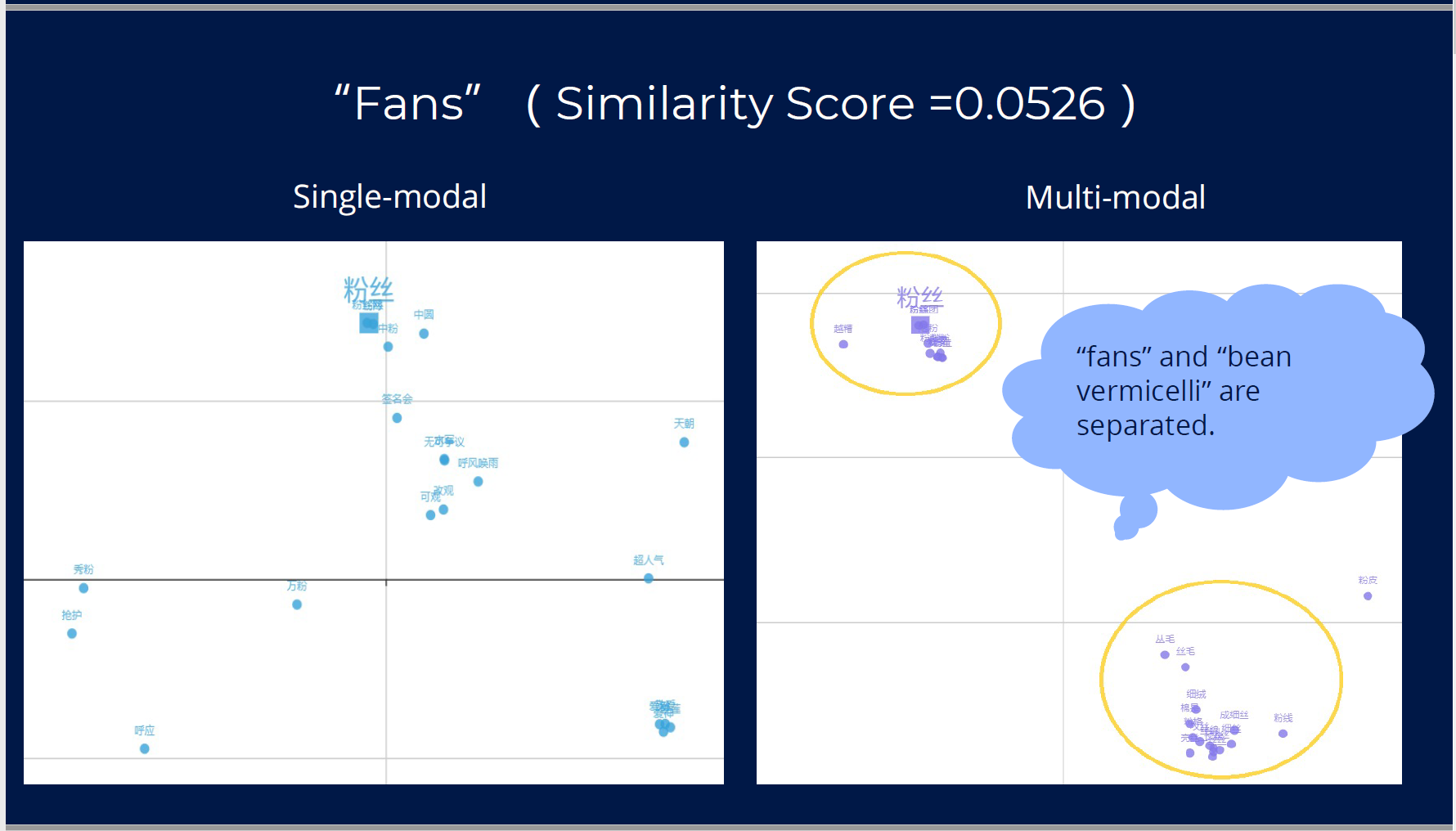

尽管多模态模型在许多任务取得了SOTA,但人们对它的理解依然很少。首先,在概念相似度上,单模态模型和多模态模型有很大的差异。如下图所示,分别对单模态和多模态模型中的每个词取最接近的30个词,两个模型会给出非常不同的结果。

而在对“教育”这个词的具体分析显示,多模态模型的表示似乎引入了更多的“常识”知识。同时多模态模型能够更好的区分“成功”和“失败”,同时对“粉丝”一词的不同语义也能得到更好的区分。

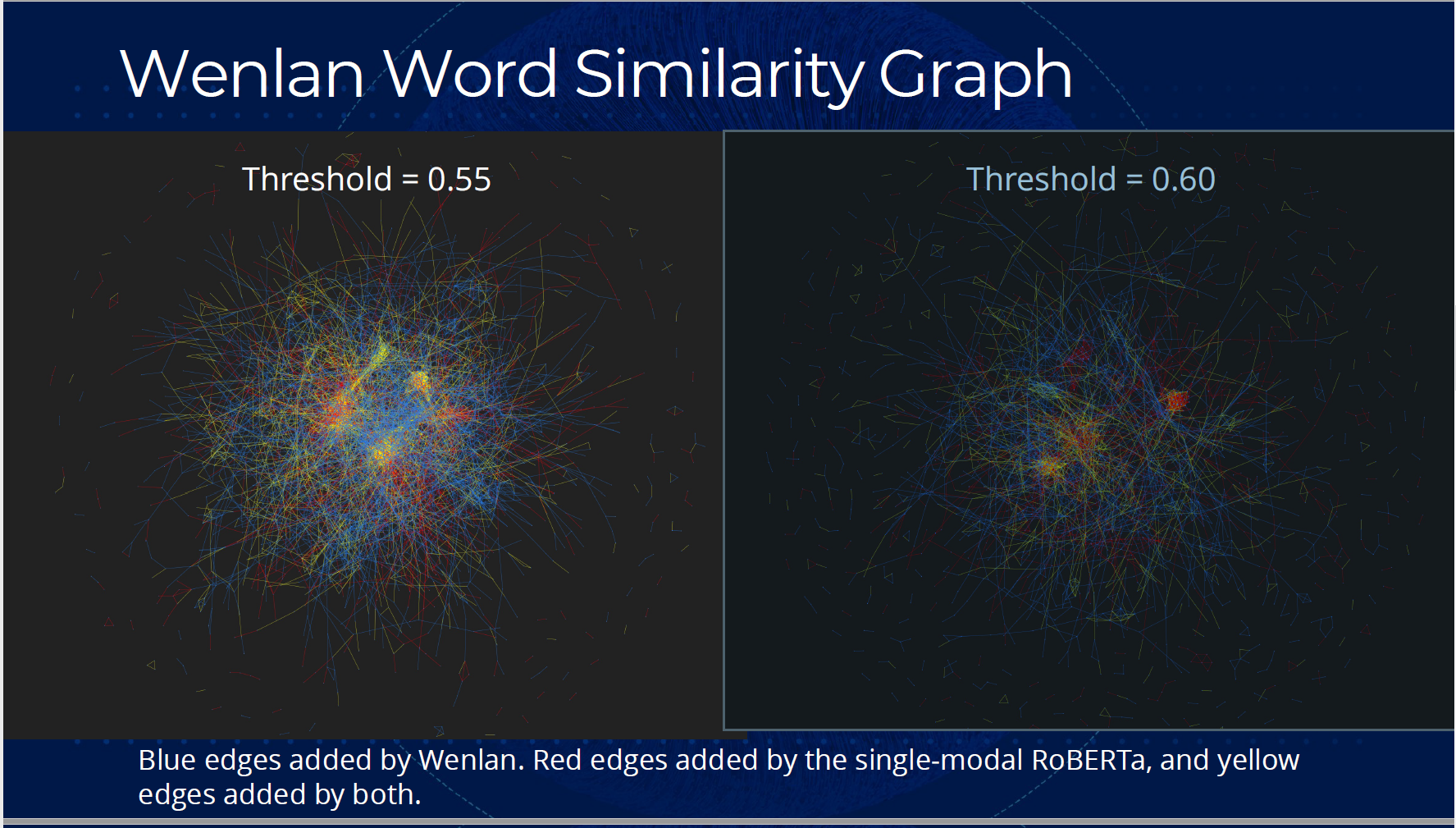

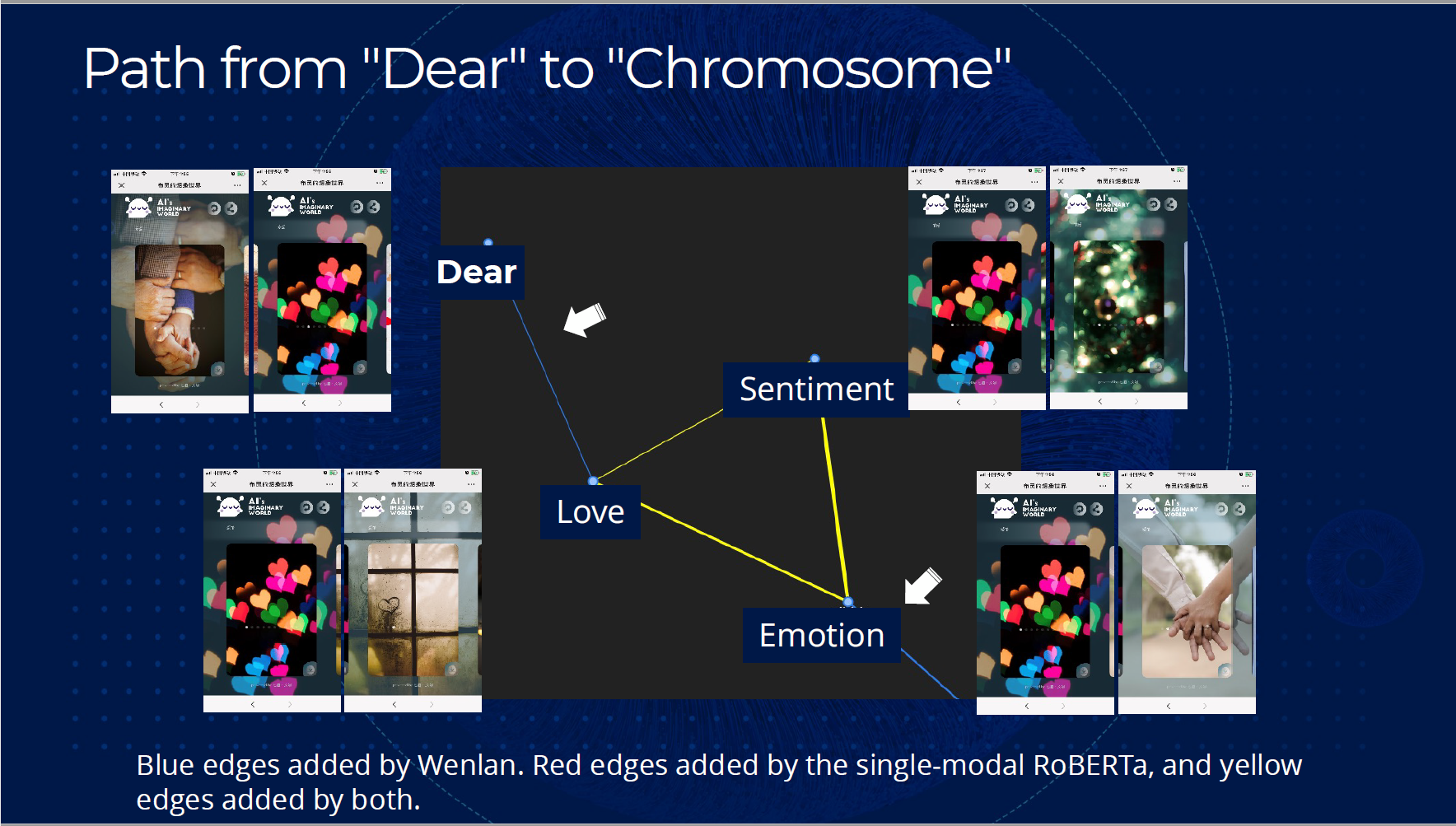

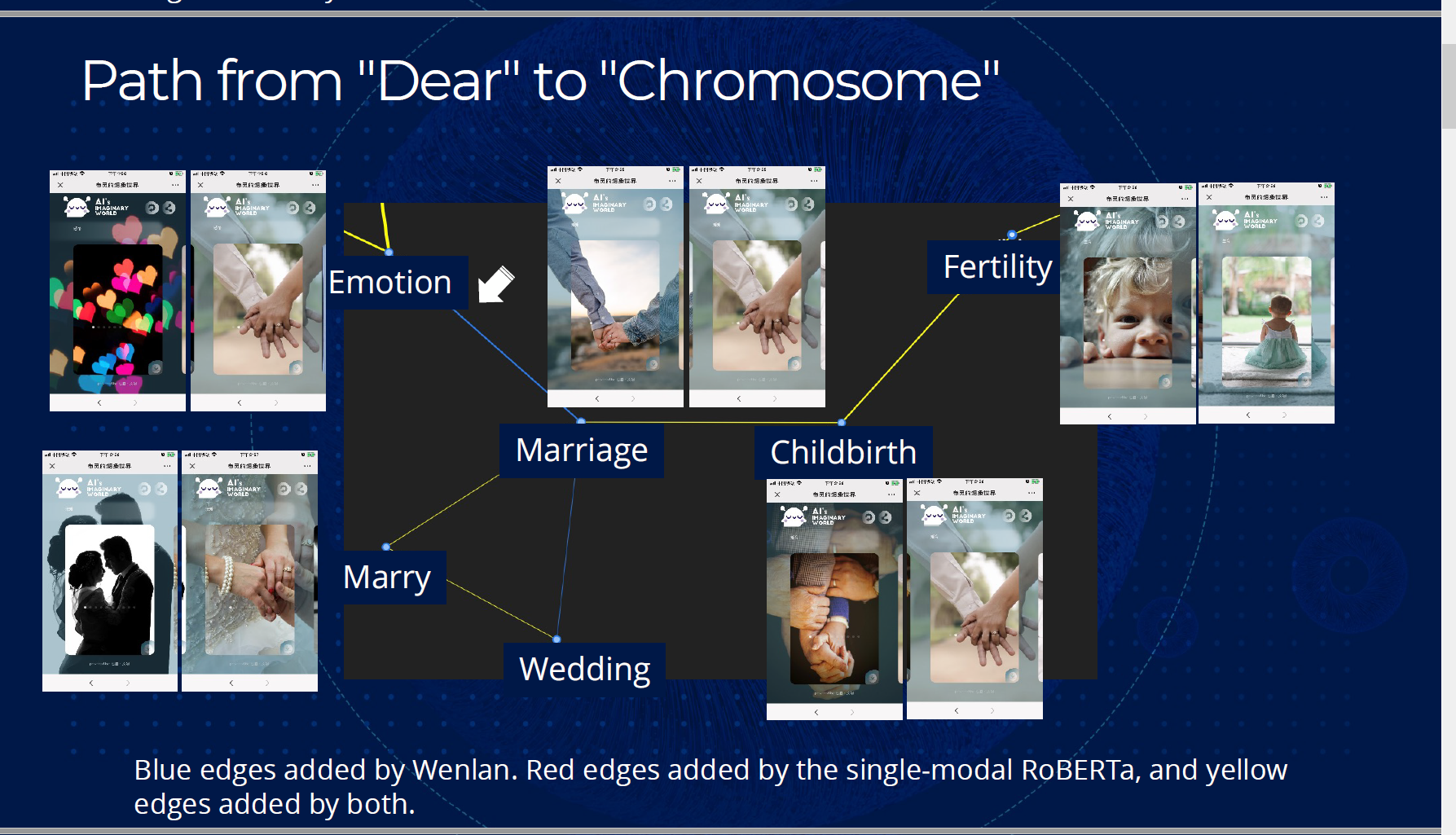

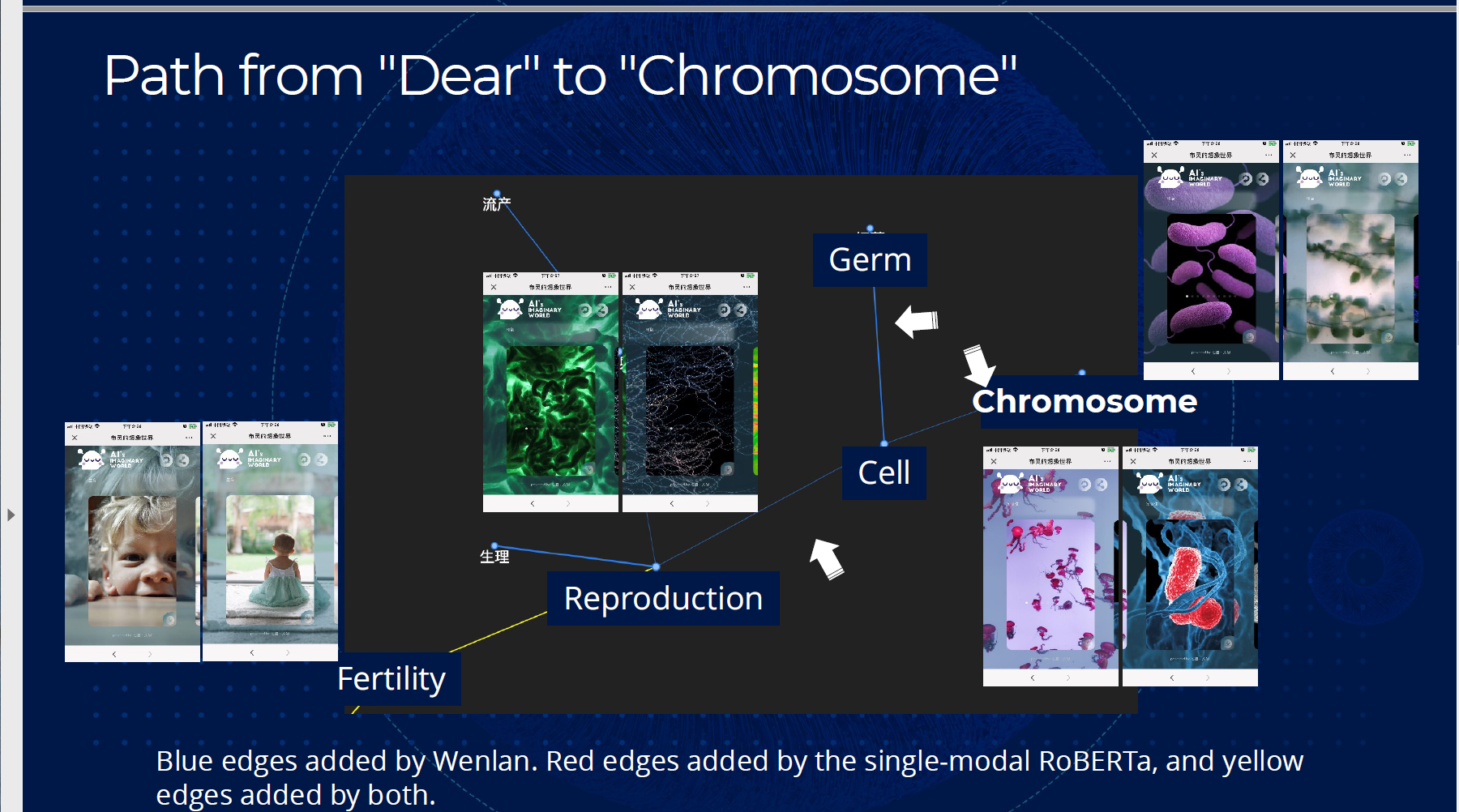

同时,文澜模型能够连接更多的词。如下图所示,图中的节点是词,如果两个词的相似度大于一定阈值,则添加一条边。蓝边由文澜模型添加,而红边由单模态的RoBERTa模型添加,黄边则是共同添加的边。文澜模型和单模态模型所添加的边有明显的不同。

一个具体的例子是“Dear”(亲爱的)和“Chromosome”(染色体)这两个看似不相关的词,在上图中能够通过文澜模型相连接。

多语言与多模态

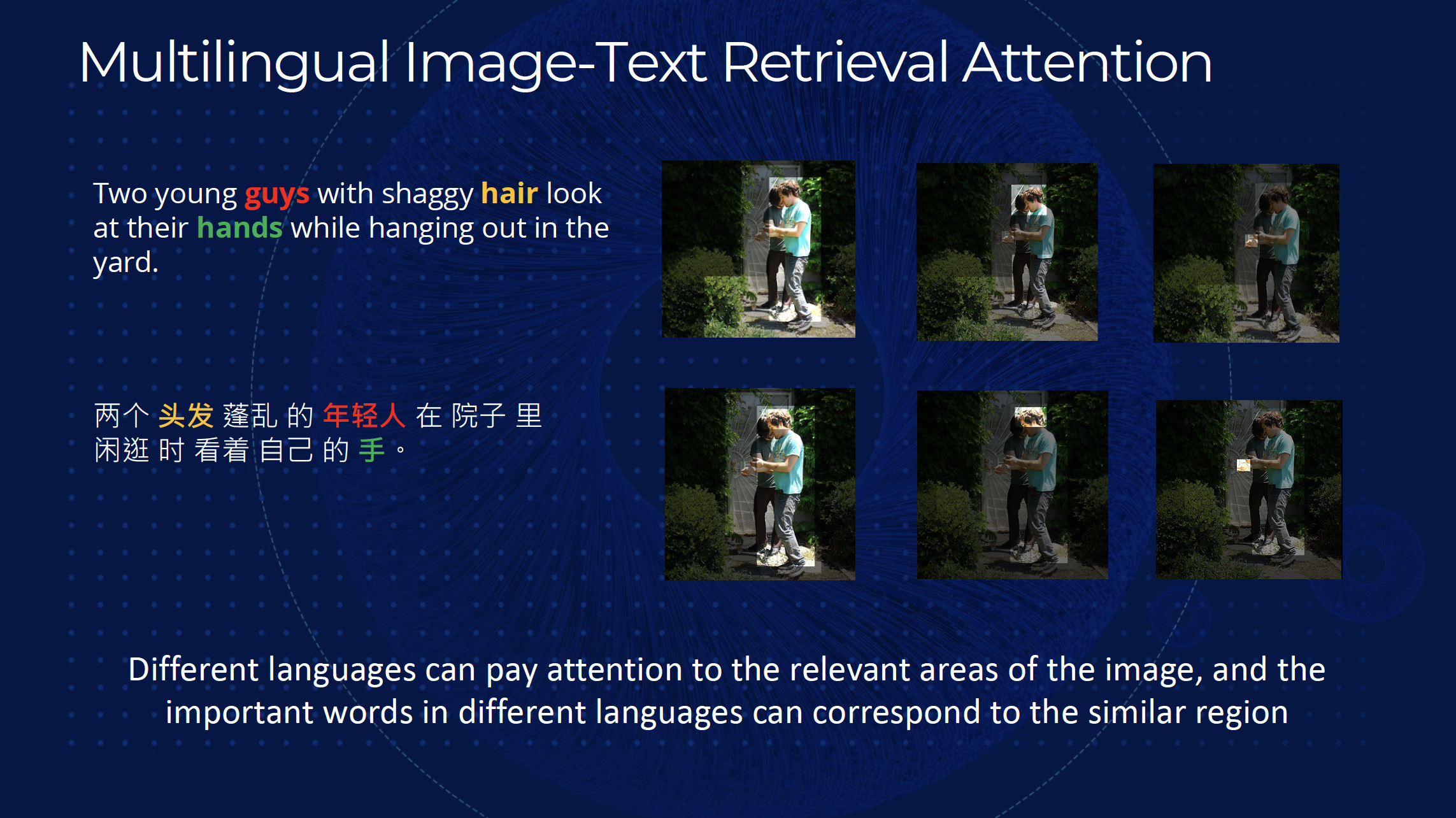

团队进一步探索多语言与多模态的预训练模型。对于图片与多语言对齐数据缺口的问题,团队通过机器翻译从单语图片对齐数据生成了多语数据,从而支撑大规模预训练的需求。跨语言和跨模态的表示学习给大模型带来的不仅仅是能处理更多不同类型输入的能力,更让大模型融合了不同语言、模态之间的独特优势,全方位提升了模型的能力,WenLan2.0模型在多模态和多语言的场景下也都达到了目前SOTA的水平。从模型可视化的图片语言表示来看,目前WenLan2.0模型已经具备多语言模态之间的相关部分对齐的能力,可以点对点连接不同类型的输入,这也给WenLan2.0的应用提供了无限的可能。

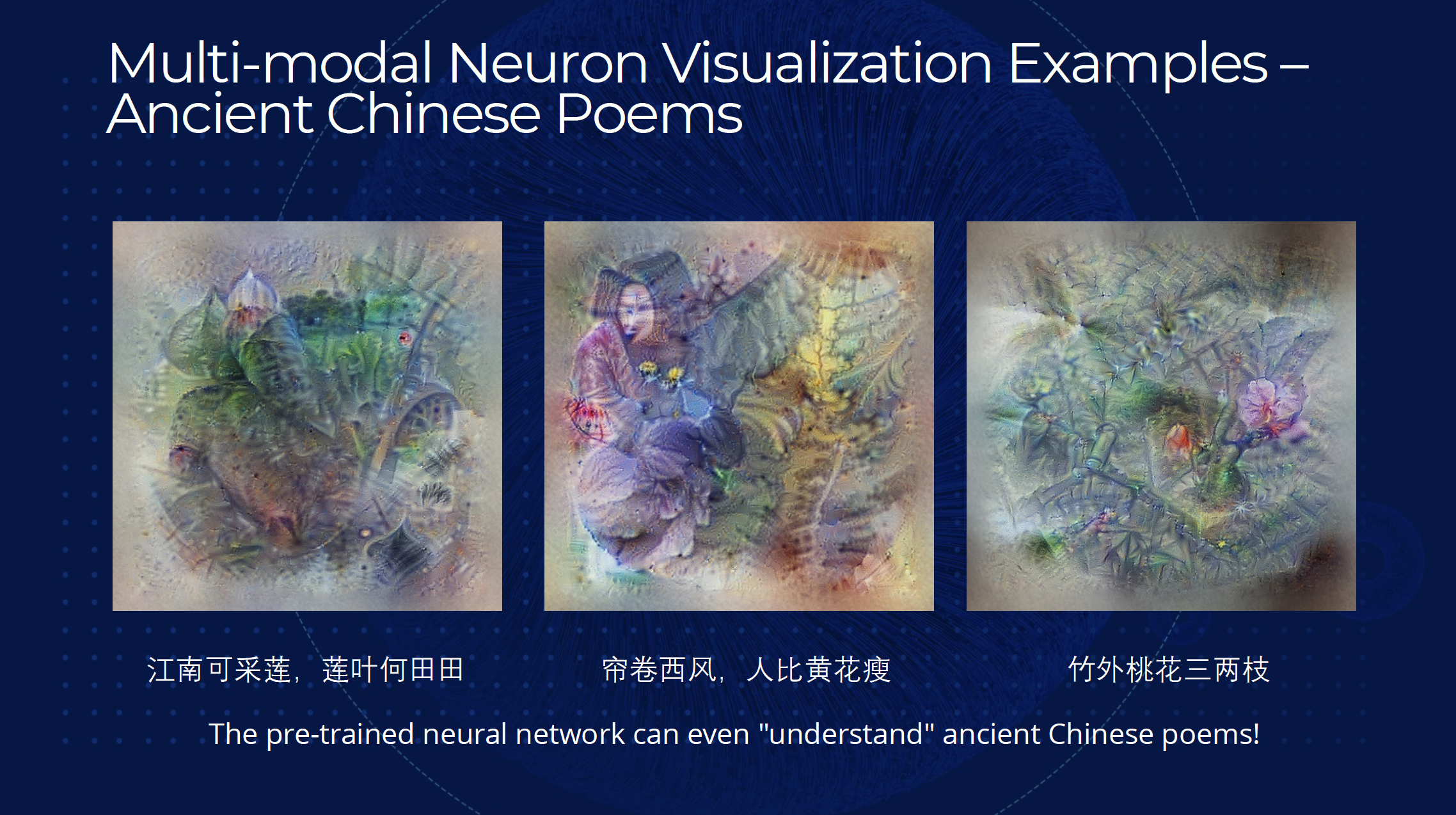

生成语言

多模态的预训练拓宽了大模型的应用场景,从自然语言和图片之间的联系入手,团队对大模型的生成能力进行了研究。模型对多模态数据的处理是由嵌入层开始的,获得图片和文字分别的表示,考虑二者表示之间的相关性,团队通过直接对噪声图片不断做微调,获得了与目标语言具有相同表示的图片输入,逆向进行了从语言到图片的生成过程。生成图片的结果也非常有趣,十分具有后现代艺术的特点,宛如人类梦境中的场景,对于古诗文的输入,模型也能相应生成很有意境的图片,从某种角度来说,目前的多语言多模态的大模型已经具有了相当的理解能力。

在图片生成的基础上,团队进一步尝试根据输入语言生成更为写实的图片。连接模型和经典的VQGAN对抗网络,在微调之后,模型就可以根据输入语言生成符合现实生活的图片,图片风格各异,但整体效果极佳,与输入文本非常贴切,甚至于现实世界中不存在的事物,模型也可以有效生成图片。在此基础上,团队又尝试了连环画的生成,也取得了很好的效果。当前模型在多模态上的优异表现也吸引了社会各界的关注,尤其是AI+艺术的领域,可以期待WenLan2.0模型在各个领域内的精彩表现,神经元可视化的应用也还有极大的探索空间。

应用和服务

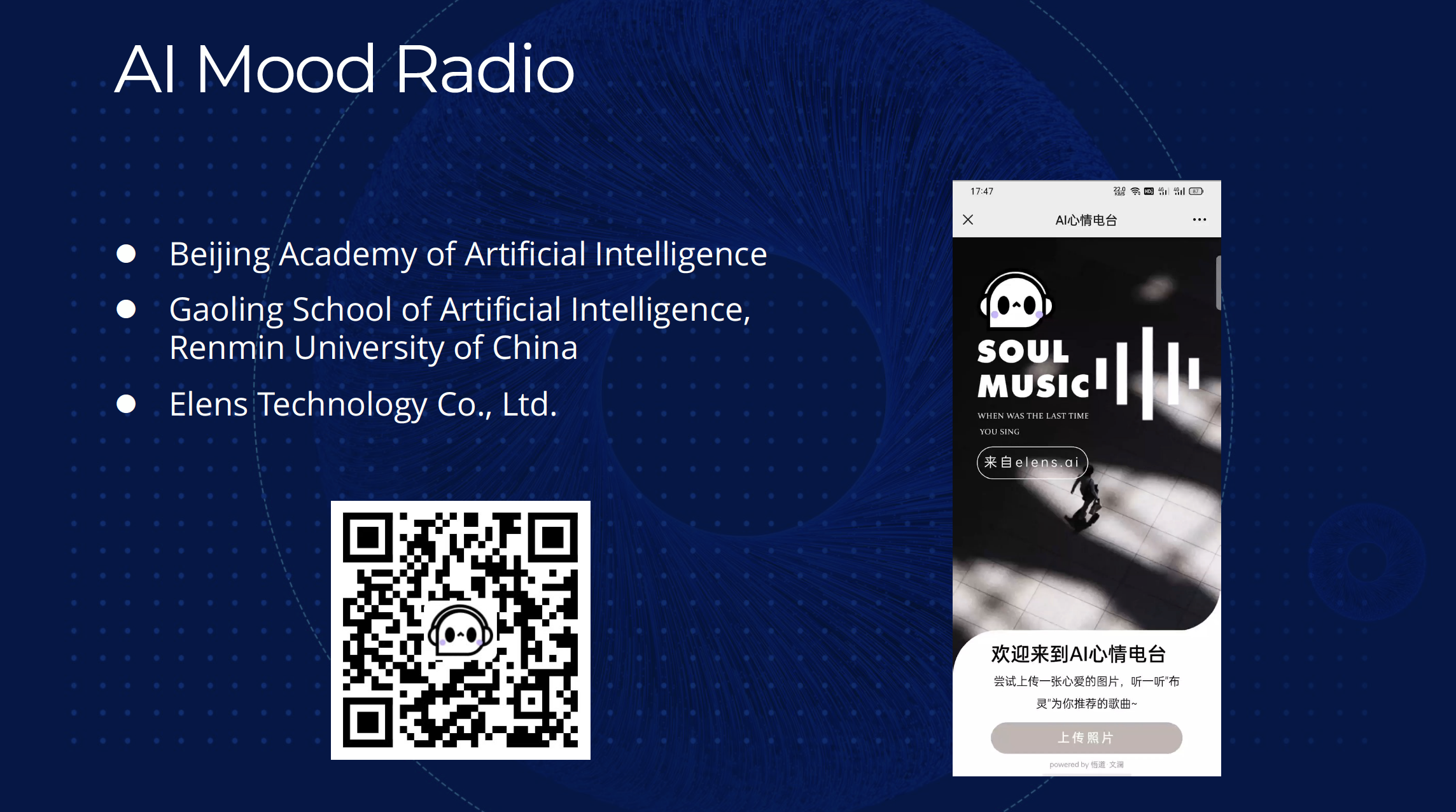

WenLan2.0模型的优秀表现也吸引了各界的关注,现实世界中的相关应用也逐渐落地,高瓴人工智能学院自主设计的产品Bling就提供了语言到图片生成的接口,供广大用户使用。另外,团队也与快手、腾讯等各大企业合作, AI心情电台可以根据用户上传的图片,智能进行歌曲推荐,深受用户喜爱。WenLan1.0的模型和接口也已经开源在Github上,受到了研究者的广泛欢迎,截至目前已经有上千万次的使用。

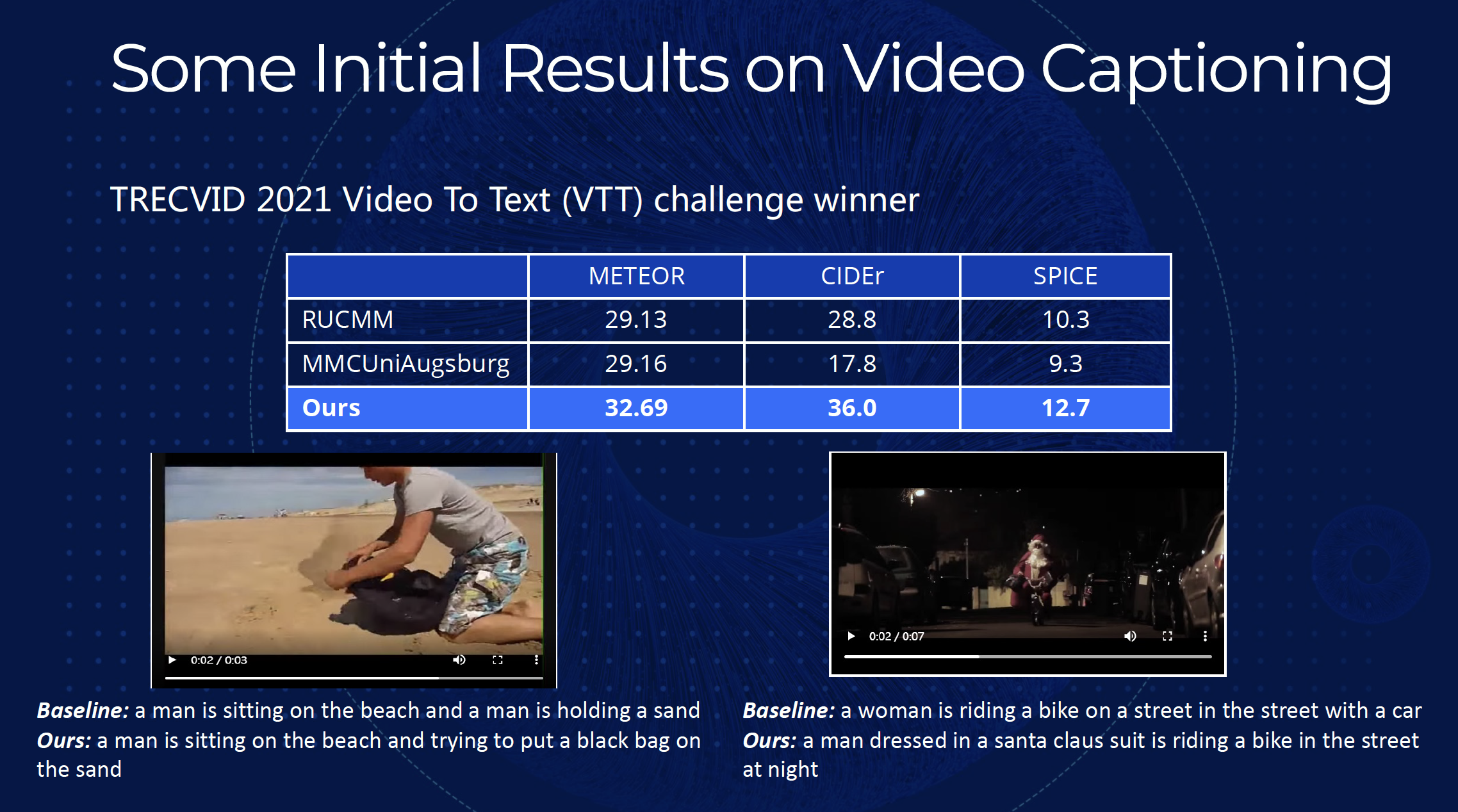

WenLan 3.0

上个月开始,团队就着手进行WenLan3.0模型的设计与实现。相比于之前的模型,WenLan3.0计划集成真正的多模态和多语言,可以同时对视频、音频等格式的输入进行处理,而多模态多语言的预训练反过来又可以增强模型自然语言理解的能力。此外,鉴于WenLan2.0在各个领域广泛的应用场景,WenLan3.0计划继续拓展更多的领域,集成更多的产品。目前来讲,到完善的理解世界的模型还有很远的距离,但WenLan系列模型无疑印证了多模态大模型的可行性,而目前各个国家、研究机构也都在进行相关的研究,包括美国的OpenAI、英国的DeepMind等组织也都在构建超大规模的模型,可以预见,在不久的将来,模型、算力、研究者的比拼可能形成一种信息时代的“军备竞赛”。

对于大模型的思考

最后,对于大模型的未来发展,文教授也提出了他的几个思考。首先是对于智能大脑的构建,类似《钢铁侠》电影中的Jarvis,构建能够匹配人类智能的全面模型一直是人工智能研究的最终目标,也就是WebBrain,将整个网络编码学习到一个模型中。传统的多个模型各司其职的集成方法已经过时,在数据与算力的支撑下,多语言多模态多任务的训练成为可能,也给WebBrain的设计带来了无限的可能,WebBrain的出现,也将是对目前搜索系统的彻底颠覆。目前已经有相关工作在进行尝试,但是都在起步阶段,设计的模型和算法也都相对谨慎,整体来看还有巨大的研究空间。

另外,对大模型的内部理解也还十分基础,包括模型对不同模态的不同理解,不同模态在模型中的相互作用,为什么多模态能够反向提升单模态的效果等,都是很有意思的研究方向。最近有工作发现,大模型对多模态数据的理解,和人脑对不同模态数据的理解十分相似,这也给多模态模型内部探索提供了更广泛的研究方向。最后,从应用层面来看,特定领域的大模型也是发展的主要方向之一,今年复杂系统的研究获得诺贝尔物理学奖就是很好的例子,大规模模型让复杂系统的理解和建模成为可能,这些都是此前研究所无法触及的领域。人民大学也计划发展人工智能对社会科学的复杂系统进行建模,目前人工智能经济实验室就正在筹备中。

总结来说,多模态超大规模的预训练模型无论是在研究还是在应用领域都有着巨大的前景,WenLan2.0的成功也印证了这一点。随着数据和算力的增加,更完善的模型的研究也在稳步推进,更大规模的模型、更多模态的数据赋予了模型各个方面无限的潜能。多模态预训练模型相关的研究还有很大的发展空间,我们也希望各界研究者考虑这方面的研究,团队也非常欢迎与大家的交流与合作。

精彩视频回顾及完整版PPT下载,请点击:

AIR学术沙龙第13期 | 超大规模多模态预训练带来了什么