深度神经网络本身的层次结构其实就是在做迭代的优化,做数据压缩,逐层逐步优化数据特征的表达。

——马毅

活动概况

5月27日上午,第四期AIR学术沙龙跨越太平洋,在清华大学智能产业研究院(AIR)图灵报告厅展开了一场精彩的隔空对话。本期活动荣幸地邀请到加利福尼亚大学伯克利分校电子工程与计算机科学系马毅教授线上做题为《基于第一原理的深度(卷积)神经网络》的报告,这是他首次用中文深度解析这一课题。

主持人马维英介绍马毅教授

本次演讲以完全"白盒"的方式,从数据压缩(以及群不变性)的角度来构造和阐释深度(卷积)神经网络。具体说明了现代深度层次架构、线性(包括卷积)算子和非线性激活,甚至所有参数,都能用数据压缩中“编码率减小”(Rate Reduction)的原理解释(以及群不变性)。网络所有层次结构、算子(包括卷积)、以及算子的参数值都能利用前向传播算法显式构造得出,无需反向传播算法进行学习。由此获得的ReduNet网络具备严格精确的基于几何、统计以及优化的意义。

现场观众向马毅教授提问

本次讲座由清华大学智能产业研究院(AIR)惠妍讲席教授、首席科学家马维英博士主持,现场观众认真听取报告并与马毅教授通过热烈的研讨与碰撞,贡献了一次影响深远的思想盛宴。同时,讲座也在清华大学智能产业研究院(AIR)微信视频号、哔哩哔哩双平台同步直播。本次活动汇聚了来自斯坦福大学、北京航空航天大学、卡内基梅隆大学、清华大学、北京大学、中科院,以及英特尔、58同城、Oppo等学校及企业单位的专家学者、算法工程师等的参与,全网累计观看人数共计逾8600人次,直播获赞过万次。

讲者介绍

马毅,加利福尼亚大学伯克利分校电子工程与计算机科学系教授,1995年从清华大学本科毕业,2000年从加利福尼亚大学伯克利分校取得硕士及博士学位。研究方向为计算机视觉、高维数据分析、智能系统。2000年至2011年,任伊利诺伊大学厄巴纳-香槟分校教授,2009年至2014年任微软亚洲研究院视觉计算团队主任和首席研究员,2014年至2017年任上海科技大学信息科学与技术学院院长。马教授发表超160篇学术论文,撰写过计算机视觉、统计学习、数据科学相关的三本教科书。曾获2004年美国自然科学基金委员会杰出青年奖、2005年美国海军研究署青年研究员奖、1999年计算机视觉马尔奖(Marr Prize),曾任国际计算机视觉大会2013年项目主席和2015大会主席。马教授还是电气与电子工程师协会、工业与应用数学学会,和美国计算机学会会士。

报告内容

过去十年,深度学习(Deep Learning,DL)风靡全球,对学术界、工业界产生了深远的影响。2012年,在ImageNet图像识别大赛中深度学习模型AlexNet一举夺冠,AlexNet采用ReLU激活函数,从根本上解决了梯度消失问题。2016年,谷歌公司基于深度学习开发的AlphaGo以4:1的比分战胜了国际围棋高手李世石,深度学习的热度一时无两。此后,AlphaGo更是接连战胜多位世界级围棋高手。这也证明了在围棋界,基于深度学习技术的机器人已经超越了人类。此后,学术界、工业界不断提出新型网络结构,例如,引入残差机制的ResNet,DenseNet等网络结构。

但是,随着网络结构的变化,从学术界理论的角度出发,如何判断网络结构的好坏,深度网络学习的本质又是什么,在迭代训练的过程中又具体是在做什么,可否通过数学理论推导得出完整的过程,从而理解网络内部的机理,对网络的性能提供严格的理论保障?则是当下迫切需要思考的问题。

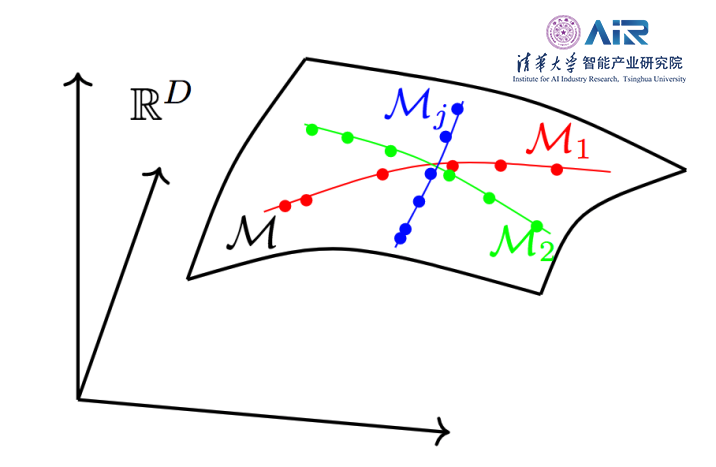

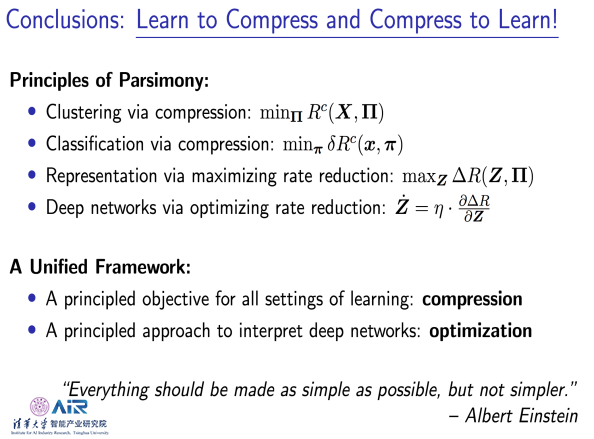

数据科学,模式识别,归根到底就是学习数据结构,进行最基本的聚类任务和分类任务。这样的任务可以对数据进行更加简略的表述。完成聚类任务和分类任务之后,以特征feature的整体编码量与各部分编码量差值作为特征表示好坏的度量依据:差值较大者,则效果更好。从此角度出发,深度网络可以看成是一个用于优化该度量的工具。很多高维的图像、声音等各类数据,不同的高维空间数据在不同的低维流形分布中。不同的类具有不同的低维流形分布。数学上目前对数据所做的绝大部分任务只是以下三者之一:

1. Interpolation(内插):利用数据之间相似性,对数据进行聚类;

2. Extrapolation(外插):利用数据的结构,对新样本进行归类和分类;

3. Representation(表示):依据数据内在结构,对数据进行最简略的建模得到最有用的表示。

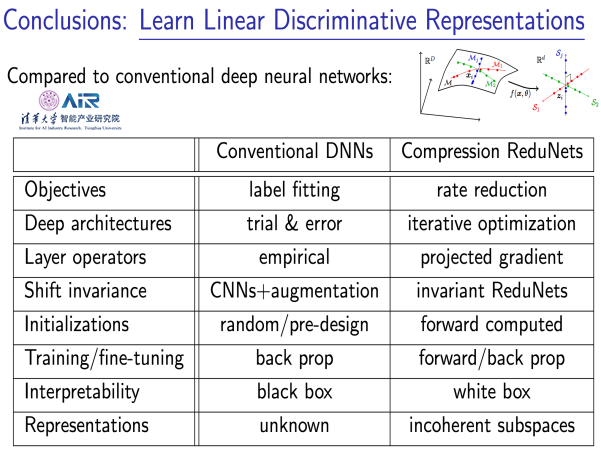

而过去十年深度学习,从一定程度上忽略数据内在结构,直接通过经验设计的深度神经网络在数据与输出(class labels)之间学习一个映射,深度神经网络可以预测新样本的label。这在实践中比较方便,也取得了很好的效果。但是从理论的角度出发,这样学到的深度神经网络属于“黑盒”模型,并不能严格保证可靠性和鲁棒性等,很难从中了解到深度模型内部到底在干什么,究竟学习到了数据什么结构。另外,已有的利用信息理论进行的解释,往往基于传统信息论的统计量,例如信息瓶颈理论。但对于有低维退化分布的高维数据,这些量往往无法计算甚至没有定义。

这项工作从更基本更本质的角度出发,思考为什么要对数据进行聚类和分类?我们如何度量正确聚类分类之后得到了什么?

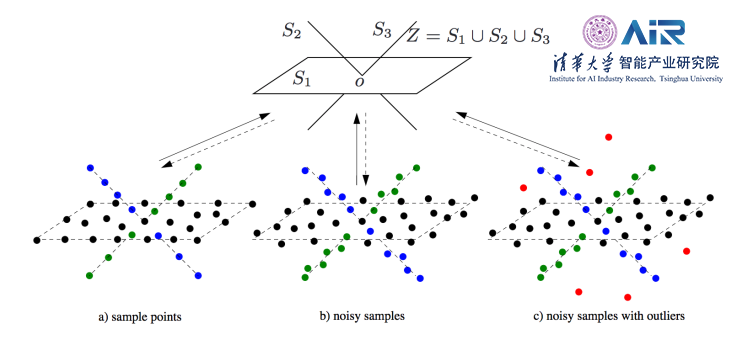

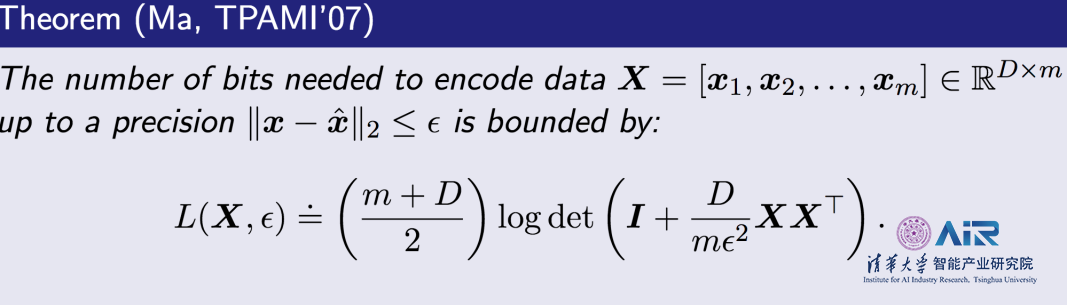

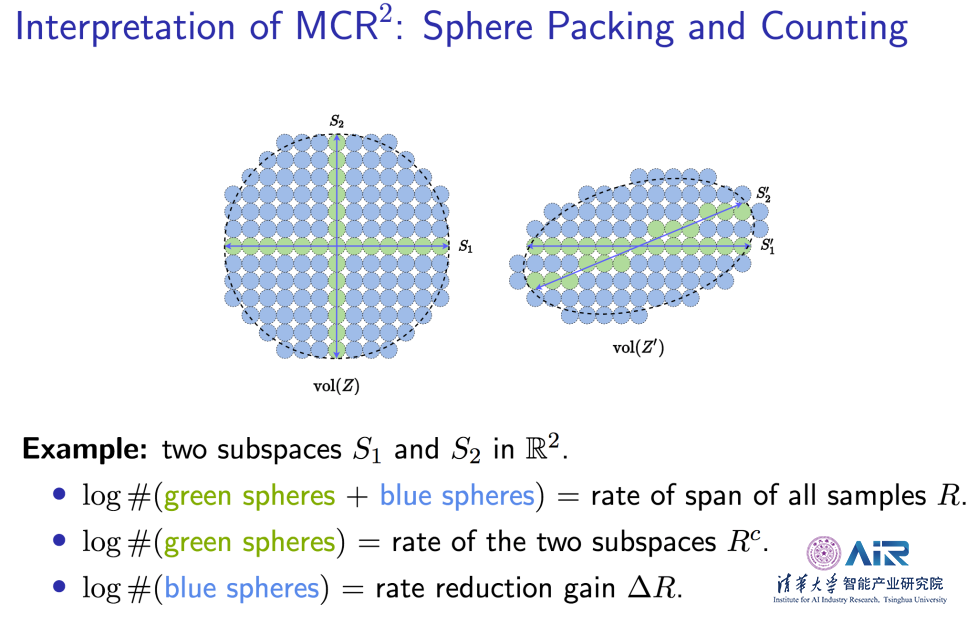

如果我们将数据聚类任务和数据分类任务放在更本质的数据压缩框架下,那正确划分的数据应该具有更小的体积,能够获得对数据更简略的表示。从信息论的角度,可以使用有损编码理论来测量高维数据分布的维度和体积。

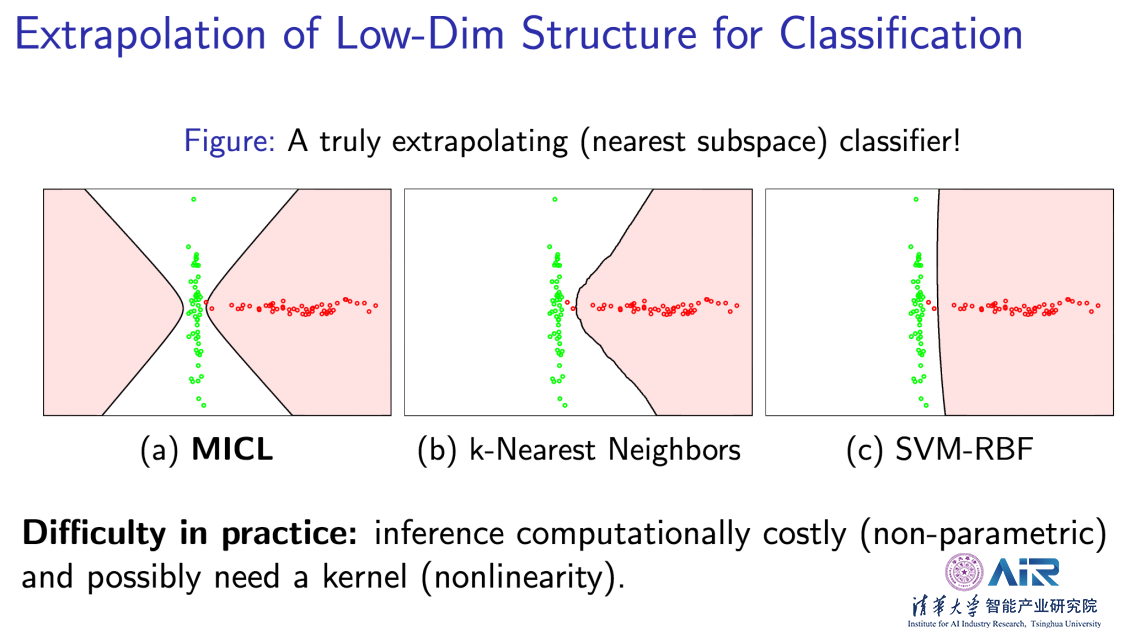

在分类任务中,对新输入的样本计算与各个类之间的距离,该样本则属于距离最短的那一类别。在数据压缩的框架下,哪类数据可以用最少的编码增量解释新样本,则该样本就属于那一类别。相比于传统方法,最小增加编码长度(Minimum Incremental Coding Length -- MICL)可将数据的低维结构捕捉到,可得到一个真正的利用结构外插(extrapolating)的分类器。而k-Nearest Neighbors(最近邻)和SVM-RBF并没有通过低维数据结构外插的特性。

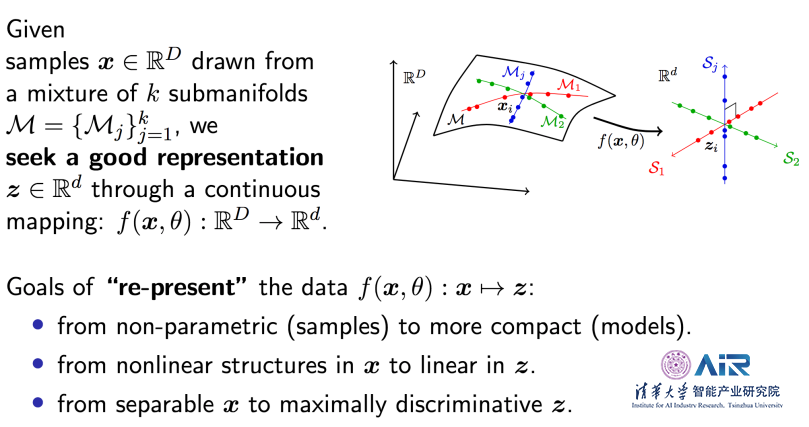

在理解如何对数据进行聚类与分类之后,如果允许通过某些(非线性)映射对数据进行变换,我们有机会得到更简略和线性的数据特征表示。如下图所示。不仅可把原数据非线性结构变为线性还能让不同部分最大限度分开。较好的数据表述应符合下列几点:

1. 同类的数据尽量可压缩在一起,在一个低维的线性子空间上面;

2. 不同类数据,尽量分开,越不相关(甚至正交)越好;

3. 每一类的feature,丰富性、完整性越高越好。

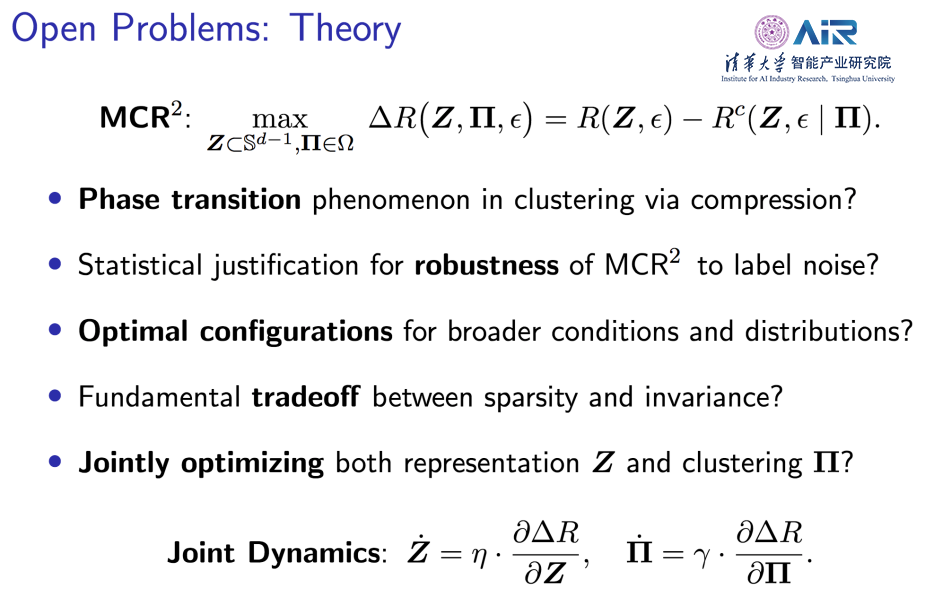

数据特征表述达到最优时,同类压缩更为紧凑,非同类间距拉大,可用“同性相斥,异性相吸”来概括。也就是说使整体的编码率减去局部的编码率得到的编码率差值,越大越好,表明整体更开,局部更紧凑。

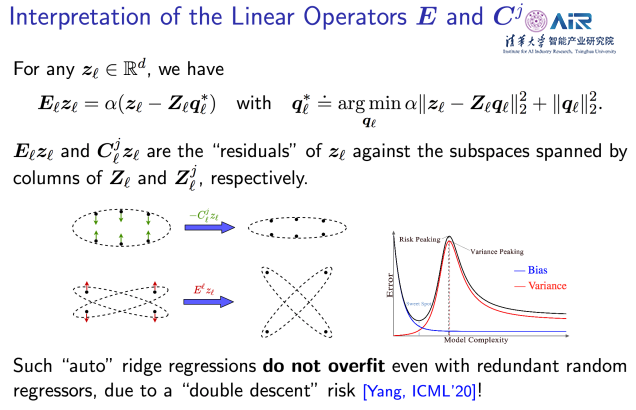

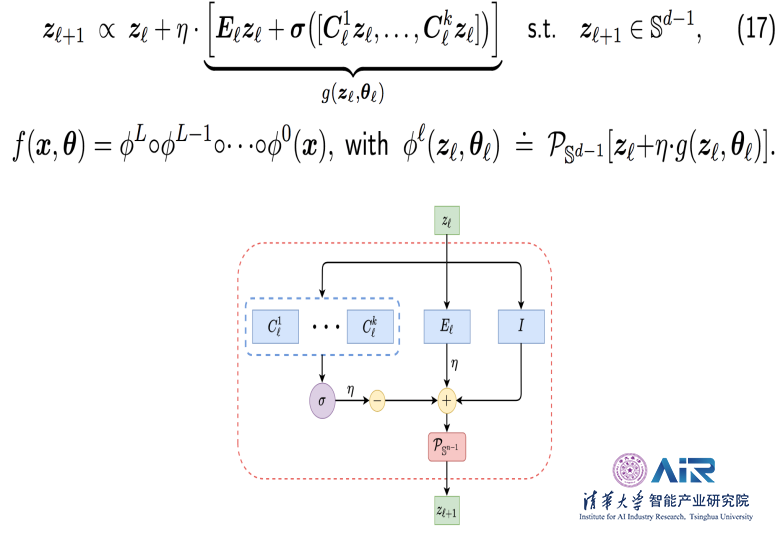

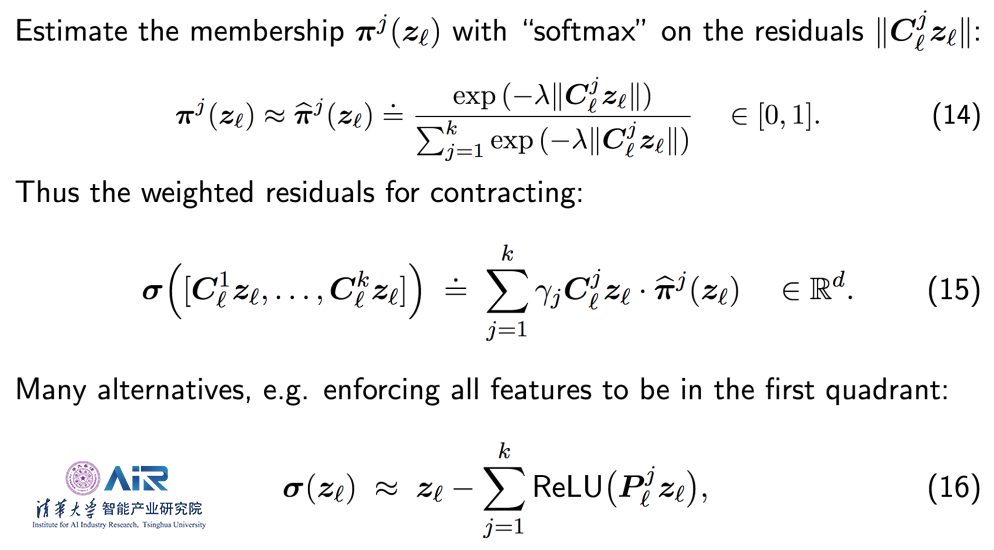

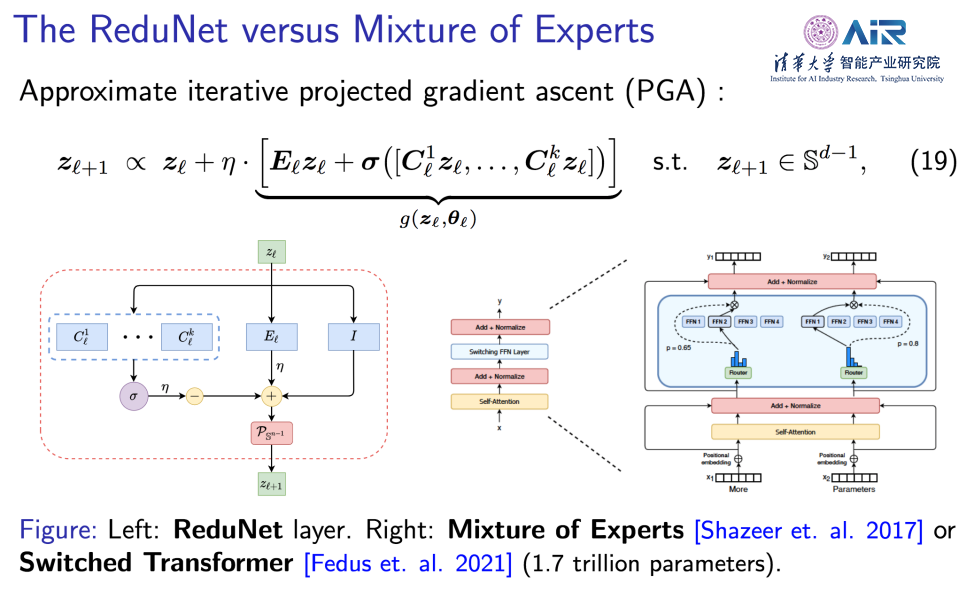

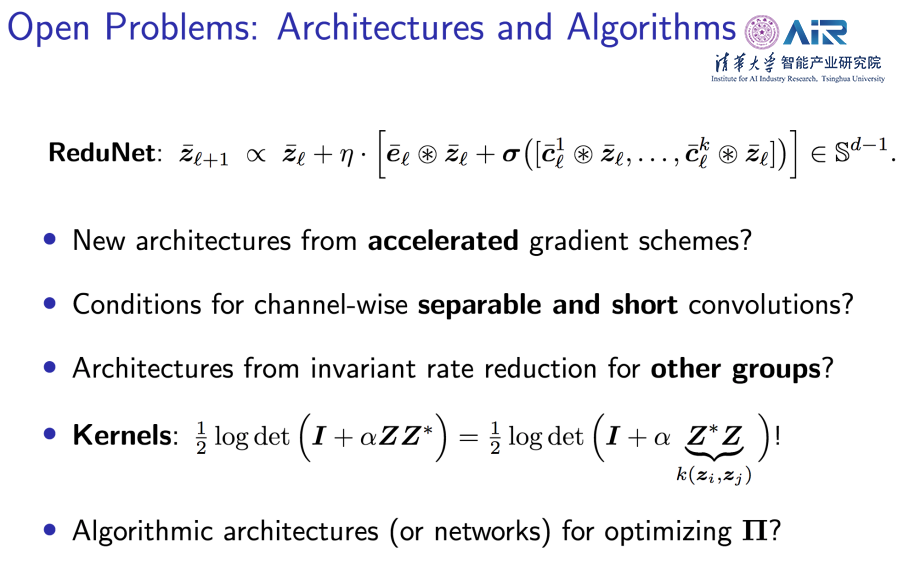

为了实现最大化编码率差(MCR^2)这个目标,我们可以直接构建一个新的深度神经网络ReduNet。一个简单的方法就是对编码率的差做梯度上升。从编码率对特征feature的导数可以获得两个矩阵E、C,而所求梯度就是其分别与样本乘积的和。当需要扩张样本空间的大小时,只需要加上E与样本相乘获得的残差,当要压缩各类低维子空间的大小时,只需要减去与C进行相同操作的结果。

下图所示的网络结构表述梯度下降的过程。其中,每个不同的C通道对应一个类别的分类器,E则为扩张整个feature集的操作矩阵,而梯度下降的更新过程正是在当前特质feature加上得到的梯度。有趣的是Ez和Cz在统计上分别严格对应用所有features或者每一类features对一个新特征 z进行自回归(data auto regression)的“残差”。从很大程度上解释了残差网络(ResNet)的结构特点。

ReduNet网络中所有的结构参数均能够“前向传播”计算得到。因此,ReduNet并不需要经过反向传播(BackPropagation,BP)计算。由此获得的ReduNet网络的所有算子和参数具备严格精确的基于几何、统计、以及优化的意义。由于ReduNet是从优化一个最基本的信息量(编码率差)直接严格推导而来,没有任何主观的或者经验的因素,我们可以认为这是基于“第一原理”得来的神经网络 – 它的功能是实现一个客观的目标。类似于物理中热力学的熵增原理。

这种基于第一原理的严格数学推导还揭示了以下几个好处:

1. 揭示了不变性和以分类为目的的稀疏表之间存在的权衡关系;

2. 揭示了不变深度网络和傅里叶变换之间的基本联系——也就是在谱域中计算的优势;

3. 揭示了前向传播算法(优化)和反向传播(BackPropagation,BP)算法(变分)分别扮演的数学角色。

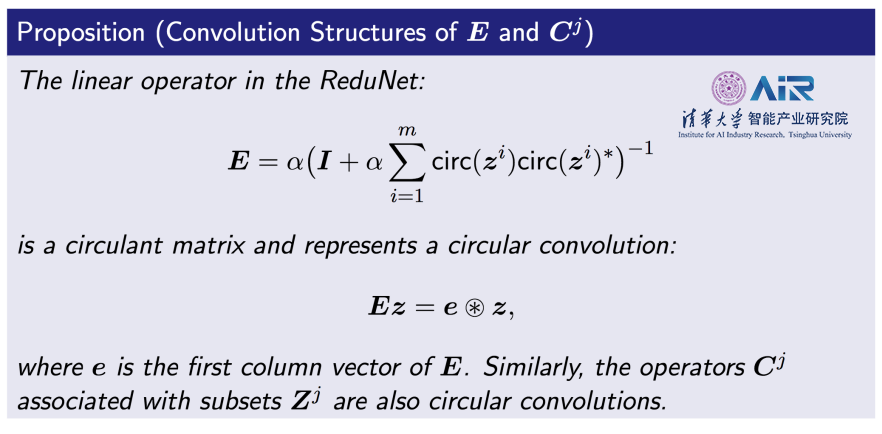

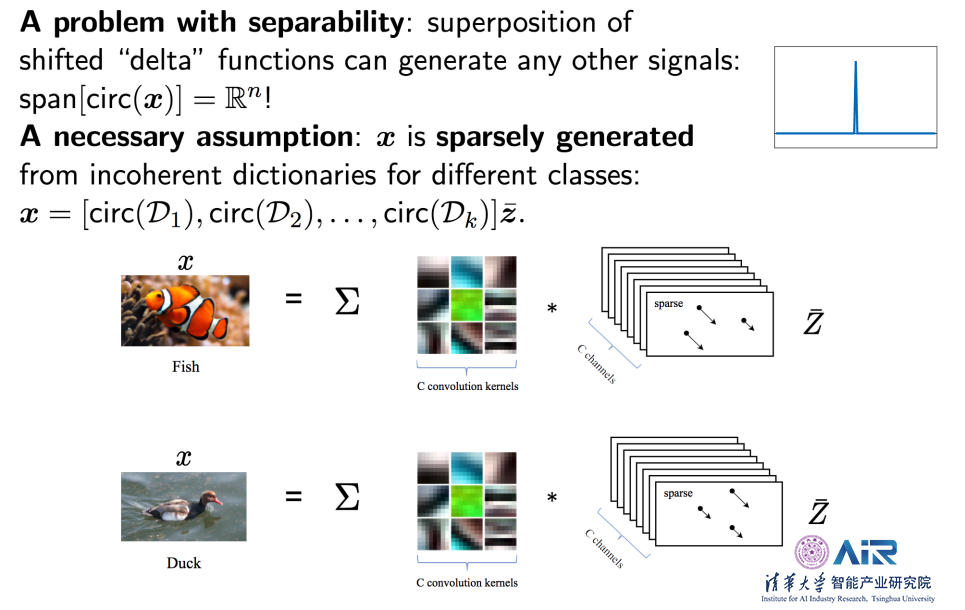

ReduNet可从平移不变性直接派生出深度卷积网络,实现对信号分类的平移不变性。我们只需要用循环矩阵表示样本所有平移,当使用ReduNet对这样的数据进行压缩时,对应的E、C矩阵自然变成循环卷积算子。

更有趣的是,当我们对多通道数据进行平移不变的压缩时,派生网络的所有线性算子自然会变成多通道卷积。该框架也揭示了数据的稀疏性和不变性之间的相斥关系。目前,ReduNet使用最简单的随机卷积核来提取样本的稀疏编码。

ReduNet网络的整体结构与目前通用的网络非常相似,也可以通过反向传播对它进行进一步优化。在前向传播计算得到的参数,为反向传播训练提供了参数初始化,通过该初始化得到的参数,经过反向传播训练后,结果比随机初始化要所提升。由此可知,深度神经网络中的卷积、归一化、非线性等操作都是为了更好的优化MCR^2目标。

从数据压缩以及群不变性的角度来构造和阐释深度卷积神经网络。说明现代深度层次架构、线性算子和非线性激活,甚至所有参数,都能用数据压缩中编码率减小的原理解释。网络所有层次结构、算子(包括卷积)、以及算子的参数值都能利用前向传播算法显示构造得出,无需反向传播算法进行学习。而反向传播可以对网络进行进一步细调。所以ReduNet网络本身的正向传播是在对编码率进行优化,而反向传播可以看成是对正向的优化路径进行进一步变分优化。作者在下面的列表里把基于数据压缩原理的深度学习和深度网络与传统的进行了系统的比较。

本次报告中阐述了许多关于深度学习的前沿知识,关于深度神经学习与数据压缩之间的关联,关于MCR^2原理的研究,以及ReduNet网络结构的优化。可用一句话概括为:深度神经网络本身的层次结构其实就是在做迭代的优化,做数据压缩,逐层逐步优化数据特征的表达。

在讲座的最后,马毅教授表示,这个报告其实信息量很大,涉及到很多领域、专业知识,希望同学们深入地理解之后,形成自己正确的看法。这项工作给大家提供了一个严格的数学框架,由此引申出非常多理论,算法,以及应用方面的新问题。“(这个方向)还有很多可以扩展可以改进的地方,这只是一个非常基础的起点。”马毅如是说。

撰文 / 孟春雷 冼晓晴

编辑排版 / 冼晓晴

校对责编 / 马毅 黄妍

精彩视频回顾及完整版PPT下载,请点击:

AIR学术沙龙第4期|基于第一原理的深度(卷积)神经网络