清华大学智能产业研究院(AIR)致力于利用人工智能技术赋能产业升级、推动社会进步。为更好地增强学术交流,促进学科发展,保障行业最新信息的及时交换,AIR将定期举办各种不同类型的学术沙龙。

活动概况

4月1日下午在智能产业院图灵报告厅举办的AIR学术沙龙第一期,我们荣幸地邀请到清华大学自动化系助理教授黄高博士为师生作题为《动态卷积神经网络》的学术报告。活动中,黄高博士从动态自适应模型的角度介绍高效深度神经网络设计的研究进展,并探讨现有方法的局限以及未来发展前景。

本次活动吸引了来自清华大学、北京大学、帝国理工大学、爱丁堡大学、天津大学等院校的学者与学生参加,现场氛围热烈活跃。

黄高博士用严谨又不失风趣的语言为在座的清华学子及专家献上一场精彩纷呈的《动态卷积神经网络》学术盛宴,并在讲演结束后与同学们展开了热烈互动。黄高博士深入浅出、妙语连珠的精彩回应赢得了全场热烈的掌声。本次活动由清华大学智能产业研究院副院长刘洋教授主持。

黄高与马维英、陶大程、聂再清等参会学者合影

讲者简介

黄高,清华大学自动化系助理教授、博士生导师,2015年获清华大学博士学位,2015年至2018年在美国康奈尔大学计算机系从事博士后科研工作。致力于深度学习和计算机视觉研究,提出了主流卷积网络模型DenseNet。目前在NeurIPS,ICML,CVPR等国际顶级会议及IEEE多个汇刊共计发表学术论文50余篇,被引用20000余次。获CVPR最佳论文奖、达摩院青橙奖、世界人工智能大会SAIL先锋奖、全国百篇最具影响国际学术论文、中国人工智能学会自然科学一等奖和和国家优青基金资助等荣誉。

报告内容

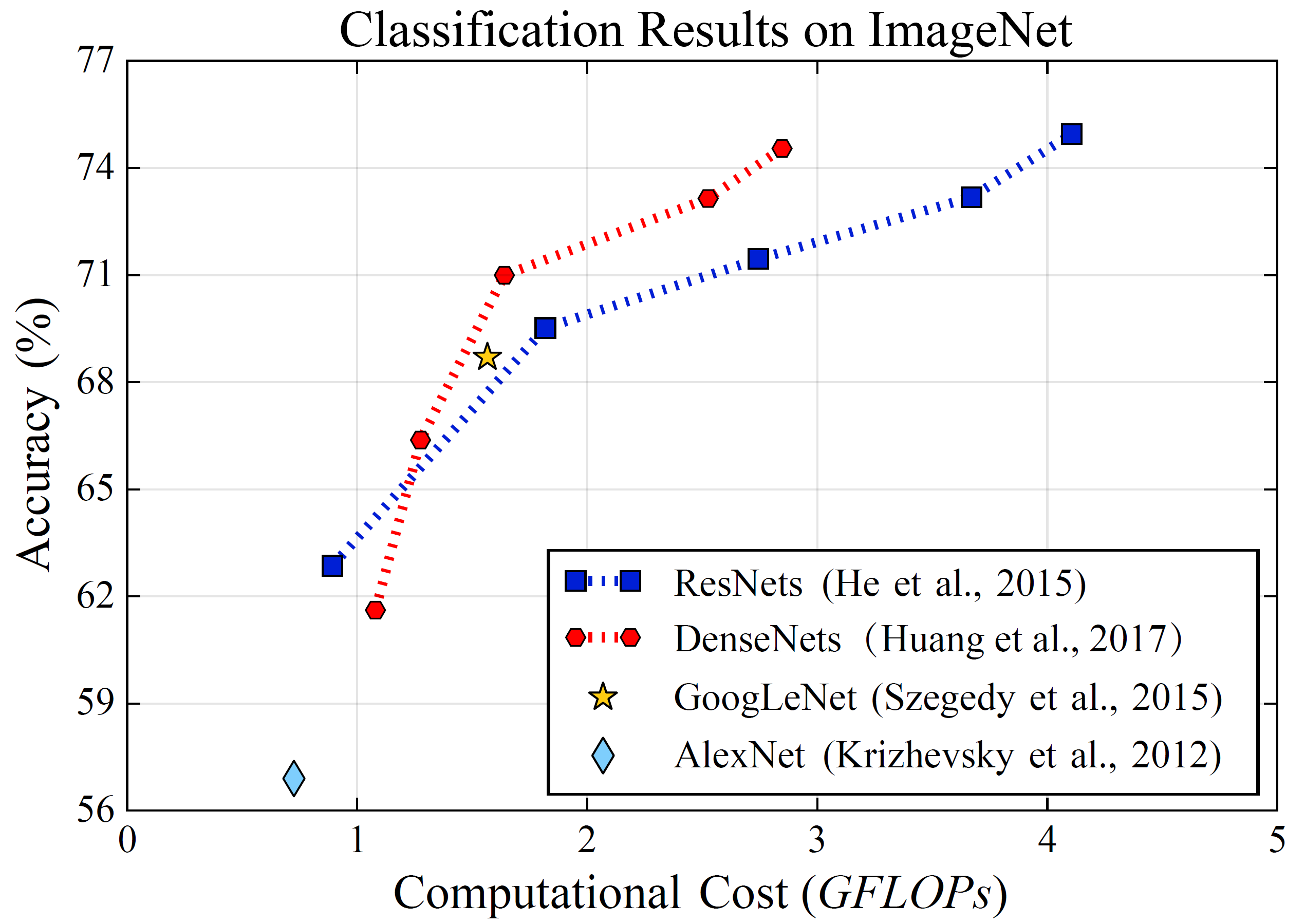

近年来,深度神经网络在CV、NLP等领域中取得了广泛的应用,AlexNet, VGG, ResNet, DenseNet等网络在相应任务上取得了显著的突破。这些深度网络往往能够在更大参数量的支持下能够取得较好的性能。

(深度网络往往面临着计算量与性能间的权衡)

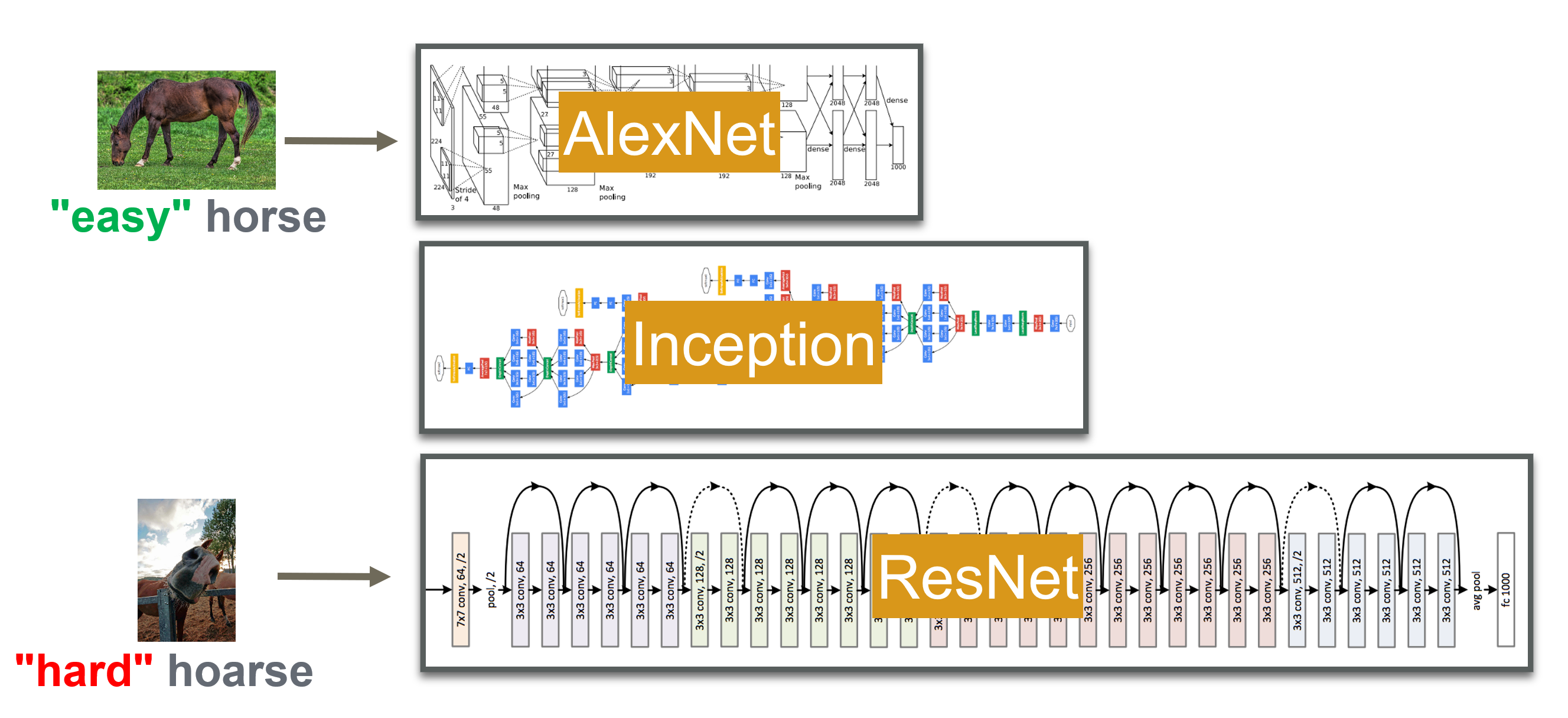

关于模型参数规模与性能提升间的联系,一个可能的解释在于更大的模型有助于识别那些非常规的、难度更高的图像。然而,对于静态网络而言,模型结构和参数在训练完成后就被固定下来,在推理阶段对于任何难度的输入都需要相同数量的参数去做推理。对于那些相对简单的样本而言,一个浅层的网络可能足以完成分类任务,采用大模型进行推理可能会带来不必要的计算冗余。那么是否可以根据输入样本的“难度”自适应地调节模型大小呢?

(采用不同规模的网络适配不同难度的样本)

一个简单而直观的解决方案是将多个模型从小到大地级联起来。对于任意的输入样本,首先经过小模型得到分类的结果和置信度,对于置信度低的模型再送入到更大的模型中重新分类。

这样的方案存在的问题在于,各个级联模型间是相互独立的。对于一个难度较大的样本,小模型的分类结果对后续的计算没有帮助,大模型需要重新对样本进行分类,这同样带来了计算上的冗余。因此,可以进一步地考虑在大模型的中间层插入分类器,使得简单样本不需要经过完整的模型即可得到分类结果。

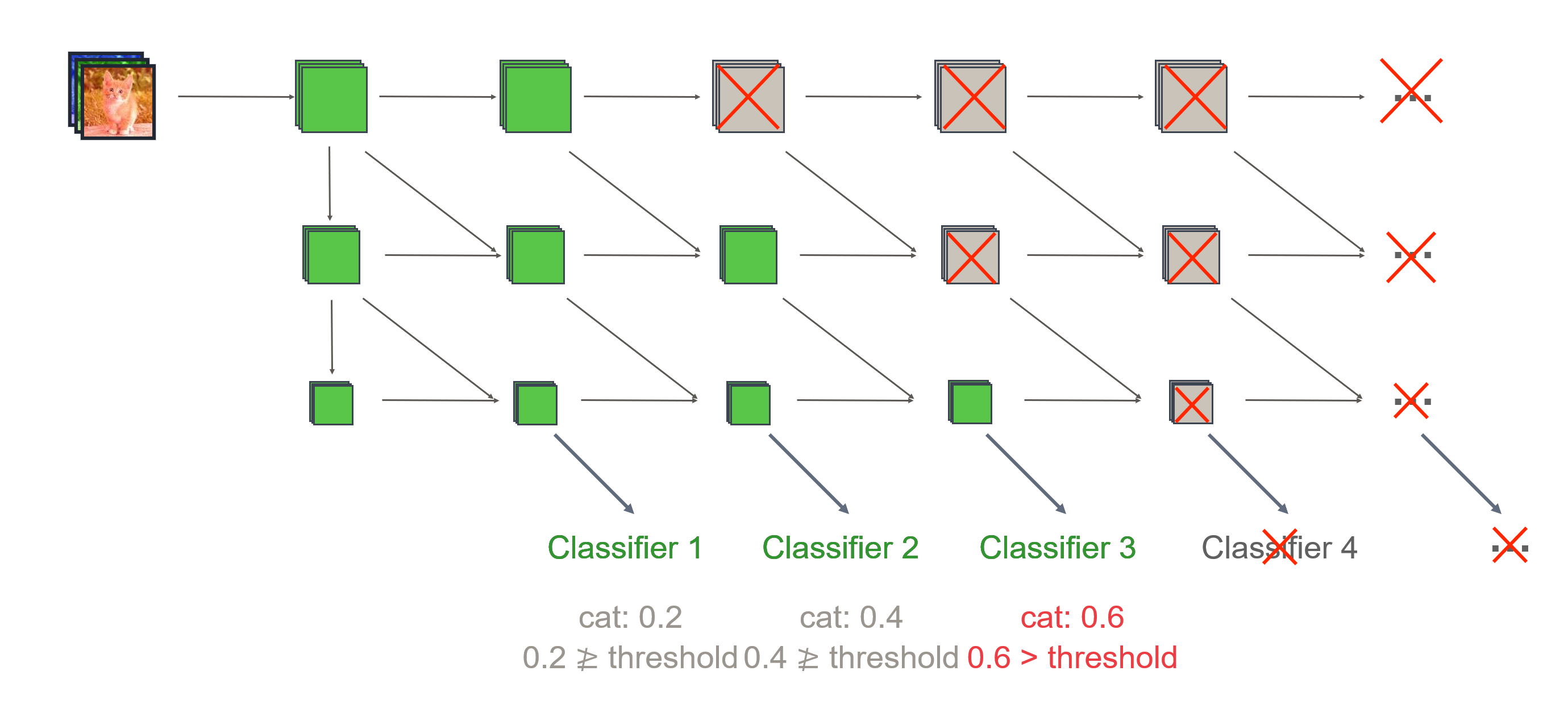

(MSDNet架构图)

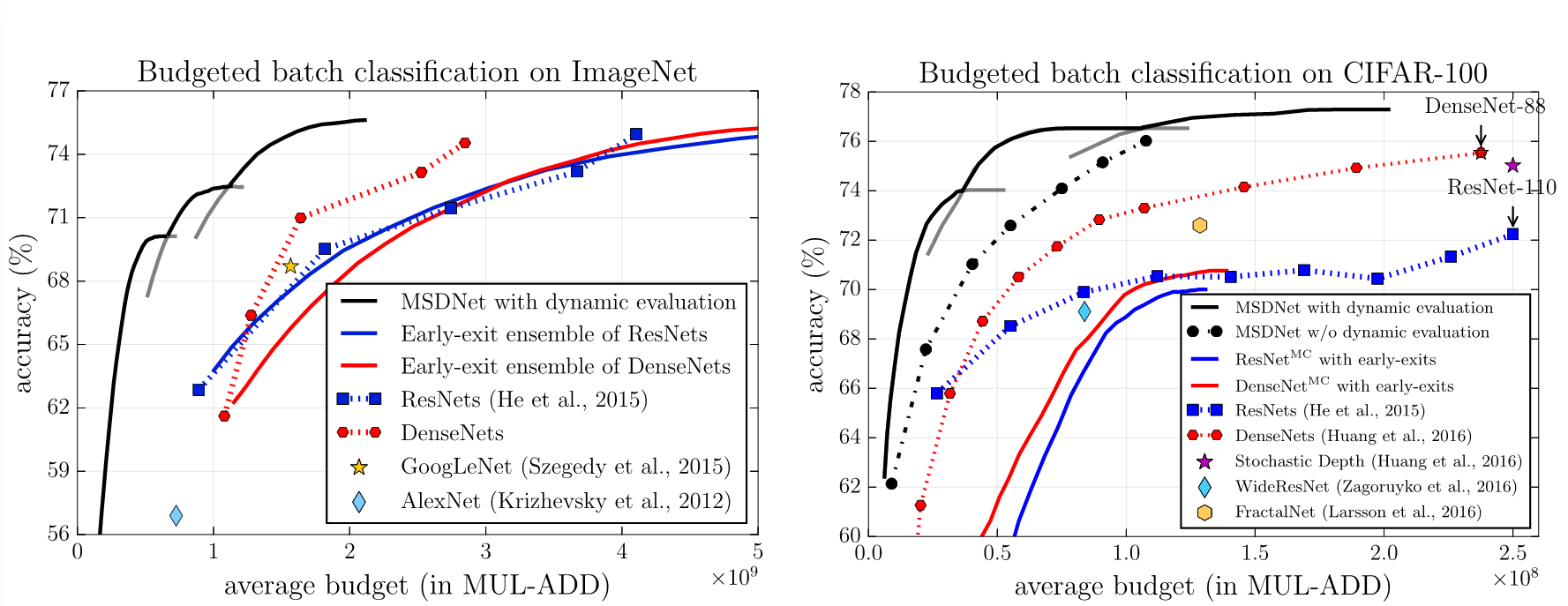

然而,深度卷积神经网络往往存在着中间层表示分类准确度低的问题。为解决这一问题,黄高老师在ICLR’18提出了MSDNet架构,该架构中的水平层衡量表征粒度,垂直层衡量分辨难度,每一垂直层中节点兼顾前一层的同粒度表征(水平连接)和更细粒度表征(斜向连接),而分类器只接在垂直层的粗粒度表征后。模型通过对分类器的置信度设定阈值来判断是否需要进一步的横向计算。通过调节阈值,模型可以在部署阶段调节计算能力,来完成计算量和性能间的权衡。下图中表明采用多尺度架构的动态网络MSDNet相对于静态的DenseNet能够达到2到5倍的速度提升。

(MSDNet在ImageNet和CIFAR-100上取得显著的速度提升)

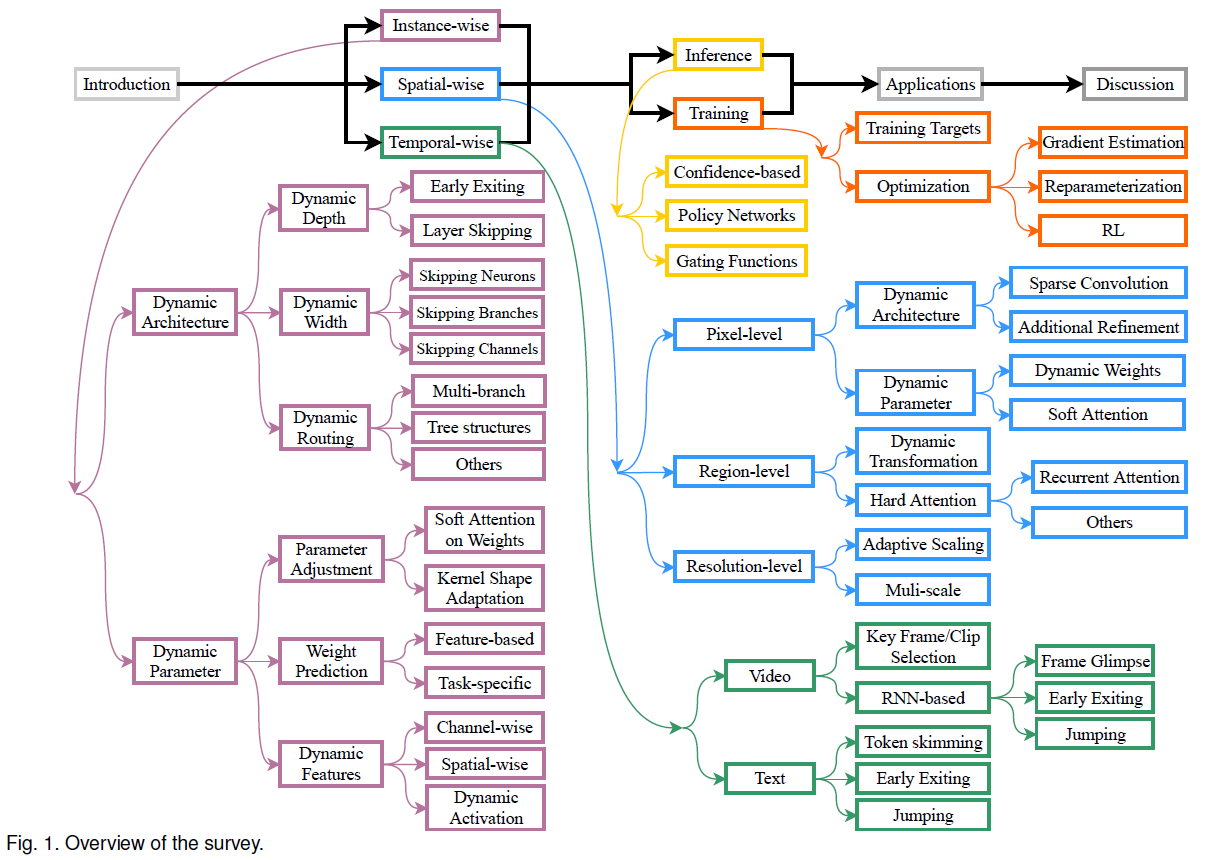

MSDNet可以在推理阶段根据输入样本动态调控模型的计算能力,这也是动态网络较之于静态网络的一大优势。而动态网络并不仅仅可以基于样本维度来实现,黄高老师团队最新完成的一篇综述中给出了对动态神经网络的层次划分。文中将动态网络划分为三个大类,除了如MSDNet的样本自适应网络外,还包括空间维度和时间维度的自适应网络。

(动态网络层次划分)

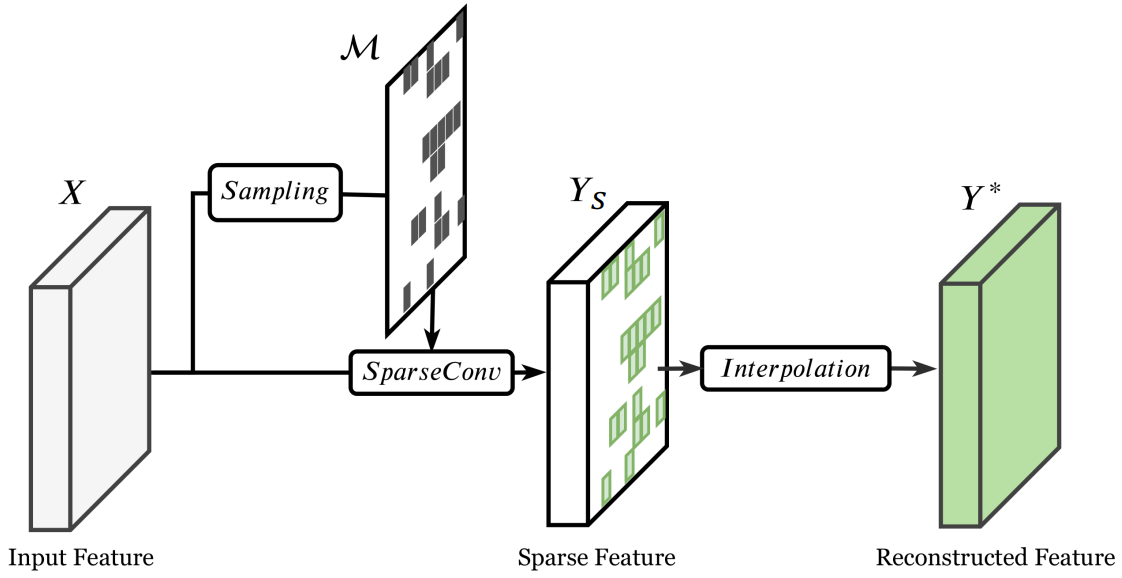

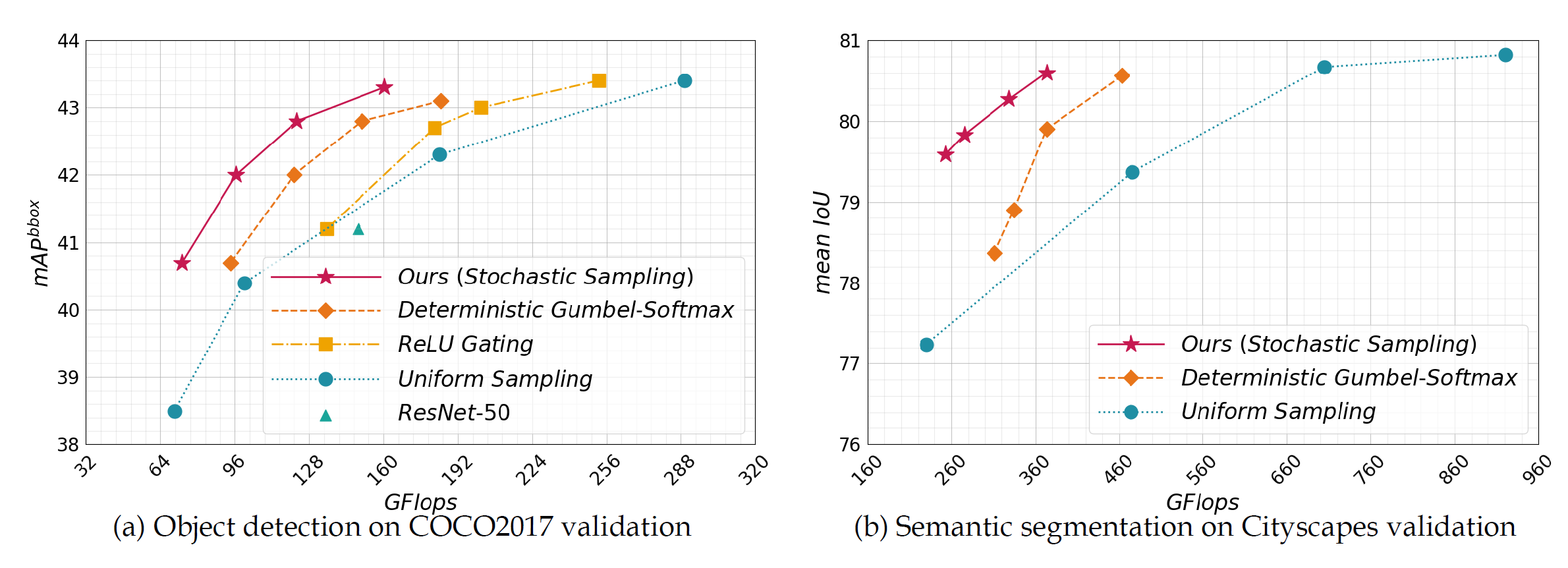

从空间的维度上来看,一个人关注于一张图片的时候,往往会优先关注于相对关键的部分。对于模型而言,同样可以通过hard attention的方式使得模型的运算集中在关键区域,减少信息量有限的局部运算。一篇典型的工作是发表在ECCV’20的Spatially Adaptive Inference withStochastic Feature Sampling andm Interpolation.

这篇工作中的网络架构主要分为三个部分:

1)采样层:对输入图片进行采样得到掩码矩阵,表征图片中的关键区域

2)稀疏卷积层:仅在采样区域进行卷积运算

3)插值层:对其他部分进行插值来重构出完整的特征图

由于网络的运算过程主要集中在卷积层,上述的采样-插值操作可以降低卷积操作次数,从而有效地提高网络的计算效率。从实验结果上来看,采样-插值网络可以在COCO2017和Cityscapes开发集上节约45%和60%的计算成本。

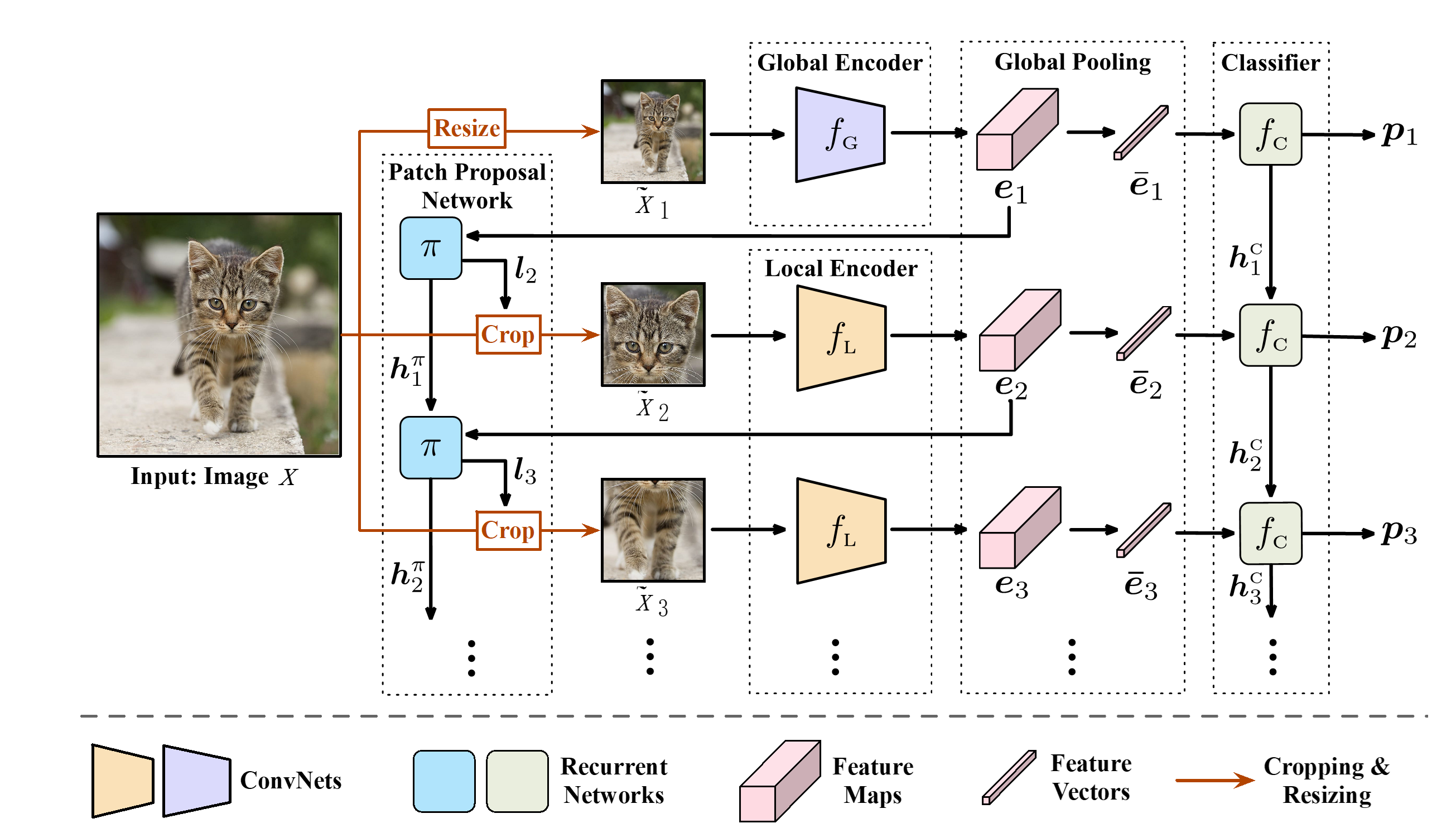

进一步来看,人类对图片的认知是一个递进式的过程,一个人首先关注到图片的全局特征,而后逐渐细致地关注到局部的关键特征,从而提取到图片的有效信息。提出于NIPS’20的GFNet将这一迭代过程融入到模型中,将图片识别过程划分为两个阶段:

(GFNet架构)

1)Glance阶段:采用全局编码器对图片进行编码,得到图片的全局表示,并基于全局表示进行分类,得到分类结果和置信度

2)Focus阶段:若全局置信度低于阈值,则迭代式地裁剪图中的子区域,基于子区域的局部表示进行分类,直到置信度达到阈值

为得到最终的模型,文中提出了一种三阶段的训练方法:

1)采用随机裁剪代替裁剪网络,训练网络中的编码器和分类器,训练模型对任意输入的全局和局部表征能力

2)固定编码器和分类器,采用强化学习方法训练裁剪网络

3)固定裁剪网络,优化编码器和分类器,进一步提升模型在给定裁剪策略下的性能。

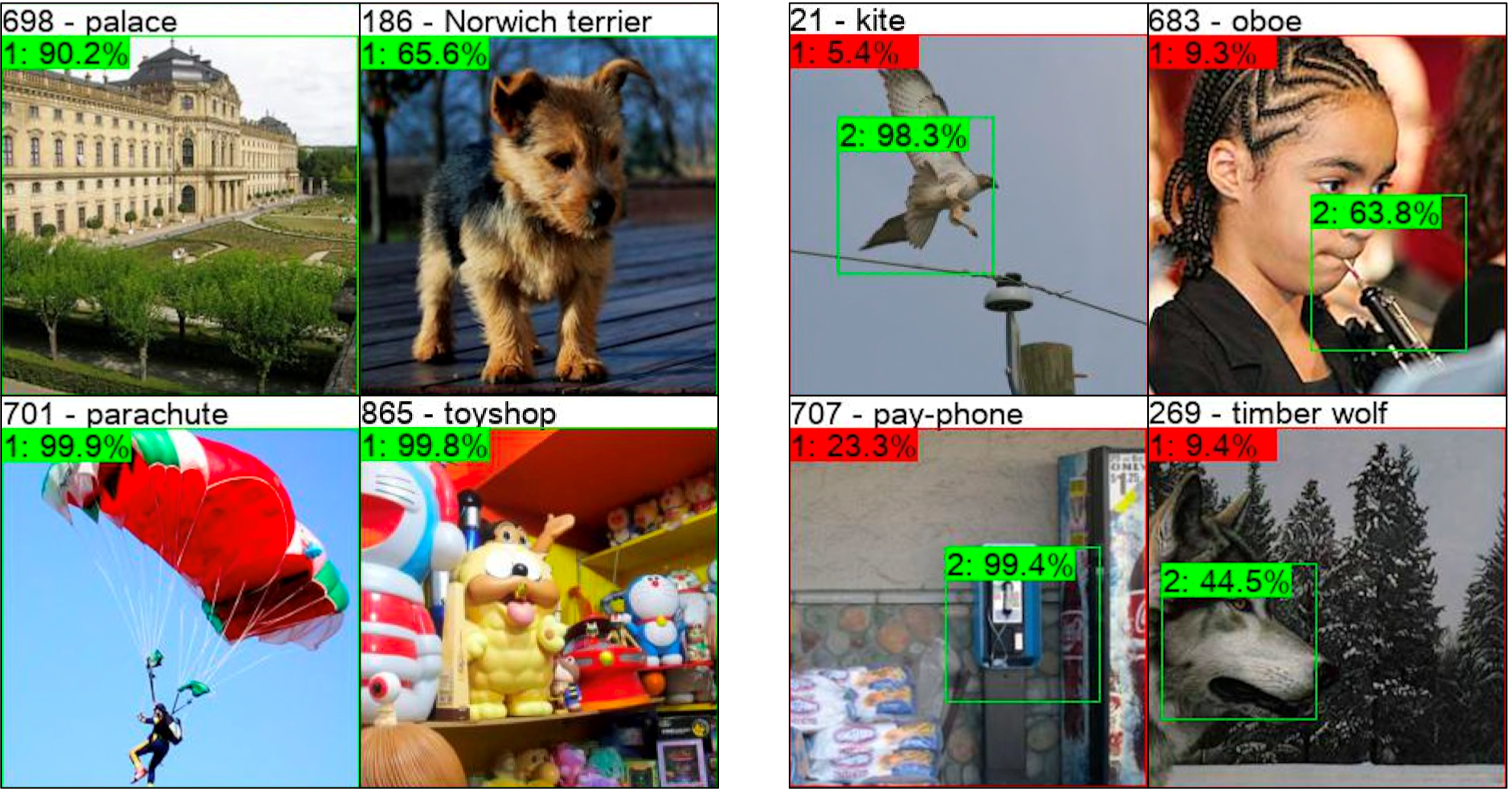

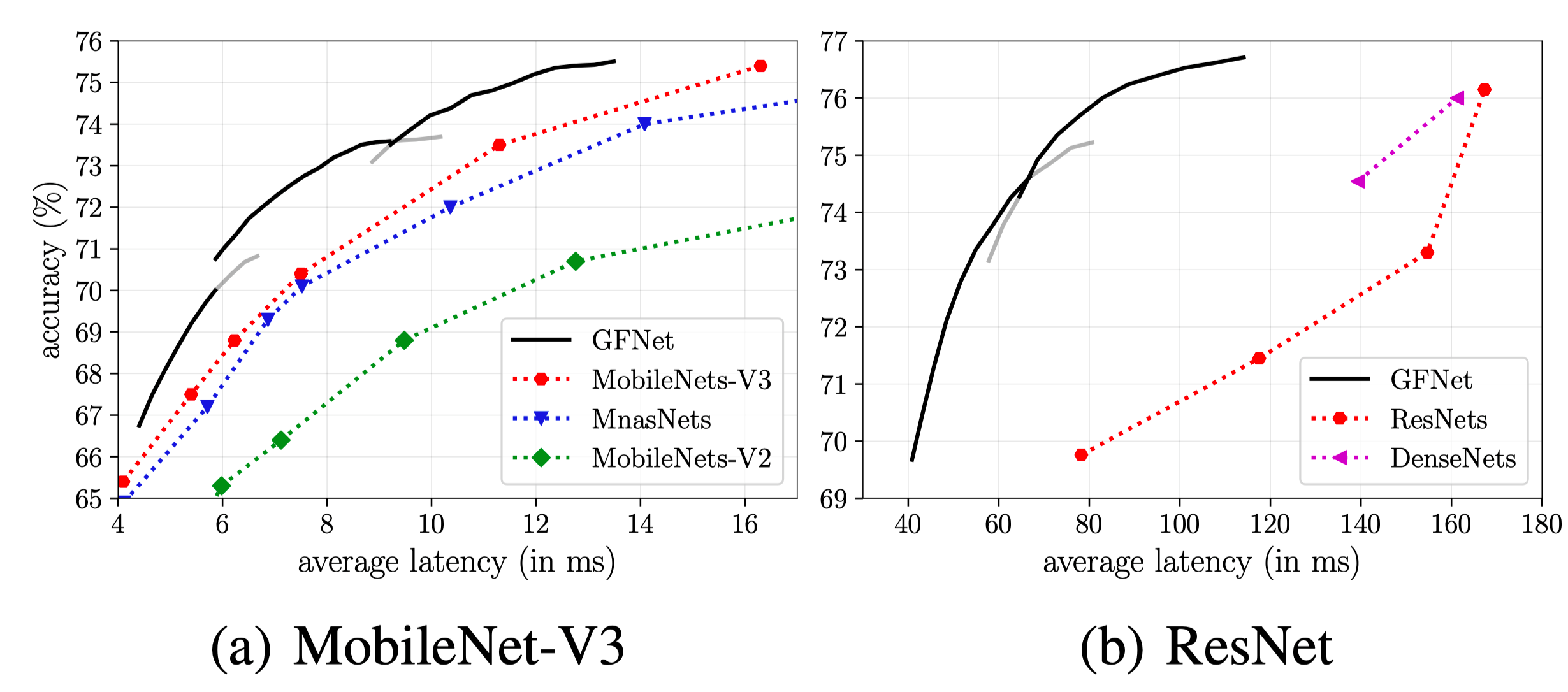

GFNet可以根据置信度动态地调节迭代轮数,在运算量和性能间达到平衡:对于低难度图片(如图中的宫殿、降落伞),模型可以在Glance阶段快速得到结果,减少运算时间;对于高难度图片(如图中的网球拍),模型可以通过多步迭代逐步提升分类能力,保证模型性能。与静态模型相比,能够带来显著的效率提升。

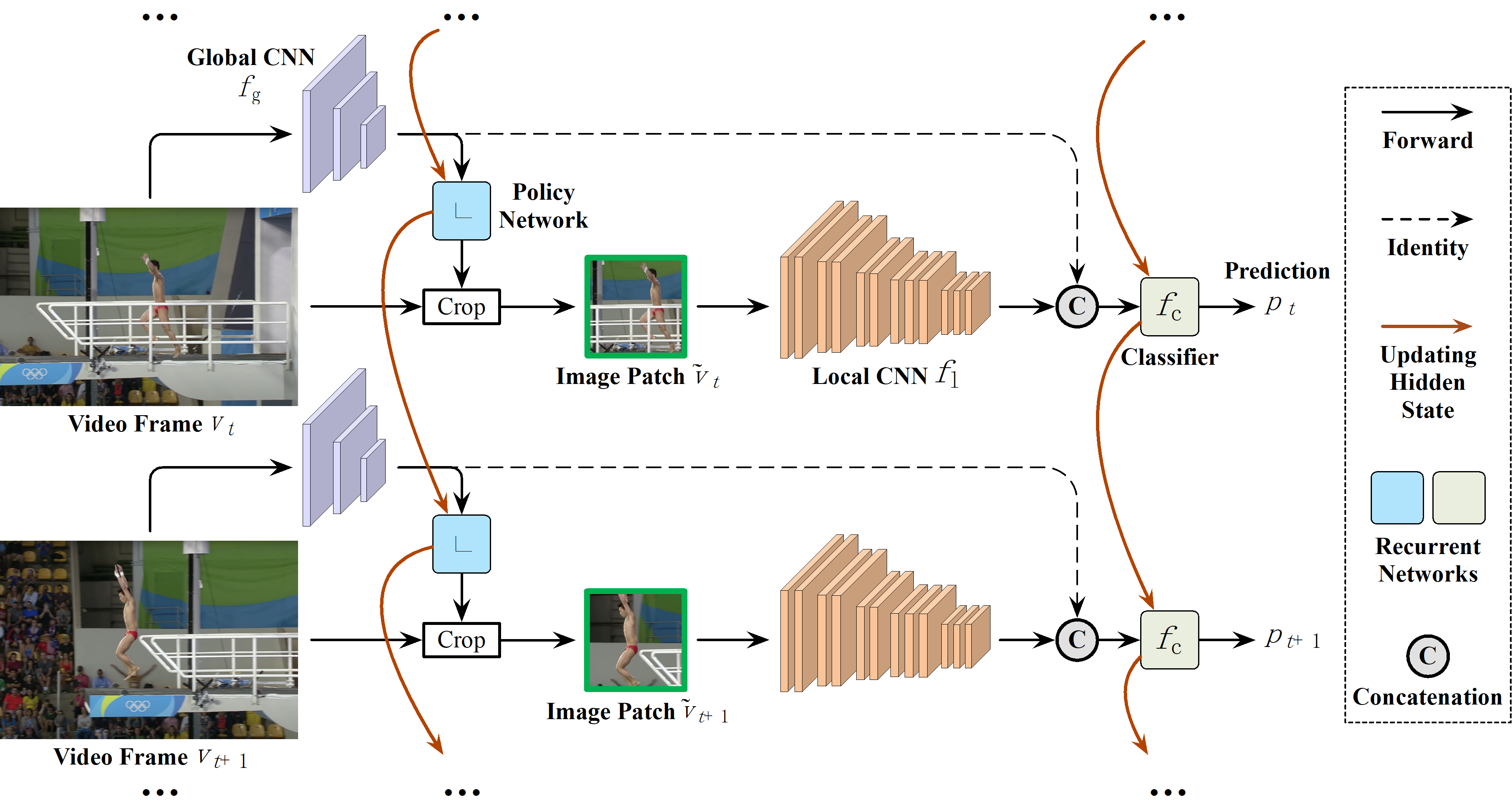

我们可以进一步将动态网络的思想应用在视频分类任务中,使模型兼具空间和时间上的自适应能力。例如将对视频中每一帧判断是否跳过,以及具体应计算该帧中的哪一子区域等。

精彩视频回顾及完整版PPT下载,请点击:

AIR学术沙龙 I《动态卷积神经网络》精彩回顾(附报告PPT、视频)