3月28日中午,由DISCOVER实验室主办的第二十九期AIR青年科学家论坛如期举行。本期讲座有幸邀请到伊利诺伊大学香槟分校(UIUC)计算机系助理教授李昀烛,为AIR的老师与同学们做了题为《Foundation Models for Robotic Manipulation: Opportunities and Challenges》的精彩讲座。

李昀烛,伊利诺伊大学香槟分校(UIUC)计算机科学系助理教授,本科毕业于北京大学计算机系,在Antonio Torralba和Russ Tedrake教授的指导下,于麻省理工学院计算机科学与人工智能实验室(CSAIL)获得了博士学位,在斯坦福大学攻读博士后期间,与Li Fei-Fei和Jiajun Wu教授合作。他的研究方向是机器人学、计算机视觉和机器学习领域的交叉,旨在帮助机器人像人类一样灵巧有效地感知物理世界并与周围环境进行交互。他的工作获得了机器人学习会议(CoRL)最佳系统论文奖和最佳论文提名奖。他还获得了索尼学院创新奖、Adobe 研究奖学金,并获得麻省理工学院人工智能与决策领域Ernst A. Guillemin硕士论文奖第一名。他的研究成果发表在Nature、NeurIPS、CVPR和RSS等顶级期刊和会议上,并被CNN、BBC、华尔街日报、福布斯、经济学人和麻省理工科技评论等主要媒体报道。

在某些特定的领域,机器人已经拥有了超越人类的能力。然而,相比于人类,机器人缺少了对于环境基于常识和直觉的理解。因此,当面对与环境的复杂物理交互时,机器人难以像人类一样准确地理解场景中物体的材质、几何结构、类别,并轻易地从一种操作泛化到其他的操作上。幸运的是,现有的基础模型具备了一定的常识信息并展现了很强的泛化能力,为机器人操作水平的提高带来了机遇。在本次讲座中,李昀烛博士为我们讲解了基础模型应用在机器人操作上的机遇与挑战。首先,李昀烛博士介绍了基础模型为机器人操作水平提升带来的三方面的机遇:

1.如何用基础模型具备的常识信息去定义机器人任务;

2.如何利用基础模型在低层次上建模环境;

3.如何利用基础模型在高层次上建模环境。

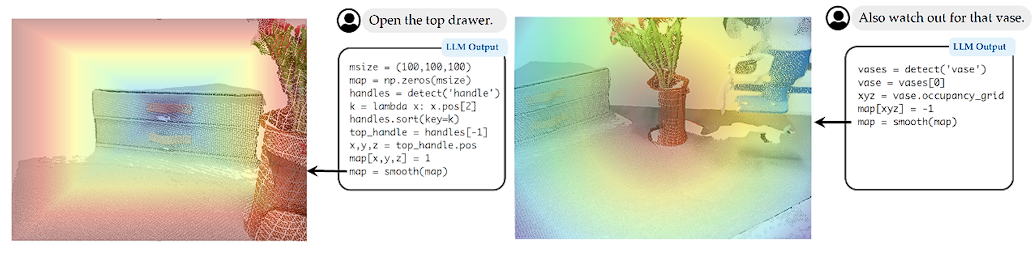

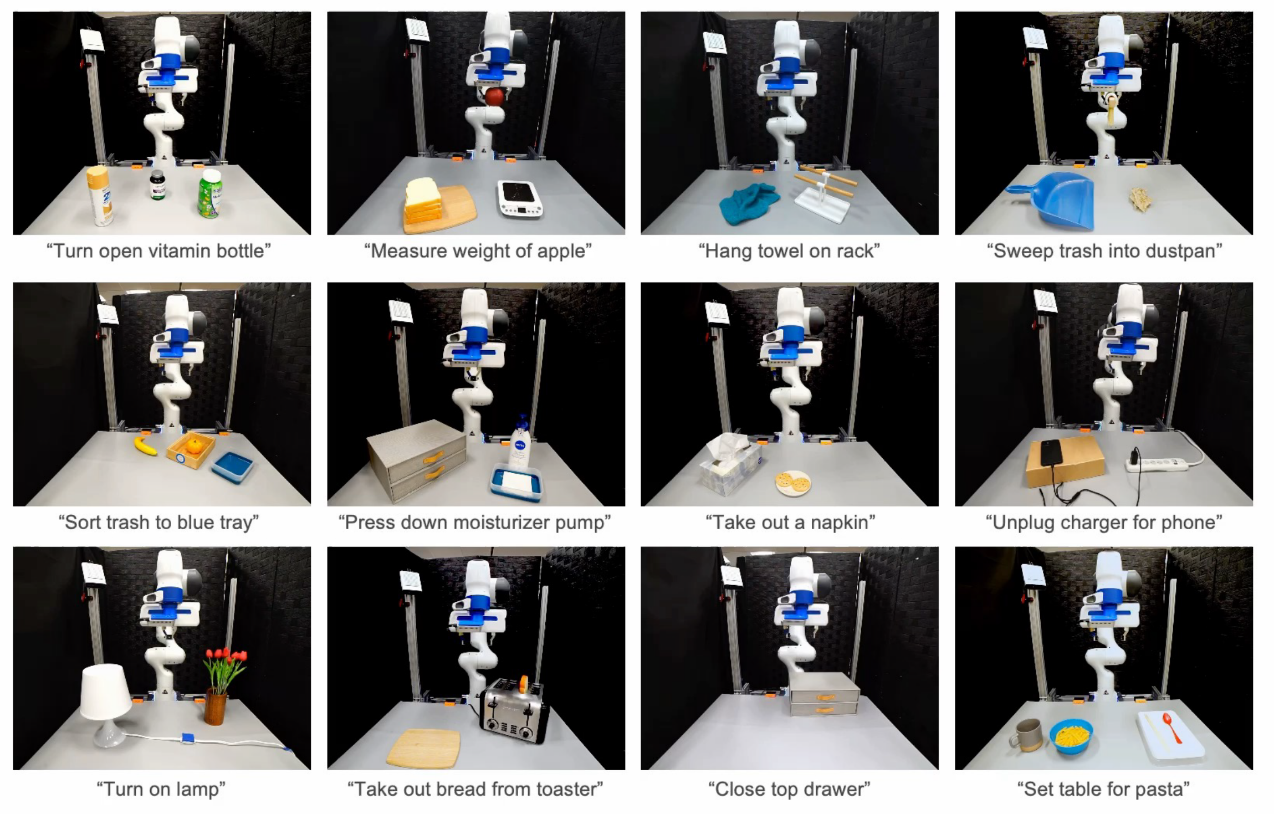

李昀烛博士首先介绍了机器人操作中任务的定义。对于机器人操作而言,一个对人来说很基本的任务描述(如“清理桌面”、“叠衣服”)都需要机器人对环境中大量的信息的理解,而基础模型学到了很多对环境常识信息的理解,因此可以用于引导机器人执行各种操作任务。李昀烛博士以VoxPoser为例,每个任务被描述为自然序言,机器人需要理解自然语言指令,并找到对应的物体执行对应的操作。在语言指令的使用层面,相比于端到端训练的方法,李昀烛博士提出了使用代码作为中间层描述,作为嫁接自然语言指令输入、基础模型、机器人底层操作的桥梁。通过利用基础模型生成代码,以客观函数的形式,这些函数描述了当前任务对机器人的动作的需求,并规划机器人做底层操作,以一步步完成任务。例如VoxPoser中LLM和VLM生成的Affordance Map和Constraint Map,用于引导机械臂操作轨迹规划。

在30多个自然语言描述的任务中,VoxPoser利用基础模型的常识信息,面向开放物体,能够零样本生成机器人操作,无需任何训练数据,证实了基础模型提供的尝试信息赋能了机器人的任务理解和操作规划。

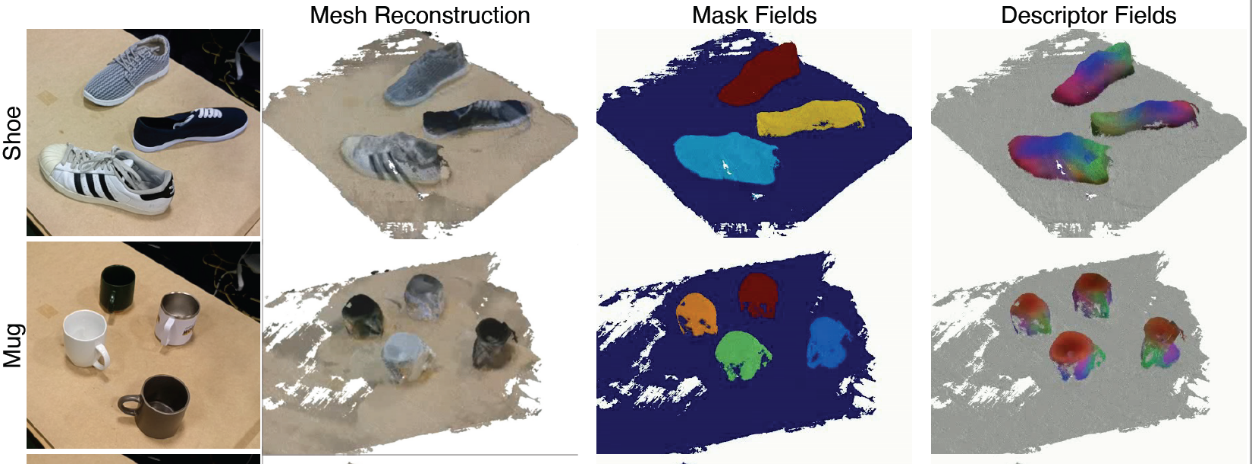

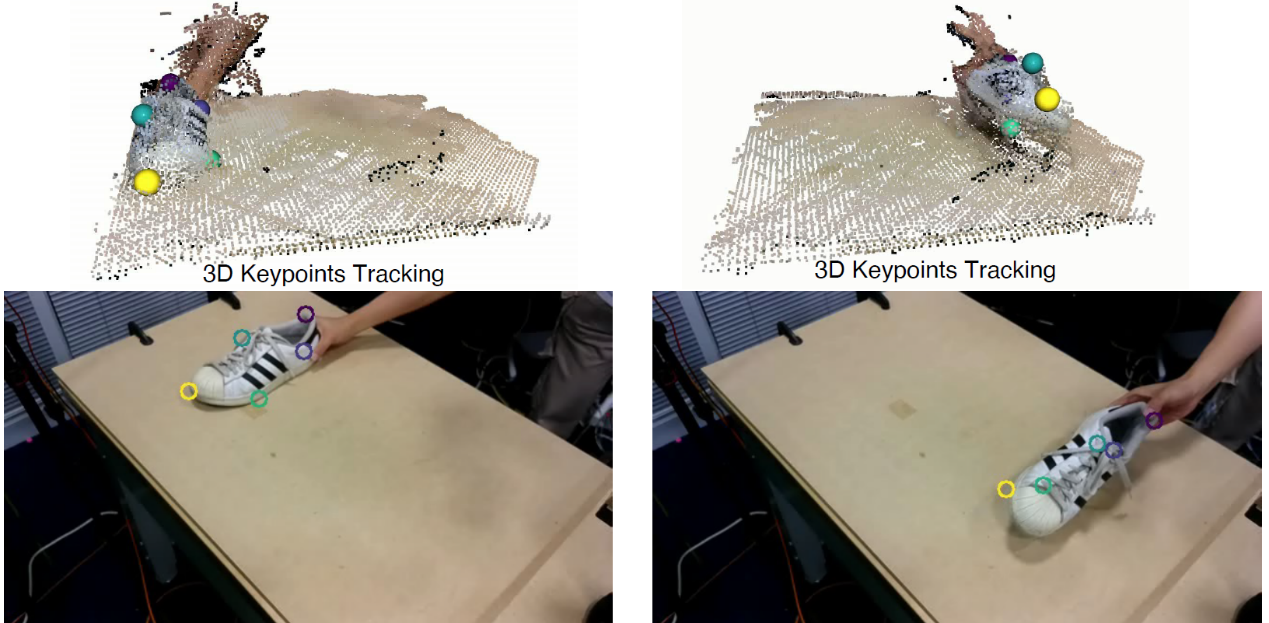

接下来,李昀烛博士介绍了如何使用基础模型如何建模机器人操作所需要的3D表征(低层次的环境建模)。机器人操作所需要的理想的表征应该是3D的,动态的,有语义的,然而现有的视觉基础模型大多是建立在2D上的,因此,李昀烛博士介绍了D3Field,通过将多视角的2D视觉基础模型的特征投影到3D并融合,以建立3D描述场。3D描述场描述了场景物体级别的稠密的语义信息,并能够支持3D查询,使得机器人能够理解场景中物体的可供性。此外,3D描述场还具有时间上的关联性,能够捕捉场景的动态变化。因此,在这样的表征的基础上,通过将目标图片处理为2D描述图,并和3D描述场进行比较,找到其中相关联的关键点,可以被用来比较现在的状态和目标状态的差异,从而进行动作规划。

李昀烛博士还展示了3D描述场在策略学习中的应用。例如在模仿学习中,在训练样例中只有少量的演示示例,通过利用3D描述场,机器人可以更好地理解场景中物体在操作中的可供性信息,从而泛化到更多的工具操作中。

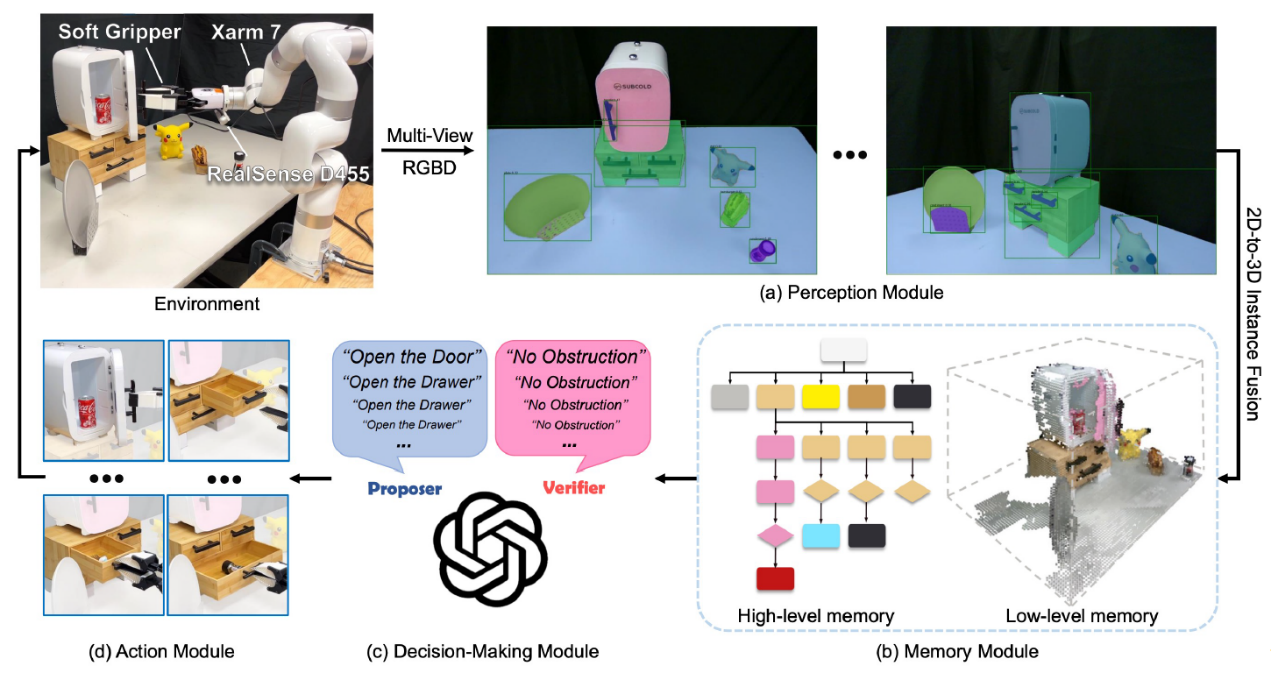

之后,李昀烛博士介绍了如何使用基础模型帮助机器人理解场景的结构以及物体-物体之间的关系(高层次的环境建模)。李昀烛博士引出了“场景图”,而这样的场景图需要机器人在探索的过程中建立。因此,基础模型帮助机器人了解哪些物体需要去探索,并且知道探索的物体信息,即物体能够被用来完成哪些操作,根据探索的过程机器人建立场景图。

根据建立好的场景图,机器人能够理解1.物体之间的从属关系和几何位置关系;2.每个物体的语义,从而在给定任务之后,机器人能够根据可供性找出对应的物体并规划寻找的路线。

本着将基础模型赋能机器人操作普及给大众的期望,李昀烛博士讲解了基础模型在机器人操作中方面的机遇:任务定义;低层次上帮助机器人理解环境(3D,语义,动态);高层次上帮助机器人理解场景的结构及物体之间的关系。最后李昀烛博士回答了老师和同学们的问题,并指出了当前大模型在机器人操作应用上面临的挑战。现在的基础模型在理解场景的3D结构和几何特征方面仍不完美。这些模型对于预测机器人行为对环境的影响也存在很大的局限性。此外,现有的视频生成模型并没有考虑机器人行为的输入,目前的模型也无法实现对于场景的精细编辑,这些都导致其在机器人应用方面面临很多的挑战。

文稿撰写 / 郑宇航

排版编辑 / 王影飘

校对责编 / 黄 妍