10月22日,AIR DISCOVER青年科学家论坛第三期在清华大学智能产业研究院(AIR)图灵报告厅举行。本期活动荣幸地邀请到北京大学前沿计算研究中心助理教授、博士生导师王鹤教授,为我们介绍3篇关于六维位姿(6Dof Pose,包括3Dof的Translation和3Dof的Rotation)的论文。

物体的六维位姿(6Dof Pose,包括3Dof的Translation和3Dof的Rotation)是将物体从世界坐标系转换到相机坐标系的重要物理性质,六维位姿的估计和追踪(Estimation and Tracking)被广泛应用于机器人视觉、抓取和控制等领域。传统的六维位姿估计是基于Instance-Level的,它需要确定的CAD模型。并且仅适用于少数已知的训练集中的物体,泛化能力差,有很强的局限性。本次王鹤博士Talk将六维位姿估计这一问题从Instance-Level推广到Category-Level,可用于估计已有类别中的大量新颖物体的六维位姿和三维尺寸,对实现可泛化的机器人视觉系统有重要推动作用。

讲者简介

王鹤博士现任北京大学前沿计算研究中心助理教授,博士生导师,兼北京通用人工智能研究院(BIGAI)研究员。研究方向为三维视觉、机器人学。博士毕业于斯坦福大学电子工程系,导师为美国两院院士Leondias J. Guibas。王鹤博士在CVPR/ICCV/ECCV发表文章十余篇(5篇获得CVPR oral),获得了2019年Eurographics Best Paper提名奖。他开辟了类别级物体六维位姿估计(category-level object pose estimation)的新方向,已被CVPR 2021列入投稿子领域。他将担任2022年国际计算机视觉与模式识别会议(CVPR)领域主席。

报告内容

王鹤博士以他的3篇论文作为本次分享的抓点,由简入繁,由浅入深,带我们逐渐揭开六维位姿估计和追踪的神秘面纱。

三篇论文分别是:

[1] Normalized Object Coordinate Space for Category-Level 6D Object Pose and Size Estimation (CVPR’19 Oral)

[2] Category-Level Articulated Object Pose Estimation (CVPR’20 oral)

[3] CAPTRA: Category-level Pose Tracking for Rigid and Articulated Objects from Point Clouds(ICCV‘21 oral)

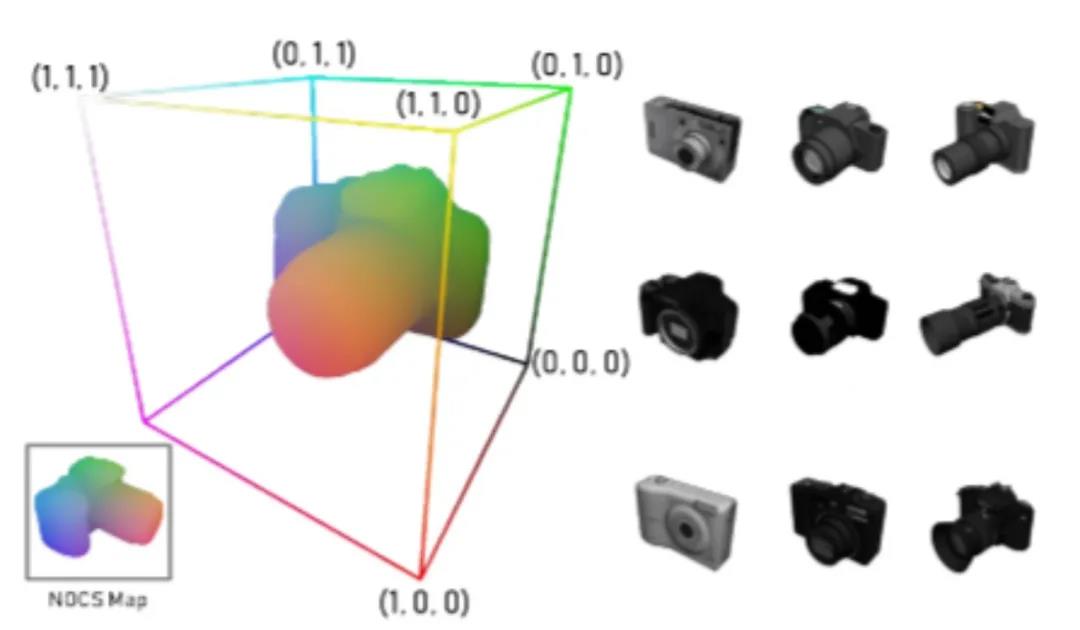

1.NOCS:从Instance到Category的基石

在提纲部分,我们提到过,传统的Instance-level的位姿估计需要Object确切的CAD模型,具有很强的局限性。为了解决这个问题,处理给定类别中不同且不可见的对象实例,定义一个类别内不同的Object的关键几何特征,王鹤博士对Object引入了规范化的坐标空间NOCS(Normalized Object Coordinate Space),如下图所示。

NOCS分三步对类中的每一个物体做规则化:

1. align,将物体边框与正方体框对齐

2. zero-center,将物体中心放置于正方体中心

3. normalize scales,将物体的尺度放缩为对角线长度的倒数,使得正方体框的边长为1

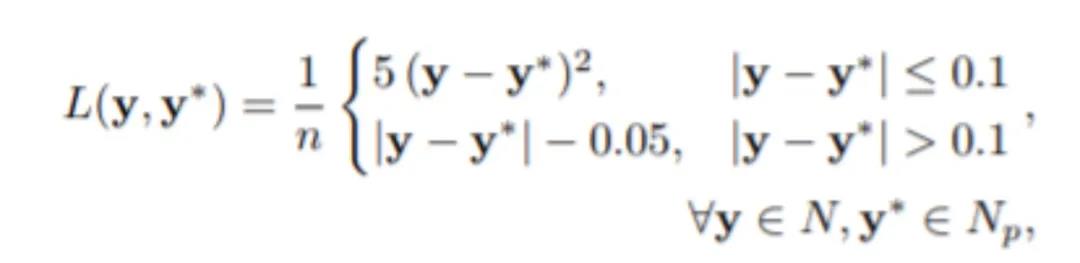

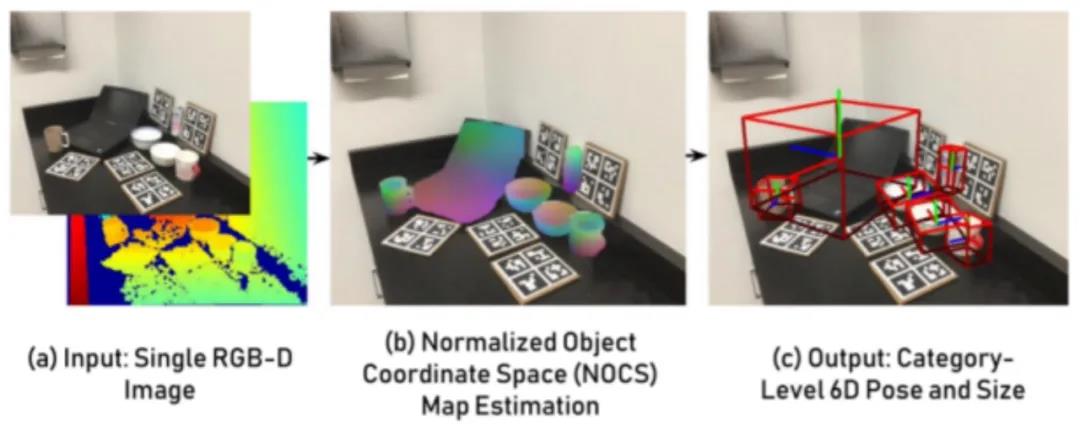

这样,NOCS创造了一个利于网络学习的表达式,然后,就可以用RGB-D图像直接训练神经网络。CNN预测了Class label,Instance Mask和NOCS Map,Instance Mask和NOCS Map通过输入的Depth图像做pose fitting得到估计的6DOf Pose和Scale。在训练数据中,ground truth标注了每个图像的NOCS Map的像素值,通过监督网络预测的NOCS Map的像素值与ground truth的损失函数来训练整个网络,损失函数的定义如下:

其中,n是网络中ROI-align区域内的像素数,y是ground truth中图像的NOCS Map的像素值,y*是网络预测的NOCS Map的像素值。

训练过程如下图所示:

大量的实验表明,NOCS具有较好的鲁棒性,能够估计真实环境中物体实例的位姿和大小,同时在标准的6D位姿估计基准上也取得了最好的表现。

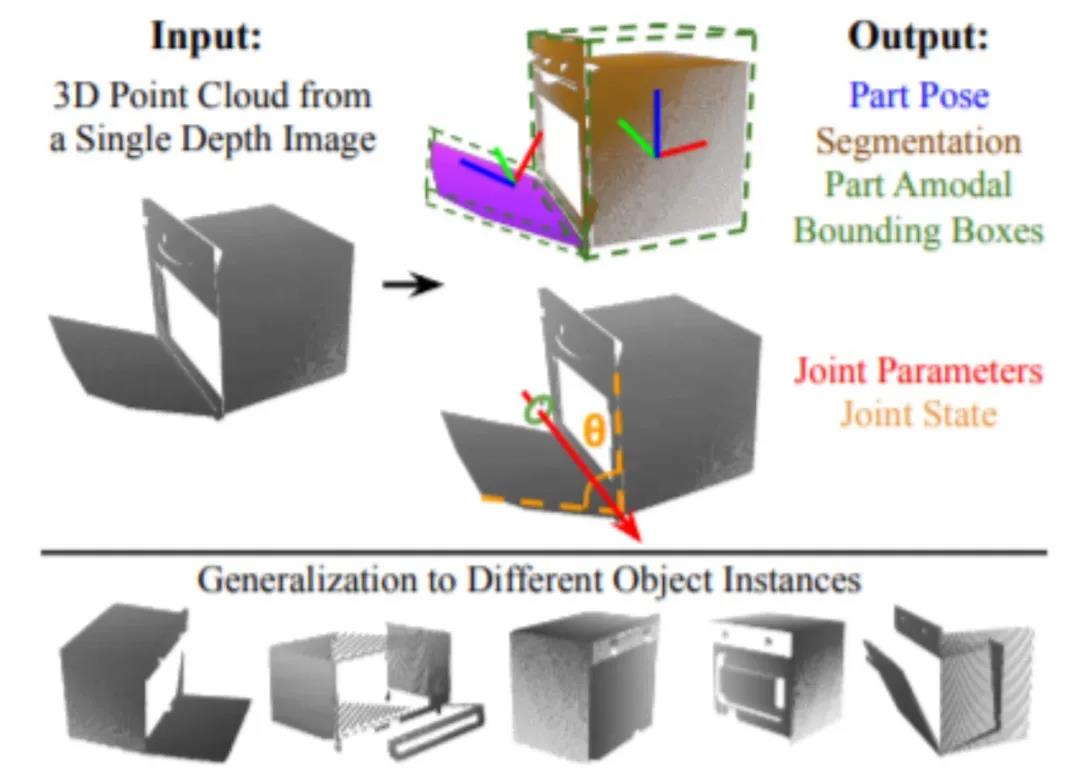

2.ANCSH: 从刚体到关节类物体

相较于刚体,关节类物体的组成更为复杂。关节类物体通过关节相连的每一个部分都可以看作是一个单独的物体,但每一个部分之间又存在着制约关系,王鹤博士的第二篇论文解决了仅利用深度深度图像对关节目标进行类别级位姿估计的问题。

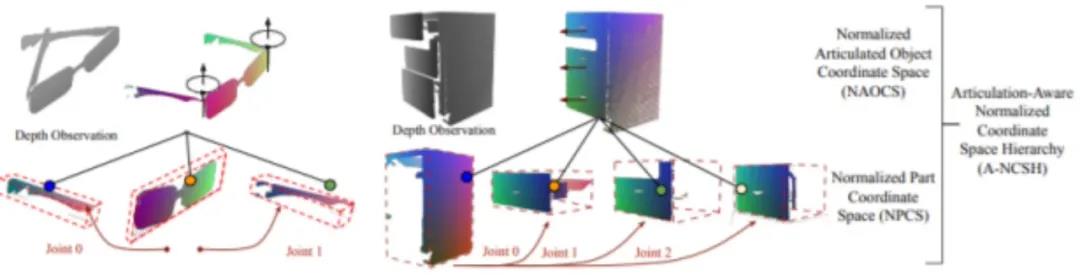

第一个研究工作NOCS为同一类的物体给出了规则化的方法,通过使用NOCS到相机空间的相似变换来定义每个object的pose和scale,但是对于关节类物体(铰接物体),更需要关注的是每个独立部件和关节的姿态以及状态,这是NOCS无法做到的。因此,在NOCS的基础上,王鹤博士提出了一种新的方法,他在引入了一个two-level的规则化方法ANCSH,在root-level,使用NAOCS提供一个object-level的规范化框架,具有规范化的位姿,大小和关节。在leaf-level引入NPCS,作为part-level,为关节体的每一个部分做出规范化。如下图所示,以眼镜为例,NAOCS对眼睛整体做规范化,而NPCS对眼镜的每一部分做规范化。

利用NAOCS,可以更方便地预测关节体转轴的方向和关节的参数;利用NPCS,可以定义部件的位姿和比例从NPCS到相机空间的转换,有助于同一类内部物体的泛化能力。

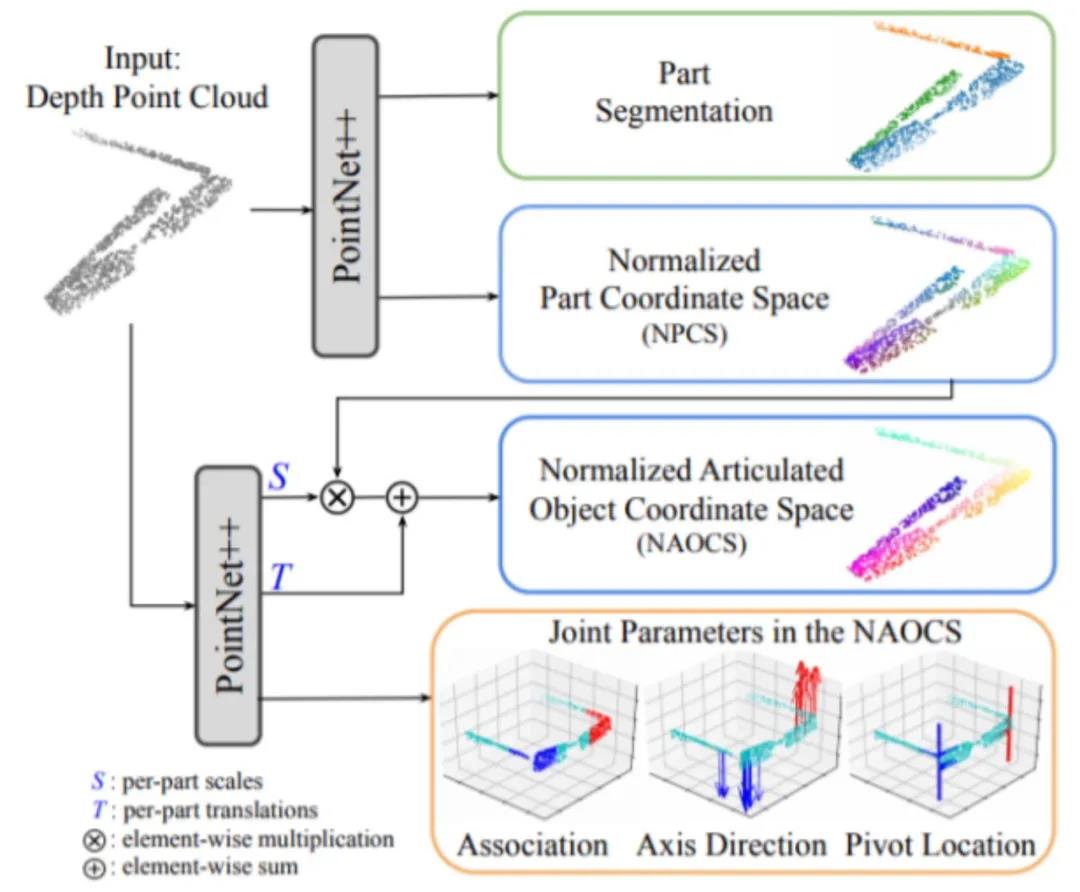

在训练过程中,使用两个PointNet来预测物体的ANCSH表示,包括关节体部分的分割和每个部分的NPCS表示的预测以及每个NPCS到NAOCS的转换(1Dof Scale和3Dof Translation)。这样的网络结构能最好的利用转轴和部分之间的一致性制约条件。

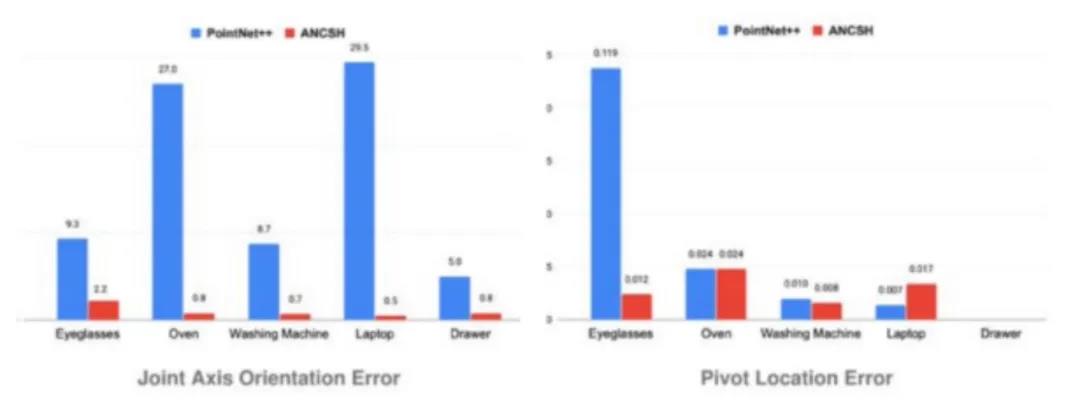

通过大量实验证明,王鹤博士的ANCSH在关节体的预测上取得的良好的预测结果。由于在关节体上的预测为首次,没有baesline可以作为比较。因此,在对比实验中,王鹤博士通过对比单独使用PointNet和联合PointNet ANCSH的方法,确定了ANCSH规范化方法的巨大作用。实验结果如下图所示,数值代表预测的error。使用ANCSH规范化后的error明显更小。

3.CAPTRA:从单帧的Pose Estimation到连续视频的Pose Tracking

前述的两个研究完成的都是单帧的位姿估计,但现实中需要从连续的运动中进行位姿追踪的预测。因此,王鹤博士在前面的category-level的基础上提出了CAPTRA,从3D点云中学习pose tracking。

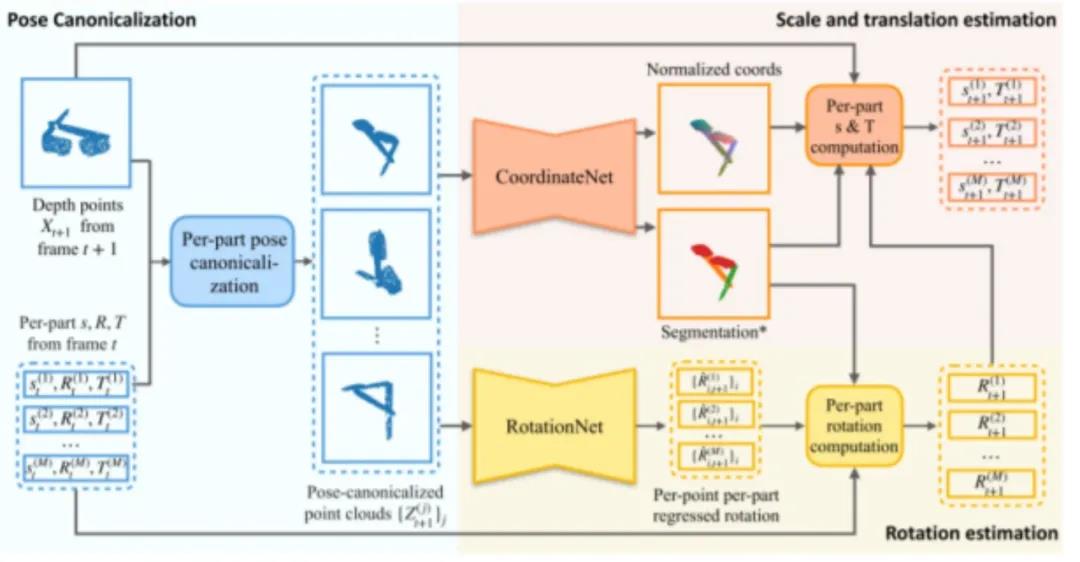

不同于NOCS和ANCSH,CAPTRA估计的是连续的9Dof Pose,包括6Dof Pose和3Dof Bounding Box,通过给定当前帧的3D点云和上一帧估计的9Dof Pose,CAPTRA输出当前帧9Dof Pose的估计。整个Pipeline由3部分组成:Pose Canonicalization Module,RotationNet和CoordinateNet。

Pose Canonicalization Module与前面的NOCS和ANCSH的规范化思想一致,用于规范Pose的表示方法。RotationNet用于直接估计相邻帧之间物体旋转的变量,由于相邻帧之间物体旋转变量较小,因此可以选用RotationNet直接预测。CoordinateNet用于预测标准化坐标和分割的模块,实现3D尺寸和平移的解析计算。整体的训练过程如下:

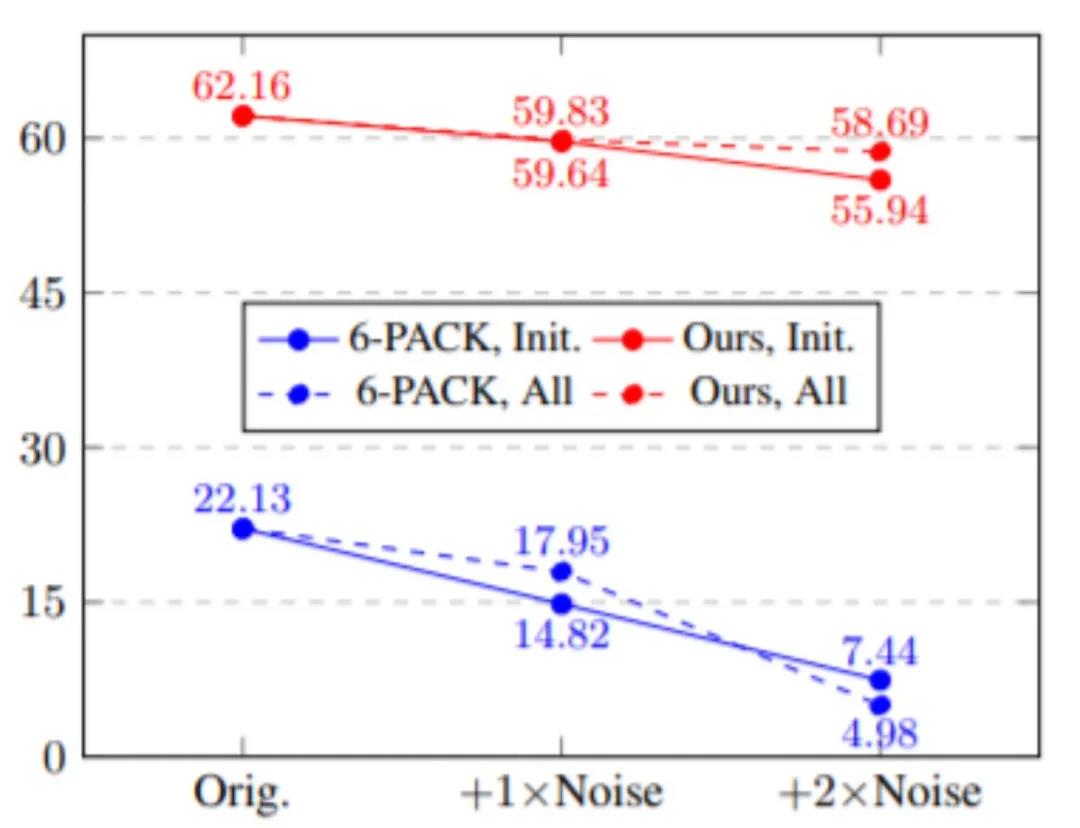

实验表明,王鹤博士的CAPTRA在连续位姿预测中取得了目前最好的表现,尤其CAPTRA具有非常好的鲁棒性,在有噪音条件下仍然能有非常高的准确性。

回顾与展望

王鹤博士通过引入NOCS、ANCSH等规范化方法巧妙地将六维位姿的估计和追踪从Instance-level引入了Category-level,又利用了SE(3) Equivariance网络将自监督训练的方式引入了位姿估计和追踪领域。在talk结束时,王鹤博士向我们展示了他未来的研究方向:object pose and human hand pose trajectory,希望能够真正地实现可泛化的位姿估计与追踪的机器人视觉系统。

精彩回顾

关注AIR公众号并回复“六维位姿”

打包下载王鹤教授讲座论文合集

撰文 / 郑宇鹏

编辑排版 / 魏欣葳

校对责编 / 黄妍

精彩视频回顾及完整版PPT下载,请点击:

AIR DISCOVER|王鹤:六维位姿估计和追踪