在未来的工作中,我们希望能够更加细粒度、层次化地将知识引入模型中,加强知识获取、表示和指导三类任务间的联系,构建更具知识性和可解释性的自然语言处理模型。

——刘知远

活动概况

8月18日下午,第七期AIR学术沙龙在清华大学智能产业研究院(AIR)图灵报告厅如期举行。本期活动荣幸邀请到了清华大学计算机系副教授刘知远,为我们线上作题为《知识指导的预训练语言模型》的报告。

本次讲座由清华大学智能产业研究院(AIR)副院长刘洋教授主持,并在清华大学智能产业研究院(AIR)微信视频号、哔哩哔哩进行双平台同步直播。由于疫情原因本次活动为全线上模式,全网直播观看人数约5800人次。

报告内容

近年来,深度学习方法已经成为了自然语言处理领域常用的关键技术,而BERT、GPT等预训练语言模型更显著提升了自然语言处理的整体性能。然而,以预训练模型为代表的深度学习方法仍面临着可解释性不强,鲁棒性差等问题。如何将人类所掌握的大量先验知识融入模型中,进一步提升模型性能,是当前自然语言处理领域一类关键的研究方向。刘知远老师在本次报告中系统地讲述了知识指导的预训练语言模型的最近进展与未来趋势。

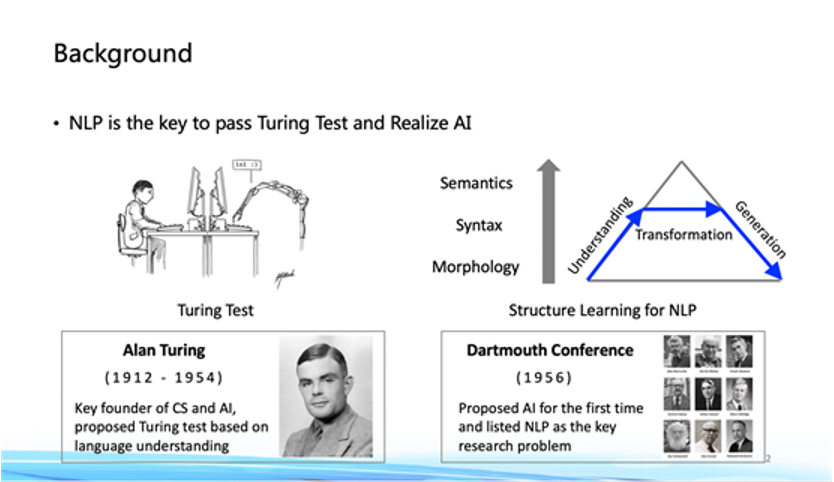

自然语言处理是完成图灵测试和实现人工智能的关键

自然语言处理是完成图灵测试和实现人工智能的关键

自然语言处理的主要目标在于让计算机能够理解并使用人类语言。早在1950年,阿兰·图灵就曾提出著名的思想实验——图灵测试,即让受试者判断与之交流的是人还是机器,以考量“机器能否像人类一样思考”,而图灵测试的方式即是通过自然语言交互来进行的。想要完成复杂、深层次的自然语言理解,需要更丰富的先验知识储备。

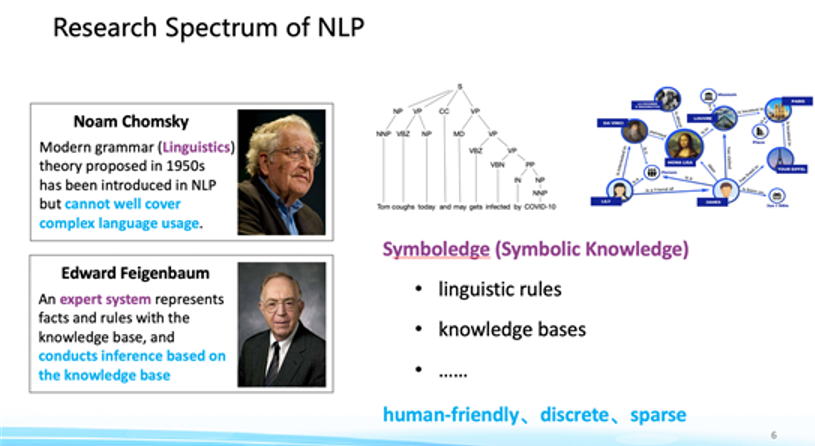

Symboledge:符号化知识

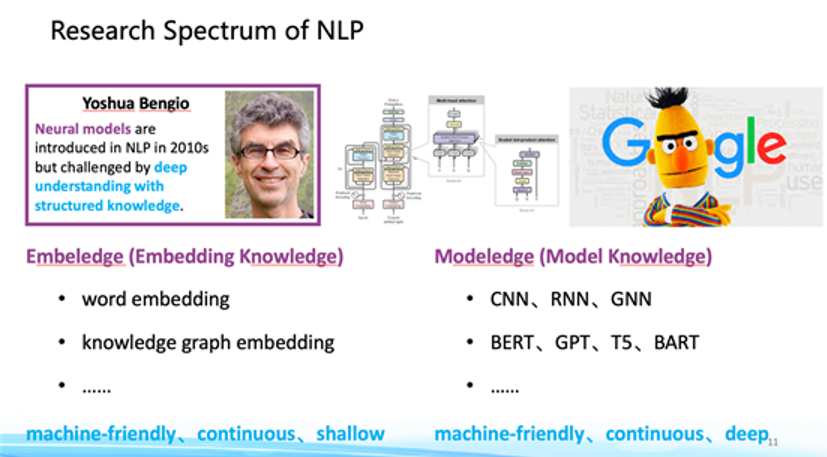

早期的NLP研究工作通过引入句法规则、知识库来符号化地引入知识。符号化的知识更具有可解释性,有利于人类使用者进行理解,但由于其离散性和稀疏性,并不利于计算机对其进行存储和表示。后续的研究提出了一系列的统计机器学习方法,通过模型从大规模数据中学习知识,使之更有利于计算机表示。而近年来,随着数据规模和计算算力的增长,深度学习方法得到了快速的发展。深度学习模型既能够将知识映射到浅层的嵌入表示中,也能够通过高参数量的深层模型学习数据中的知识。

深度学习中的Embeledge与Modeledge

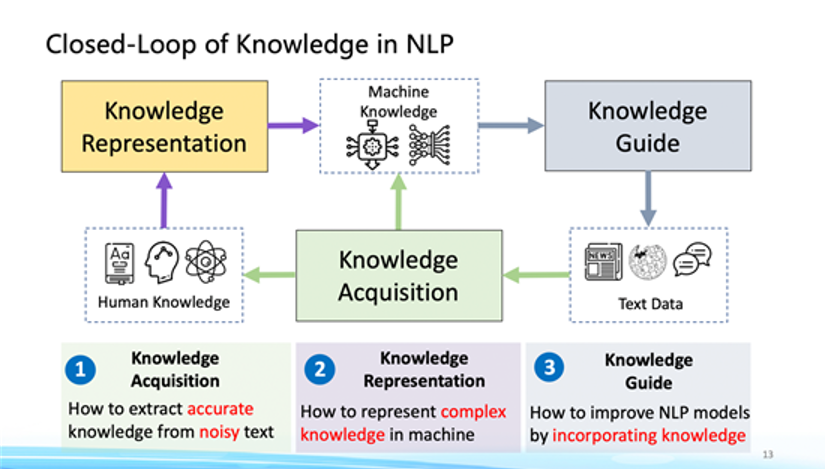

知识的获取、表示与指导形成闭环

整体而言,知识在自然语言处理工作中非常重要,我们可以将自然语言处理看作三类主要任务:即知识的获取、表示与指导。知识获取(knowledge acquisition)关注于从开放性文本中获取结构化知识,要求模型能够从大规模文本信息中去除噪音,并充分利用更大窗口的上下文信息,获取精确有效的知识。知识表示(knowledge representation)的目标在于将结构化的知识转化为对机器更友好的表示,在这一过程中需要充分利用实体间关系,并希望能够将信息映射到统一的表示空间中去。而知识指导(knowledge guide)希望将外部的知识更好地嵌入到模型中,提升模型的性能。

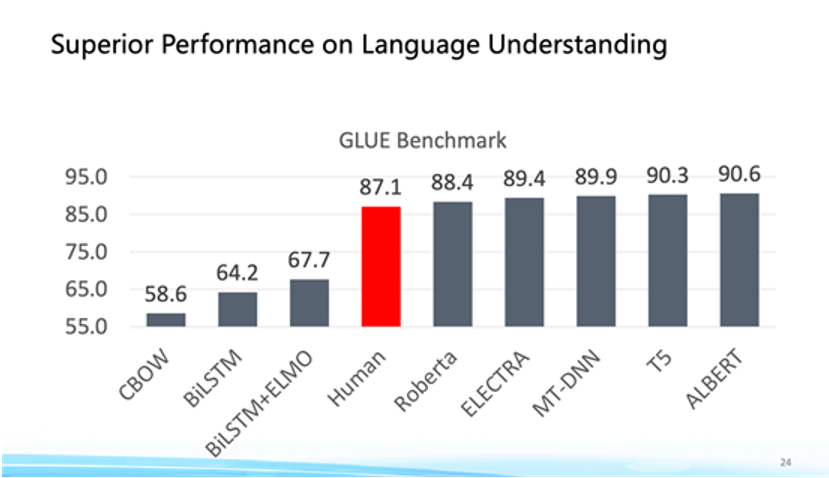

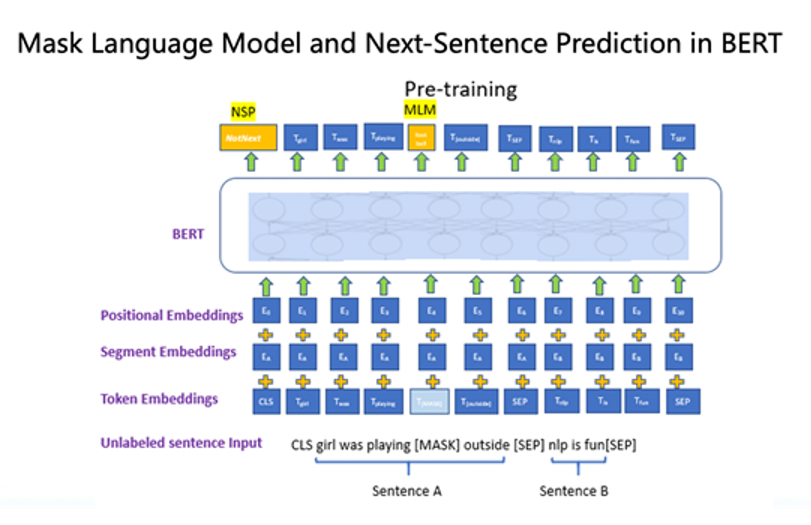

预训练模型在GLUE任务上达到人类水平

自2018年以来,多种预训练语言模型走入到我们的视野中,并在多个自然语言处理任务中取得了显著的成果。与以往的有监督学习相比,预训练方法能够充分利用无标注数据进行训练,使得模型能够获取到相当大规模的训练样本,通过下游任务上的微调即能够获取到很好的效果。当前的预训练语言模型大多以Transformer[1]为骨架,通过提出不同的预训练任务在大规模无标注文本上训练,例如BERT通过MLM和NSP任务使模型学习词级别和句级别的表征,而GPT通过自回归生成任务使模型具备文本生成能力。

BERT中采用MLM和NSP任务学习词句表征

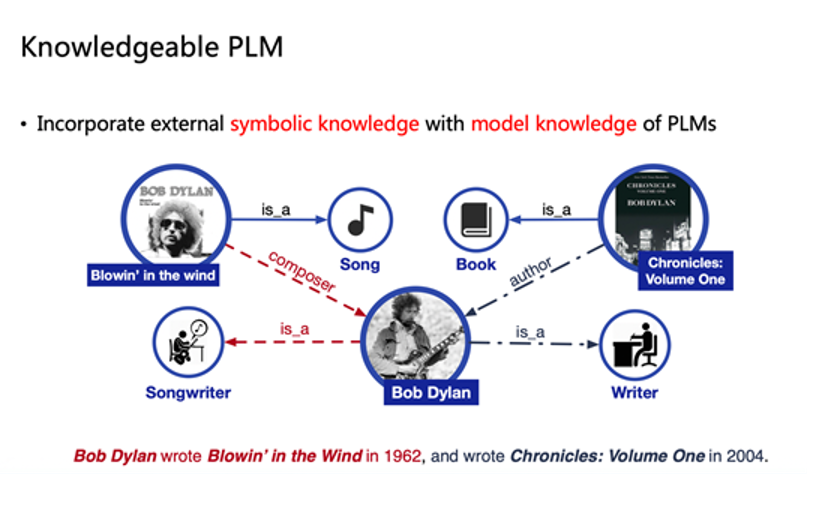

将符号化知识嵌入到模型中

预训练模型能够通过大规模数据的学习取得优越的成效,那么我们能否将知识图谱中的符号化先验知识嵌入到预训练模型中,来进一步提升模型的性能呢?当前的研究工作中对这一问题有三类努力的方向,即从模型输入、训练任务和中间架构三个角度来将知识融入模型中。

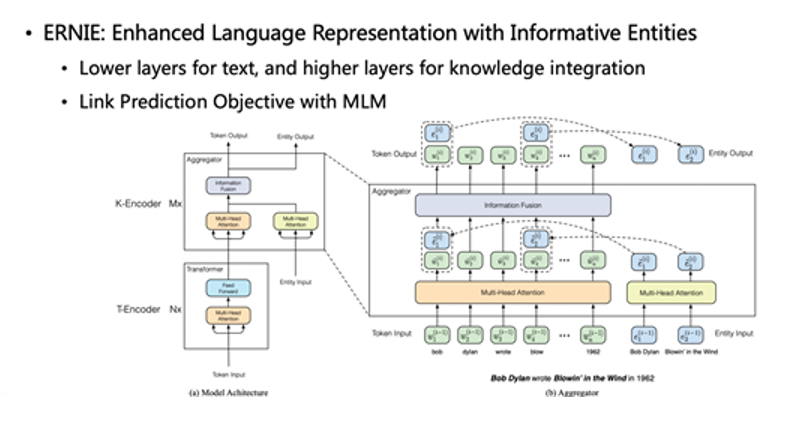

ERNIE架构

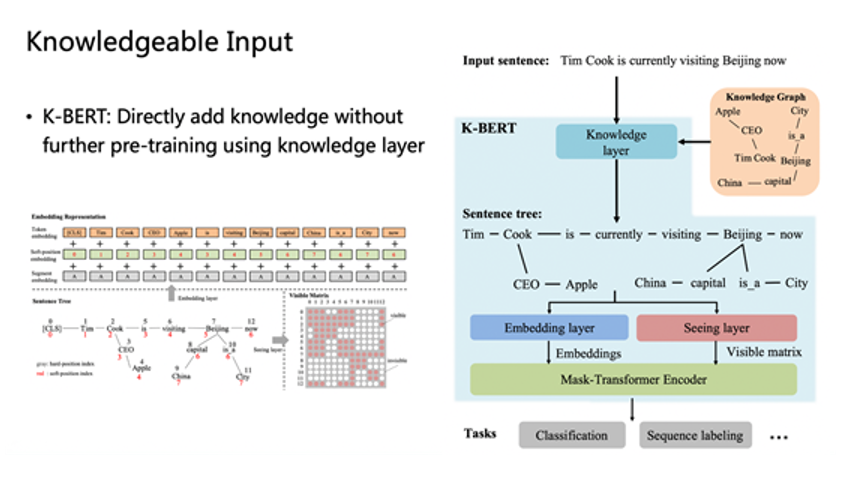

K-BERT架构

从模型输入的角度,可以将相关的外部信息与原数据一同输入到模型中,起到数据增强的效果。以ERNIE[2]为例,这篇工作中将实体在知识图谱中的嵌入表示与文本表示均输入到模型中,并提供一个额外的训练任务来判断文本与实体间的关联关系。从效果上看,引入的图谱知识有助于模型在实体分类、关系抽取等相关任务中取得更好的效果。而K-BERT[3]模型将实体间关系的三元组以树状形式嵌入到文本中作为模型输入,以提供更多的信息。

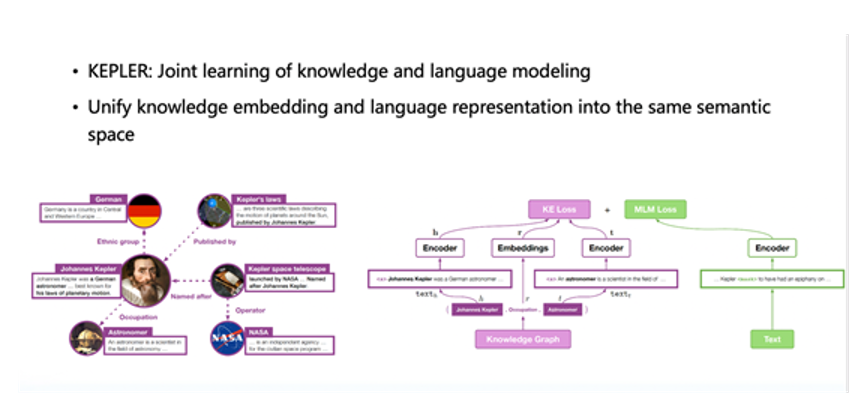

KEPLER架构

而从模型输出的角度,可以通过引入额外的知识相关预训练任务来帮助模型学习知识。KEPLER[4]工作中引入了知识图谱嵌入任务,对于每个关系三元组中的头实体h,关系r,尾实体t,通过引入h r~t的训练任务来约束模型学习实体间关系;而CorefBERT[5]模型通过判断共指关系来学习知识。

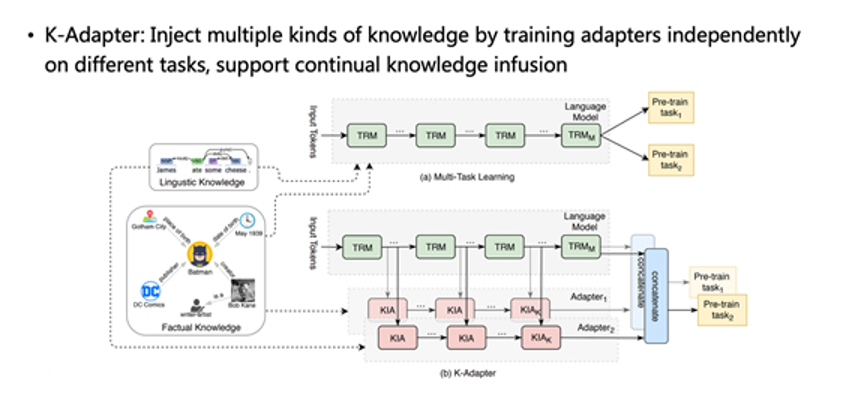

K-Adapter架构

从模型架构的角度,我们也可以通过外部知识帮助模型进行架构上的改造。例如K-Adapter[6]工作中对不同的知识训练不同的适配器来对通过外部知识库对模型进行调节。

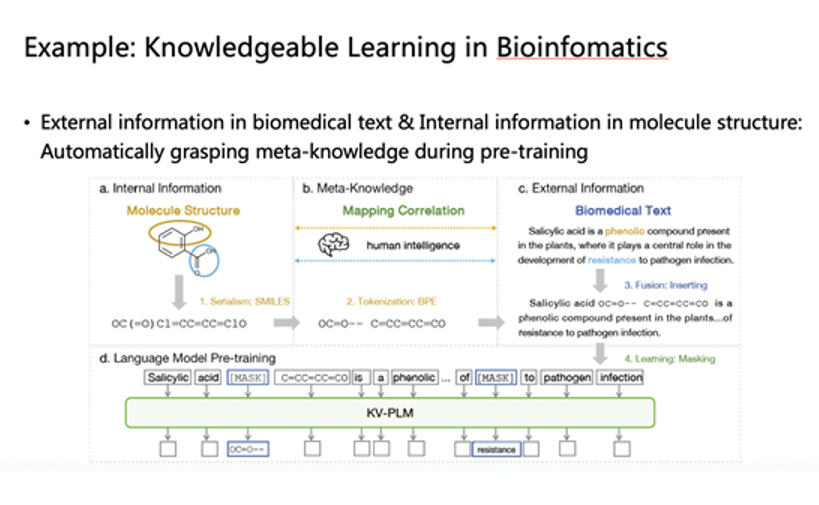

知识指导模型在生物信息学中的应用

知识融合的思想也同样可以应用在领域相关工作中。例如有工作中将分子的SMILES结构化表示与生物学文本信息相结合,构建更统一的模型来学习不同表示形式下实体间的联系。

未来展望

当前,知识指导的预训练方法仍在不断发展与优化。在未来的工作中,我们希望能够更加细粒度、层次化地将知识引入模型中,加强知识获取、表示和指导三类任务间的联系,构建更具知识性和可解释性的自然语言处理模型。

相关资源

THUNLP开源框架:

https://github.com/thunlp

CPM:

CPM-2:

参考书目:

参考文献:

[1]Vaswani, Ashish, NoamShazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, LukaszKaiser, and Illia Polosukhin. Attention is All You Need. NIPS 2017.

[2]Zhengyan Zhang,Xu Han, Zhiyuan Liu, Xin Jiang, Maosong Sun, Qun Liu. ERNIE: EnhancedLanguage Representation with Informative Entities. ACL 2019.

[3]Weijie Liu, PengZhou, Zhe Zhao, Zhiruo Wang, Qi Ju, Haotang Deng, Ping Wang. K-BERT: EnablingLanguage Representation with Knowledge Graph. AAAI 2020.

[4]Wang et al. KEPLER: AUnified Model for Knowledge Embedding and Pre-trained LanguageRepresentation. To appear at TACL.

[5]Ye et al. CoreferentialReasoning Learning for Language Representation. EMNLP2020.

[6]RuizeWang, Duyu Tang, Nan Duan, Zhongyu Wei, XuanjingHuang, Jianshu ji, Guihong Cao, Daxin Jiang, Ming Zhou.K-Adapter: Infusing Knowledge into Pre-Trained Models withAdapters. Arxiv: 2002.01808.

讲者介绍

刘知远,清华大学计算机系副教授。主要研究方向为自然语言处理。2011年获得清华大学博士学位,已在人工智能著名国际期刊和会议发表论文100余篇,Google Scholar统计引用超过15,000次。曾获教育部自然科学一等奖(第2完成人)、中国中文信息学会钱伟长中文信息处理科学技术奖一等奖(第2完成人)、中国中文信息学会汉王青年创新奖,入选国家万人计划青年拔尖人才、北京智源研究院青年科学家、2020年Elsevier中国高被引学者、中国科学青年人才托举工程。担任中文信息学会青年工作委员会主任,中文信息学会社会媒体处理专委会秘书长,ACL、EMNLP、WWW、CIKM、COLING领域主席。

撰文 / 矫瑞 刘聆羽

编辑排版 / 刘聆羽

校对责编 / 黄妍

精彩视频回顾及完整版PPT下载,请点击:

AIR学术沙龙第7期|知识指导的预训练语言模型