7月15日上午,清华大学智能产业研究院(AIR)成功举办以“数据安全与可信AI”为主题的学术工作坊。本次活动由聂再清教授主持,邀请到杨强、宋晓冬、朱军、邰骋、刘洋五位教授带来精彩报告。

杨强:用户隐私,数据孤岛和联邦学习

宋晓冬:打造负责任的数据经济

朱军:理解与评测对抗鲁棒性

邰骋:高性能、保护隐私的生物识别技术

刘洋:联邦学习的技术挑战和应用展望

AIR学术工作坊是AIR定期举办的中大型学术交流研讨活动,旨在提供一个学术交流、思想碰撞的平台,实现信息共享。

当前深度学习网络在面对对抗样本时非常脆弱,因此对抗鲁棒性是安全领域中非常重要的一方面。

—— 朱军

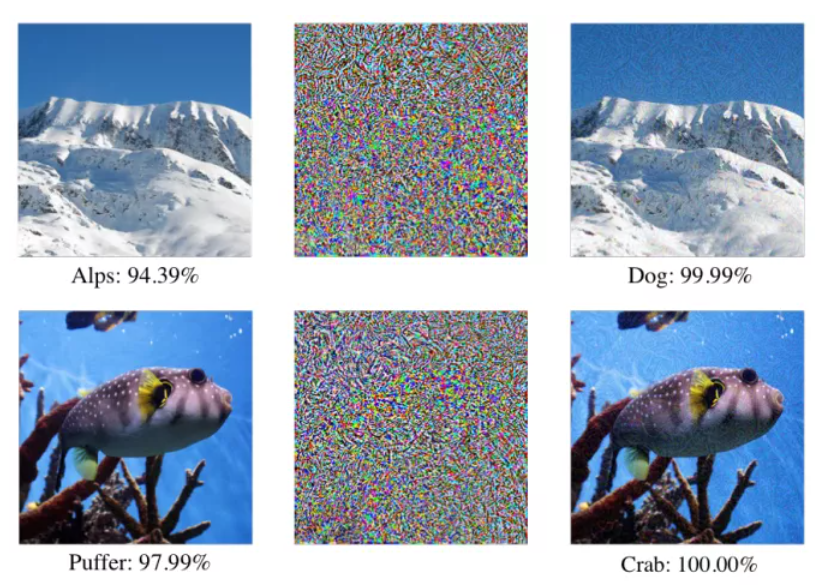

对于一张清晰的图片,深度神经网络可以很好地进行分类,但当对这张图片加入对抗的噪声后,对于人眼来说依然是非常清晰的,但是深度神经网络却会出现非常大的误判。

比如雪山图片在深度神经网络下可以获得非常高的分类置信度,但是在加入对抗的噪声后,图片的基础信息是没有改变的,人眼还是能够非常轻易地识别出雪山,但是深度神经网络却将它误判为狗。

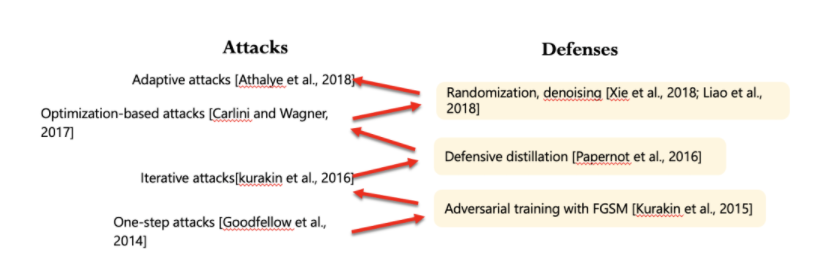

因此对于对抗攻击需要提出相应的防御策略。目前常见的防御策略有如下几种:鲁棒训练、输入形变、随机处理、模型集成、可验证防御等。

在介绍完对抗攻防的基础定义目前的发展状况后,朱老师为我们介绍了他们团队最近的一些工作。

1.对抗鲁棒性交叉熵损失函数的再思考

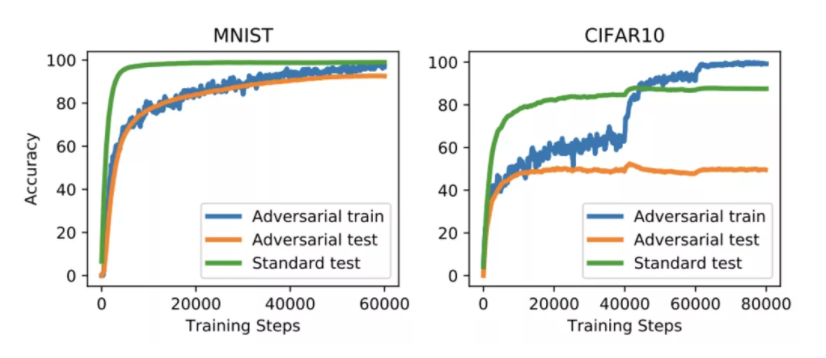

想要获得较好的对抗鲁棒性需要样本的复杂度足够高,但是当前的数据集并不都能满足这个要求,MNIST这种简单的数据集能够满足这个要求,但是像CIFAR10这种稍微复杂一些的数据集就无法满足这个要求。

对于这个问题,目前常用的方式是引入额外的标记数据和非标记数据。但是当无法获得额外的数据的时候,该怎么处理这个问题呢?

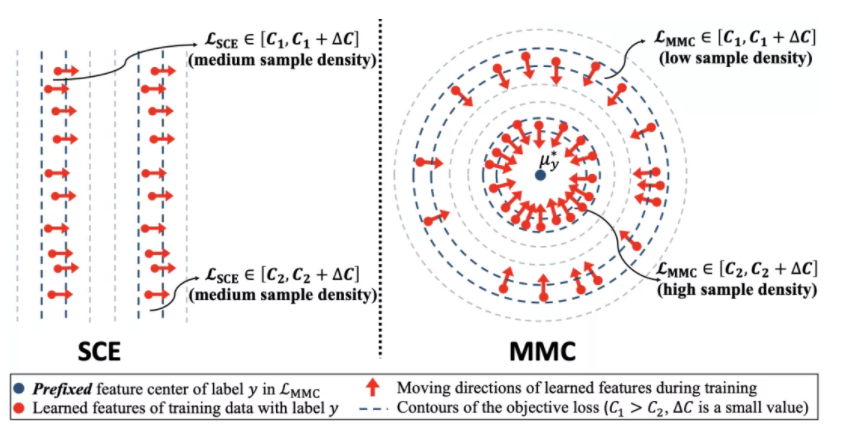

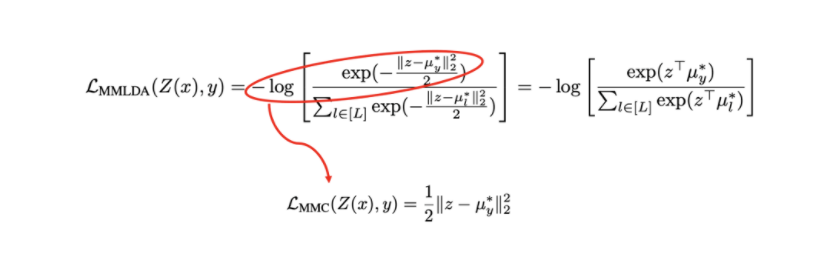

朱老师的团队提出了提高样本密度的方式来解决这个问题。样本密度指的是样本在特征空间中在邻域多寡。

朱老师的团队发现通用的交叉熵损失函数并不能提高样本的密度,因此他们设计出了一种新的损失函数。

这种新的损失函数能够极大地提高样本密度,并且可以提高训练速度。

2.鲁棒深度学习的对抗分布训练

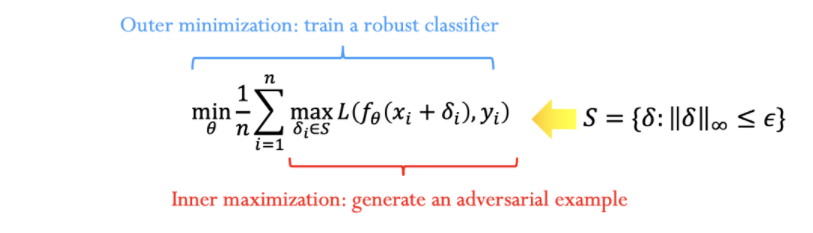

对抗训练一般抽象成一种Minimax的优化问题。

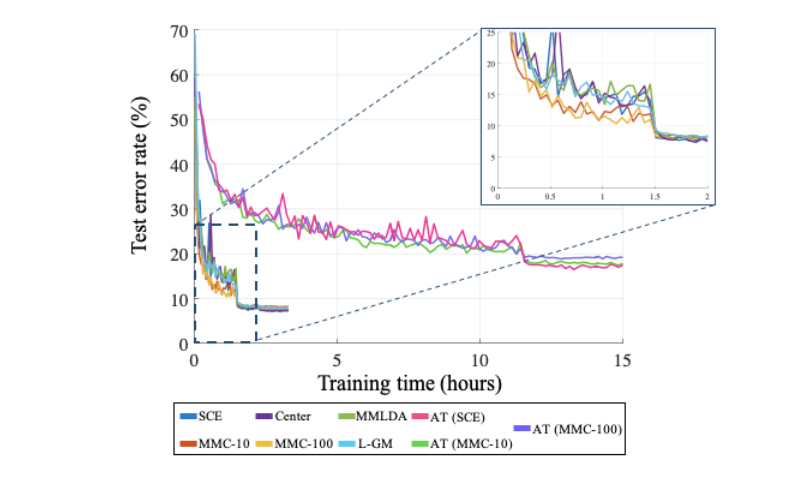

当前基于PGD的对抗训练是一种非常有效的方法,但是它也面对着一些问题。

1)基于PGD的对抗训练相比于传统的训练要慢很多,因此直接应用于ImageNet这样大型的数据集是不可行的。虽然目前有些工作可以让训练速度提高,但是却无法达到相应的精度。

2)目前大部分对抗训练的方法都是基于某种特定的攻击,因此对于不同攻击形式的泛化性比较薄弱。

3)而且训练过程中容易出现过拟合,推理准确度和训练准确度之间有非常大的差距。

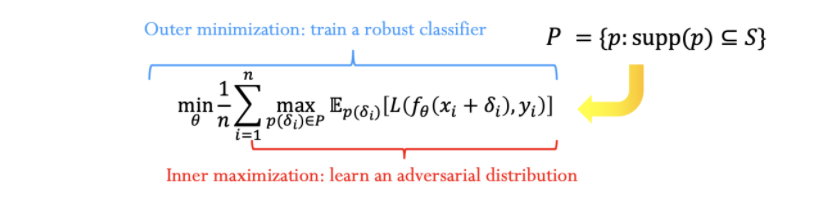

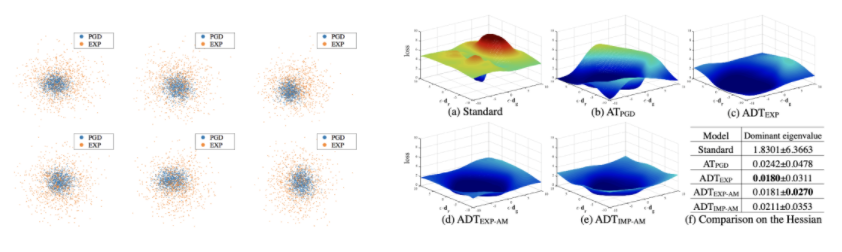

针对上面这些问题,朱老师的团队提出鲁棒深度学习的对抗分布训练,将对抗分布训练定义为一种新的Minimax优化问题

并通过增加特殊的正则项,最终能够达到更好的跨攻击方式的泛化性和更好的模型鲁棒性。

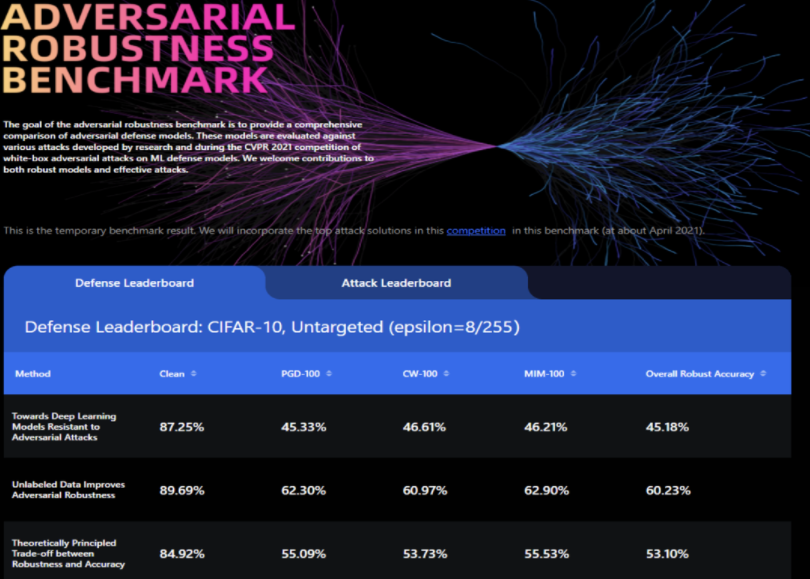

3.图像分类对抗鲁棒性的基准

当前攻防这个领域发展比较迅速,但是不同的攻防之间的该如何进行客观的评价与比较是一个难题。

朱老师团队开发了Ares (https://github.com/thu-ml/ares),一个聚焦于图像分类对抗鲁棒性评测的研究平台。目前这个平台已经支持来着各种威胁模型的不同攻击方法,并且提供各种预训练的基础模型和一些高效好用的工具。

朱老师团队已经公开发布了adv-bench基准,研究人员可以基于这个平台对各种不同的攻防方法进行更好的评价和比较。

讲者介绍

朱军,清华大学计算机系教授、北京智源人工智能研究院首席科学家,曾任卡内基梅隆大学兼职教授。主要从事机器学习研究,担任IEEE TPAMI的副主编、AI编委,担任ICML、NeurIPS等领域主席20余次。获科学探索奖、CCF自然科学一等奖等,入选万人计划领军人才、MIT TR35中国先锋者以及IEEE“AI’s 10 to Watch”,获多项国际竞赛冠军和最佳论文奖。

撰文 / 杨泽邦

编辑排版 / 刘聆羽

校对责编 / 黄妍

精彩视频回顾及完整版PPT下载,请点击:

朱军丨深度学习中对抗鲁棒性的理解与评测