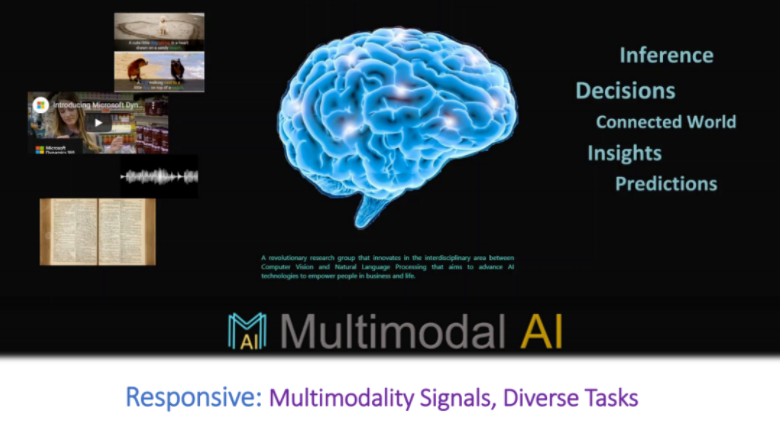

多模态AI的目标是使计算机像人脑一样,能够同时理解自然界中的多模态数据信号(如语音、文本、图片、视频等),并完成类人脑的智能任务,比如推断、预测、决策等。

活动概况

7月7日晚,清华大学智能产业研究院首席研究员、国强教授刘菁菁为U&AI Camp带来题为《How Multimodal AI Empowers People》公开课。

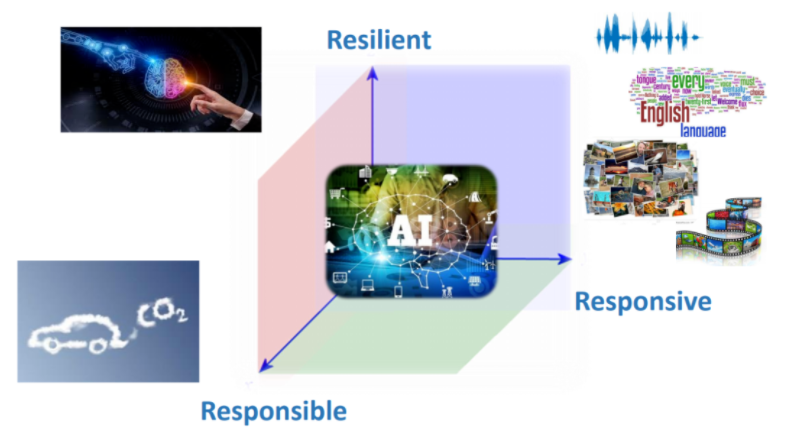

课程围绕多模态人工智能以及其如何赋能人类来展开,重点介绍视觉和语言多模态预训练,并解析新时代下机器学习的重要支柱——自监督学习的概念。通过介绍人工智能的Responsive(积极响应)、Resilient(适应发展)、Responsible(坚守价值)特征,来探讨如何发展负责任的人工智能,促进实现可持续发展目标。

“U&AI Camp | AI for SDGs Youth Bootcamp——AI促进可持续发展青年创造营” 由清华大学人工智能国际治理研究院(I-AIIG)主办,联合国开发计划署(UNDP)支持、多家人工智能学术机构协办。

讲者介绍

刘菁菁教授,清华大学智能产业研究院首席研究员、国强教授,美国麻省理工学院计算机科学博士,英国剑桥大学MBA,曾任美国微软资深首席研究部门经理,带领科研团队在视觉加语言多模态机器学习、自然语言处理等人工智能领域开展科学研究。加入美国微软研究院之前,刘菁菁博士曾任麻省理工学院计算机科学与人工智能实验室 (MIT CSAIL) 研究科学家,专注语音对话系统学术研究。

报告内容

在过去的70年里,人工智能的发展曲折起伏。上世纪50年代,艾伦·图灵提出“机器能否思考”的问题,引发了人们关于机器智能的思考;1956年的达特茅斯会议上,“人工智能”的概念被正式提出,推动了人工智能研究的第一波浪潮;到了上世纪70~80年代,由于诸多问题短时间内无法得到解决,人工智能的发展迎来第一个寒冬;2012年至今,随着深度学习的兴起,多项突破性成果诞生,人工智能进入蓬勃发展期。

在今天,人工智能已经改变了人类生活的方方面面。AIR院长张亚勤院士曾提出人工智能的发展要秉持3R原则:积极响应(Responsive)、适应发展(Resilient)、坚守价值(Responsible)。本次演讲中,刘菁菁教授介绍了多模态AI如何从这三个维度为人类社会赋能。

什么是多模态AI

人工智能技术的应用举例:

AI帮助视觉障碍人士:利用AI技术,将周围的环境讲述给使用者听,让有视觉障碍的用户“听”到周围的环境;

AI眼镜:结合了眼镜、超声波传感器和GPS技术,可以给使用者提供方向、面前物体的颜色、前方是否有障碍等信息;

指尖阅读器(MIT Media Lab推出):可以帮助有视觉障碍的人通过手指来进行阅读。

以上所有应用都依赖于多模态AI技术。那么什么是多模态AI?可以将AI模型类比为人类的大脑,多模态AI的目标就是建立一种模型,能够处理、理解自然界中的多模态的信号(如语音、文本、图片、视频),并完成一些智能的任务,比如推断、预测、决策等。在这里我们接触到了人工智能发展3R原则中的的第一个原则:积极响应(Responsive),即我们的技术应该能够处理自然界中的多模态的信号并完成各式各样的任务,进而对人类社会产生帮助。

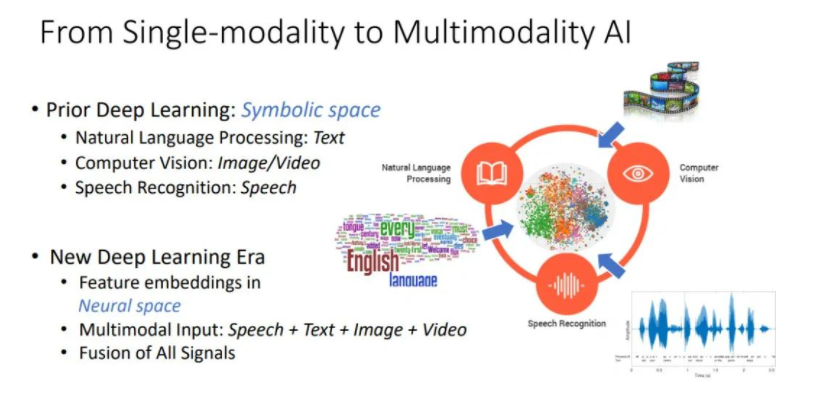

可以客观地说,深度学习给AI世界带来了巨大的变革。在前深度学习时代,语音、自然语言处理、机器视觉领域是严格分开的,他们各自只能聚焦于一些单模态内的问题,比如语音识别、图片分类等。深度学习实现了让AI领域从纯粹的单模态研究向多模态融合研究转变。不同于前深度学习时代使用离散的符号空间(如文本中的token,图片中的pixel等),深度学习时代,所有信号都被编码进一个通用的神经空间(neural space),给多模态信息融合带来可能,从而促进了多模态AI的发展。

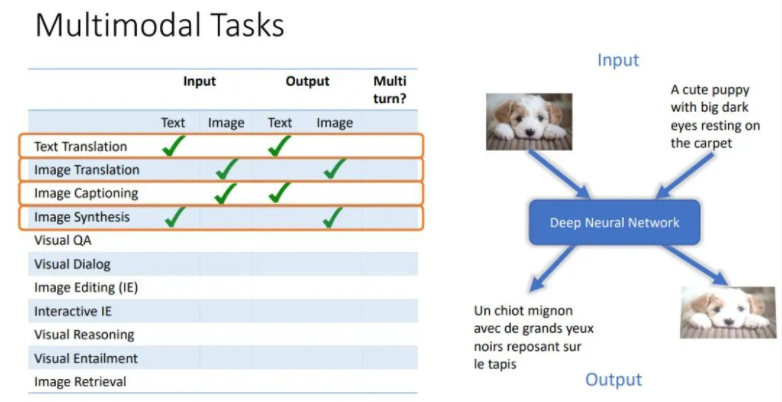

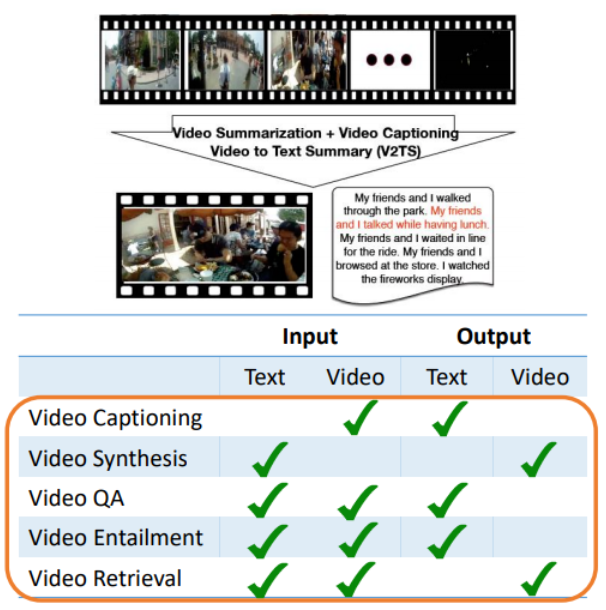

多模态AI子任务

一些多模态任务的示例如下,在多模态任务中,模型的输入和输出可以是多种模态信号的不同组合:

若输入和输出都是文本,是语言单模态任务,典型的任务有机器翻译,模型会将一种语言翻译到另一种语言;

若输入和输出都是图片,是图片翻译任务,例如将一个有色彩的清晰图片转换成模糊的图片或黑白图片;

若输入是图片,输出是文本,这是图像描述(Image Captioning)任务,给定一张图片,模型需要生成对此图片的自然语言描述;

若输入是文本,输出是图片,这是图像生成(Image Synthesis)任务,给定一段文本,模型需要生成符合此文本描述的图片;

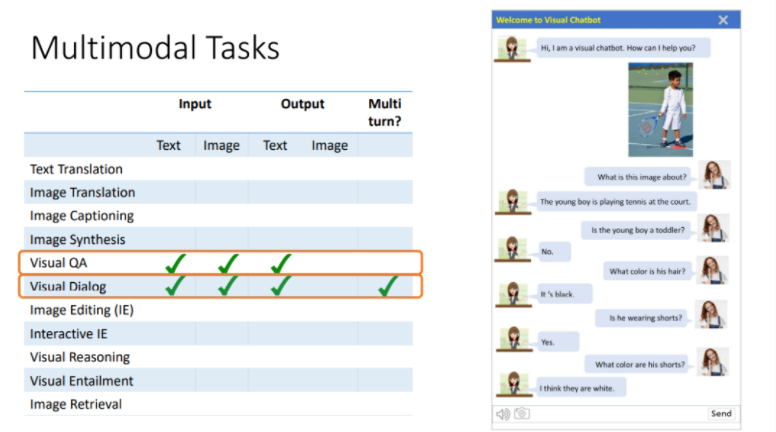

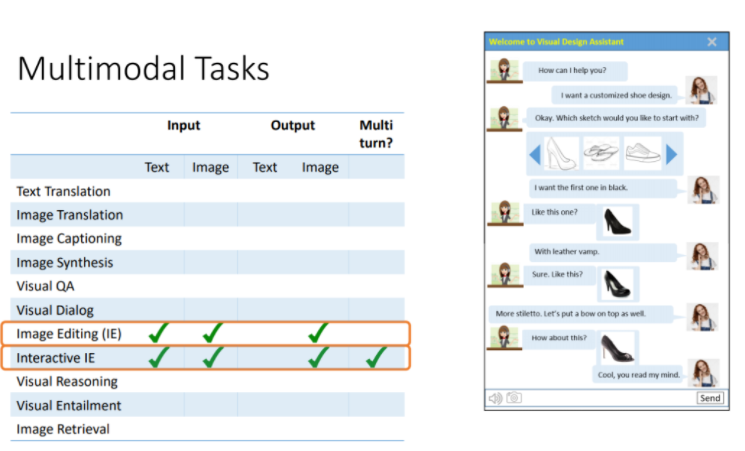

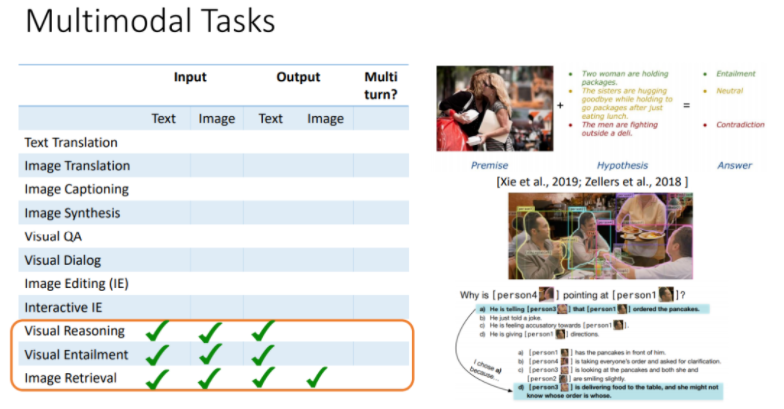

以下任务以文本+图片作为输入:

除此之外,还有Visual Grounding, Vision-Language Navigation等等其他有趣的多模态任务。

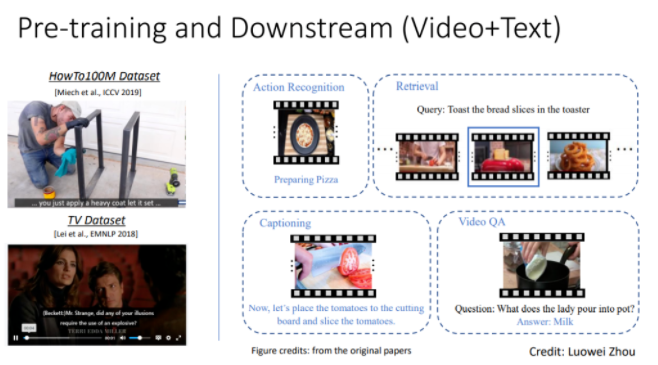

多模态AI是一个非常多元化的领域,任务多种多样,且都十分有趣,世界各地有很多研究者正在进行着很多有趣的研究。以上这些只是在图片+文本领域,对于视频+文本领域,还有如下任务。

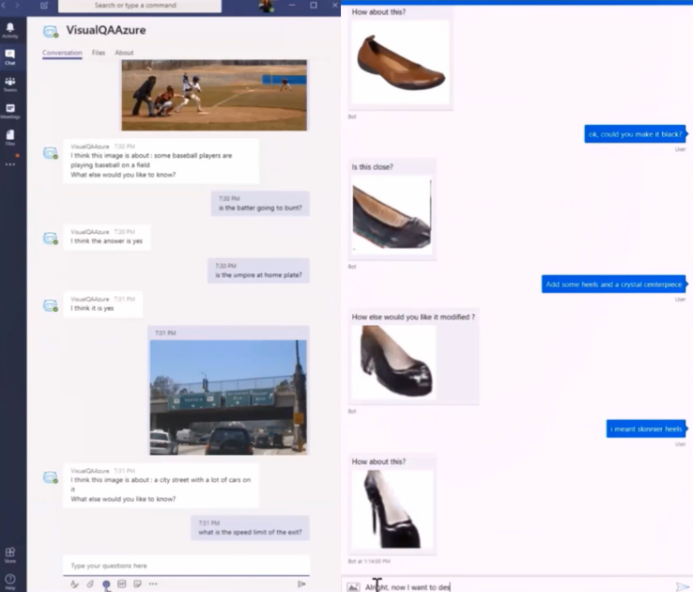

下面是上述多模态任务能构建起的两个实际应用。左图VQA机器人,用户可以上传图片并进行提问,聊天机器人会依据图片回答相关问题并和用户聊天。右图是基于对话的图片编辑机器人,可以通过和用户的交流,跟随用户的指示,产生新的图片或更改之前设计的图片,来帮助用户设计产品:

多模态AI常用技术

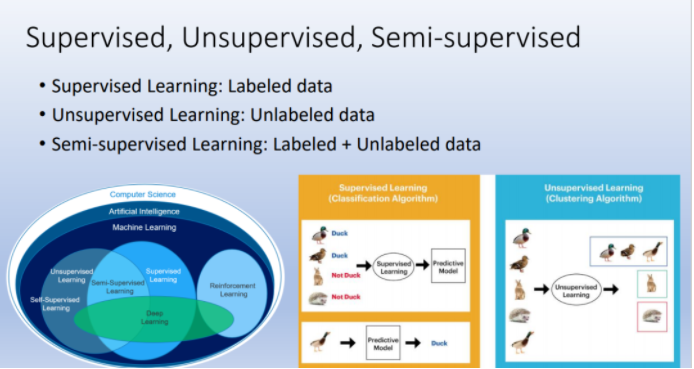

机器学习可分为有监督学习、无监督学习、半监督学习,半监督学习可以看作前两者的折中。

在有监督学习中,我们会给模型有标签的数据,随后模型为每个样本做出预测,并根据样本的标签进行模型优化。例如对于图像分类模型,我们给模型一系列的图片,并告诉他哪些图片是狗,而哪些是猫,随后模型可以从这些有标签的图片中进行学习。之后给定一张新图片,模型可以根据之前学得的结果,对这张图片进行猫狗二分类。

无监督学习指模型从无标签的数据中进行学习。即我们给模型大量的图片,但我们不会告诉他这张图片属于猫和狗中的哪一类,模型需要自己去学习。

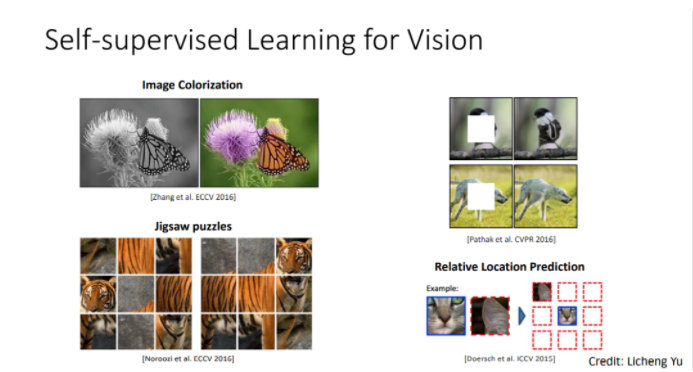

现实中存在的大量数据都是无标签的,获取带标签的数据是昂贵且费时的,因此自监督学习应运而生。自监督学习的主要思想是除了显式的标注,无标签的原始数据本身,也有一些内在的监督信号可以用来训练模型。在计算机视觉领域,通过改变图片样本,比如将有色彩的图片转换成黑白图片,或者遮盖图片的某些区域,或改变图片中各个块的顺序,可以构造出一些人造的标签。有了这些人造的免费标签,我们可以在神经网络上进行训练。自监督学习的关键就是用数据本身和一些人造的标签来训练模型。

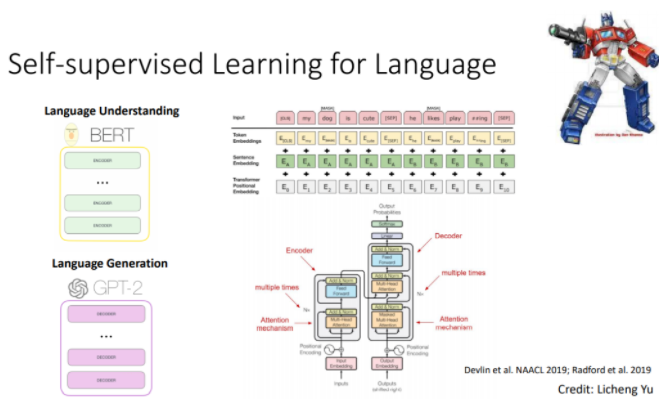

最近自监督学习方法为NLP领域带来了很大的突破,例如BERT和GPT-3模型。这两个模型都是Transformer架构,Transformer是一个非常酷炫且强力的模型结构,最近风靡深度学习领域。大规模模型的预训练可以使用Wikipedia或News copora的免费语料。

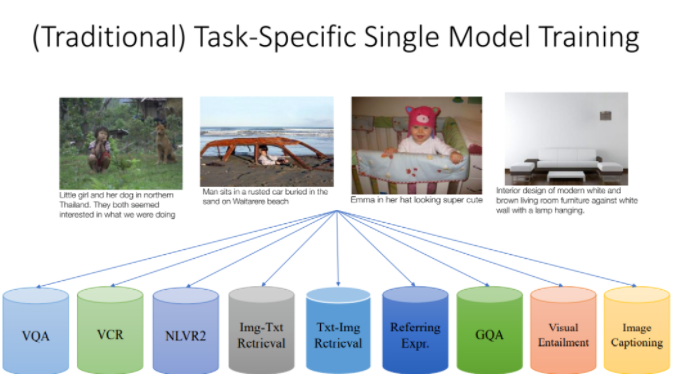

在多模态领域,传统的机器学习的做法是为每个任务设计特定的模型,针对不同任务的模型在模型结构和特征设计方面可能大不相同。

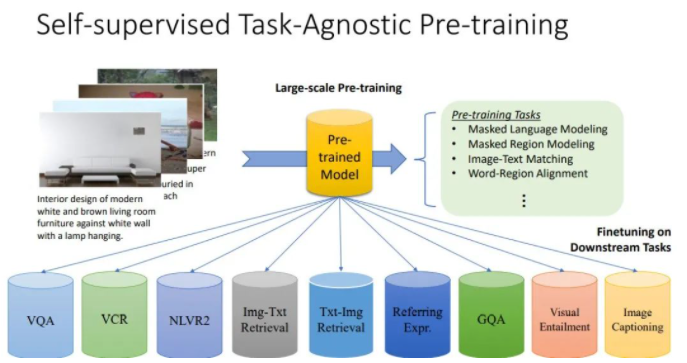

在深度学习时代,我们可以使用自监督学习来预训练一个大规模、Task-Agnostic的模型,而不是设计只针对特定任务的模型。这种通用的模型不显式地针对任何具体任务,但当需要适配到某具体任务时,可以通过微调,将其特化成可以适用于相应任务的特定模型,并取得很好的效果。微调是指,给定预训练好的模型,使用一些迁移学习方法,将模型适配到具体的下游任务中。预训练+微调的范式是目前深度学习领域非常流行的方法,其可以利用大量的数据,以一个更通用、高效的方式,处理各式各样特定的下游任务。

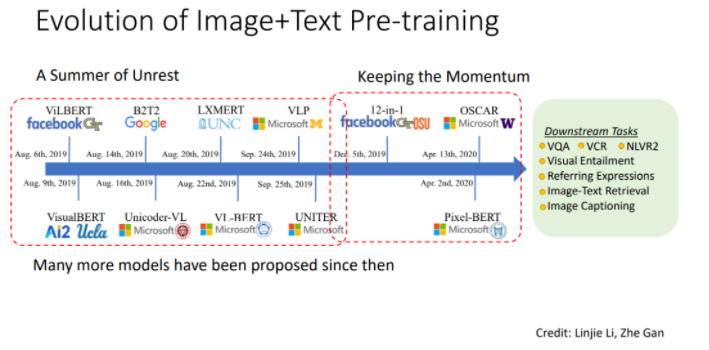

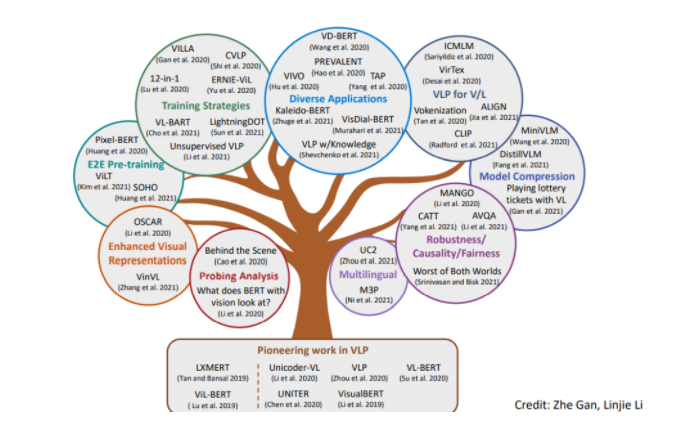

多模态预训练从19年的夏天开始兴起,各种模型如雨后春笋般涌现,如ViLBERT、LXMBERT、UNITER等,他们使用不同的特征提取方法、不同的预训练任务。其中UNITER模型由刘菁菁教授在微软时的团队提出。与此同时,视频+文本预训练领域也在蓬勃发展。

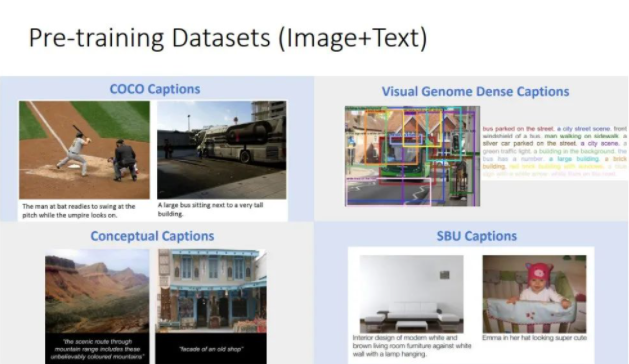

以下是一些预训练中常用的数据集,每一个数据集包含很多的Image-Text pairs,一个Image-Text pair中,文本通常是对图片内容的描述。

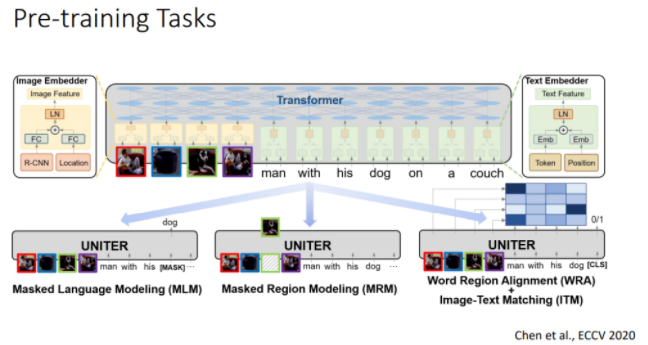

我们通常会设计一些预训练任务来训练模型,以UNITER为例。UNITER是基于Transformer的单流模型。给定一个Image-Text pair,UNITER首先使用图像编码器和Faster R-CNN提取图像中各个区域的特征;随后使用文本编码器,从文本中提取各个token的特征;最后将提取的特征提供给Transformer,并使用一些精心设计的预训练任务来预训练模型。典型的预训练任务有:Masked Language Modeling(预测文本中被遮盖的token),Masked Region Modeling(遮盖图片中的一些区域,训练模型来重构这些区域),Image-Text Matching(判断文本和图片是否匹配)等等。

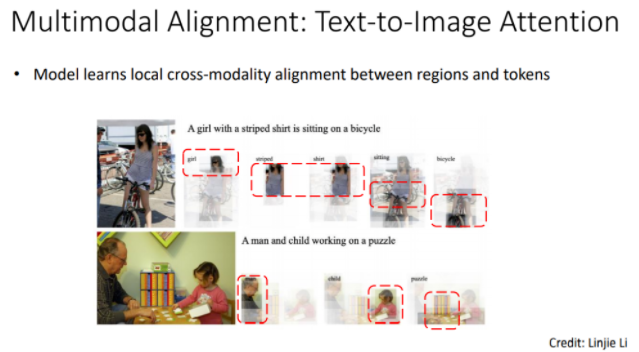

模型预训练的目标是学习不同模态之间的对齐。以下是Text-Image之间互注意力的示例,展示了模型学习到的图片和文本之间的对齐关系。可以明显地观察到,模型能够将图片中特定的区域与文本中相应的部分联系在一起:

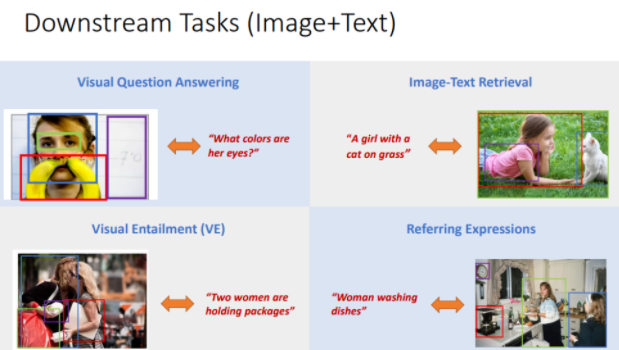

预训练之后,我们可以使用迁移学习,将模型适配到各式各样的下游任务中去。下面列出了一些典型的下游任务:

视频+文本的任务也是类似的处理方式,我们可以用视频+文本数据集(比如HowTo100M,包含100million YouTube视频)来训练模型,下游任务包括Action Recognition等:

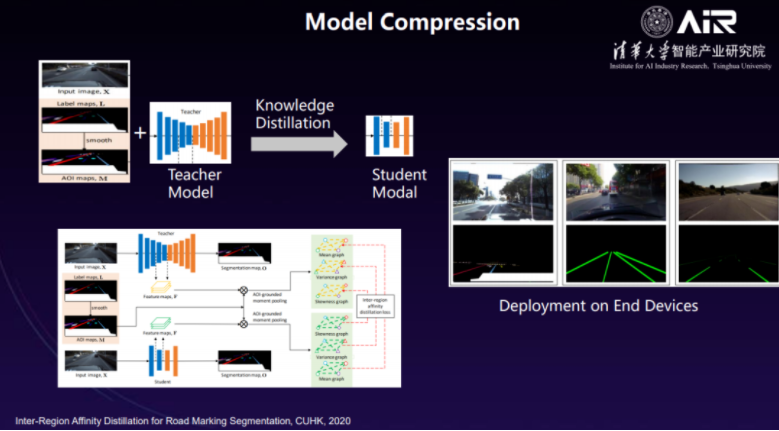

此外,预训练模型还有大量的研究主题,比如训练策略、端到端预训练、模型鲁棒性、模型效率、多语言预训练、探测分析等等。探测分析(AI可解释性)是一个非常有趣的领域,其目标是理解预训练模型的黑盒,深度学习模型就像一个黑盒,我们不知道在现象背后具体是哪些部分在起作用,此领域相关研究可以帮助人们理解AI到底是如何有效地工作的。

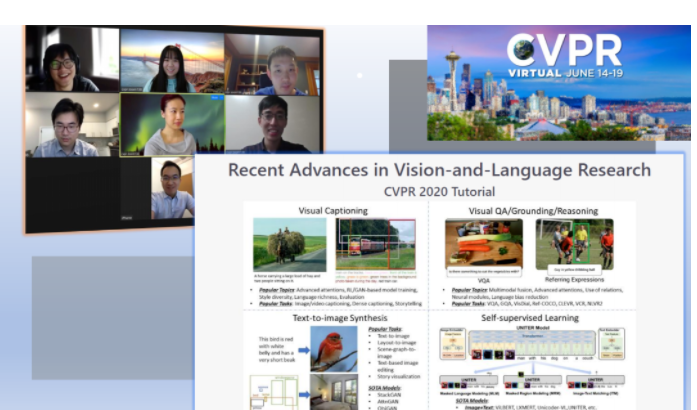

如果大家想更多地了解多模态AI领域,可以参考刘菁菁教授与微软、UCSC等合作者在CVPR 2020和CVPR 2021大会上办的 Tutorial。另外,刘菁菁教授参与了与微软、UNC、UCSC等合作者最新发布的 benchmark,叫做VALUE,其中包含了11个不同的视频+语言理解的任务,比如Video Retrieval、Video QA等。可以从网站上下载相应的数据集,参与性能排行挑战,也可以下载代码库来尝试使用一些基线模型,这是一个能动手入门很好的方法。此外,还可以使用一些现有的预训练模型,并针对某下游任务进行微调,这样可以更直观地感受预训练方法是如何工作的。

以上是对于多模态AI领域的一个高度概览。接下来我们讨论AI发展3R原则中的另外两个原则:

多模态AI赋能智慧交通

多模态AI的一个重要的应用场景是智慧交通。在这个时代,智慧交通领域正以迅猛之势发展。目前工业界的四个发展趋势是:电动化、网联化、共享化、智能化。

我们为什么需要自动驾驶?首先是安全原因,研究表明,超过90%的道路事故是由人为错误引发的,我们希望借助技术手段,帮助人们做出正确决策,减少人为错误,增加交通的安全性;其次是效率,我们都希望每天的通勤时间可以放松地坐着休息,或是从事一些放松惬意的活动,让车辆自己行驶;此外,从经济角度来看,自动驾驶领域存在着巨大的市场,每年可以产生1.5万亿美元的商业价值。

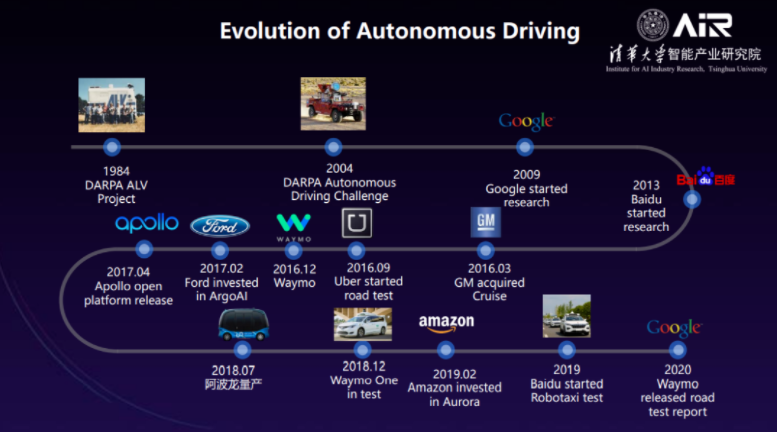

过去的四十年里,人们在自动驾驶领域投入了很多的研究和努力:

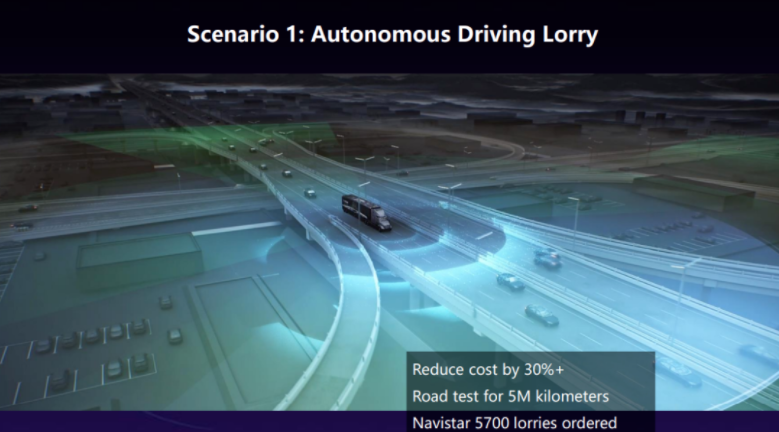

自动驾驶的实际使用案例有自动驾驶货车、校园后勤、矿车等。以自动驾驶货车为例,货车通常需要进行长途的运输和行驶,自动驾驶技术可以帮助减轻驾驶员的负担。

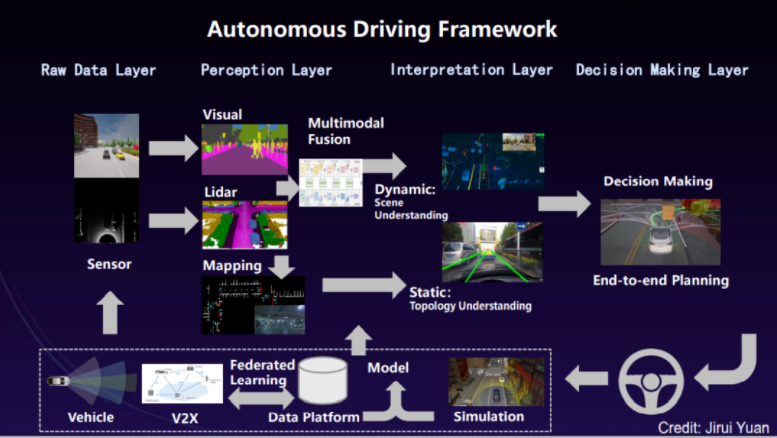

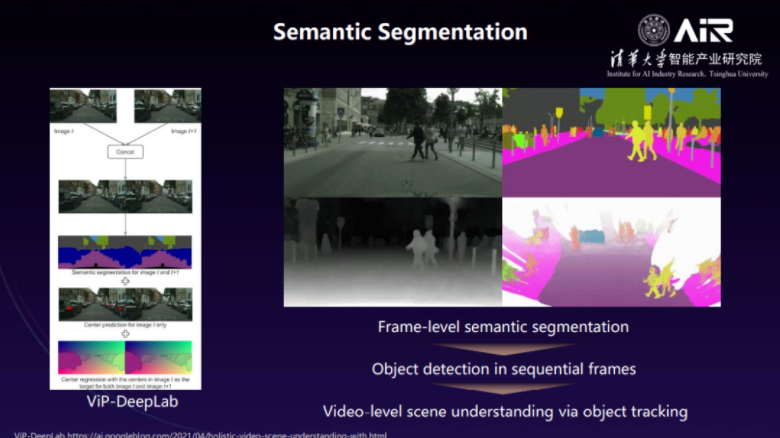

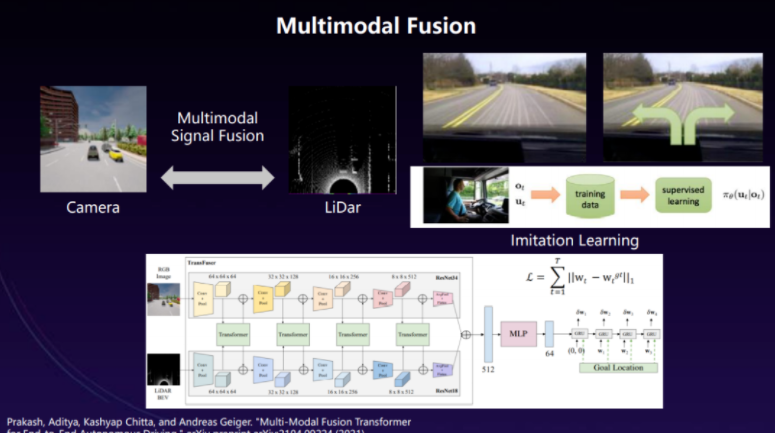

AI是怎样赋能自动驾驶的?下图是一个简化的自动驾驶框架,包含了自动驾驶系统的各个组成成分。首先,最开始的原始数据层需要传感器、雷达、相机等,来捕获多模态的信号,作为原始数据;随后原始数据会被送给感知层,感知层使用一些计算机视觉模型,比如目标检测、语义分割模型,来对原始数据进行分析处理,还需要使用多模态融合技术来融合不同模态的信号;在解释层我们需要AI模型帮助我们理解路况的动态变化情况以及路径的拓扑结构;最后在决策层,我们使用强化学习和其他的AI算法来进行端到端规划和决策。

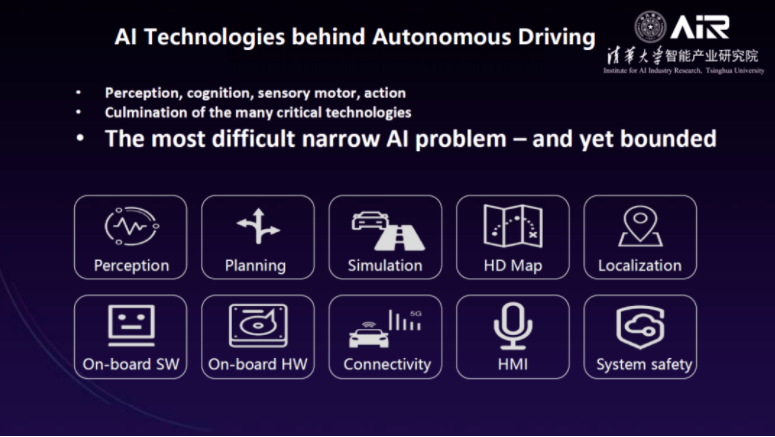

背后有很多AI技术来支撑这个复杂的自动驾驶框架,比如感知、规划、模拟仿真、人机交互、系统安全等等。可以很客观地说,自动驾驶是最困难的人工智能问题之一,它也是受限制的问题。

以下是一些AIR在研究的传统AI任务:

本次演讲,刘菁菁教授简要的介绍了多模态AI的一些研究主题,以及多模态AI如何从积极响应(Responsive)、适应发展(Resilient)、坚守价值(Responsible)三个维度为人类社会赋能。刘教授希望在这样可持续发展的3R原则的指导下,我们的AI技术可以最大程度上为人类社会做贡献,同时也最小化对环境、安全、隐私等方面的负面影响!

精彩视频回顾及完整版PPT下载,请点击:

刘菁菁:How Multimodal AI Empowers People