类型:ACL 2021 主会长文

题目:Mask-Align: Self-Supervised Neural Word Alignment

作者:陈驰,孙茂松,刘洋

【介绍】

词对齐是一项重要的自然语言处理任务,它是统计机器翻译的重要组成部分,在机器翻译中的误差分析、约束解码、后编辑等任务上都有使用。Attention机制最早被引入神经机器翻译中,目的是在源端和目标端的词之间建立对齐关系。然而,近年来人们发现,NMT模型中的 attention并不像预期的那样与词对齐完全一致,特别是在Transformer模型中。这是因为NMT模型在计算源端和目标端之间的cross-attention时,只考虑了部分目标端上下文。这会带来预测的不确定性,并不可避免地会带来对齐噪声。为了从NMT模型中获得更好的词对齐,需要额外的对齐标签来指导训练过程。

在我们最近的论文中,我们提出了一个自监督的词对齐模型:Mask-Align。与基于NMT模型的对齐方法不同,Mask-Align并行地遮盖了每个目标端token,并根据源端和其他目标端token来复原它。这种做法可以充分利用目标端的双向上下文,并减少由预测错误造成的对齐错误。我们的模型在四种语言对上取得了最先进的词语对齐性能,并且是完全端到端的,不需要任何对齐标签指导。

【挑战】

基于NMT的对齐方法存在的挑战

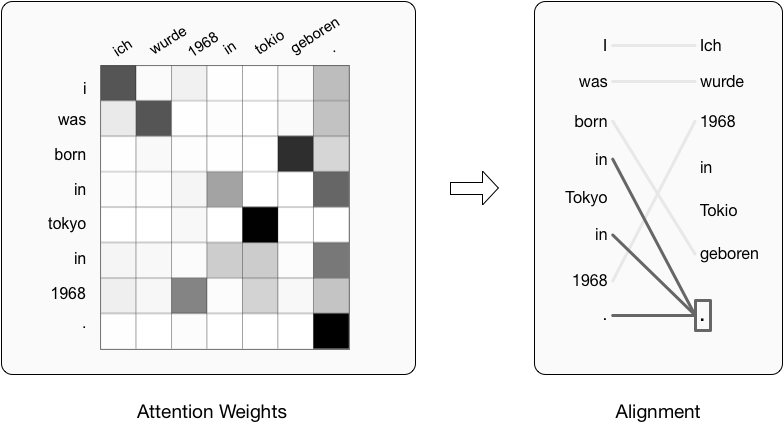

这里展示一个从NMT模型中推断词语对齐的示意图。该模型依照源端 token 和目标端前文 token 来预测每个目标端token,并根据源端和目标端之间的cross-attention权重来生成对齐。在预测“Tokyo” 时,因为无法观察到其右端的token,所以模型错误的生成了“1968”。这会导致 “Tokyo”被错误的对齐到源端token “1968”。

直觉上讲,如果模型能够在预测时观测到目标token右边的 “1968”,这种错误就不会发生。受此启发,我们提出了基于遮盖的词语对齐方法Mask-Align。

Mask-Align

Mask-Align通过遮盖-预测的方式来预测每一个目标端token。具体来说,我们并行的遮盖每一个目标端token,并根据源端 token 和完整的目标端上下文来复原它。因此,当预测被遮盖的token “Tokyo” 时,我们的模型不会生成“1968”,因为它能够观测到后文已经存在一个 “1968”。这样产生的对齐链接也相应是正确的。

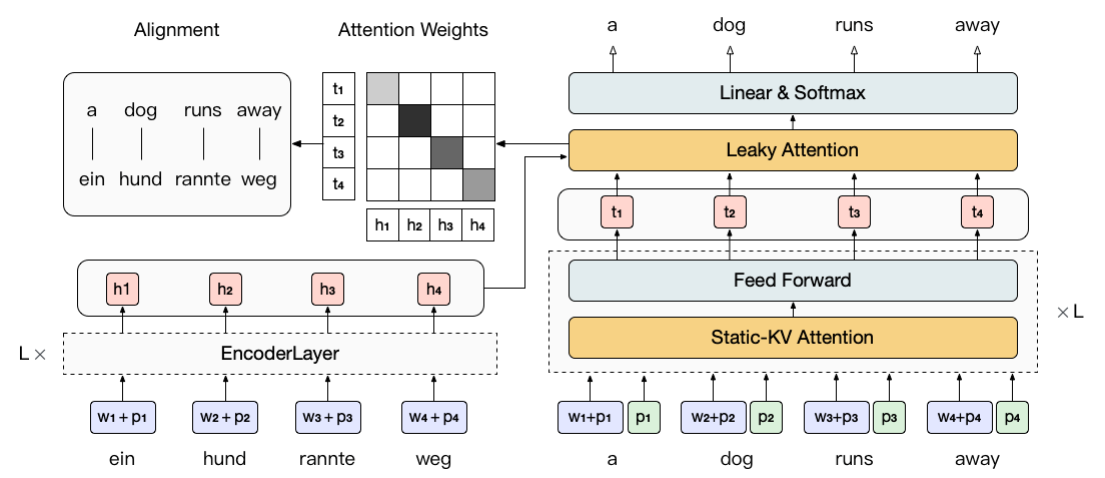

上述想法很直接,但实现起来并不简单。由于self-attention是全连接的,使用普通的Transformer每次只能遮盖并复原一个目标端token。对于一个长度为N的目标句,这就需要N次独立的前向传递。为了使这一过程更加有效,受 DisCo[1]的启发,我们提出使用static-KVattention,在一次前向传递中并行地遮盖和预测所有目标端token。

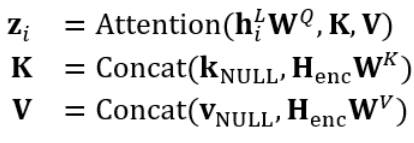

Static-KV attention 与普通的self-attention有两处不同。首先,只使用position embedding来初始化每个token的表示,这相当于遮盖这个token。其次,在不同层的计算中,每个token的key和value向量一直保持为与第一层一致,即 word embedding position embedding,并且每个token禁止连接向自己key和valu 向量(用-x->表示)。这些变动能够让我们并行的计算所有token被单独遮盖时的表示,并且避免了信息泄漏导致的模型退化。

我们还删除了除最后一个解码层外的所有cross-attention。这使得源端和目标端之间的信息交互被约束在最后一层。我们的实验表明,这种修改能够在更少的模型参数下取得更好的对齐结果。Mask-Align 的整体结构如下图所示。

Leaky Attention

从普通cross-attention权重中抽取对齐结构可能会受到某些特定源端token的较大的attention权重的影响,比如句号、[EOS]或其他高频 token。这些token类似于统计对齐模型中的“garbage collectors”,会被对齐到很多目标端token。在下面这个例子中,源端 token “.” 作为collector会被错误地对齐到目标端的两个 “in”。

我们推测产生这种现象的原因是NMT模型在建模上没有设计统计机器翻译与词语对齐中常用的 NULL token,这种token会被用来对齐那些在源端没有相应翻译的目标端token。因而这些collectors本质上扮演了NULLtoken的角色。如果我们想从attnetion权重中获得对齐结果,这种现象显然是不利的。

因此,我们提出了一种叫做 leaky attention的注意力变体,对 NULLtoken 进行显式建模。具体来说,我们在cross-attention的计算中增加了两个可训练的参数

和

和

,通过将它们与编码器的输出

,通过将它们与编码器的输出

变换得到的key和value向量连接起来,来模拟NULL token的行为,即:

变换得到的key和value向量连接起来,来模拟NULL token的行为,即:

下图表示,使用leaky attention能够对attention权重中的collector现象进行矫正,从而能从中获得更准确的词语对齐。

Agreement

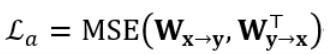

为了更好的利用来自两个方向的注意力权重,受统计对齐模型[2]的启发,我们在训练和测试阶段都引入了agreement 来提升模型的对称性。具体来说,在训练时,我们引入了一个agreement loss:

来鼓励两个方向的模型生成相似的attention权重矩阵。由于引入了 leaky attention,我们只考虑除了[NULL]以外位置的权重,并对其进行重归一化。

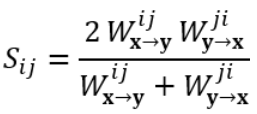

在测试时,我们通过综合两个方向的attention权重

和

和

来计算源端第 j 个 token 和目标端第 i 个token之间的对齐分数:

来计算源端第 j 个 token 和目标端第 i 个token之间的对齐分数:

我们在实验中发现这种抽取对齐结果的方法比传统使用的grow-diag效果更好。

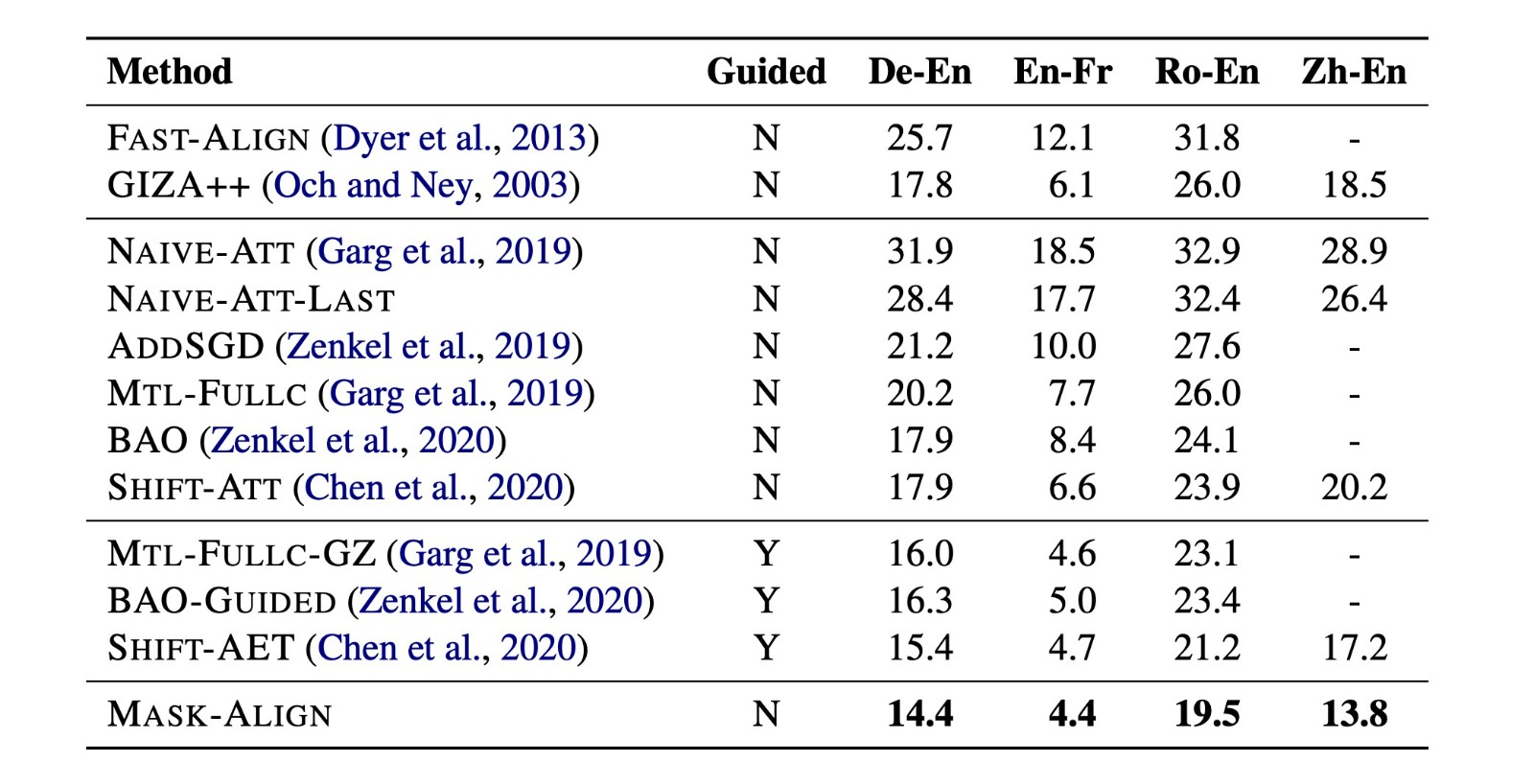

【实验结果】

下表给出在四种语言对上Mask-Align 与其他无监督统计对齐方法和神经对齐方法的对比。实验结果表明,Mask-Align在这几种语言对上都取得了最佳效果。

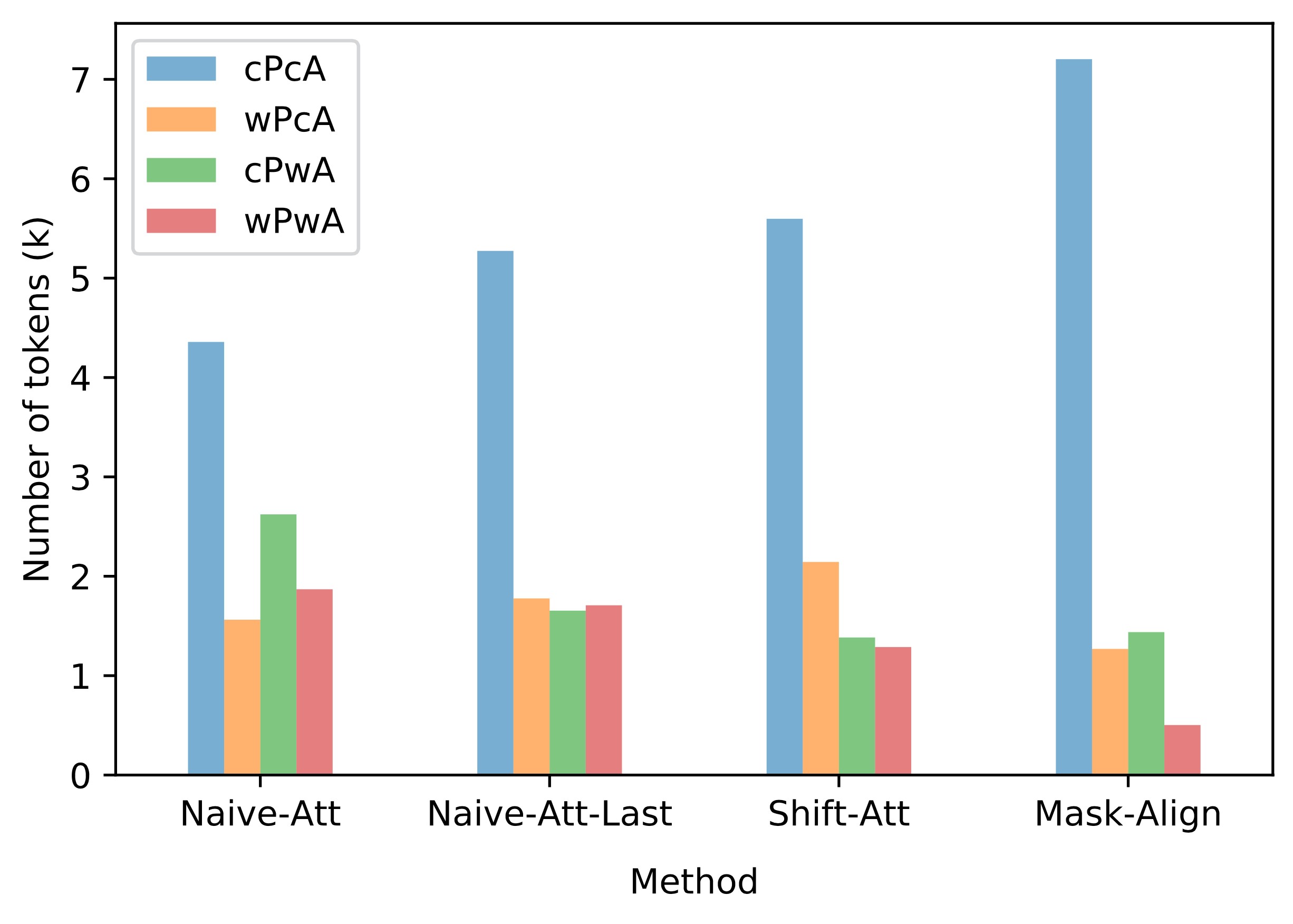

我们还计算了不同方法在测试集上的预测误差(即模型预测的目标端token是否与真实token一致)和对齐误差之间的关系。可以看到,相比于其他基于NMT的对齐方法,Mask-Align显著减少了预测误差而导致的对齐误差 (wrong Prediction & wrong Alignment, wPwA),这说明我们的方法引入了更多目标端上下文确实能够得到更好的对齐效果。

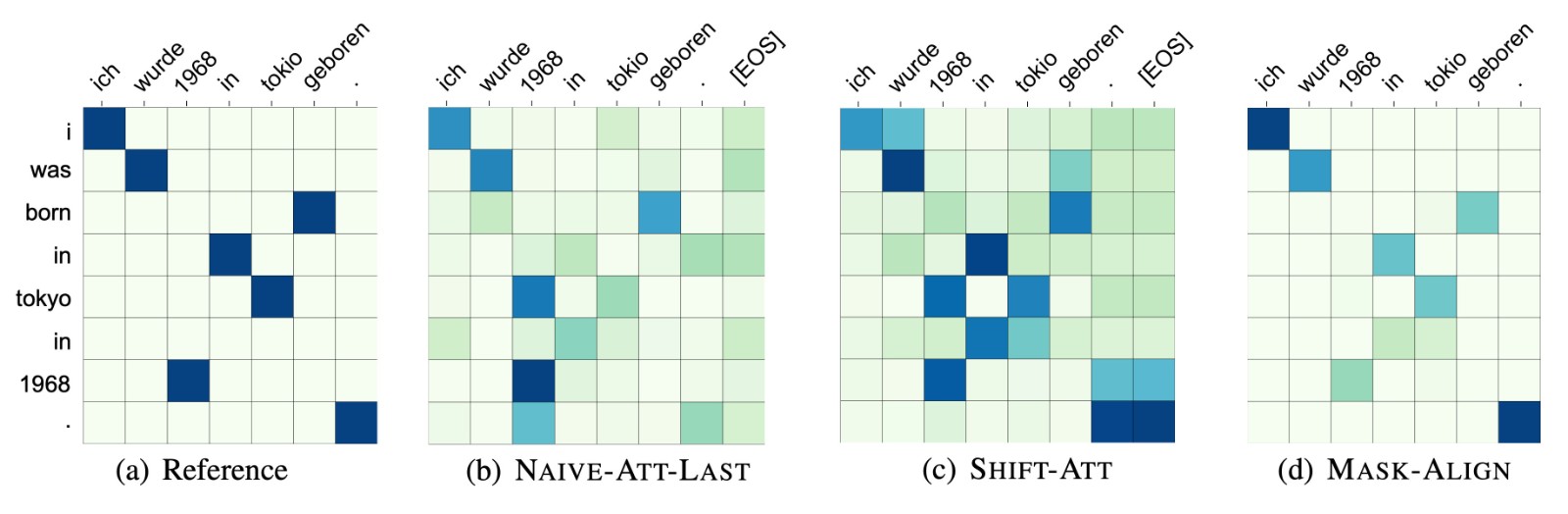

与其他方法相比,Mask-Align得到的注意力权重矩阵与词对齐reference更一致。

【总结】

在本文中,我们提出了一个自监督的神经对齐模型Mask-Align,对每个目标端token进行遮盖并根据完整的源端和目标端上下文还原,从而减少了错误带来的对齐误差。同时,我们提出了显式建模NULL token的leaky attention来缓解集中的attention权重造成对齐错误的现象,并通过在训练和测试时引入agreement来进一步提升对齐效果。实验结果表明,Mask-Align相较于其他无监督统计和神经对齐方法取得了更好的对齐效果。

作者简介:陈驰,清华大学自然语言处理与社会人文计算实验室19级博士生,师从刘洋教授。研究方向为机器翻译、自监督学习。

撰文 / 陈驰

编辑排版 / 刘聆羽

校对责编 / 黄妍

点击阅读论文原文: