类型:ACL 2021 主会长文

题目:Transfer Learning for SequenceGeneration: from Single-source to Multi-source

作者:黄轩成、许静芳、孙茂松、刘洋

简介:多源端序列生成(Multi-source Sequence Generation,MSG)是输入包含多个源端的一类序列生成任务,包含自动后编辑、多源端翻译、多文档摘要等。MSG存在数据稀缺的问题,而近年来BART、mBART等适用于encoder-decoder结构的预训练模型对于数据稀缺的序列生成任务有非常良好的效果。但是,MSG常用的包含多个encoder的Transformer模型与BART等预训练模型有明显的架构差异。本文探究了如何更好地将encoder-decoder结构的预训练模型应用到MSG类任务,提出了新的微调方法与新的模型,在自动后编辑、多源端翻译和文档翻译等任务的多种不同资源场景下验证了我们方法的有效性。

【介绍】

由于文本、图像、语音等都可以被表示成连续稠密向量表示,深度神经网络模型可以接收更多的源端作为输入(Ive et al., 2019; Dupont and Luettin, 2000)。多模态的输入在许多序列生成任务中被证明是有效的,例如自动问答(Antol et al., 2015), 机器翻译(Huang et al., 2016), 和语音识别(Dupont and Luettin, 2000)。在自然语言处理中,多个文本模态的源端同样也对序列生成任务有效,例如多源端翻译(Zoph and Knight, 2016), 自动后编辑(Chatterjee et al., 2017), 多文档摘要(Haghighi and Vanderwende, 2009), 神经机器翻译的系统融合 (Huang et al., 2020), 还有文档级别翻译(Wang et al., 2017)等。我们将这一类任务称之为多源端序列生成(Multi-source Sequence Generation,MSG)任务。

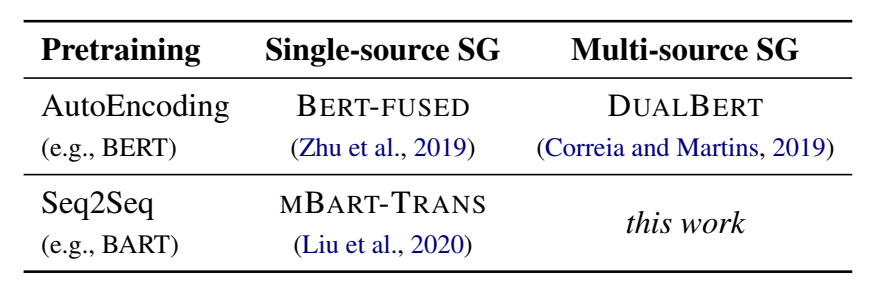

图1:多源端序列生成类任务

不幸的是,由于包含多个源端,MSG任务的平行数据更难获取,存在数据稀缺的问题。近年来,BERT等预训练模型被证明在低资源的自然语言处理下游任务上有非常好的效果。Correia和Martins 在2019年提出使用预训练的autoencoding(AE)模型,如BERT,来改进自动后编辑。最近,预训练的序列到序列(Seq2Seq)模型也被提出,在单一源端的序列生成任务上有很好的效果。我们相信Seq2Seq预训练模型在序列生成任务上有不弱于AE预训练模型的效果。但是,由于多源端序列生成任务通常使用包含多个encoder的Transformer架构,与Seq2Seq预训练模型存在明显的架构差异,会导致预训练-微调偏差。一个容易想到的解决方案是,把多个源端拼接起来视为单个源端。我们认为这种方法有两个主要的弊端:其一是预训练与MSG接收的输入有很大差异,会导致性能下降;其二是仅依靠预训练的单一encoder中的自注意力层来捕捉多个源端之间的跨源信息是不够的。受自然语言理解中的中间任务的启发,我们推测在预训练和微调之间插入一个合适的中间任务可以缓和预训练与微调之间的差异导致的性能下降。不同于前人工作,我们的工作专注于将预训练的Seq2Seq模型迁移到MSG任务上(如图2所示)。在本文中,我们提出一个两阶段微调方法称之为逐步微调(gradual finetuning)。我们的方法首先将预训练模型迁移到有监督的单一源端序列生成任务上,再迁移到有监督的多源端序列生成任务上。另外,我们还提出了一个新的模型,包含粗粒度(coarse)和细粒度(fine)的encoders来区分不同的源端且更好地学习表示。

图2:我们的工作与前人工作的区别

我们将提出的面向多源序列生成的任务无关框架命名为TRICE(a task-agnostic Transferring fRamework for multI-sourCe sEquence generation),其在WMT17 自动后编辑任务以及WMT14 多源端翻译任务上取得了新的最佳结果,在文档翻译任务上也显著超过了基线系统。

【方法】

微调方法

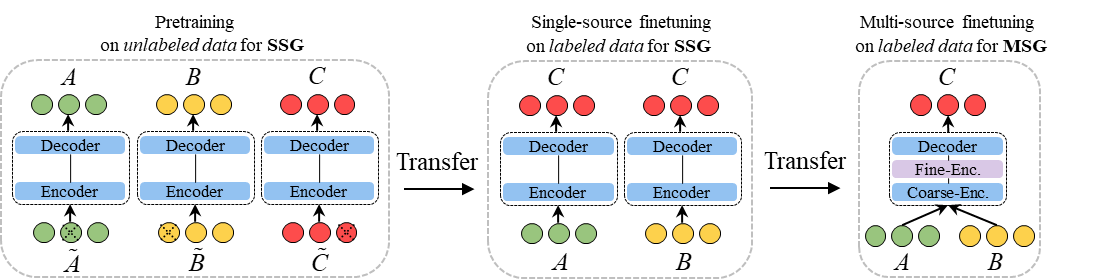

图3: 逐步微调策略

逐步微调是一个两步微调方法,图3展示了包含预训练以及两个微调步骤的三个阶段。其中图3左边的部分即预训练阶段,这个阶段使用的数据是多种语言的单语无标注数据,以去噪自编码的目标进行训练,并使用标准的Transformer单源端模型架构。预训练阶段可以利用海量的无标注数据。

图3的中间部分是微调的第一步,这个阶段使用单一源端的有监督数据(如机器翻译中常用的平行语料),以序列生成的目标进行训练。这个阶段的源端只有一个,模型架构也保持与预训练一致。因为有监督数据较难获得,此阶段使用的数据量相对第一阶段而言较少。

图3的右边部分是微调的第二步,这个阶段使用多个源端的有监督数据,即数据量最少的MSG类任务使用的数据。训练的目标即为特定MSG任务的目标,架构上变化为我们提出的包含粗粒度与细粒度encoders的针对MSG的变种模型。

通过在预训练和最后一步微调中增加一步微调,我们可以利用数量中等的单一源端的有监督数据,并缓和预训练与MSG之间任务和架构差异所带来的负面影响。

模型架构

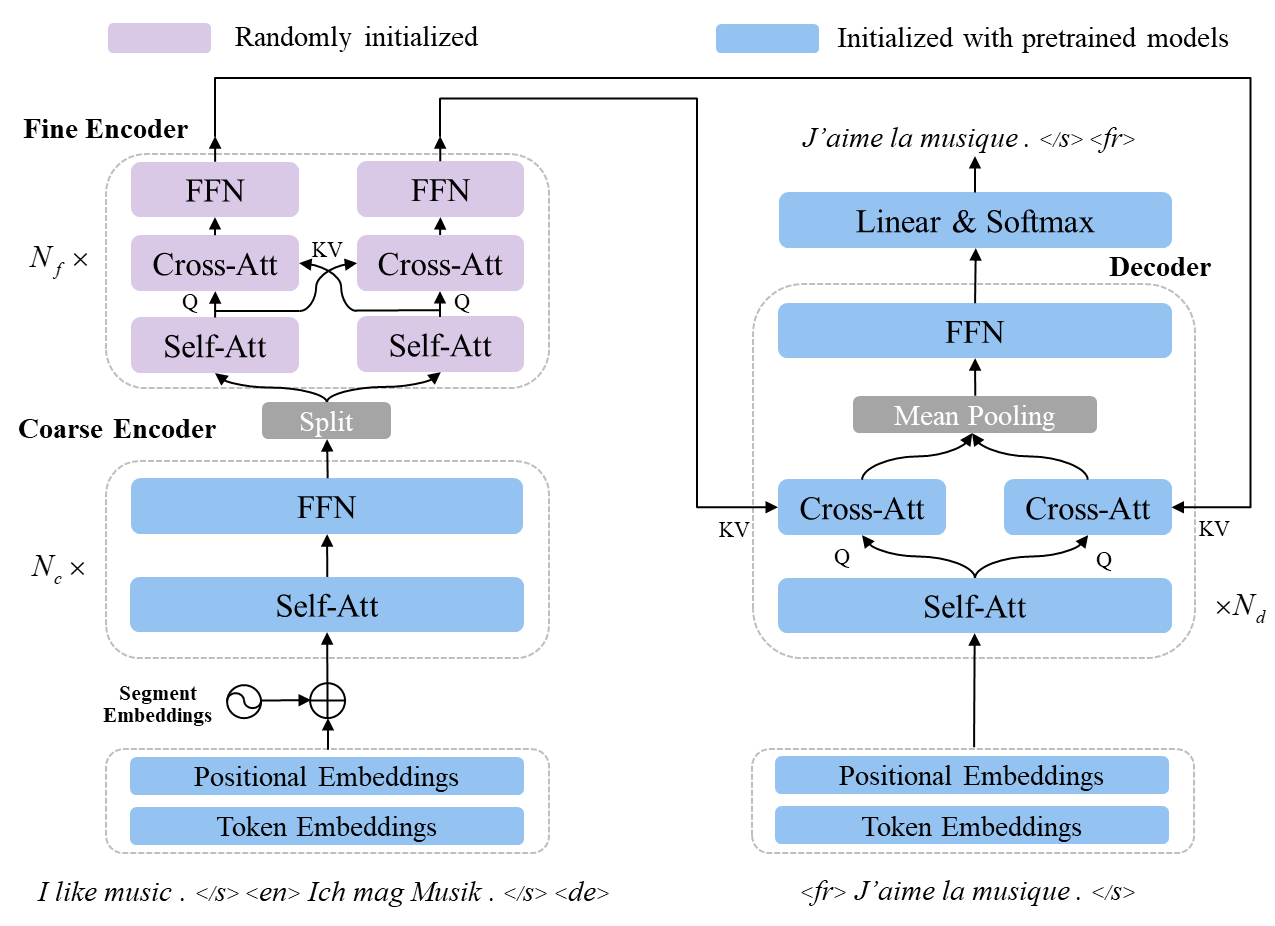

图4:我们的模型架构

我们的模型架构如图4所示,其中蓝色的部分是由预训练模型的参数初始化的,紫色的部分是随机初始化的。蓝色的部分总体上是一个传统的Transformer模型,包含encoder(也被我们称之为粗粒度encoder)还有decoder。模型的输入是多个源端的文本序列,并增加了其语言的标签,输入的embedding包含词、位置、还有所属的源共三种embeddings。输入经过了粗粒度encoder的编码,进而输送到细粒度encoder进行细粒度的编码。细粒度encoder单独对每个源端的信息进行编码,并以cross-attention建模他们之间的交互,以学习更好的表示。编码之后的向量输送到decoder用于解码,其中唯一与传统Transformer结构中的decoder不同的是,cross-attention被拆分成了多个,对每个源端的编码向量进行单独处理,并把所得的向量进行平均。此架构被用于第二步微调,也即蓝色的部分由前一步所得模型的参数进行初始化,而紫色的部分由于是新增加的模块,进行随机初始化。这样的模型结构在我们的实验中被证明是有效的。

【实验结果】

在多个多源序列生成类任务上的实验效果

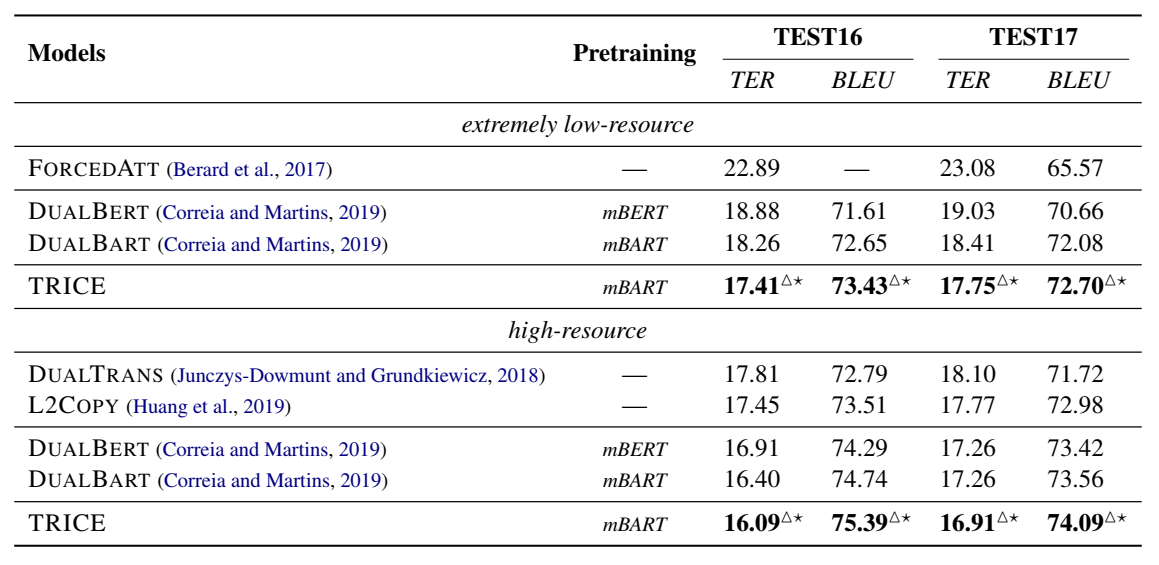

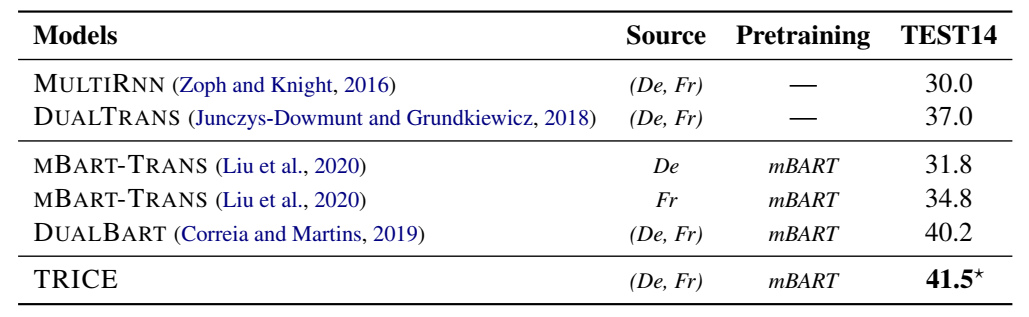

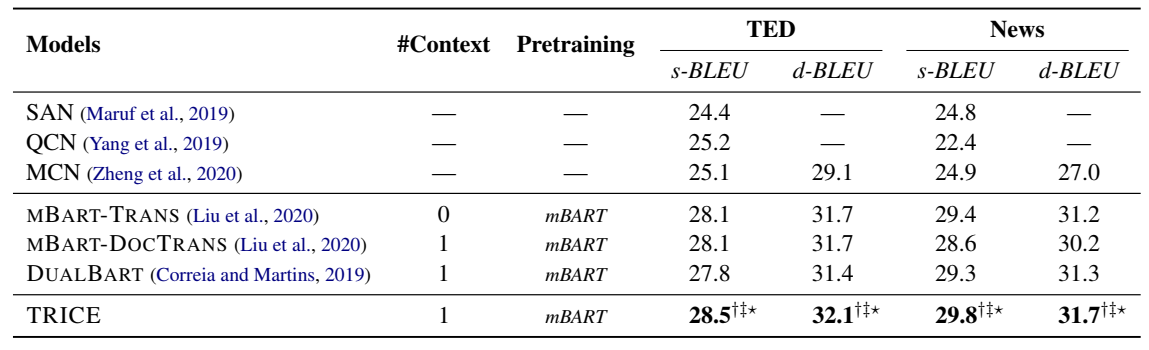

我们在三个MSG类任务上评估我们的框架,分别是自动后编辑,多源端翻译和文档级别翻译。如图5-7所示,我们的框架在三种MSG任务上都显著好于基线系统,刷新了WMT17 自动后编辑任务与WMT14多源端翻译任务的最佳结果。

图5:自动后编辑任务(极低资源与高资源)上的实验结果

图6:多源端翻译任务(中等资源)上的实验结果

图7:文档级别翻译任务(低资源)上的实验结果

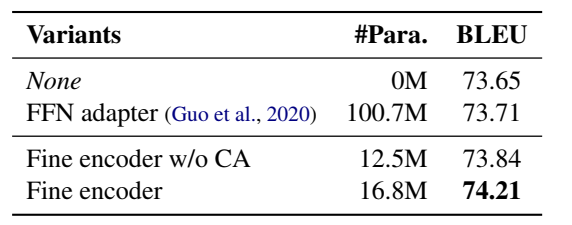

对模型架构中细粒度编码器的分析

如图8所示,我们发现细粒度encoder中cross-attention是重要的,并且参数量并不是使得细粒度encoder奏效的因素。

图8:对细粒度encoder的分析

对我们的框架中各个部分的消去实验

如图9所示,消去实验中证明了我们的框架中各个部分的重要性。

图9:消去实验

参考文献:

[1] StanislawAntol, Aishwarya Agrawal, Jiasen Lu, Mar-garet Mitchell, Dhruv Batra, CLawrence Zitnick,and Devi Parikh. 2015. Vqa: Visual question answering. InProceedings of the IEEE internationalconference on computer vision, pages2425–2433

[2] RajenChatterjee, M Amin Farajian, Matteo Negri,Marco Turchi, Ankit Srivastava, andSantanu Pal.2017. Multi-source neuralautomatic post-editing:Fbk’s participation in the wmt 2017 ape sharedtask.InProceedings of the Second Conference on Ma-chine Translation, pages630–638.

[3] Goncalo MCorreia and Andre FT Martins. 2019. Asimple and effective approach to automatic post-editing with transferlearning. InProceedings of the57th Annual Meeting of the Association forCompu-tational Linguistics, pages 3050–3056.

[4] StephaneDupont and Juergen Luettin. 2000. Audio-visual speech modeling for continuous speech recog-nition.IEEEtransactions on multimedia, 2(3):141–151.

[5] Aria Haghighiand Lucy Vanderwende. 2009. Explor-ing content models for multi-documentsummariza-tion. InProceedings of Human Language Technolo-gies: The 2009 Annual Conference of theNorthAmerican Chapter of the Association for Computa-tional Linguistics, pages362–370.

[6] Po-Yao Huang,Frederick Liu, Sz-Rung Shiang, JeanOh, and Chris Dyer. 2016. Attention-based multi-modal neural machinetranslation. InProceedingsof the FirstConference on Machine Translation: Vol-ume 2, Shared Task Papers, pages639–645.

[7] Xuancheng Huang, Jiacheng Zhang, Zhixing Tan,Derek F. Wong, Huanbo Luan, Jingfang Xu,Maosong Sun, and Yang Liu. 2020. Modeling vot-ing for systemcombination in machine translation.InProceedings of the Twenty-NinthInternationalJoint Conference on Artificial Intelligence, IJCAI-20.

[8] Julia Ive,Pranava Swaroop Madhyastha, and LuciaSpecia. 2019.Distilling translations withvisualawareness. InProceedings of the 57th Annual Meet-ing of the Associationfor Computational Linguistics,pages 6525–6538.

[9] Yinhan Liu,Jiatao Gu, Naman Goyal, Xian Li, SergeyEdunov, Marjan Ghazvininejad, MikeLewis, andLuke Zettlemoyer. 2020.Multilingual denoisingpre-training for neuralmachine translation.Transac-tions of the Association for ComputationalLinguis-tics, 8:726–742.

[10] Longyue Wang,Zhaopeng Tu, Andy Way, and Qun Liu.2017. Exploiting cross-sentence context forneuralmachine translation. InProceedingsof the 2017Conference on Empirical Methods in Natural Lan-guage Processing,pages 2826–2831.

[11] Jinhua Zhu,Yingce Xia, Lijun Wu, Di He, Tao Qin,Wengang Zhou, Houqiang Li, and Tieyan Liu.2019.Incorporating bert into neural machine translation.InInternationalConference on Learning Represen-tations.

[12] Barret Zophand Kevin Knight. 2016. Multi-sourceneural translation. InProceedings of the 2016 Con-ference ofthe North American Chapter of the Asso-ciation for Computational Linguistics:Human Lan-guage Technologies, pages 30–34.

作者简介:黄轩成,清华大学自然语言处理与社会人文计算实验室17级博士生,师从清华大学智能产业研究院(AIR)副院长、计算机系长聘教授刘洋。研究方向为机器翻译、自然语言处理。目前在ACL、EMNLP等人工智能顶级会议上以一作发表长文多篇。

撰文 / 黄轩成

编辑排版 / 冼晓晴

校对责编 / 黄妍